如何让大型语言模型部署更高效?Run:ai Model Streamer的革命性突破 原创

01、概述

在人工智能的迅速发展中,大型语言模型(Large Language Models,简称LLMs)正成为各类应用的核心。然而,面对强大模型带来的复杂计算需求,如何高效部署成为了一个关键问题。尤其是在加载模型时,大部分用户会遭遇“冷启动问题”——即模型从存储器加载到GPU内存的时间延迟。这种延迟不仅影响用户体验,还直接影响模型的可扩展性和实时性。

针对这一挑战,Run公司推出了一款革命性工具——Run Model Streamer。该工具通过并行处理和流式传输模型权重至GPU内存的方式,大幅减少了模型加载的时间。今天,我们就深入探讨Run Model Streamer如何改变模型部署的游戏规则,为LLMs的未来发展带来新的可能。

02、Run Model Streamer:突破传统,重塑部署效率

在传统的模型加载方式中,模型权重数据需要从存储器逐步传输至CPU,再从CPU传递至GPU。这种串行的加载流程存在多个瓶颈,尤其在处理大规模模型时,加载时间往往较长,影响了实际使用的流畅度。

Run Model Streamer打破了这一传统做法,通过“并行+流式传输”的创新思路,改变了模型权重加载的路径。模型数据从存储器直接流式传输至GPU内存,不再依赖于CPU的中转步骤。这种改变不仅提升了加载速度,还让GPU资源能够更有效地得到利用。Run Model Streamer通过并行读取模型权重的方式,大幅提高了加载效率,尤其在对大规模模型的实际应用中,具有显著优势。

03、Run Model Streamer的核心优势

1. 并发处理,提升加载速度

Run Model Streamer通过使用多个线程并发地读取模型文件,将模型权重数据高效加载至GPU,极大地减少了等待时间。这种并发处理模式通过优化存储和GPU之间的传输,确保GPU在加载时不会“闲置”,从而实现更高效的利用。

2. 动态负载平衡

每个语言模型的张量大小不一,通常较大的张量文件可能会造成加载过程中的瓶颈。Run Model Streamer对各个张量的加载进行了动态分配,确保不同大小的张量在加载时得到合理分配,从而平衡了存储带宽的消耗。这一动态负载平衡的特点让它在处理超大规模模型时依然能保持高效。

3. 支持多种存储类型

Run Model Streamer兼容多种存储解决方案,无论是本地SSD还是基于云的对象存储(如Amazon S3)。这种多样化的兼容性,使得它能够适应不同企业的技术环境,进一步拓展了模型部署的灵活性。

4. 消除格式转换带来的性能开销

Run Model Streamer直接支持safetensors格式,使得模型在加载时无需额外的格式转换,节省了大量时间。这种“即拿即用”的模式,使模型加载更为简便。

5. 易于集成,拓展性强

Run Model Streamer为用户提供了与safetensors原生迭代器类似的API,支持并行读取功能,与当前主流的推理引擎(如vLLM和Text Generation Inference,TGI)都可以快速整合。这种便捷的集成方式,使得Run Model Streamer适合多种模型部署场景。

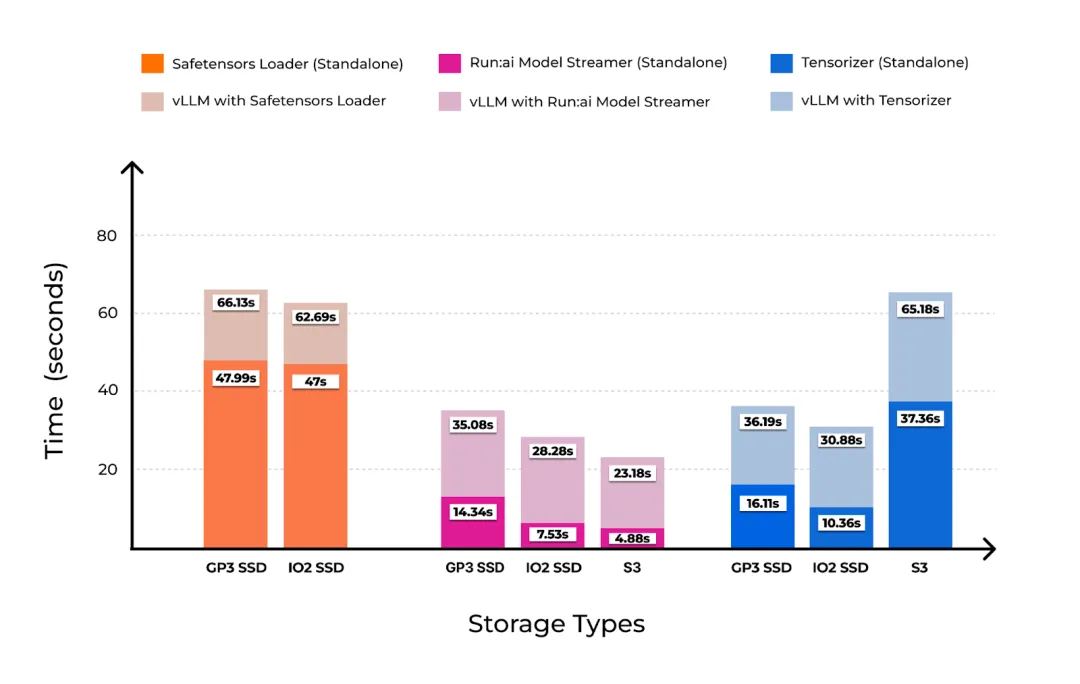

04、实验分析:Run Model Streamer vs. 传统加载器

为了验证Run Model Streamer在实际应用中的性能表现,研究团队在一台AWS g5.12xlarge实例上进行了详尽的实验。该实例配备4个NVIDIA A10G GPU,实验使用了Meta的Llama-3-8B模型(模型大小为15GB,采用safetensors格式存储),并且选择了多种存储条件以验证其适用性,包括本地SSD和Amazon S3。

1. 在本地SSD上的表现

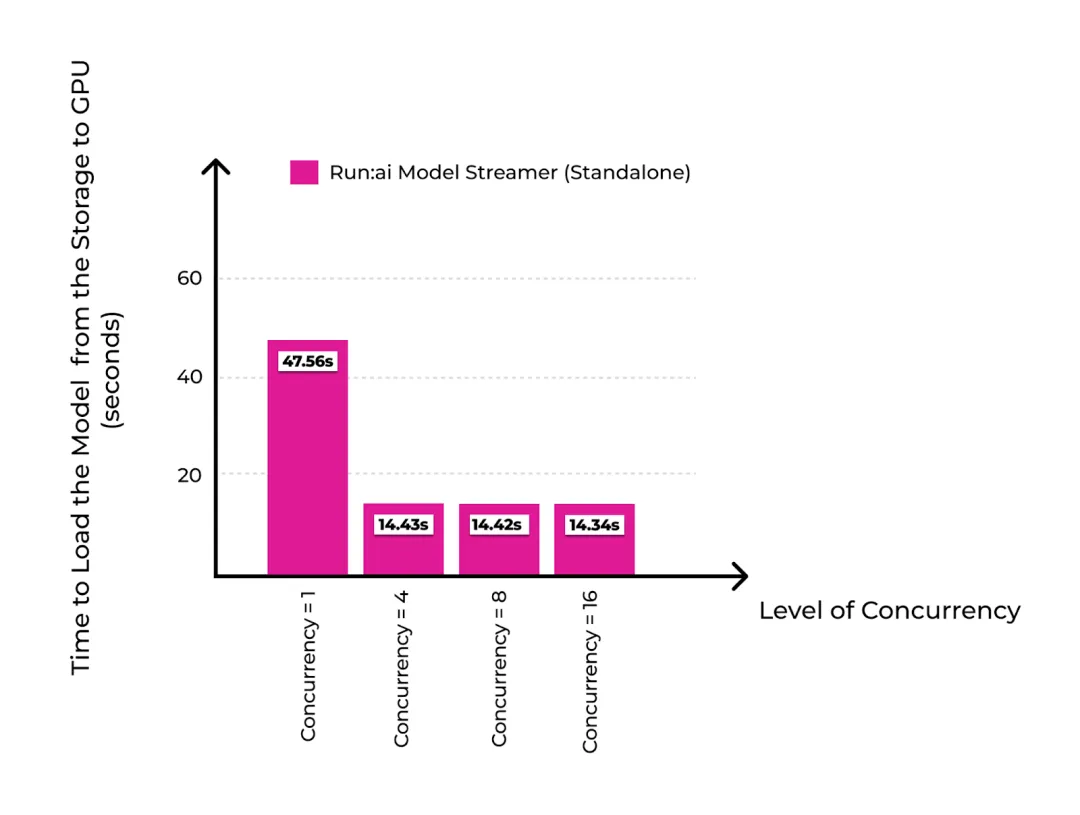

在使用本地GP3 SSD存储的情况下,当并发度设置为16时,Run Model Streamer将模型加载时间从47.56秒降低至14.34秒,达到了GP3 SSD的接近最大传输吞吐量(1 GiB/s)。相比传统的加载工具,Run Model Streamer显然更具优势。

2. 在云端Amazon S3上的表现

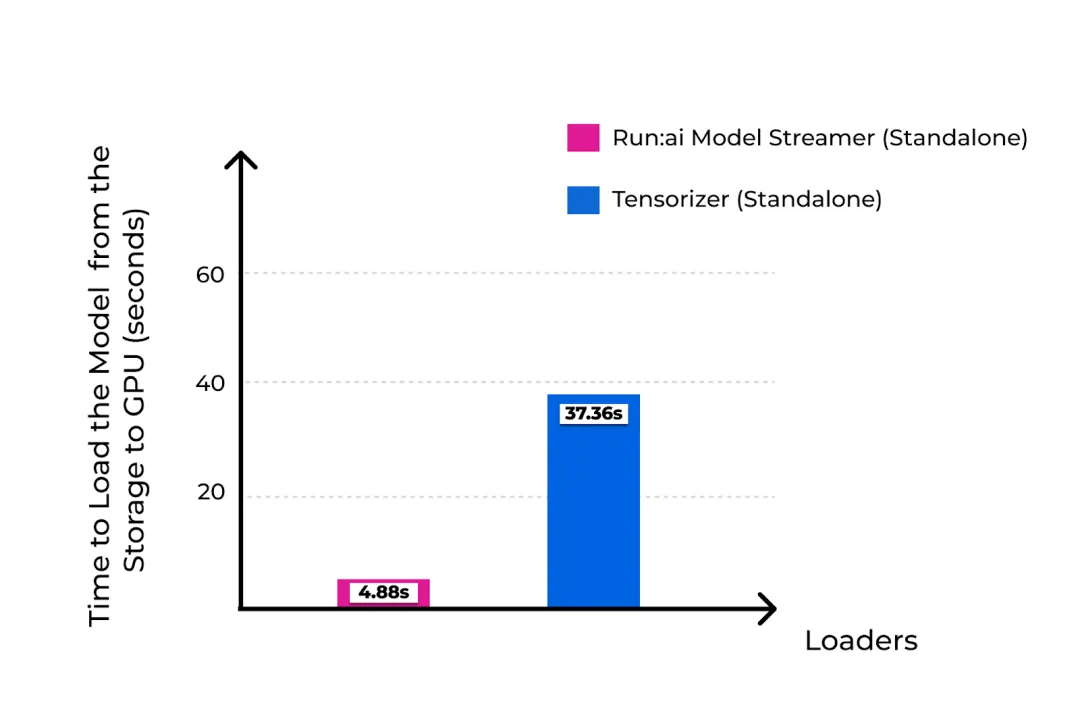

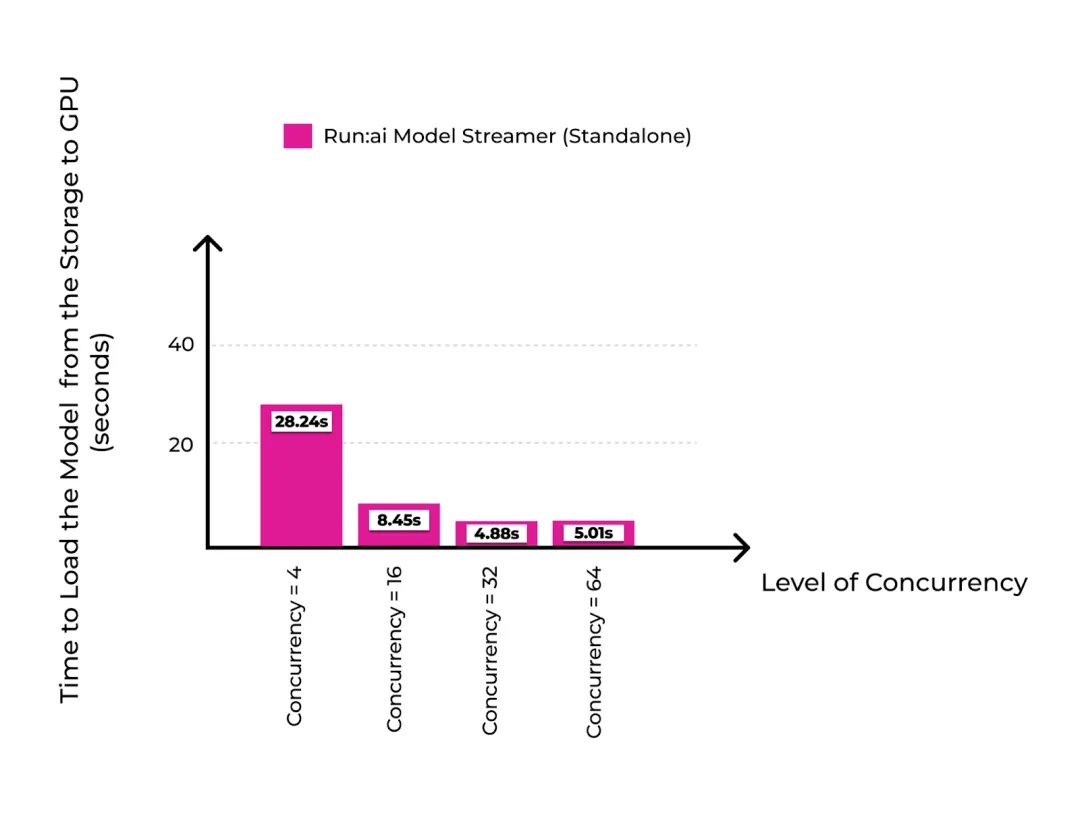

在云存储环境下,Run Model Streamer也表现出色。在使用Amazon S3时,实验设置了32个并发线程,在此配置下模型加载时间仅为4.88秒,远优于传统加载器Tensorizer在最佳配置下的表现。这一结果表明,Run Model Streamer不仅适合本地存储环境,同样能在云存储场景中保持高性能。

3. 与其他加载工具的对比

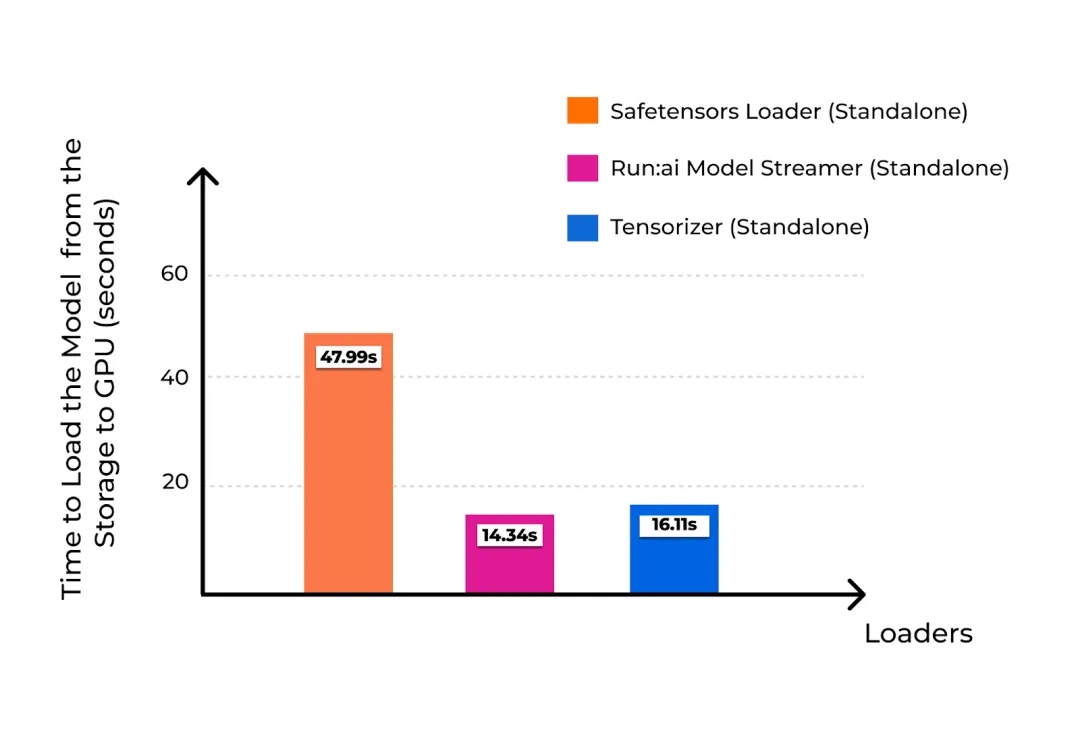

实验将Run Model Streamer的加载速度与Hugging Face的safetensors loader和Tensorizer进行了比较。在多种存储场景下,Run Model Streamer的加载时间均显著短于其他工具,特别是在并发线程增加的情况下,性能提升更加明显。

05、Run Model Streamer的未来展望

通过实验结果不难发现,Run Model Streamer在大幅缩短模型加载时间方面表现出色。但其潜力并不仅限于此。以下是一些未来的扩展方向:

- 集成更多推理引擎:Run Model Streamer目前已与vLLM集成,未来还可以进一步拓展至如Hugging Face的Text Generation Inference (TGI)等推理引擎,提供更强大的推理功能。

- 支持多GPU模型并行加载:目前的实验集中在单个GPU的加载效率上,未来Run Model Streamer可以探索多GPU并行处理的潜力,以支持更大规模的模型。

- 适配Kubernetes集群的自动扩展:在云计算环境中,通过Kubernetes集群实现弹性扩展已经成为趋势。Run Model Streamer若能在Kubernetes环境中实现自动扩展,将进一步提升其在企业级部署中的应用价值。

- 优化存储方案:在未来,可以针对不同的存储方案设计更加针对性的加载优化策略,以进一步提升加载性能。

06、结语

Run Model Streamer的推出,为大型语言模型的部署提供了一个全新的解决方案。通过高效的并行处理和流式加载技术,Run

Model Streamer不仅显著缩短了模型加载时间,还解决了传统加载方式中存在的性能瓶颈。对于开发者和企业来说,Run Model Streamer不仅是一个加速模型部署的工具,更是降低成本、提升用户体验的有效方案。

未来,随着Run Model Streamer不断扩展至更多推理引擎、多GPU加载和Kubernetes自动扩展的场景,我们有理由期待它在AI部署领域引领更多变革。Run Model Streamer的诞生,让LLM的部署效率迈向了一个新的台阶,为人工智能的快速落地和应用提供了强大的支持。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯