深度解析 REAcT Agent 的实现:利用 LlamaIndex 和 Gemini 提升智能代理工作流 原创 精华

01、概述

在过去的两三年中,人工智能领域经历了令人瞩目的发展,尤其是在大语言模型、扩散模型和多模态技术等方面。其中,我对智能代理工作流产生了浓厚的兴趣。今年初,Coursera 的创始人、深度学习先锋 Andrew Ng 发了一条推特:“智能工作流将推动今年的 AI 巨大发展”。自那时起,智能代理领域的进展令人惊叹,许多人开始构建自主代理和多代理架构。

02、什么是 REAcT 提示?

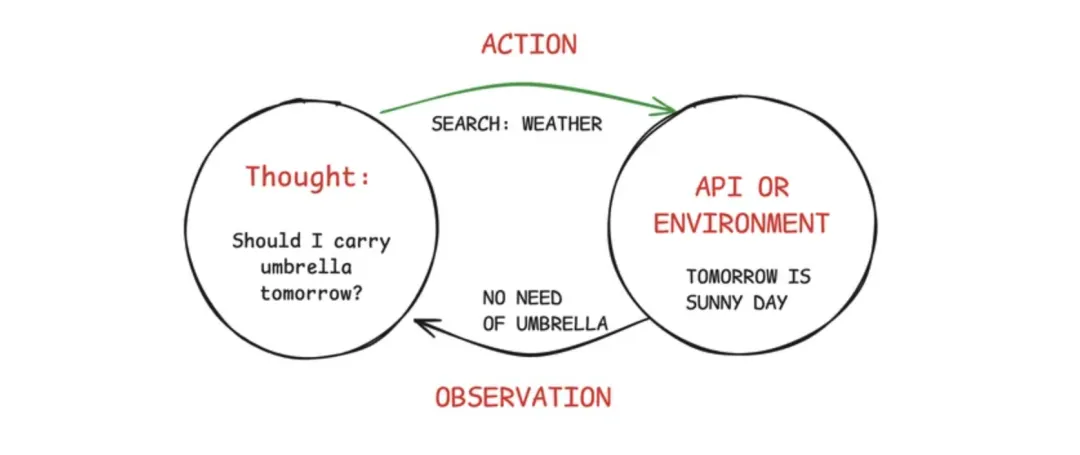

REAcT 代表 Reasoning(推理)、Acting(行动) 和 Thinking(思考),它是一种提示技术,使大语言模型(LLMs)能够将复杂任务分解为一系列思考过程、行动和观察。

REAcT 提示的过程简单明了,主要包括以下三个步骤:

- 思考:根据用户查询,代理生成关于如何解决问题的思路。

- 行动:代理根据其思考执行某些操作,利用可用的工具或 API,例如谷歌搜索、文件加载等。

- 观察:代理分析其行动结果,并决定是否继续该过程或提供最终答案。

这个过程会循环进行,直到获得令人满意的结果或达到最大迭代次数。

REAcT 提示的示例

让我们看一个典型的 REAcT 提示结构:

- 思考:关于任务的推理。

- 行动:要执行的动作,例如“搜索”。

- 行动输入:执行该动作的输入,例如搜索查询。

- 观察:该动作的结果。

- 思考:基于观察的进一步推理。

- 最终答案:代理的结论。

实时示例

假设用户查询:“最近的印度与英格兰测试系列赛的最佳球员是谁,他们的关键表现如何?”

输出(使用 crewAI 生成):

- 思考:为了准确回答这个查询,我需要找到关于最近的印度与英格兰测试系列赛的信息,确定最佳球员,并收集他们的表现细节。我将开始搜索系列赛的结果。

- 行动:搜索

- 行动输入:“2024 年印度与英格兰测试系列赛结果”

- 观察:最近的印度与英格兰测试系列赛以印度 4-1 获胜告终,该系列赛于 2024 年 1 月至 3 月在印度进行。

通过不断的思考、行动和观察,代理最终得出了答案:Yashasvi Jaiswal 被评选为最佳球员,并列出了他的关键表现。

REAcT 提示在构建代理中的价值

传统上,从 LLM 中获取结果的方式是编写结构良好的提示。然而,需要注意的是,LLMs 本身并不具备推理能力。虽然多种方法试图使 LLMs 能够推理和计划,但许多方法未能取得成功。REAcT 的出现,在一定程度上成功地设计了比以往更合乎逻辑的研究计划。

REAcT 通过将复杂任务分解为一系列思考、行动和观察,使代理能够以之前难以实现的透明度和适应性处理复杂问题。这种方法使开发者更容易理解代理的决策过程,从而进行调试、优化和改进。

此外,REAcT 提示的迭代特性使代理能够处理不确定性。随着代理在多个思考、行动和观察周期中的进展,它可以根据新信息调整其方法,类似于人类在面对复杂任务时的应对方式。

03、REAcT 代理的关键应用与案例

接下来,我们将探索 REAcT 代理的多种应用和实际案例,突显其在各个领域提升推理、决策和适应能力的潜力。

实时体育分析与预测

REAcT 代理可以利用互联网上大量信息提供体育行业的分析和预测。例如,在 IPL 比赛中,代理可以:

- 分析球员表现趋势。

- 预测最佳击球顺序或投球调整。

- 根据击球手的击球区域建议场上布阵。

自动化客户支持

客户支持需要提供有效反馈的技能。REAcT 代理非常适合在 LLM 或代理需要提供智能反馈时使用,帮助:

- 理解复杂的客户查询。

- 获取相关产品信息和故障排除指南。

- 逐步引导客户解决问题。

个性化学生学习

教育领域也是 REAcT 代理可能产生巨大影响的领域。想象一个个性化的 AI 辅导员,它可以:

- 评估学生当前的知识水平。

- 将复杂主题分解为可管理的小块。

- 根据学生的反馈调整教学风格。

- 提供实时反馈并建议额外资源。

04、使用 LlamaIndex 实现 REAcT 代理

现在,我们进入实现 REAcT 代理的激动人心的部分。实际上,使用 LlamaIndex 实现起来相当简单,只需几行代码。

安装和设置

在进行代码实现之前,我们需要安装一些必要的库,包括 LlamaIndex。LlamaIndex 是一个有效连接大语言模型与数据的框架。我们将使用 DuckDuckGo 搜索作为我们的动作工具,并将 Gemini 作为集成的 LLM。

!pip install llama-index

!pip install duckduckgo-search

!pip install llama-index-llms-gemini导入必要组件

我们首先需要导入必要的组件。REAcT 代理需要与外部工具交互以获取数据,这可以通过 LlamaIndex 核心工具中的 Function Tool 实现。逻辑很简单:每当代理需要访问真实数据时,它会触发一个 Python 函数来检索所需信息。

python

from llama_index.core.tools import FunctionTool

from duckduckgo_search import DDGS

from llama_index.llms.gemini import Gemini定义 Gemini LLM

在 LlamaIndex 中,OpenAI 是默认的 LLM。为了覆盖 Gemini,我们需要在设置中初始化它。您可以在 Google AI Studio 获取 API 密钥。

from llama_index.core import Settings

import os

GOOGLE_API_KEY = "" # 在这里添加您的 API 密钥

os.environ["GOOGLE_API_KEY"] = GOOGLE_API_KEY

llm = Gemini()

Settings.llm = llm创建 REAcT 代理的动作工具

接下来,我们定义搜索工具 DuckDuckGo 搜索。需要记住的一个重要细节是,在定义用于执行操作的 FunctionTool 时,需要指定输入参数的数据类型。例如,search(query: str) -> str 确保查询参数是字符串。由于 DuckDuckGo 返回的搜索结果包含附加元数据,我们将提取结果的主体内容以简化响应。

def search(query:str) -> str:

"""

Args:

query: 用户提示

return:

context (str): 用户查询的搜索结果

"""

req = DDGS()

response = req.text(query, max_results=4)

context = ""

for result in response:

context += result['body']

return context

search_tool = FunctionTool.from_defaults(fn=search)编写 LlamaIndex 的 REAcT 代理

随着代理的主要组件已设置完毕,我们现在可以定义 REAcT 代理。我们可以直接使用 LlamaIndex 核心中的 ReAct Agent。此外,我们设置 verbose=True 以了解幕后发生的事情,设置 allow_parallel_tool_calls=True 允许代理在适当情况下做出决策而无需总是依赖外部操作。

from llama_index.core.agent import ReActAgent

agent = ReActAgent.from_tools(

[search_tool],

llm=llm,

verbose=True,

allow_parallel_tool_calls=True

)这样,我们就创建了 REAcT 代理。现在可以使用它来回答查询,通过运行 agent.chat 方法。

template = """

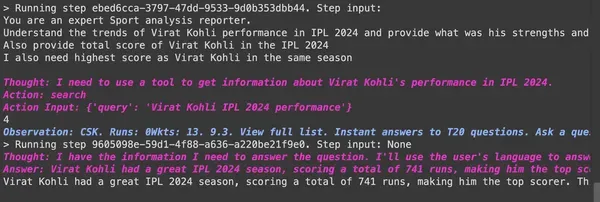

你是一位专业的体育分析记者。

分析 Virat Kohli 在 2024 年 IPL 的表现趋势,并提供他的优缺点。

还需提供 Virat Kohli 在 IPL 2024 的总得分。

我还需要他在同一赛季的最高分。

"""

response = agent.chat(template)

print(response)输出

最终,我们得到了 REAcT 代理的响应。通过这样的实现,代理能够有效地回答实时用户查询。

05、结语

REAcT 代理代表了人工智能和智能工作流领域的一大进步。通过使用 LlamaIndex 实现 REAcT 代理,我们创建了一个强大的工具,能够在实时用户查询中进行推理、行动和思考。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯