AMD 开源 AMD OLMo:完全开源的 1B 语言模型系列 原创

01、概述

在人工智能和机器学习领域,我们正经历着一场技术革命。随着技术的飞速发展,对于强大、灵活且易于获取的解决方案的需求也在不断增长。开发者、研究人员和技术爱好者在利用尖端技术时,常常受限于封闭生态系统的束缚。许多现有的语言模型,包括一些最受欢迎的模型,往往伴随着专有限制和许可限制,或者托管在限制开发者精细控制的环境之中。这些问题对于那些热衷于实验、扩展或以特定方式部署模型以满足个别用例的人来说,常常成为阻碍。这时,开源解决方案成为了关键的推动者,提供了自主权,并民主化了对强大AI工具的访问。

02、AMD OLMo:开源AI生态的新成员

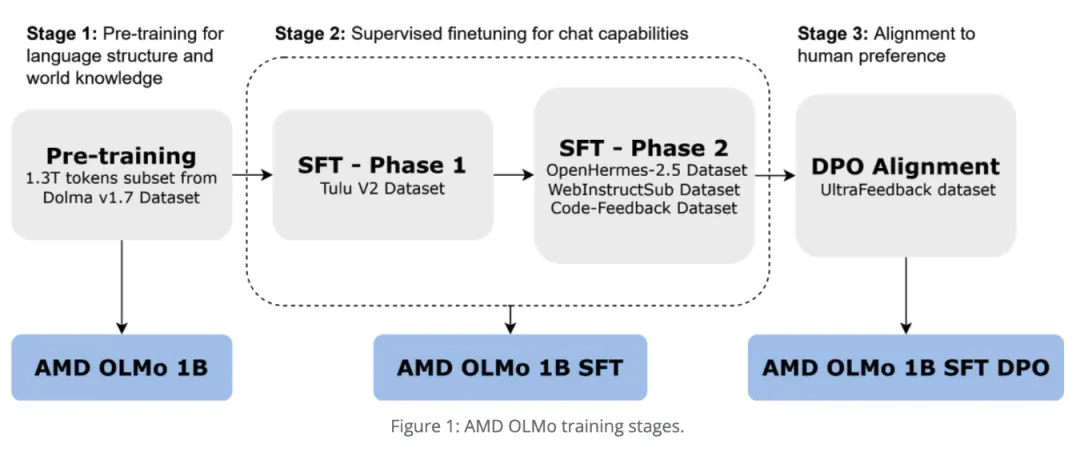

最近,AMD发布了AMD OLMo:一个完全开源的1B(10亿)参数语言模型系列,由AMD在AMD Instinct™ MI250 GPU上从头开始训练。AMD OLMo的发布标志着AMD首次大规模进入开源AI生态系统,提供了一个完全透明的模型,服务于开发者、数据科学家和企业。特别是AMD OLMo-1B-SFT(Supervised Fine-Tuned,监督微调)模型,经过特别微调以增强其理解指令的能力,改善用户交互和语言理解。这个模型旨在支持从基础对话AI任务到更复杂的自然语言处理(NLP)问题的广泛用例。模型与标准的机器学习框架如PyTorch和TensorFlow兼容,确保了不同平台上用户的易访问性。这一步代表了AMD致力于培养一个繁荣的AI开发社区,利用合作的力量,并在开源AI领域采取了明确的立场。

03、技术细节:AMD OLMo模型的亮点

AMD OLMo模型的技术细节尤其引人注目。该模型采用变换器架构构建,拥有强大的10亿参数,提供了显著的语言理解和生成能力。它在多样化的数据集上进行训练,以优化其在广泛的NLP任务中的性能,如文本分类、摘要和对话生成。对指令遵循数据的微调进一步增强了其在交互式应用中的适用性,使其更擅长理解微妙的命令。此外,AMD在训练过程中使用高性能的Radeon Instinct GPU,展示了其硬件处理大规模深度学习模型的能力。该模型已针对准确性和计算效率进行了优化,使其能够在消费级硬件上运行,而不需要通常与专有大规模语言模型相关的昂贵资源需求。这使得它成为爱好者和无法负担昂贵计算资源的小型企业的有吸引力的选择。

04、降低AI研究和创新的门槛

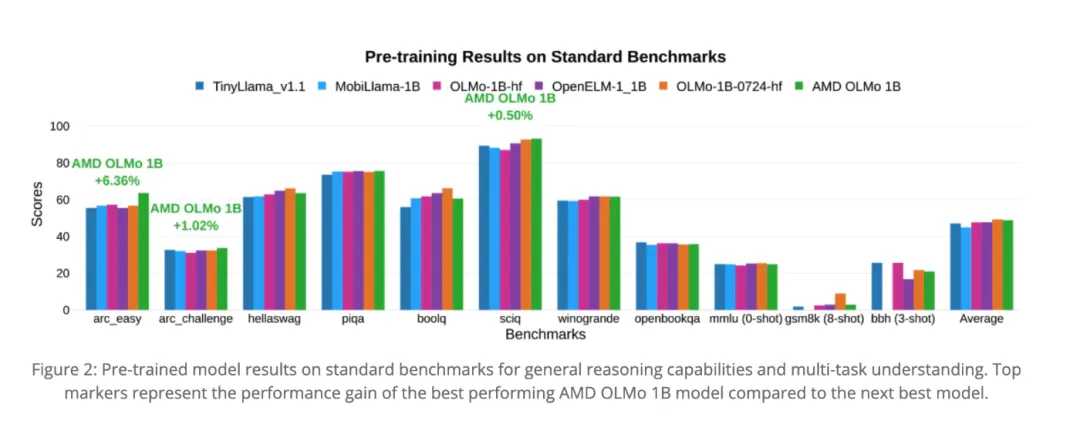

这一发布的重要性不言而喻。这个模型之所以重要,其中一个主要原因是它有潜力降低AI研究和创新的入门门槛。通过向所有人提供完全开放的10亿参数模型,AMD提供了一个关键资源,可以赋予全球开发者权力。AMD OLMo-1B-SFT以其指令遵循微调,允许在各种现实世界场景中增强可用性,包括聊天机器人、客户支持系统和教育工具。初步基准测试表明,AMD OLMo在多个NLP基准测试中的表现与类似规模的其他知名模型具有竞争力,包括GLUE和SuperGLUE。在开源环境中提供这些结果的可用性至关重要,因为它使社区能够进行独立的验证、测试和改进,确保透明度,并促进合作方法,推动这些模型能够实现的界限。

05、结语

AMD引入完全开源的10亿语言模型是AI社区的一个重要里程碑。这一发布不仅民主化了对高级语言建模能力访问,还实际展示了如何使强大的AI更具包容性。AMD对开源原则的承诺有潜力激励其他科技巨头做出类似的贡献,培养一个更丰富的工具和解决方案生态系统,使每个人都受益。通过提供一个强大、经济高效且灵活的语言理解和生成工具,AMD成功地将自己定位为未来AI创新的关键参与者。

参考:

- https://huggingface.co/amd/AMD-OLMo-1B-SFT

- https://www.amd.com/en/developer/resources/technical-articles/introducing-the-first-amd-1b-language-model.html

本文转载自公众号Halo咯咯 作者:基咯咯