RAG:如何通过实时数据提升AI准确性并减少“幻觉” 原创 精华

在人工智能的发展中,内容生成的准确性始终是一个重要挑战,特别是当模型生成出看似可信但实际错误的回答时,即所谓的“幻觉”(Hallucinations)。为了解决这一问题,出现了一项先进的AI技术——检索增强生成(Retrieval-Augmented Generation,简称RAG),它通过结合实时检索与内容生成的双重能力,显著提升AI的回答准确性。本文将深入探讨RAG的原理、技术架构、向量数据库的应用及其如何减少AI的常见问题,让读者全方位了解如何通过RAG实现更可靠、更贴近实际的内容生成。

01、RAG的核心理念:什么是检索增强生成?

简单来说,RAG是一种通过先检索再生成来提升回答准确性的AI方法。传统的AI生成内容通常基于模型的训练数据,但往往无法反映实时的动态信息,这可能导致回答与实际情况脱节。RAG则不同,它首先从知识库中检索出与问题相关的最新信息,然后基于这些信息生成回答。通过将检索式模型与生成式模型相结合,RAG不仅显著提升了内容的质量和准确性,也增强了模型在自然语言处理任务中的表现。

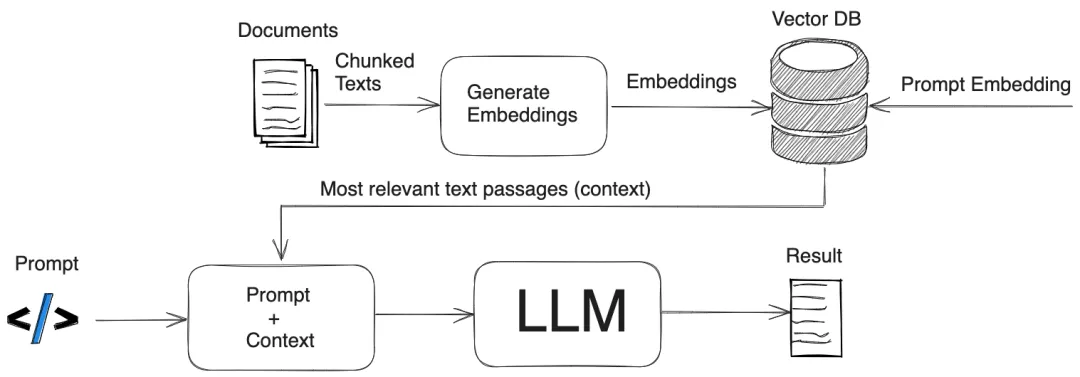

02、深入解析RAG的架构流程

RAG的流程分为两个主要阶段:检索阶段和生成阶段。以下为RAG的详细工作步骤:

1. 检索阶段

- 输入:用户输入问题或提示,例如“量子计算的最新进展是什么?”。

- 检索:系统会在一个知识库或文档集合中(通常是向量数据库)进行搜索,通过相似度检索找到相关文档。

- 返回结果:系统将检索出的最相关的信息片段返回(例如前5或10条最匹配的内容)。

2. 生成阶段

- 结合信息:将检索到的内容与用户的输入整合,以提供更加全面的上下文。

- 生成答案:使用生成式模型(如GPT等)基于这些信息生成回答,同时结合模型的已有知识与检索内容。

- 输出结果:系统返回基于检索信息生成的最终回答,确保其准确性和实时性。

这种双重过程使得RAG生成的回答更具可信度,特别是在知识密集型或需要实时更新的领域中表现出色。

对比RAG与传统生成模式

在没有RAG的情况下,传统AI模型只能依赖已训练的静态数据来回答问题,缺乏对新知识的适应能力。这导致了生成的内容往往不够准确,甚至出现“幻觉”或“虚构”内容。而RAG通过引入实时信息,弥补了这一短板,为AI生成的内容增添了时效性和真实性。

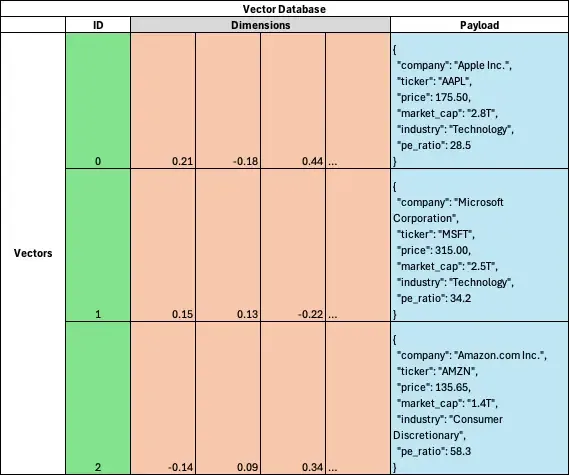

03、什么是向量数据库?RAG工作流中的关键角色

向量数据库在RAG的检索阶段中起到至关重要的作用,它能够通过语义相似性高效地检索相关信息。与传统的关键词匹配系统不同,向量数据库将文本转化为高维空间中的向量,并将具有相似含义的文本向量放置在相邻位置,从而实现更精准的信息检索。

向量数据库示例

以下为向量数据库中一个数据点的结构示例:

{

"id": 0,

"vector": [0.01, -0.03, 0.15, ..., -0.08],

"payload": {

"company": "Apple Inc.",

"ticker": "AAPL",

"price": 175.50,

"market_cap": "2.8T",

"industry": "Technology",

"pe_ratio": 28.5

}

}这种结构使得向量数据库能够以语义相似度而非简单的关键词来检索信息,非常适用于需要快速检索相关内容的AI系统。

04、RAG常用的距离度量方法

在向量数据库中,为了更准确地匹配信息,系统需要使用距离度量来衡量数据点之间的相似性。不同的距离度量适用于不同场景,以下是RAG常用的几种距离度量方法:

这些度量方法通过计算数据点间的相似性,确保RAG能够找到最匹配的信息,从而生成更精准的回答。

05、如何利用RAG减少AI幻觉与虚构问题?

在AI生成内容时,有时会产生“幻觉”,即看似合理但却错误的回答。例如:

- 问题:“澳大利亚的首都是哪里?”

- 错误回答:“澳大利亚的首都是悉尼。”(正确答案应为堪培拉)

这类问题源于模型试图根据已知的模式来预测回答,却无法访问实时或正确的信息。RAG通过将生成过程建立在外部信息检索之上,从根本上减少了这种错误。另外,RAG还能有效应对另一类问题,即“虚构”,即AI模型用错误的理由来支撑一个回答。RAG通过确保模型生成的内容基于实际检索的数据,降低了生成不准确信息的风险。

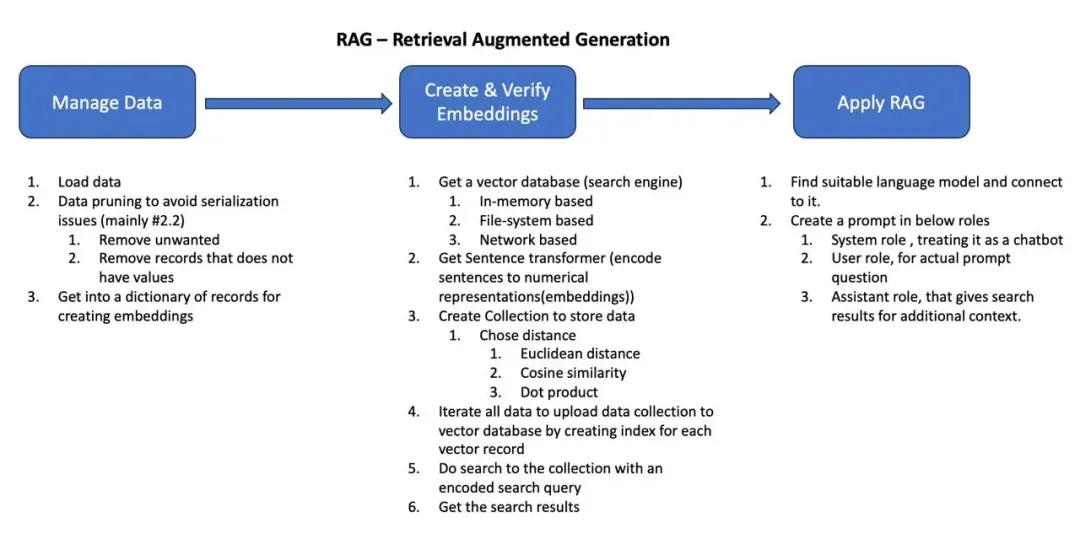

06、RAG实现步骤:从数据管理到向量数据库检索

以下是实现RAG的基本流程:

- 数据管理:整理和验证用于检索的数据,确保数据的完整性。

- 创建并验证向量嵌入:使用语言模型将文本转化为向量嵌入,以便后续的相似性匹配。

- 应用RAG流程:将用户的查询转换为向量,检索数据库并生成回答。

示例:Python实现RAG流程

以下为RAG流程的Python代码实现步骤:

Step 1:初始设置与配置

import pandas as pd

from sentence_transformers import SentenceTransformer

# 加载句子嵌入模型

encoder = SentenceTransformer('all-MiniLM-L6-v2')Step 2:数据清洗

# 读取JSON格式的数据

df = pd.read_json('../../stock_data.json')

df = pd.json_normalize(df['stocks'])

df = df[df['company'].notna()]

data = df.to_dict('records')Step 3:初始化向量数据库

from qdrant_client import QdrantClient

# 创建内存中的向量数据库

qdrant = QdrantClient(":memory:")Step 4:创建向量集合

# 创建集合以存储向量数据

qdrant.recreate_collection(

collection_name="top_stocks",

vectors_cnotallow=models.VectorParams(

size=encoder.get_sentence_embedding_dimension(),

distance=models.Distance.COSINE

)

)Step 5:数据向量化并上传

# 向量化数据并上传至向量数据库

valid_data = [doc for doc in data if isinstance(doc.get("company", ""), str) and doc["company"].strip()]

qdrant.upsert(

collection_name="top_stocks",

points=[

models.PointStruct(

id=idx,

vector=encoder.encode(doc["company"]).tolist(),

payload=doc

) for idx, doc in enumerate(valid_data)

]

)Step 6:执行查询并检索结果

# 执行查询并获取相似结果

query_prompt = "市值较高的科技公司"

query_vector = encoder.encode(query_prompt).tolist()

search_results = qdrant.search(

collection_name="top_stocks",

query_vector=query_vector,

limit=3,

with_payload=True

)

for result in search_results:

print(f"公司:{result.payload['company']},行业:{result.payload['industry']},市值:{result.payload['market_cap']}")结合检索结果进行生成

RAG还可以将检索结果传递给生成式模型,用于增强回答的准确性。例如:

from openai import OpenAI

client = OpenAI(base_url="http://127.0.0.1:8080/v1", api_key="your_api_key")

completion = client.chat.completions.create(

model="LLaMA_CPP",

messages=[

{"role": "system", "content": "你是股票领域的专家,帮助用户选择股票并回答他们的问题。"},

{"role": "user", "content": "NVIDIA的市值和市盈率是多少?"},

{"role": "assistant", "content": str(search_results)}

]

)

print(completion.choices[0].message["content"])通过RAG的检索增强,回答不仅限于模型训练的静态数据,还加入了最新的市场动态信息,使回答更加准确和实时。

07、结语

在追求AI内容生成准确性和可靠性的时代,RAG技术无疑是一项突破。通过将外部实时数据融入到生成过程,RAG显著降低了“幻觉”和“虚构”现象的发生,使AI生成的回答更具实际意义。结合向量数据库的语义搜索功能,RAG能够为用户提供更相关、更符合现实的信息。

RAG的检索与生成相结合,正推动AI走向更高层次的智能化应用,为需要知识密集型内容的场景提供了新的解决方案。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯