OpenAI的o1是万金油吗?专家为思维链“泼冷水”!研究发现:这三种任务不适合让AI“想太多” 原创

出品 | 51CTO技术栈(微信号:blog51cto)

别想太多!这句劝解有一定道理,在很多问题上过度思考反而会适得其反!

AI是否也会这样呢?

自 OpenAI 的 o1 推出后,思维链成为了 AI 能力升级的一个新方向。

掌握了“慢思考”的 AI ,通过思维链的逐步推理,大幅提高了模型理解问题的深度和准确性。o1在国际数学奥林匹克(IMO)资格考试中取得了 83% 的惊人准确率,让人直呼逆天。

图片

图片

这种提升,正来源于 AI 对人类解决问题时逐步思考过程的模仿。

受到人类认知心理学的启发,普林斯敦大学和纽约大学的团队合作,希望验证在哪些特定任务中,思维链会对 AI 的任务表现起到负面作用。

图片

图片

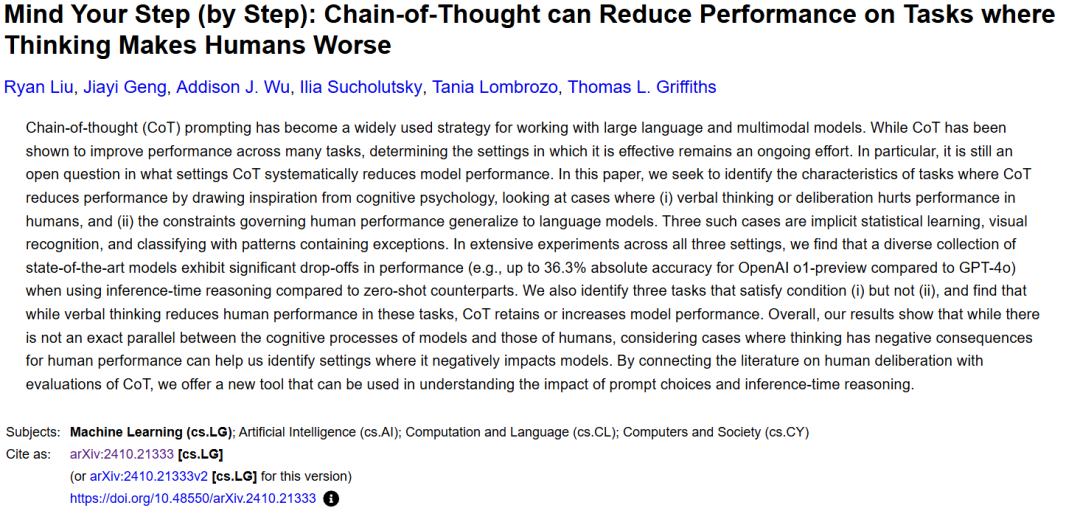

先甩个结论:在人类不能“想太多”的任务上,有半数任务中思维链同样起到了负向作用,分别是:隐式统计学习(Implicit Statistical Learning, ISL)、面部识别(Face Recognition, FR)和含有例外的数据分类(Classification of Data with Exceptions, CDE)。

1.6个人类不适合过度思考的任务,AI中了三个

过度思考降低人类能力的任务,也可能是CoT损害模型性能的任务。

顺着这个思路,该研究团队找到了6个人类不能“想太多”的任务。

图片

图片

根据论文,人类不适合的过度思考的六种任务可以分为两类:

1. 隐式统计学习(上图中:ISL):分类由人工语法生成的字符串。在这项任务中,人如果过度思考,反而会干扰潜意识中的统计规律学习,导致表现下降。

2. 面部识别(上图中:FR):从一组具有相似描述的面孔中识别特定的脸。若过度思考,会破坏直觉性的视觉识别过程,影响识别准确率。

3. 含有例外的数据分类(上图中:CDE):在存在例外的情况下学习标签。过度思考会导致对规则的过度概括,忽略例外情况,从而降低准确性。

4. 自然语言推理(上图中:NLI):识别逻辑上的不一致。过度思考可能使人们更容易忽视逻辑不一致性。

5. 空间直觉(上图中:SI):倾斜水杯的判断。若人过度思考,则可能干扰直觉性的空间判断。

6. 工作记忆(上图中:WM):聚合文本中描述的多个特征以做出决策。过度思考容易使人信息过载,影响决策质量。

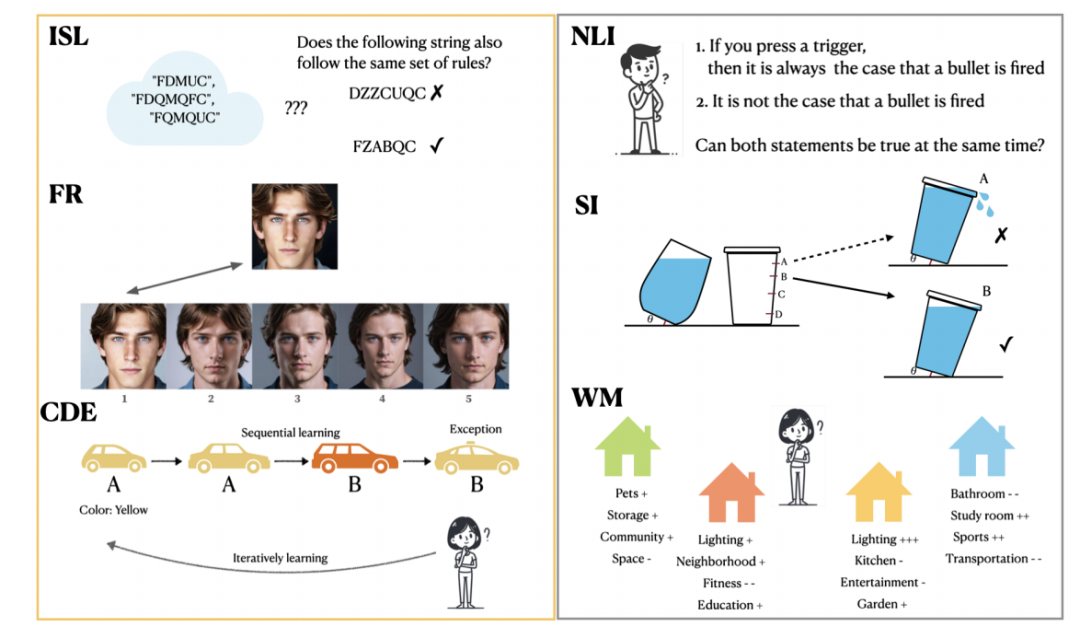

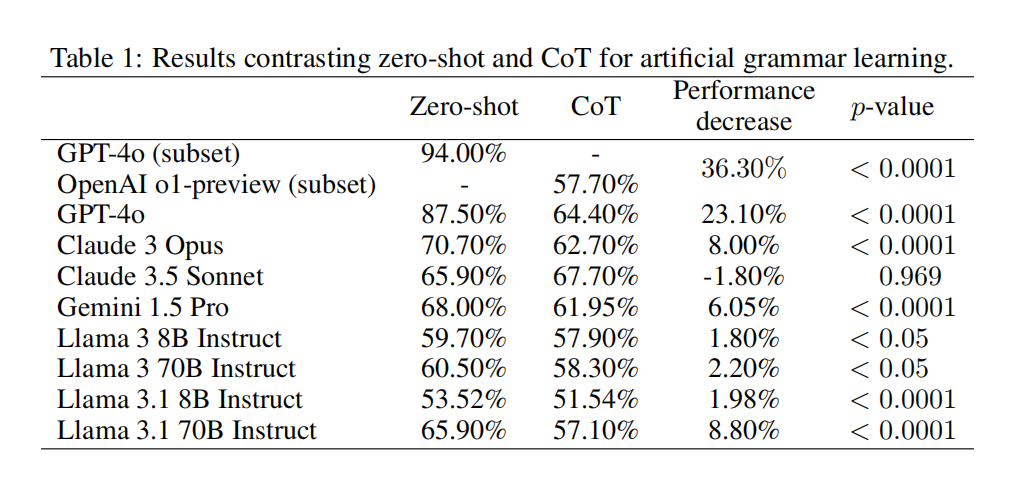

在实验中,除了 o1 以外, GPT-4o, Claude 3.5 Sonnet, Claude 3 Opus, Gemini 1.5 Pro 等主流模型也都被测到了。除了 o1 自带思维链,其他的模型则使用了一句简单的Prompt“Please reason about your answer before answering “Yes” or “No”(请在回答是或否前进行推理)”,人为配置了思考过程。

结果表明,在前三项任务中,模型性能都同人一样,出现了下降。

图片

图片

上图:任务一结果,OpenAIo1预览版,与GPT-4o 直给答案相比,绝对精度降低了36.3%。

不过,也有三个任务 AI 并未受到思考过度的干扰,这体现了人类与 AI 能力的不同。

2.AI不受影响的任务,以及为什么?

在自然语言推理任务中,CoT通常使得模型能力不降反升。

尤其在GPT-4o中,CoT对MNLI和SNLI(数据集名)的性能提高了40%以上。然而,在直给答案的Prompt引导下表现最好的模型——Gemini 1.5 Pro中,研究却看到了CoT造成的性能下降。

这说明,在自然语言推理任务下,思维链能帮助推理“底子”较弱的模型提升逻辑推理能力。

第二,在空间直觉任务上,CoT对模型性能的影响未有统计学的意义。原因很简单:LLM没有直觉!在如何倾斜水杯,水杯中的水会溢出来的这个问题上,模型不具有人类所有的运动模拟能力,物理模型仍然留待突破。

最后,在工作记忆任务上,CoT 也通常使得模型的性能得到提升。

在这个任务中,参与者被展示了48个有关公寓的描述,其中这些陈述描述了四个公寓选择中的一个积极、消极或中性的方面。在要求人类进行选择时,大多数人会做出糟糕的判断。

不过,由于模型记忆容量远超人类,不易出现信息过载现象,因此逐步思考后,保持了良好的决策水平。

https://www.51cto.com/aigc/