击败SDXL登顶SOTA | CoMat:端到端的扩散模型微调策略

文章链接:https://arxiv.org/pdf/2404.03653

项目链接:https://caraj7.github.io/comat/

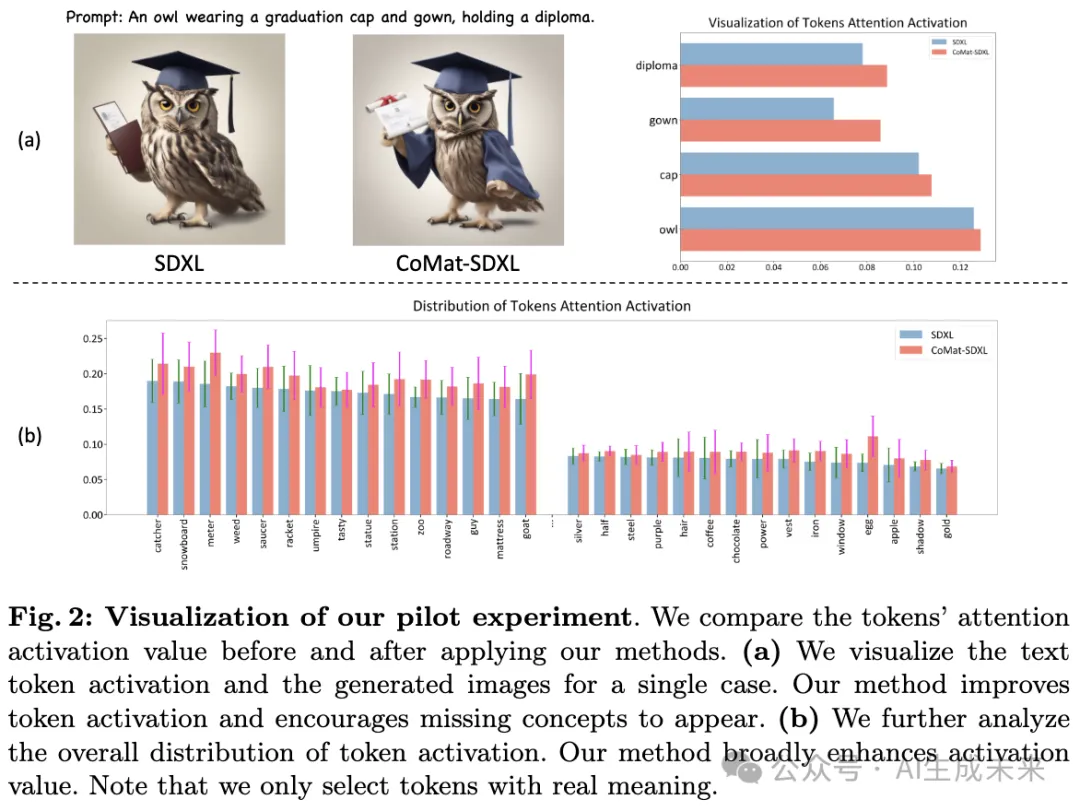

扩散模型在文本到图像生成领域取得了巨大成功。然而,缓解文本提示和图像之间的不对齐仍然具有挑战性。不对齐的根因尚未得到广泛调查。不对齐是由于token注意力激活不足引起的,进一步将这种现象归因于扩散模型的训练范式所导致的条件利用不足。

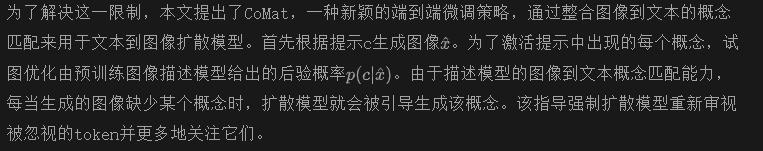

为了解决这个问题,本文提出了CoMat,这是一个端到端的扩散模型微调策略,具有图像到文本概念匹配机制。利用图像描述模型来衡量图像到文本的对齐,并引导扩散模型重新访问被忽视的token。此外还提出了一种新颖的属性集中模块来解决属性绑定问题。在没有任何图像或人类偏好数据的情况下,仅使用了20K个文本提示来微调SDXL以获得CoMat-SDXL。大量实验证明,CoMat-SDXL在两个文本到图像对齐基准测试中明显优于基线模型SDXL,并达到了最先进的性能水平。

介绍

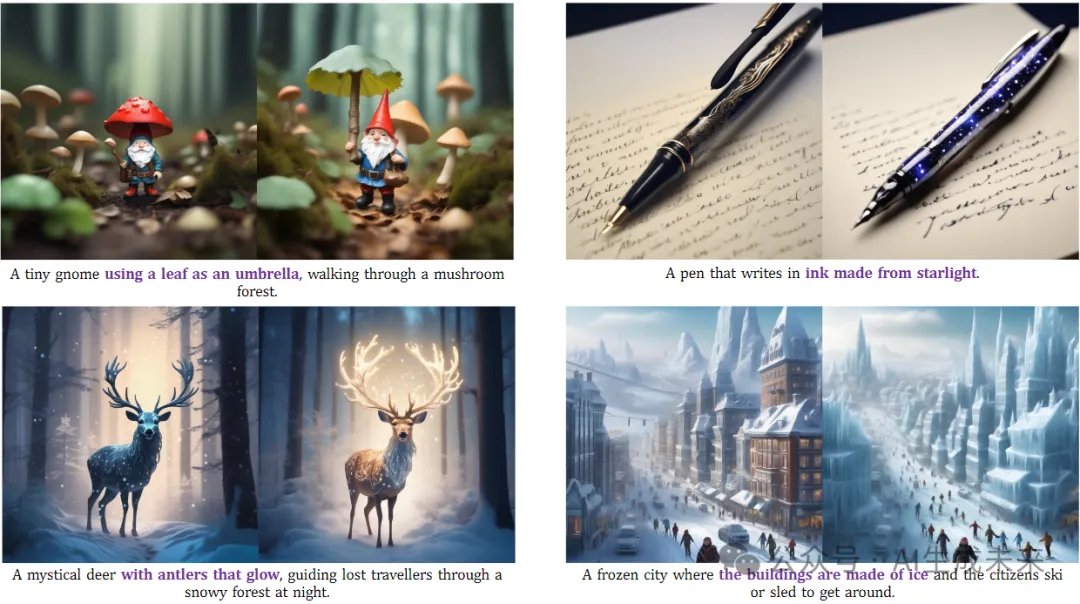

最近,随着扩散模型的引入,文本到图像生成领域取得了可观的进展。这些模型在基于文本提示创建高保真度和多样化图像方面表现出了显著的性能。然而,对于这些模型来说,准确地与提示对齐仍然具有挑战性,特别是对于复杂的提示。如下图1所示,当前最先进的开源模型SDXL在生成实体或属性方面存在失败,例如,顶部行中提到的由蕾丝制成的羽毛和矮人。此外,它还未能理解提示中的关系。在图1的中间行中,它错误地生成了一个维多利亚绅士和一块上面有条河的被子。最近,各种工作提出了从语言学先验或大语言模型(LLM)中引入外部知识以解决这个问题。

然而,对于不对齐问题的合理解释仍然不足。为了进一步探索问题的原因,设计了一个试验,研究文本token的交叉注意力激活值。如下图2(a)所示的示例,礼服和文凭没有出现在图像中。与图像中显示的概念(即猫头鹰和帽子)相比,这两个token的激活值也处于较低水平。此外,我们还在图2(b)中可视化了token激活的整体分布。

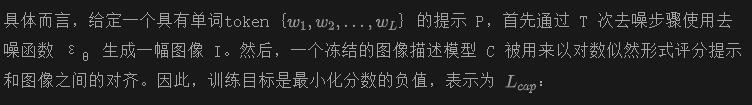

具体来说,模拟了训练过程,使用预训练的UNet对带有文本标题的嘈杂图像进行去噪。我们记录了每个文本token的激活值,并在空间维度上取平均值。分布表明,在生成过程中激活仍然保持在较低水平。因此,确定了不对齐问题是由于对某些文本token的注意力不足引起的。这种行为最初源于文本到图像扩散模型的训练范式:给定文本条件c和配对图像x,训练过程旨在学习条件分布

。然而,文本条件仅仅是对去噪损失的附加信息。在学习文本中的每个概念时没有明确的指导,扩散模型可能会轻易地忽略文本token的条件信息。

如前面图2(a)所示,我们的方法大大增强了“礼服”和“文凭”的token激活,并使它们出现在图像中。此外,图2(b)表明我们的方法提高了整个分布中的激活。另外,由于描述模型在识别和区分属性方面的不敏感性,发现属性对齐仍然不理想。因此,引入了一个实体属性集中模块,其中属性被强制在实体的区域内激活,以提高属性对齐。最后,添加了一个保真度保持部分,以保持扩散模型的生成能力。值得注意的是,我们的训练数据仅包括文本提示,不需要任何图像文本对或人类偏好数据。此外,作为一种端到端方法,在推理过程中不引入额外的开销,还展示了本文的方法与利用外部知识的方法是可组合的。

本文贡献总结如下:

- 提出了CoMat,一种具有图像到文本概念匹配机制的扩散模型微调策略。

- 引入了概念匹配模块和实体属性集中模块来促进概念和属性的生成。

- 与基线模型进行的广泛定量和定性比较表明,所提出的方法具有更优越的文本到图像生成能力。

相关工作

文本到图像对齐

文本到图像对齐是增强提示和生成图像之间一致性的问题,涉及到存在性、属性绑定、关系等多个方面。近期的方法主要通过三种方式来解决这个问题。

基于注意力的方法旨在修改或添加限制到UNet中的注意力模块中的注意力图。这种方法通常需要针对每个不对齐问题进行特定的设计。例如,Attend-and-Excite通过激励每个对象的注意力分数来改善对象的存在性,而SynGen通过调节修饰语和实体之间的注意力图的距离来增强属性绑定。

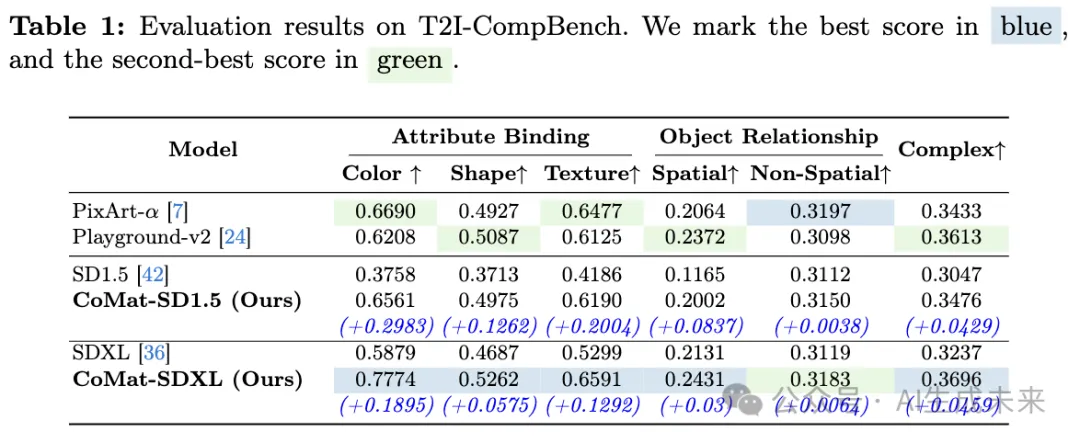

基于规划的方法首先从用户的输入或大语言模型(LLM)的生成中获得图像布局,然后在给定布局的条件下生成对齐的图像。此外,一些工作提出使用其他视觉专家模型,如grounded-sam、多模态LLM或图像编辑模型,进一步完善图像。尽管这种集成将复合提示分解为单个对象,但它并不能解决下游扩散模型的不准确性,并且仍然存在不正确的属性绑定问题。此外,在推理过程中会产生不可忽略的成本。

此外,一些工作旨在利用来自图像理解模型的反馈来增强对齐。[21, 46]通过对由VQA模型选择的对齐良好的生成图像进行微调扩散模型,以策略性地偏置生成分布。其他工作提出以在线方式优化扩散模型。对于通用奖励,[4,13]引入了RL微调。而对于可微分奖励,[11, 55, 57]提出通过去噪过程直接反向传播奖励函数梯度。我们的概念匹配模块可以被视为直接利用描述生成器作为可微分奖励模型。

与本文的工作类似,[14]提出对生成的图像添加描述,并优化生成的描述与文本提示之间的一致性。虽然图像描述模型也参与其中,但它们未能提供详细的指导。生成的描述可能会遗漏关键概念,并且可能会添加不必要的特征,这两者都导致了优化目标的次优性。

图像描述模型

这里的图像描述模型是指那些在各种视觉和语言任务上进行了预训练(例如,图像文本匹配、(masked)语言建模),然后在图像描述任务上进行了微调。已经提出了各种模型架构[25,26,49,50,60]。BLIP采用了融合编码器架构,而GIT采用了统一的Transformer架构。最近,多模型大语言模型已经蓬勃发展。例如,LLaVA利用LLM作为文本解码器,并取得了令人印象深刻的结果。

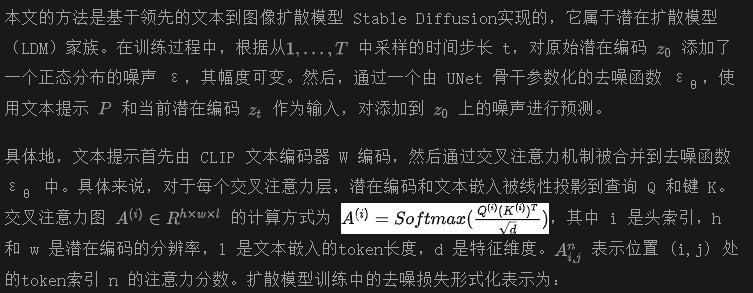

准备工作

方法

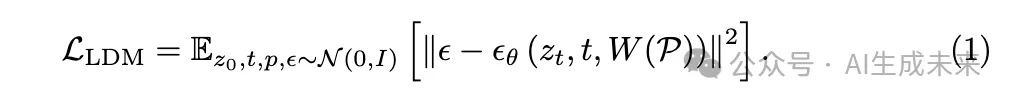

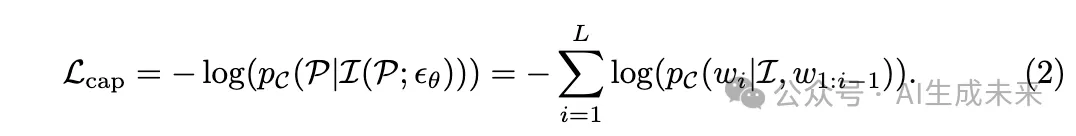

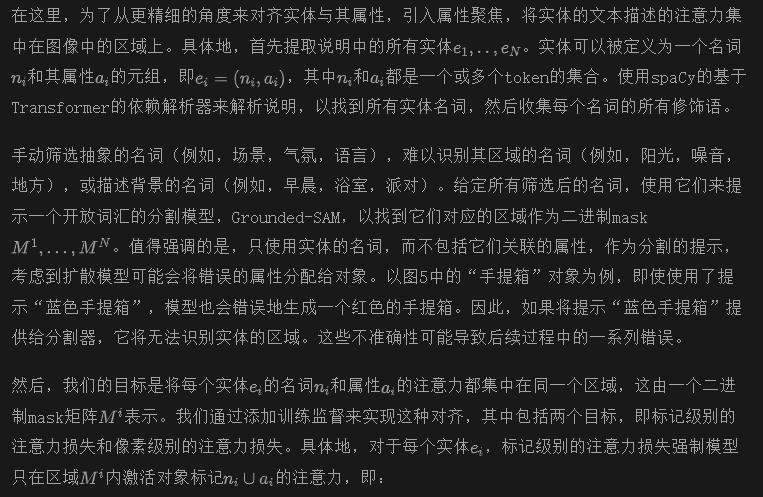

本文方法的整体框架如图4所示,由三个模块组成:概念匹配、属性集中和保真度保持。将通过图像描述模型介绍了图像到文本概念匹配机制。然后详细介绍了用于促进属性绑定的属性集中模块。随后,介绍了如何保留扩散模型的生成能力。最后,将三个部分结合起来进行联合学习。

概念匹配

导致不对齐问题的根本原因在于对上下文信息的不完全利用。因此,即使所有的文本条件都呈现出来,扩散模型也很少关注某些token,因此在生成的图像中缺少相应的概念。为了解决这个问题,我们的关键见解是在生成的图像上添加监督以检测缺失的概念。

通过利用图像描述模型的图像理解能力来实现这一目标,该模型可以根据给定的文本提示准确识别生成的图像中不存在的概念。通过描述模型的监督,扩散模型被迫重新审视文本token,以搜索被忽视的条件信息,并且会赋予先前被忽视的文本概念更大的重要性,以实现更好的文本-图像对齐。

实际上,来自描述模型的分数可以被视为微调扩散模型的差分奖励。为了通过整个迭代去噪过程进行梯度更新,遵循 [55] 的做法,对去噪网络 εθ 进行微调,通过简单地停止去噪网络输入的梯度来确保训练的有效性和效率。此外,值得注意的是,图像中的概念涉及到一个广泛的领域,我们的概念匹配模块可以缓解各种不对齐问题,如对象存在和复杂关系。

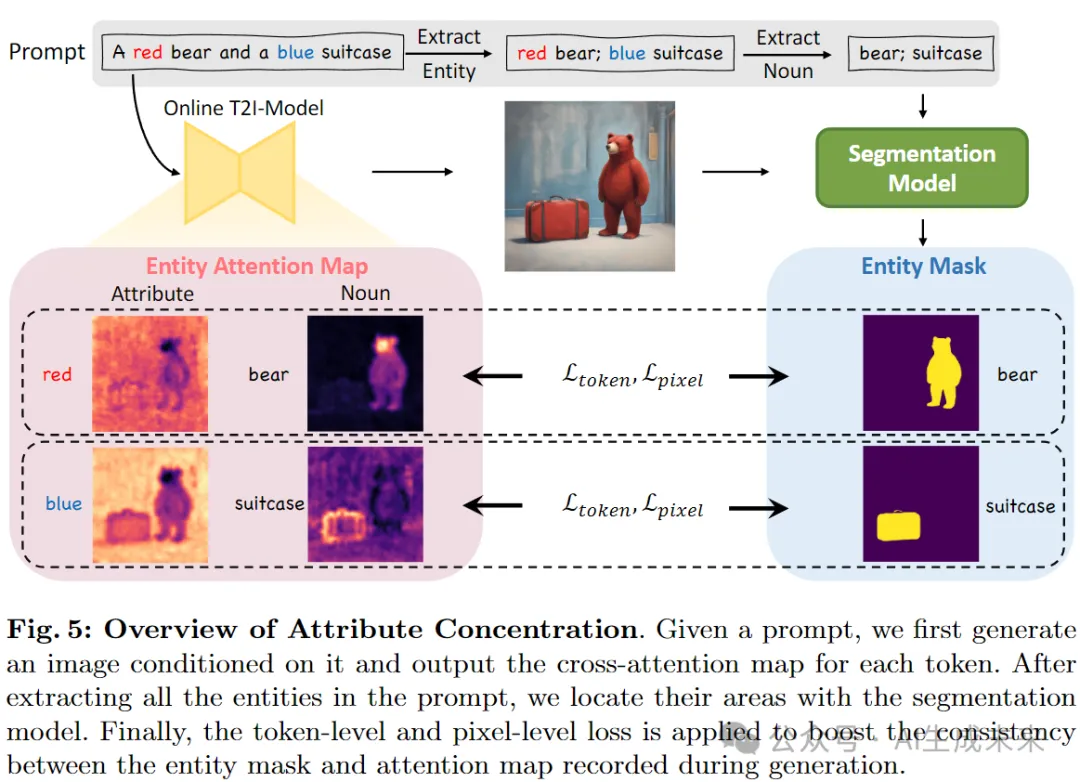

属性聚焦

已经有报道称,将属性与图像联系起来是文本到图像扩散模型中的一个挑战性问题。正如图5所示的例子所基于的SDXL模型,单词“红色”和“蓝色”的注意力大部分被激活在背景中,与其相应的对象几乎没有对齐。我们的概念匹配模块可以在一定程度上缓解这个问题。然而,受限于说明模型对对象属性的不敏感,性能改进是有限的。

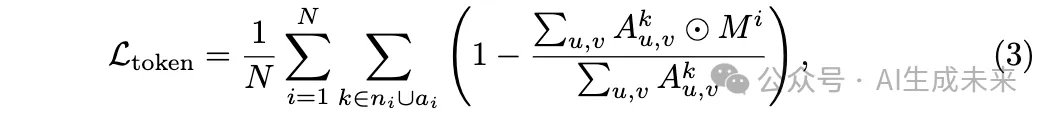

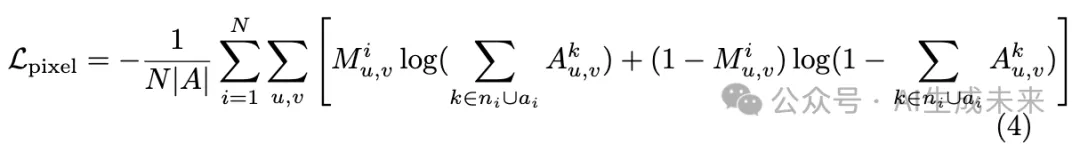

其中 ⊙ 表示元素级乘法。像素级别的注意力损失进一步强制区域内的每个像素仅关注对象token,使用二元交叉熵损失函数:

其中 |A| 表示注意力图中的像素数量。与 [52] 不同,提示中的某些对象可能由于不对齐而未出现在生成的图像中。在这种情况下,像素级别的注意力损失仍然有效。当mask完全为零时,表示当前图像中没有任何像素应该关注缺失的对象token。此外,考虑到计算成本,仅在在线模型的图像生成过程中的 r 个随机选择的时间步骤上计算上述两个损失。

保真度保持

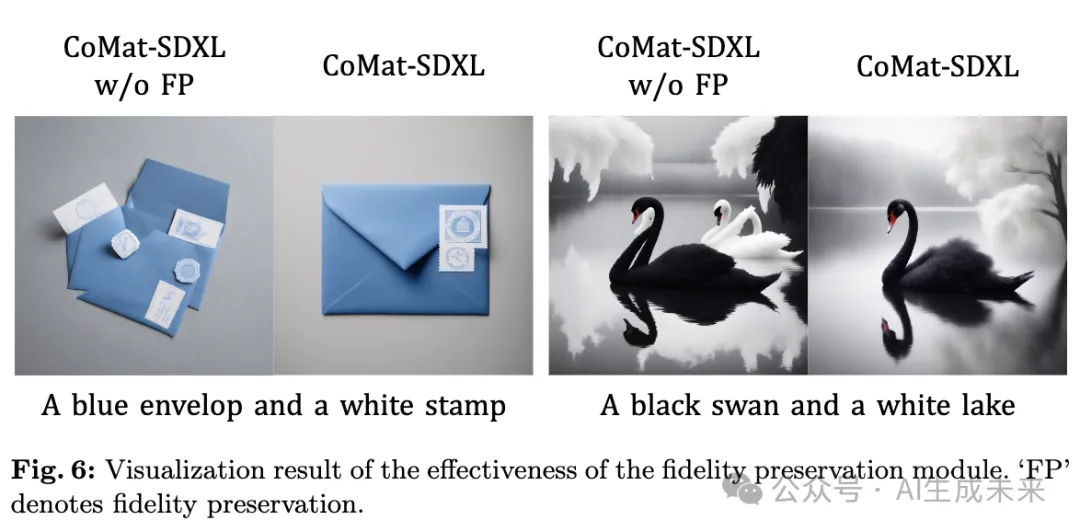

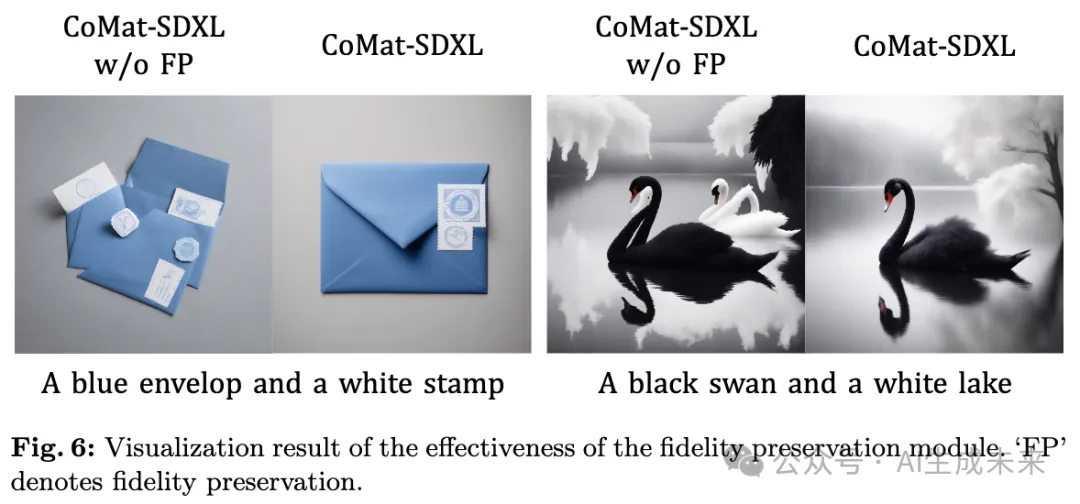

由于当前的微调过程完全由图像描述模型和属性与实体之间的先验知识驱动,扩散模型可能会迅速过拟合奖励,失去其原始能力,并生成退化的图像,如下图6所示。

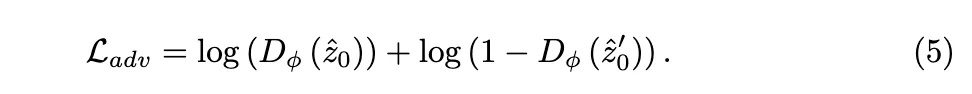

目标是微调在线模型,以最小化这个对抗损失,同时训练鉴别器以最大化它。

联合学习

在这里,将描述模型损失、属性集中损失和对抗损失结合起来,建立我们的在线扩散模型的训练目标,具体如下:

其中 α、β 和 λ 是用于平衡不同损失项的缩放因子。

实验

实验设置

基础模型设置。主要在 SDXL 上实现了所有实验中的方法,它是最先进的开源文本到图像模型。此外,在某些实验中,还在 Stable Diffusion v1.5 (SD1.5) 上评估了我们的方法,以进行更全面的比较。对于描述模型,选择了在 COCO 图像描述数据上微调的 BLIP。至于保真度保持中的鉴别器,直接采用了 SD1.5 的预训练 UNet。

数据集。由于传递给扩散模型的提示需要足够具有挑战性,以导致概念缺失,我们直接利用了几个文本到图像对齐基准上提供的训练数据或文本提示。具体而言,训练数据包括 T2I-CompBench提供的训练集、HRS-Bench中的所有数据以及从 ABC-6K随机选择的 5,000 个提示。总体而言,这些约为 20,000 个文本提示。请注意,训练集的构成可以根据目标改进的能力自由调整。

训练细节。在本文的方法中,将 LoRA 层注入到在线训练模型和鉴别器的 UNet 中,并保持所有其他组件冻结。对于 SDXL 和 SD1.5,在 8 个 NVIDIA A100 GPU 上训练了 2,000 次迭代。对 SDXL 使用了batch大小为6,对 SD1.5 使用了batch大小为 4。从其他开放词汇分割模型中选择了 Grounded-SAM。DDPM 采样器使用了 50 步来生成图像,用于在线训练模型和原始模型。特别地,遵循 [55],仅在这 50 步中的 5 步中启用梯度,其中属性集中模块也会被操作。此外,为了加快训练速度,使用训练提示提前生成并保存预训练模型的生成潜在编码,这些编码稍后在微调过程中输入鉴别器。

基准。在两个基准上评估我们的方法:

- T2I-CompBench是一个用于组合式文本到图像生成的基准。它包括来自 3 个类别(属性绑定、对象关系和复杂构图)和 6 个子类别(颜色绑定、形状绑定、纹理绑定、空间关系、非空间关系和复杂构图)的 6,000 个组合式文本提示。它采用了 BLIP-VQA 模型、CLIP 和 UniDet 来自动评估生成结果。每个子类别包含 700 个训练提示和 300 个测试提示。

- TIFA是一个用于评估文本到图像忠实度的基准。它使用预先生成的问题-答案对和 VQA 模型来评估生成结果。该基准包含了 4,000 个多样化的文本提示和跨越 12 个类别的 25,000 个问题。

遵循这两个基准的默认评估设置。

定量结果

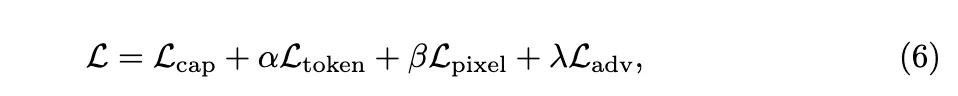

将我们的方法与基线模型进行比较:SD1.5 和 SDXL,以及两种最先进的开源文本到图像模型:PixArt-α 和 Playground-v2。PixArt-α 采用了 transformer 架构,并利用了由大视觉语言模型自动标注的密集伪描述来辅助文本-图像对齐学习。Playground-v2 的结构与 SDXL 类似,但在生成的图像上更受欢迎。

T2I-CompBench。评估结果如下表1所示。

值得注意的是,由于评估代码的演变,我们无法复现一些相关工作中报告的结果。我们展示的所有结果都基于 GitHub 上最新发布的代码。与我们的基线模型相比,在所有六个子类别中,观察到显著的增益。具体而言,SD1.5 在颜色、形状和纹理属性上分别增加了 0.2983、0.1262 和 0.2004。在对象关系和复杂推理方面,CoMat-SD1.5 也获得了显著改进,空间关系的改进超过了 70%。使用我们的方法,SD1.5 甚至可以在与 PixArt-α 和 Playground-v2 相比中获得更好或可比的结果。

当将我们的方法应用于更大的基础模型 SDXL 时,仍然可以看到巨大的改进。CoMat-SDXL 在属性绑定、空间关系和复杂构图方面表现最佳。发现我们的方法在非空间关系中未能获得最佳结果。推测这是由于我们文本提示中的训练分布,其中大多数提示是描述性短语,旨在混淆扩散模型。在非空间关系中的提示类型可能仅占很小的一部分。CoMat-SDXL的架构流程如下图8:

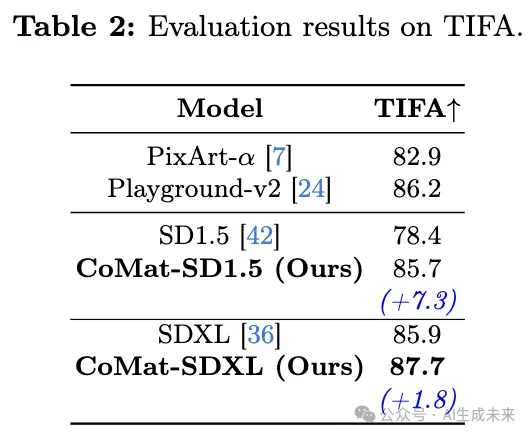

TIFA。 在下表2中展示了 TIFA 的结果。我们的 CoMat-SDXL 达到了最佳表现,比 SDXL 提高了 1.8 分。此外,CoMat 对 SD1.5 的提升达到了 7.3 分,远远超过了 PixArt-α。

定性结果

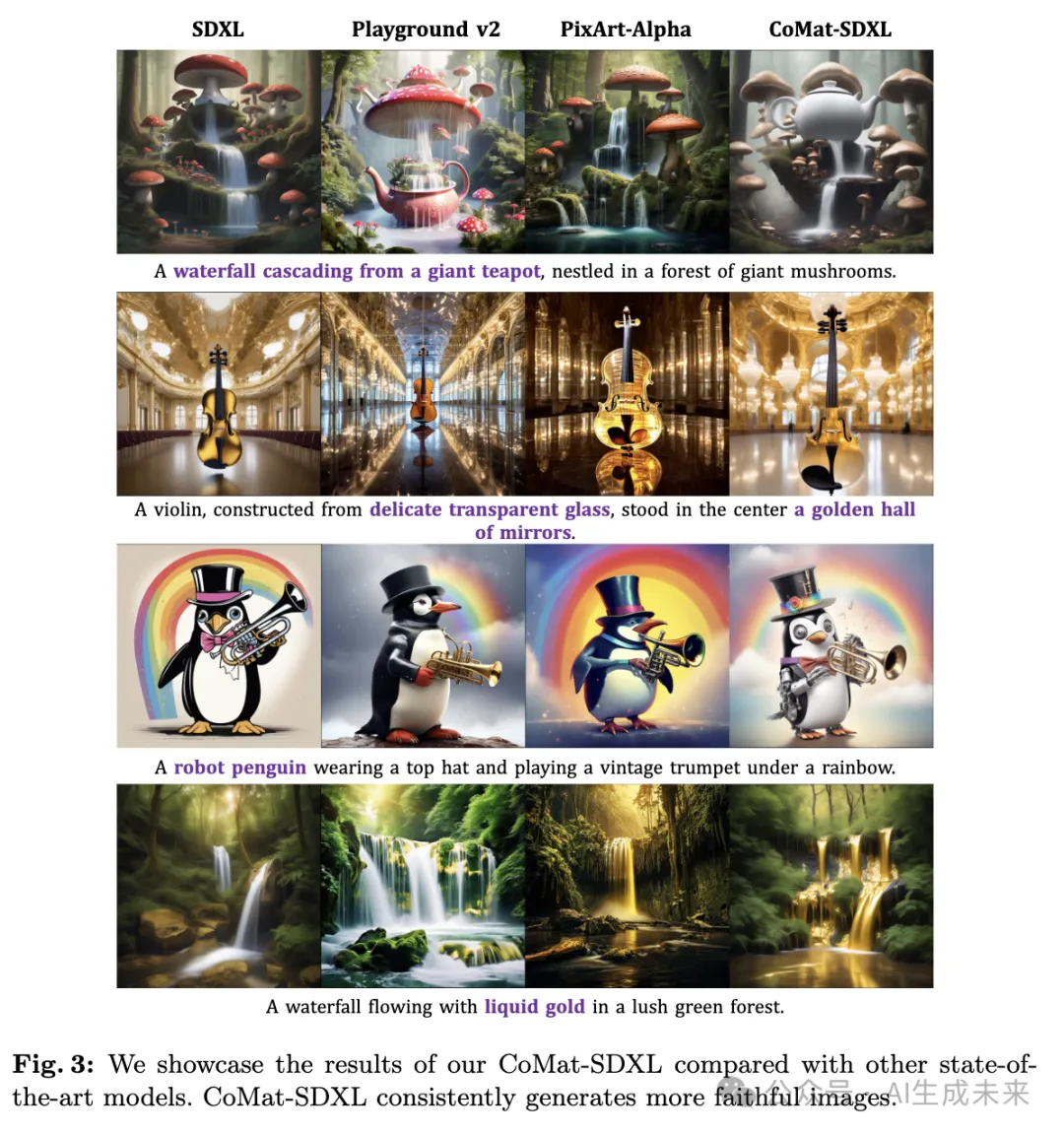

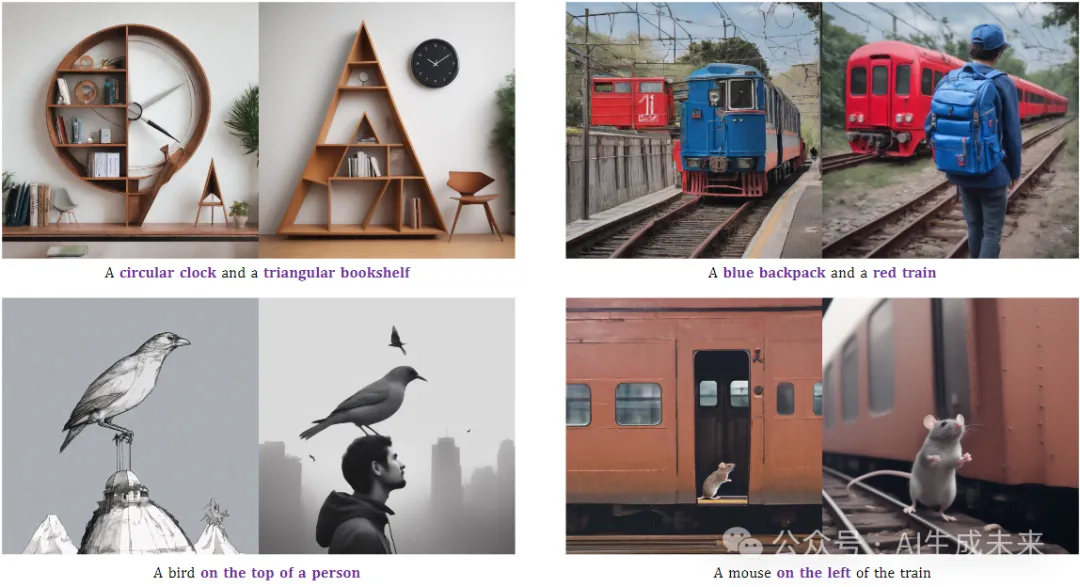

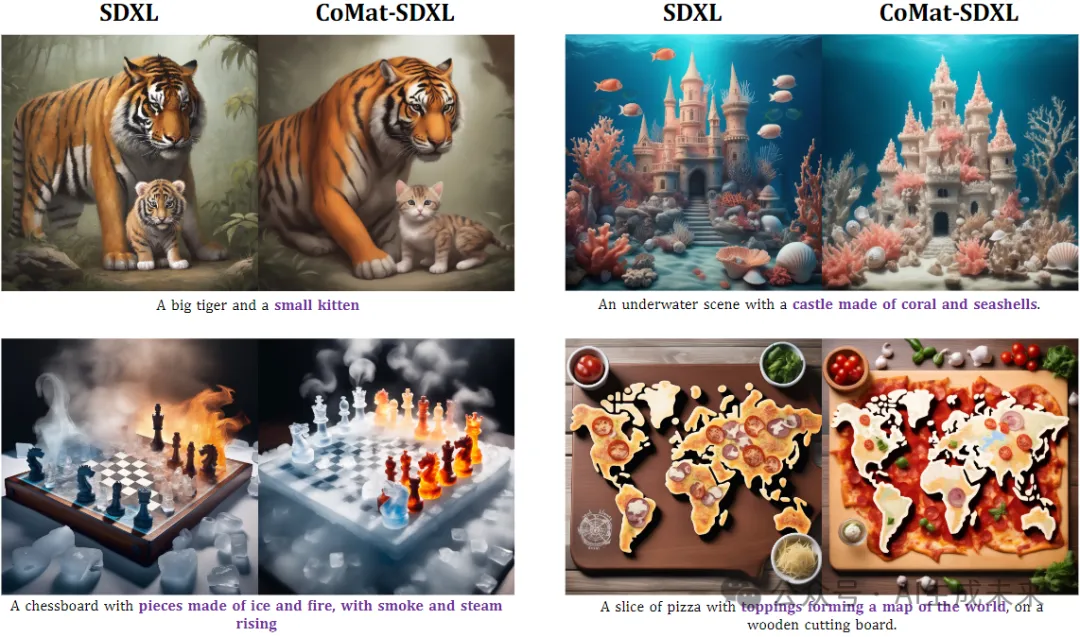

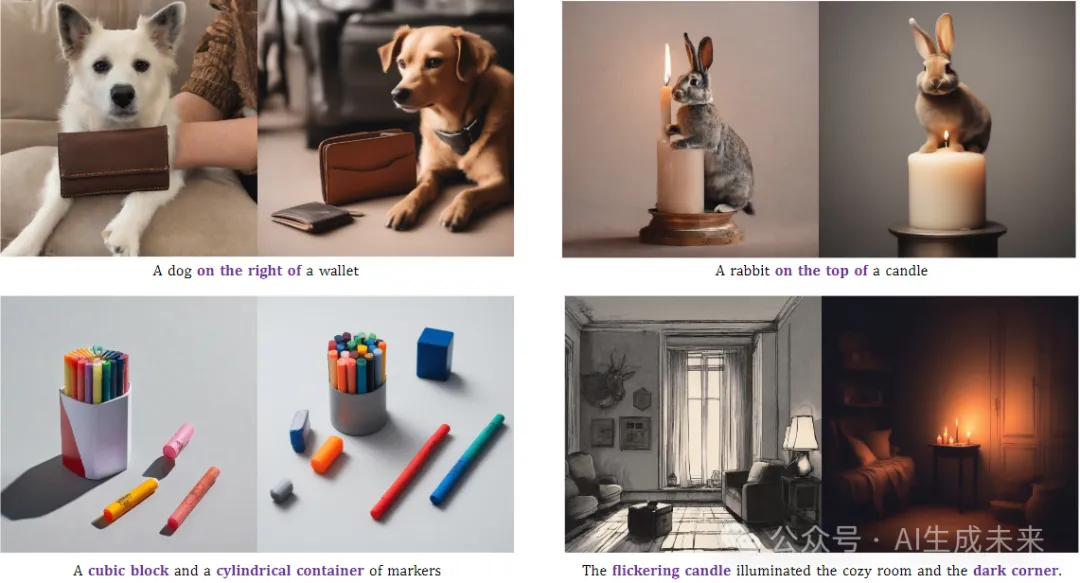

下图3呈现了CoMat-SDXL与其他最先进的扩散模型的并排比较。观察到这些模型与CoMat-SDXL相比,表现出较低的条件利用能力。图3中的提示都包含与现实现象矛盾的概念。所有三个比较的模型都坚持原始偏见,并选择忽略不现实的内容(例如,从茶壶中倾泻出的瀑布、透明的小提琴、机器人企鹅和液态黄金的瀑布),这导致了不对齐。然而,通过训练以与提示中的条件保持忠实对齐,CoMat-SDXL遵循了不现实的条件并提供了对齐良好的图像。

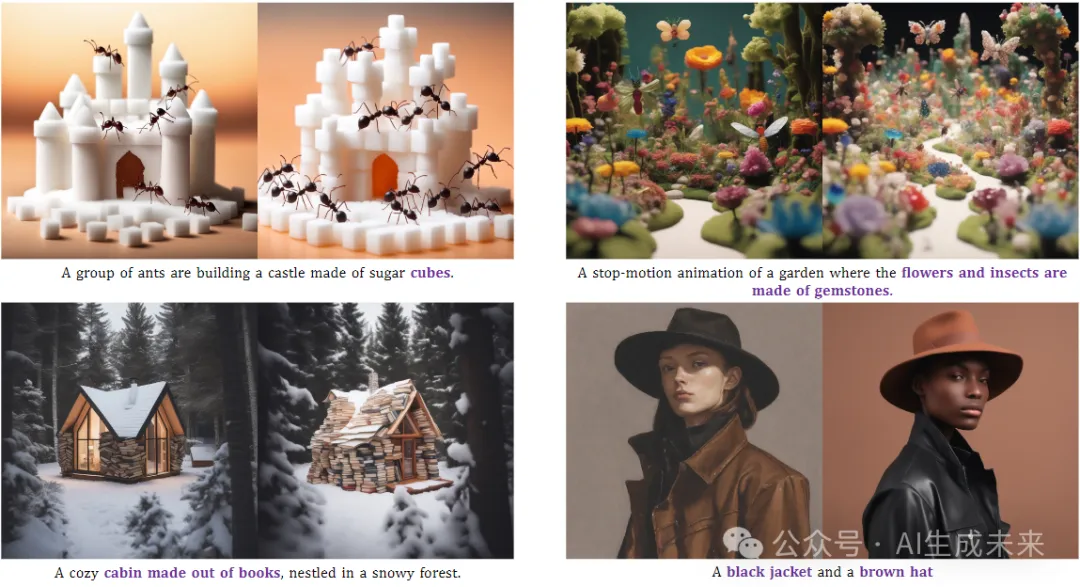

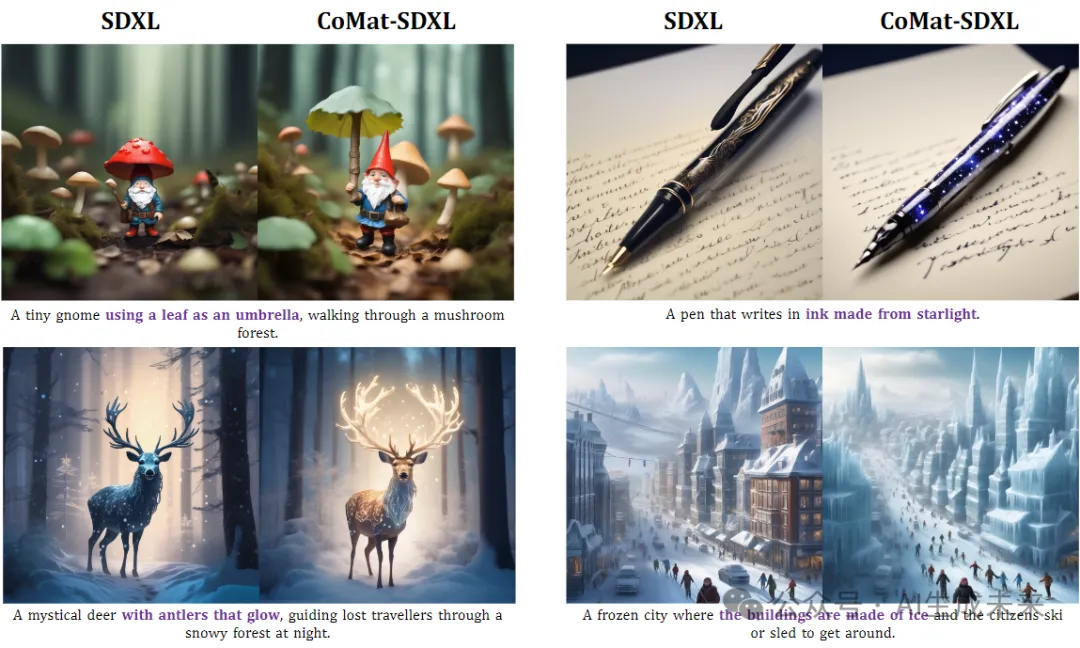

更多 SDXL 和 CoMat-SDXL 的比较:

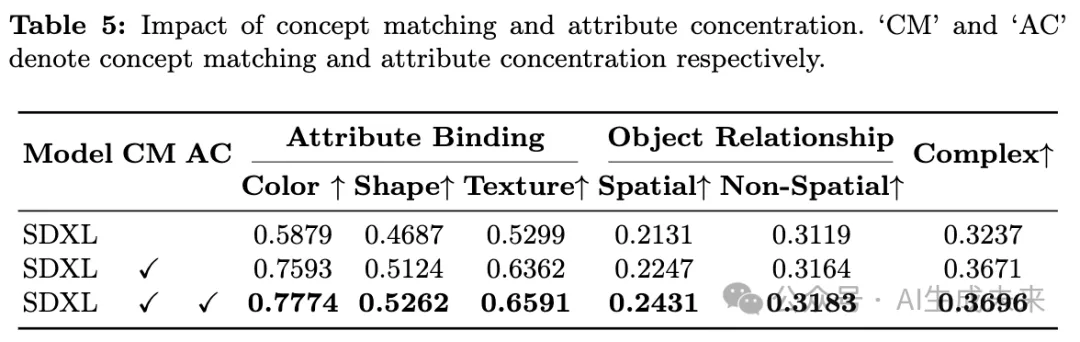

消融研究

在这里,旨在评估我们框架中每个组件和模型设置的重要性,并尝试回答三个问题:

1)两个主要模块,即概念匹配和属性集中,是否都是必要且有效的?

2)保真性保护模块是否必要,以及如何选择鉴别器?

3)如何选择用于图像描述模型的基础模型?

概念匹配和属性集中。在下表5中,展示了旨在确定概念匹配和属性集中模块有效性的T2I-CompBench结果。发现概念匹配模块为基线模型带来了主要的增益。此外,属性聚焦模块在T2I-CompBench的所有六个子类别中进一步改善了性能。

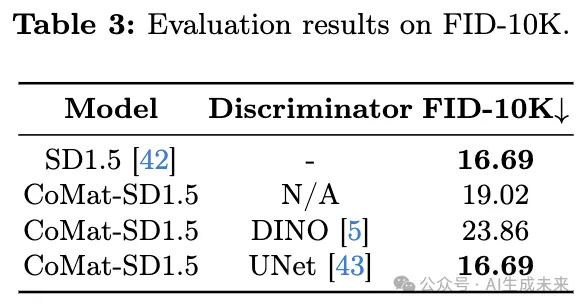

不同的鉴别器。 在这里消融了鉴别器的选择。从COCO验证集中随机抽取了10K个文本-图像对。计算了它的FID分数,以定量评估生成图像的逼真程度。如下表3所示,第二行显示了没有鉴别器的情况,即没有保真感知模块,模型的生成能力大大恶化,FID分数从16.69增加到19.02。

还在下图6中可视化了生成的图像。如图所示,没有保真性保护,扩散模型生成的信封和天鹅形状不良。这是因为扩散模型只尝试欺骗描述,失去了其原始的生成能力。

此外,受到[45]的启发,还尝试使用预训练的DINO来区分原始模型和在线训练模型在图像空间生成的图像。然而发现DINO无法提供有效的指导,并严重干扰了训练过程,导致FID分数甚至高于不应用鉴别器的情况。使用预训练的UNet效果最好。FID分数与原始模型相同,在生成的图像中没有明显的退化。

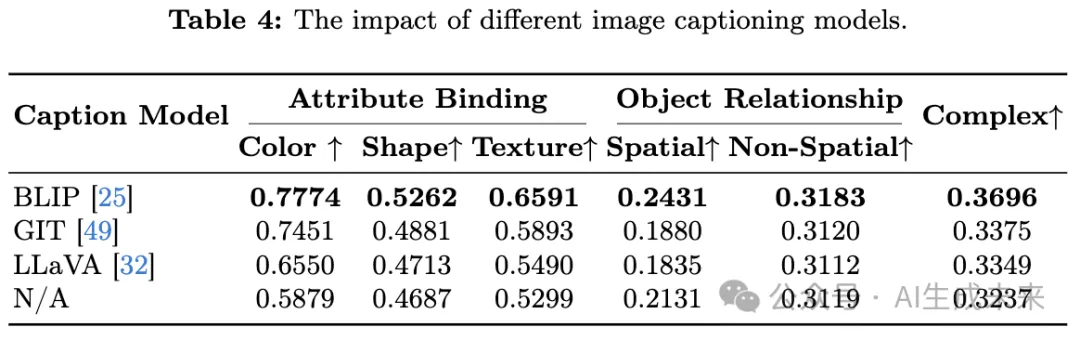

不同的图像描述模型。 在下表4中展示了使用不同图像描述模型的T2I-CompBench结果,其中底部行对应于没有概念匹配优化的基线扩散模型。

发现所有三个描述模型都可以通过我们的框架提升扩散模型的性能,其中BLIP实现了最佳性能。特别要注意的是,通用多媒体大语言模型LLaVA无法捕捉与其他两个在图像描述任务上训练的描述模型相比的性能。

限制

如何有效地将多模态大语言模型(MLLMs)纳入我们提出的方法中,以改进文本到图像扩散模型,仍然未经深入探讨。鉴于它们在图像-文本理解方面的SOTA水平,我们将专注于利用MLLMs实现更细粒度的对齐和生成保真度。此外,还观察到CoMat在适应3D领域方面的潜力,促进文本到3D生成,实现更强的对齐。

结论

本文提出了CoMat,一种配备图像到文本概念匹配的端到端扩散模型微调策略。利用图像描述模型感知图像中缺失的概念,并引导扩散模型审查文本token,找出被忽视的条件信息。这种概念匹配机制显著增强了扩散模型的条件利用率。此外,还介绍了属性集中模块,进一步促进属性绑定。我们的方法只需要文本提示进行训练,无需任何图像或人工标注的数据。通过大量实验证明,CoMat在多个方面远远优于其基线模型,甚至超过了商业产品。希望我们的工作能够启发未来对齐问题及其解决方案的研究。

本文转自 AI生成未来,作者:Dongzhi Jiang等