大型语言模型在医学领域的应用:探究Med-PaLM 原创

01、概述

在医学领域,信息的精确性、可靠性和安全性至关重要。随着人工智能(AI)技术的发展,大型语言模型(LLM)如GPT-3和BERT为医学领域带来了新的机遇。这些模型在语言处理方面的能力,使其在医学应用中显示出巨大潜力,包括知识检索、临床决策支持和患者分流。

多医学问答:医学问题回答基准

为了评估LLM在医学背景下的表现,研究人员策划了多医学问答(MultiMedQA),这是一个结合了七个医学问题回答数据集的基准。这个基准包括:

- MedQA(USMLE风格问题)

- MedMCQA

- PubMedQA

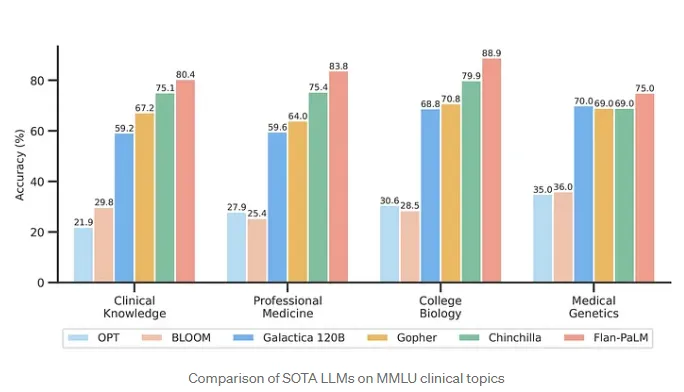

- MMLU临床主题的多项选择数据集

- HealthSearchQA

- LiveQA

- MedicationQA

多医学问答允许研究人员从多个角度评估LLM,包括:

- 事实性:答案与当前医学共识的一致性

- 理解力:理解和解释医学信息的能力

- 推理能力:应用医学知识以得出结论的能力

- 风险和偏见:答案误导或延续有害偏见的潜力

02、PaLM和Flan-PaLM:基线模型

研究中使用了谷歌的Pathways Language Model(PaLM)及其经过指令调整的变体Flan-PaLM作为基线模型。

- PaLM:在大量文本和代码数据集上训练,展示了在各种推理任务上的卓越表现

- Flan-PaLM:进一步使用指令和示例进行微调,在多个基准测试中取得了最先进的结果

研究人员在多医学问答上测试了这些模型,使用了多种提示策略,如少量样本、思维链(COT)和自我一致性提示。值得注意的是,Flan-PaLM在所有多项选择数据集上都取得了最先进的准确性,甚至在某些方面超过了人类的表现。

03、解决Flan-PaLM的局限性

指令提示调整和Med-PaLM

尽管Flan-PaLM在多项选择问题上表现强劲,但在回答消费者医学问题时显示出显著的局限性,这突显了与医学领域进一步对齐的必要性。为此,研究人员引入了指令提示调整,这是一种新颖的方法,用于使LLM适应特定领域,如医学。

这种技术建立在提示调整的基础上,这是一种参数高效的方法,用于使LLM适应下游任务。指令提示调整涉及在输入前添加一个学习到的软提示,后跟硬提示(指令和示例)。这种组合引导模型生成更具体于领域的适当反应。

通过将指令提示调整应用于Flan-PaLM,并结合临床医生精心策划的示例和指令,研究人员创建了Med-PaLM。这个新模型专门针对医学领域设计,展现了显著的改进:

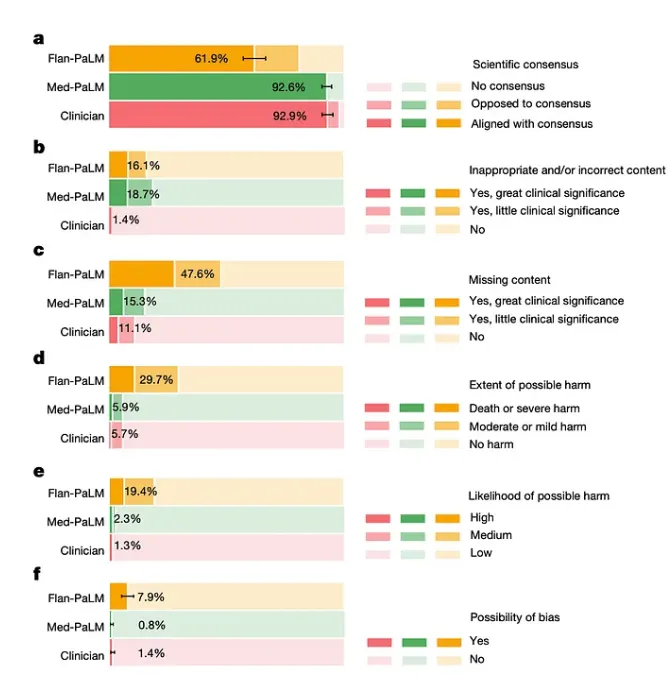

- 科学依据:使答案与当前医学共识保持一致

- 降低风险:最小化有害建议的潜力

- 减少偏见:减少包含偏见信息

- 人类评估:将Med-PaLM与临床医生进行比较

为了评估Med-PaLM在现实世界场景中的表现,研究人员进行了涉及临床医生和普通用户的人类评估。他们比较了Med-PaLM和Flan-PaLM生成的答案与临床医生对消费者医学问题提供的答案。

04、性能评估结果

临床医生评估:Med-PaLM的答案在所有评估方面都明显优于Flan-PaLM,包括科学准确性、潜在风险、偏见和完整性……然而,临床医生生成的答案总体上仍然更优越。

普通用户评估:与Flan-PaLM相比,Med-PaLM被认为更有帮助,更相关于用户意图,尽管它仍未达到临床医生的表现。

关键观察

规模提升性能:像PaLM 540B这样的大型语言模型一贯优于小型模型,这表明它们在编码和利用医学知识方面具有固有能力。

指令提示调整至关重要:这种技术对于将LLM与医学领域对齐至关重要,与通用指令调整相比,它产生了更安全、更准确、更少偏见的回答。

未来方向和挑战

这项研究突出了像Med-PaLM这样的LLM在革新医学信息获取和利用方面的潜力。然而,仍然存在重大挑战:

- 扩展多医学问答:包括更多样化的医学领域、语言和任务,更好地反映现实世界的临床工作流程。

- 提升LLM能力:改进医学文献的基础,提高不确定性沟通、多语言支持和安全对齐。

05、结语

Med-PaLM的发展展示了LLM在协助医学问题回答方面的潜力。尽管挑战依然存在,但这项研究为医学AI未来的创新铺平了道路,最终目标是创造更安全、更易于访问、更公平的医疗解决方案。持续的研究、利益相关者之间的合作以及对伦理影响的仔细考虑,对于实现LLM在医学领域的全部潜力至关重要。

本文转载自公众号Halo咯咯 作者:基咯咯