微软研究院新突破:如何让AI在专业领域更靠谱? 原创

01、概述

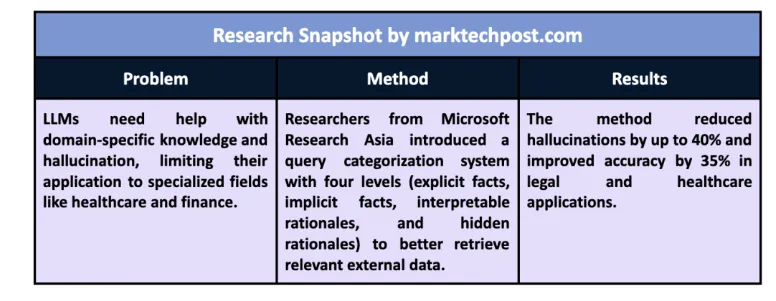

在人工智能的世界里,大型语言模型(LLMs)就像是瑞士军刀,多才多艺,几乎无所不能。但是,当它们遇到需要特定领域知识的任务时,比如医疗保健、法律和金融,这些万能的模型就显得有些力不从心了。这是为什么呢?因为它们在训练时使用的数据集往往缺乏最新的专业信息,导致它们在回答专业问题时可能会“幻觉”——也就是说,给出的答案可能不准确,甚至是错误的。

问题的根源

LLMs在处理一般知识时表现出色,但当涉及到专业或时效性查询时,它们的表现就不尽如人意了。这是因为大多数模型都是在静态数据上训练的,它们的知识库无法随时更新。想象一下,一个医疗AI模型如果不能访问最新的医疗指南,它又怎么能提供准确的医疗建议呢?

当前解决方案:微调和RAG

为了解决这个问题,研究人员尝试了多种方法,其中之一就是微调。微调可以让模型在特定领域的数据上重新训练,使其更好地适应特定任务。但这种方法既耗时又需要大量的训练数据,而且可能会导致模型过于专业化,反而在一般查询上表现不佳。

另一种方法是检索增强生成(RAG),它允许模型在生成答案的过程中实时检索外部数据。这种方法更灵活,可以提高模型的准确性和相关性。但RAG也有它的挑战,比如如何处理非结构化数据,比如文本、图像和表格等。

02、微软研究院的新方法

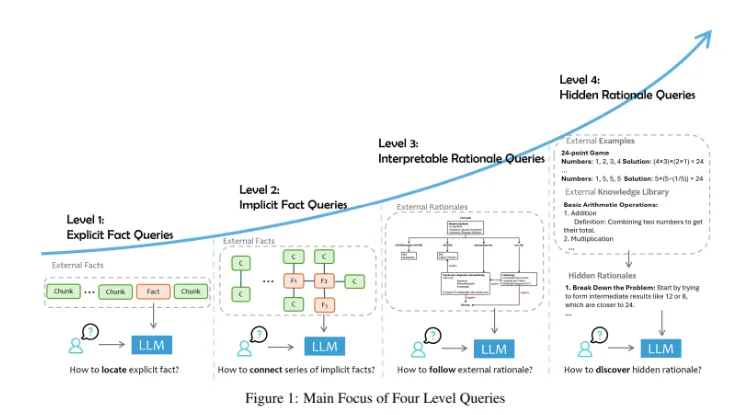

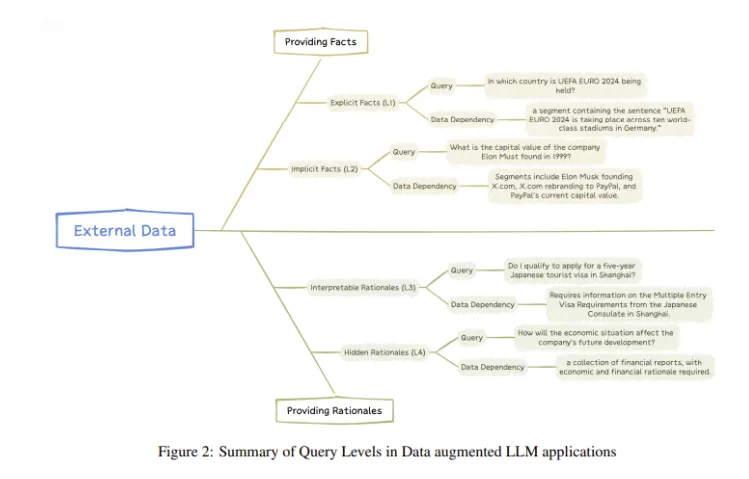

微软亚洲研究院的研究人员提出了一种新的方法,他们将用户查询分为四个不同的级别:明确事实、隐含事实、可解释理由和隐藏理由。这种分类有助于定制模型检索和处理数据的方法,确保它为特定任务选择最相关的信息。

四个查询级别

- 明确事实:比如“法国的首都是哪里?”这样的问题,答案可以直接从外部数据中检索得到。

- 隐含事实:需要更多的推理,比如结合多条信息来推断结论。

- 可解释理由:涉及特定领域的指南。

- 隐藏理由:需要深入推理,通常涉及抽象概念。

方法的优势

这种方法使LLMs能够区分这些查询类型,并应用适当级别的推理。例如,在没有明确答案的隐藏理由查询中,模型可以推断模式并使用特定领域的推理方法生成回答。这样,模型在检索所需信息和提供准确、基于上下文的回答方面变得更加高效。

实践成果

研究还突出了这种方法的显著成果。在医疗保健和法律分析等专业领域,模型的性能显著提高。例如,在医疗保健应用中,模型将幻觉率降低了高达40%,提供了更加可靠和有根据的回答。在法律系统中,模型在处理复杂文档和提供详细分析方面的准确性提高了35%。

03、结语

这项研究为在专业领域部署LLMs的一个基本问题提供了关键的解决方案。通过引入一个基于复杂性和类型的查询分类系统,微软研究院的研究人员开发了一种方法,提高了LLMs输出的准确性和可解释性。这个框架使LLMs能够检索最相关的外部数据,并有效地将其应用于特定领域的查询,减少幻觉并提高整体性能。研究表明,使用结构化查询分类可以提高高达40%的结果,这是AI驱动系统向前迈出的重要一步。通过解决数据检索问题和整合外部知识,这项研究为各种行业的更可靠和强大的LLM应用铺平了道路。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯