Emu3: 统一多模态输入与生成

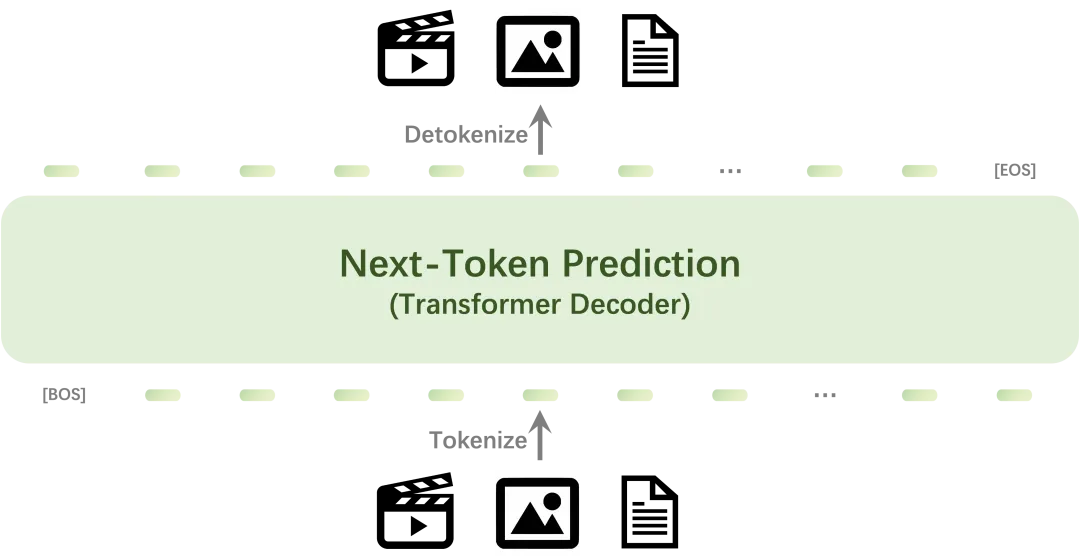

BAAI刚刚开源了Emu3多模态大模型,仅使用单个transformer,使用下一个token预测的方法从0进行训练!通过将图像、文本和视频tokenize到一个统一的离散的空间中,直接通过预测下一个token实现文本、图像和视频生成。

Homepage: https://emu.baai.ac.cn/

Github: https://github.com/baaivision/Emu3

Model: https://huggingface.co/BAAI/Emu3-Gen

Emu3

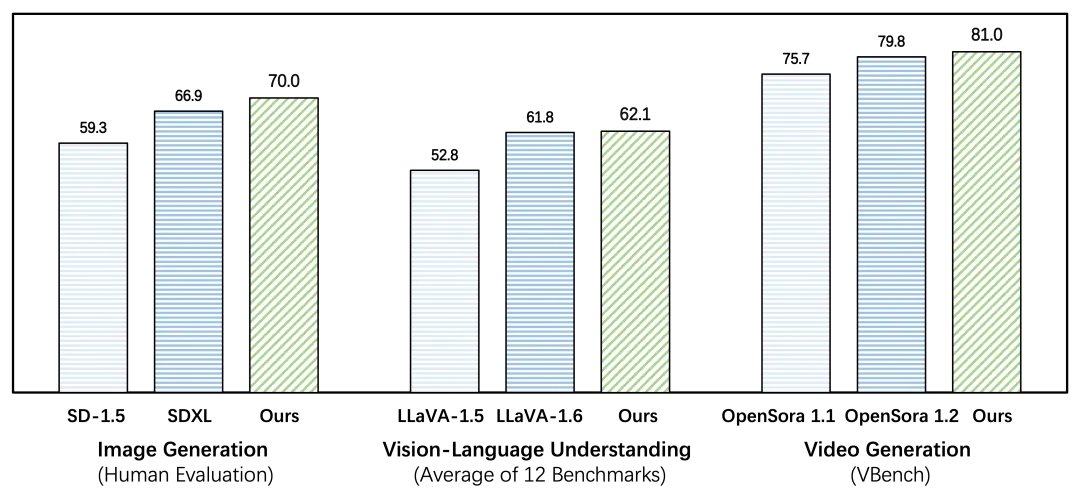

Emu3 在生成和感知任务中超越了多个任务的专用模型,表现优于主流开源模型如 SDXL、LLaVA-1.6 和 OpenSora-1.2,同时不需要基于Diffison或组合多种不同架构。

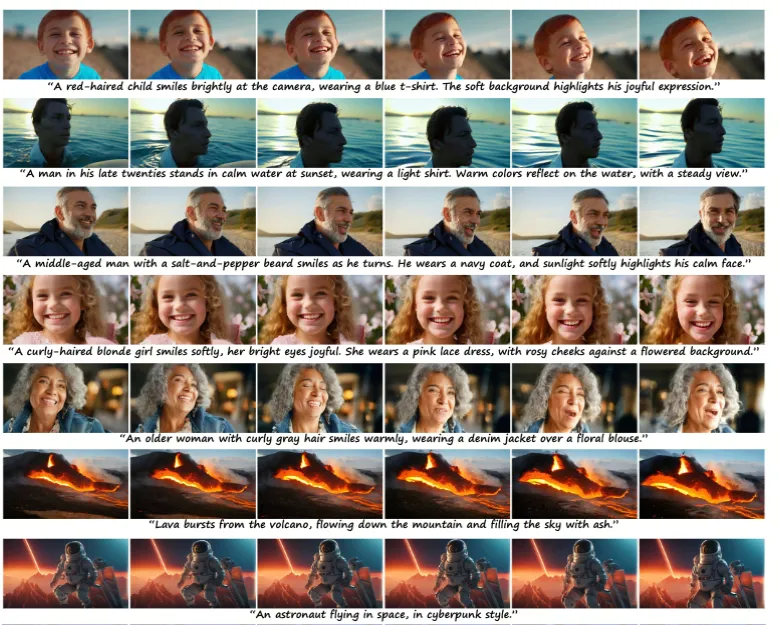

Emu3 能够根据文本输入生成高质量的图像,通过简单地预测下一个视觉标记来实现。该模型自然支持灵活的分辨率和风格。

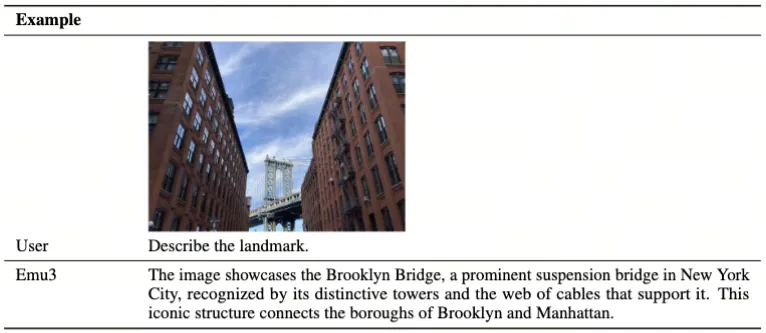

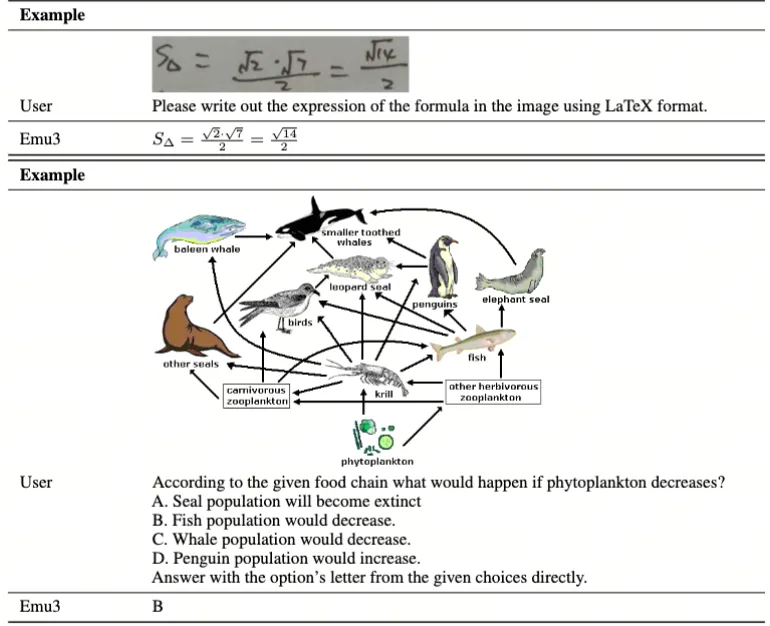

Emu3 展现出强大的视觉语言理解能力,能够感知物理世界并提供连贯的文本响应。值得注意的是,这种能力是在不依赖 CLIP 和预训练 LLM 的情况下实现的。

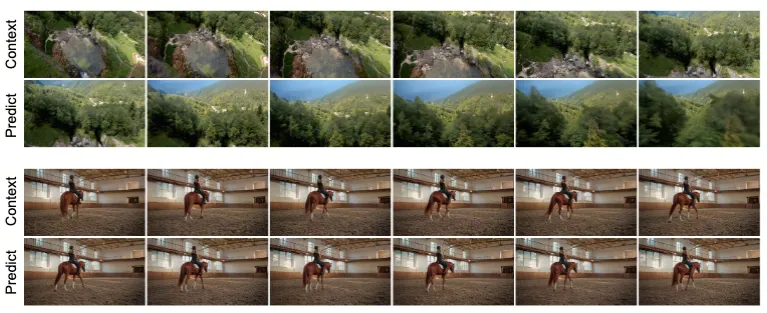

Emu3 通过预测视频序列中的下一个token来因果生成视频,与 Sora 的视频扩散模型不同。在上下文中有视频的情况下,Emu3 还能自然延伸视频并预测接下来会发生什么。

方法

Emu3 采用混合语言、图像和视频数据从零开始进行训练。语言数据来自 Aquila 的高质量中英文语料库。图像数据经过精心筛选,确保分辨率和美学质量,使用 LAION-AI 的美学预测工具过滤,并结合来自 DenseFusion 的补充数据。视频数据涵盖多种类别,经过分段、文本检测和运动评估,以确保视频质量。最后利用 GPT-4V 为图像和视频生成文本标注。

模型采用 SBER-MoVQGAN 训练视觉编码器,实现高效的视频和图像编码。预训练和后训练过程中,Emu3 集成文本和视觉信息,通过下一标记预测任务优化生成质量,并运用直接偏好优化(DPO)提升模型与人类偏好的对齐。最终,模型通过图像-文本训练和指令调优增强视觉语言理解能力。

能力

视频生成

未来帧预测

多模态对话

本文转载自公众号思源数据科学 作者:思源Source

原文链接:https://mp.weixin.qq.com/s/J6MTvki9YjXU5aqcrfi8JA