出手就是SOTA!扩散模型杀入部分监督多任务预测领域!

文章链接:https://arxiv.org/pdf/2403.13304

当前的感知模型严重依赖资源密集型数据集,促使我们需要创新性的解决方案。利用最新的扩散模型和合成数据,通过从各种标注构建图像输入,对下游任务非常有益。尽管先前的方法分别解决了生成和感知模型的问题,但DetDiffusion首次将两者结合起来,解决了为感知模型生成有效数据的挑战。

为了增强感知模型与图像生成的质量,本文引入了感知损失(P.A.损失),通过分割改进了质量和可控性。为了提高特定感知模型的性能,DetDiffusion通过提取和利用在生成过程中perception-aware属性(P.A.属性)来定制数据增强。目标检测任务的实验结果突显了DetDiffusion的优越性能,在布局引导生成方面建立了新的SOTA。此外,来自DetDiffusion的图像合成可以有效地增强训练数据,显著提高了下游检测性能。

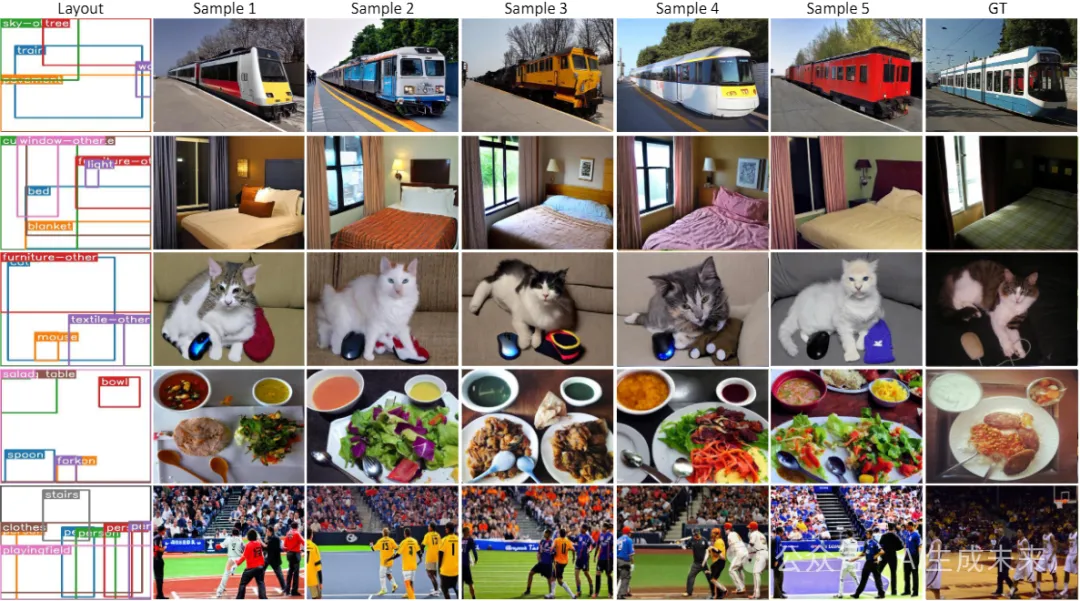

效果先睹为快

介绍

当前感知模型的有效性严重依赖于广泛且准确标注的数据集。然而,获取这样的数据集通常需要大量资源。最近生成模型的进展,特别是扩散模型,使得生成高质量图像成为可能,从而为构建合成数据集铺平了道路。通过提供诸如类别标签、分割图和目标边界框等标注,已经证明了用于生成模型的合成数据对提高下游任务(例如分类、目标检测和分割)的性能是有用的。

尽管大多数方法专注于分别改进生成模型或感知模型,但生成模型和感知模型之间的协同作用需要更紧密的整合,以相互增强生成和感知能力。在感知模型中,挑战在于有效的数据生成或增强,这是一个以前主要从数据角度(例如OoD泛化和域自适应)探讨的话题。其在一般情况下提高感知模型性能的潜力尚未充分探索。相反,生成模型研究一直致力于改进模型以获得更好的输出质量和可控性。然而,必须认识到感知模型也可以提供有价值的额外见解,以帮助生成模型实现更好的控制能力。生成模型和感知模型之间的这种协同作用为进步提供了一个有前景的途径,这表明需要更多的整合方法。

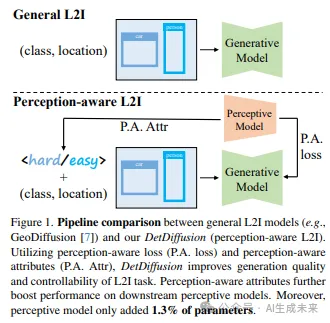

作为首个探索这种协同作用的工作,本文提出了一种新颖的感知生成框架,即DetDiffusion,如下图1所示。

DetDiffusion使生成模型能够利用来自感知模型的信息,从而增强其进行受控生成的能力。同时,它根据感知模型的能力有针对性地生成数据,从而提高了模型在合成数据上训练的性能。

具体而言,对于目标检测任务,基于Stable Diffusion对模型进行微调,利用受控生成技术生成高质量数据,有助于训练检测模型。为提高生成质量,创新性地引入了感知损失。通过引入基于UNet的分割模块,利用中间特征与标签真值一起监督生成的内容,以增强可控性。

此外,为进一步提高检测模型的性能,提出从经过训练的检测模型中提取和使用目标属性,然后将这些属性纳入生成模型的训练中。这种方法能够生成专门定制的新数据,以产生独特样本,从而显著提高检测器的性能。

经过实验证实,DetDiffusion在生成质量方面取得了新的SOTA,在COCO-Stuff数据集上达到了31.2的mAP。它显著增强了检测器的训练,通过在训练中策略性地使用Perception-Aware属性(P.A. Attr),将mAP提高了0.9 mAP。这在很大程度上是因为DetDiffusion在解决长尾数据生成挑战方面的精细控制。这些进展突显了DetDiffusion在技术上的优越性,并标志着在受控图像生成方面的重大进步,特别是在精确检测属性至关重要的情况下。

本文的主要贡献包括三个方面:

- 提出了DetDiffusion,这是第一个旨在探索感知模型和生成模型之间协同作用的框架。

- 为提高生成质量,提出了一种基于分割和目标mask的感知损失。为了进一步提高合成数据在感知模型中的有效性,并在生成过程中引入了目标属性。

- 对目标检测任务的广泛实验表明,DetDiffusion不仅在COCO数据集上的布局引导生成方面取得了新的SOTA,还有效地提升了下游检测器的性能。

相关工作

扩散模型。扩散模型作为一种生成模型,经过从图像分布到高斯噪声分布的前向变换后,被训练学习反向去噪过程。这些模型可以采用马尔可夫过程或非马尔可夫过程。由于它们在处理各种形式的控制和多种条件方面的适应性和能力,扩散模型已经应用于各种条件生成任务,例如图像变异、文本到图像生成、像素级别的受控生成等。这些模型的一个显著变种是潜在扩散模型(LDM)。与传统的扩散模型不同,LDM在潜在空间中进行扩散过程,提高了模型的效率。我们的感知数据生成框架基于LDM。然而,关注于生成模型和感知模型之间的协同作用,提出了一些设计来同时改善生成质量和可控性,以及在下游任务中的性能。

布局到图像(L2I)生成。本文的方法着重于将高层次的图形布局转换成逼真的图像。在这个背景下,LAMA实现了一个局部感知mask适应模块,以改进图像生成过程中的目标mask处理。Taming显示,一个相对简单的模型可以通过在潜在空间中训练超越更复杂的前辈模型。更近期的发展包括GLIGEN,它将额外的门控自注意力层整合到现有的扩散模型中,以增强布局控制;LayoutDiffuse则采用了为边界框量身定制的创新布局注意力模块。生成模型与GeoDiffusion和Geom-Erasing具有类似的架构,而DetDiffusion侧重于生成和感知之间的协同作用,并独特地提供了以下两点:

- 利用分割头信息的新型Perception-Aware损失(P.A. loss);

- 一种新颖的目标属性机制(P.A. Attr),有助于目标检测器的训练。

感知模型的数据生成。在一些L2I方法中,合成数据对提升目标检测任务性能的效用得到了证明,例如GeoDiffusion。类似地,MagicDrive提出生成的图像有助于3D感知,而TrackDiffusion为多目标跟踪生成数据。然而,它们没有探索使用感知模型增强生成,或为特定检测器量身定制数据。除了可控生成之外,一些工作通过从生成特征中提取标注将生成器转换为感知模型。DatasetDM使用了类似Mask2Former风格的P-decoder与Stable Diffusion,而Li等人开发了一个用于开放词汇分割的融合模块。尽管这些技术能够产生带有标注的数据,但它们受限于对基于文本的生成的依赖、对预训练扩散模型的限制以及与专门模型(如SAM)相比的性能较低。

方法

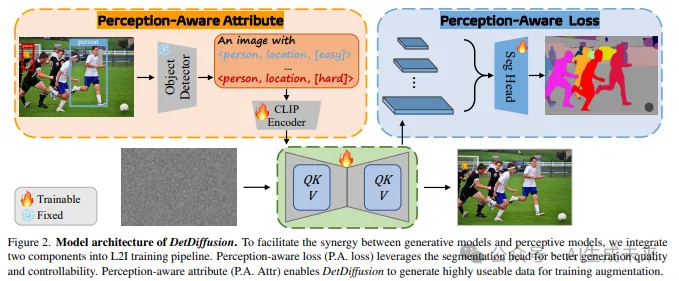

本文的目标是从感知的角度提高生成质量,并促进下游的感知任务。在解决这一具有挑战性的问题中,设计适当而强有力的监督非常重要,提议将易于访问但以前被忽视的感知信息,即Perception-Aware属性(P.A. Attr)和损失(P.A. loss),集成到生成框架中,以促进感知模型和生成模型之间的信息交互。首先介绍了预备知识,并详细展开了Perception-Aware属性(P.A. Attr),该属性通过目标检测器生成,并设计为特殊的标注以辅助扩散模型。再介绍了一个量身定制的Perception-Aware损失(P.A. loss)。整体架构如下图2所示。

预备知识

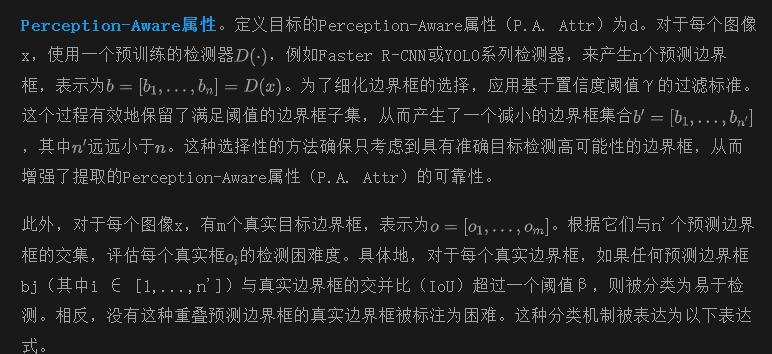

扩散模型(DMs)已经成为突出的文本到图像生成模型,以其在生成逼真图像方面的有效性而闻名。一个显着的变体,潜在扩散模型(LDM),将标准DMs的扩散过程创新地转移到潜在空间中。这种转变是重要的,因为LDMs表现出了保持原始模型质量和灵活性的能力,但计算资源需求大大降低。这种效率的提升主要归功于潜在空间维度的降低,这有助于更快的训练时间,而不影响模型的生成能力。

这个方程代表了原始噪声ε和模型预测的噪声之间的均方误差,概括了Stable Diffusion模型的核心学习机制。

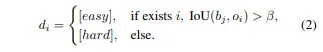

作为条件输入的Perception-Aware属性

为了增强检测模型的性能,本研究引入了一种围绕生成Perception-Aware逼真图像的新方法。该方法涉及一个两步过程:首先,从预训练的检测器中提取目标属性。这些属性封装了对准确目标检测至关重要的关键视觉特征。随后,将提取的属性集成到生成模型的训练方案中。这种集成旨在确保生成的图像不仅表现出很高的逼真度,而且与对于有效检测至关重要的感知标准密切对齐。通过这样做,生成模型被定制为生成更有助于训练稳健检测器的图像,可能会显著提高检测准确性和可靠性。

此外,与现有方法[26, 52]使用标题作为文本提示相比,我们设计了一个有效的文本提示,配备了多对Perception-Aware属性。具体而言,提示是“一张带有{目标}的图像”,其中目标是,m是真实边界框的数量。这个全面的属性集和有效的提示旨在概括对每个目标特征的更全面理解,可能为感知提供更丰富的描述。

Perception-Aware损失作为监督

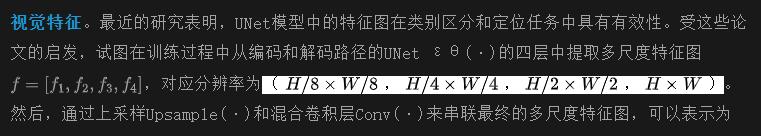

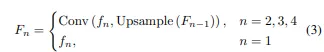

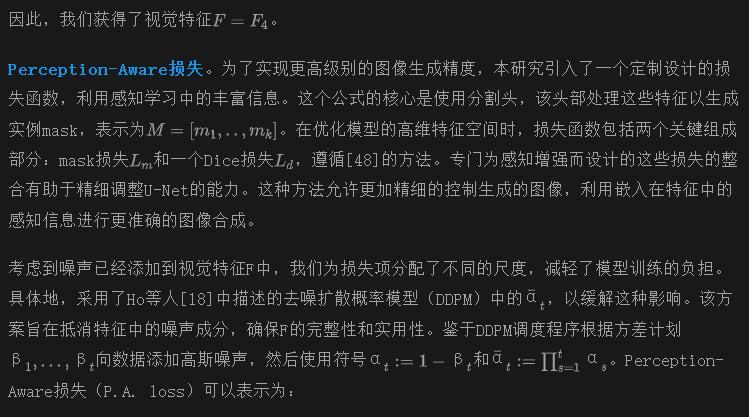

在训练扩散生成模型时,目标是最小化预测图像(或噪声)与其真值之间的重构距离。传统的生成方法主要利用L1或L2损失来实现这一目的。然而,这些标准损失函数通常不能产生具有高分辨率细节和对图像属性具有精确控制的图像。为了解决这一限制,提出了一种新颖的Perception-Aware损失(P.A. loss)。该损失函数的构建是为了利用丰富的视觉特征,从而促进更加细致的图像重构。

目标函数。最终,目标函数将Perception-Aware损失与Latent Diffusion Model(LDM)的基本损失函数相结合。这个整合在数学上表示为:

为了这个模型,λ 被设定为 0.01,确保了对Perception-Aware组件的平衡整合,同时保持了 LDM 损失函数的主要结构和目标。这种校准的方法允许对优化进行细微调整,充分利用了两种损失的优势,从而提高了模型生成高质量、与感知对齐的图像的性能。

实验

实验设置

数据集。采用了广泛认可的 COCO-Thing-Stuff 基准数据集用于 L2I 任务,该数据集包括 118,287 张训练图像和 5,000 张验证图像。每张图像都标注有 80 个目标类别和 91 个材料类别的边界框和像素级分割mask。与先前的研究 [7, 9, 52] 保持一致,忽略了属于人群或占据图像面积不到 2% 的目标。

实现细节。从 Stable Diffusion v1.5 的checkpoint微调 DetDiffusion。将位置tokens引入文本编码器,并使用二维正弦-余弦嵌入初始化位置tokens的嵌入矩阵。在固定 VQ-VAE 的情况下,微调文本编码器的所有参数,并使用余弦学习率调度的 AdamW 优化器,学习率为 。在前 3000 步采用线性预热。文本提示被替换为空文本,以 10% 的概率进行无条件生成。模型在 8×32GB GPU 上进行训练,批量大小为 32,大约需要 20 小时进行 60 个时期的训练。我们使用 DPM-Solver 调度程序进行 50 步采样,CFG 为 3.5。

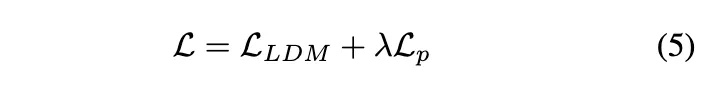

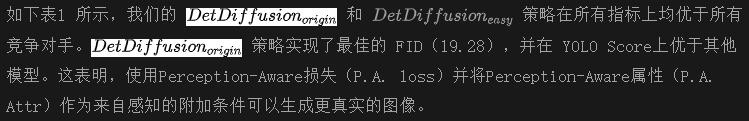

属性应用策略。在训练过程完成后,可以灵活地在生成过程中应用Perception-Aware属性(P.A. Attr)。为了简单而有效的验证目的,我们在下图3中采用了三种属性策略:

主要结果

L2I 生成要求生成的目标尽可能与原始图像一致,同时确保高质量的图像生成。因此,首先全面分析保真度实验。此外,生成目标检测数据的一个重要目的是其适用于下游目标检测。接下来展示了可训练性实验。

保真度

设置。为了评估保真度,在 COCO-Thing-Stuff 验证集上利用两个主要指标。Fréchet Inception 距离(FID)评估生成图像的整体视觉质量。它使用 ImageNet 预训练的 Inception-V3 网络来测量真实图像和生成图像之间特征分布的差异。在 LAMA 中的 YOLO Score使用生成图像上 80 个目标类别边界框的平均精度(mAP)。它使用预训练的 YOLOv4 模型来实现,展示了生成模型中目标检测的精度。我们的模型在图像尺寸为 256×256 上进行训练。与先前的工作一样,我们利用包含 3 到 8 个目标的图像,在验证期间共有 3,097 张图像。

结果。在 COCO-Thing-Stuff 验证集上使用了三种属性策略来评估我们的模型,并将它们与 L2I 任务的最新模型进行了比较,例如 LostGAN、LAMA、TwFA、Frido、LayoutDIffuse、LayoutDiffusion、Reco、GLIGEN、GeoDiffusion 和 ControlNet。

可训练性

设置。本节探讨了使用 DetDiffusion 生成的图像来训练目标检测器的潜在优势。可训练性的评估包括使用预先训练的 L2I 模型从原始标注创建新的合成训练集。然后,使用原始和合成训练集来训练检测器。

COCO 可训练性。为了建立可靠的基线,利用 COCO2017 数据集,选择性地选择包含 3 到 8 个目标的图像,以提高合成图像的质量并保持保真度。该过程产生了一个包含 47,429 张图像和 210,893 个目标的训练集。我们的目标是展示 DetDiffusion 可以为下游任务带来的改进,同时保持不同模型比较的固定标注。为了提高训练效率并专注于数据质量对训练的影响的评估,采用了修改后的 1× 计划,将训练周期缩短为 6 个epoch。DetDiffusion 在调整到 800×456 的图像上进行训练,这是其支持的最大分辨率,以解决与 COCO 的分辨率差异。

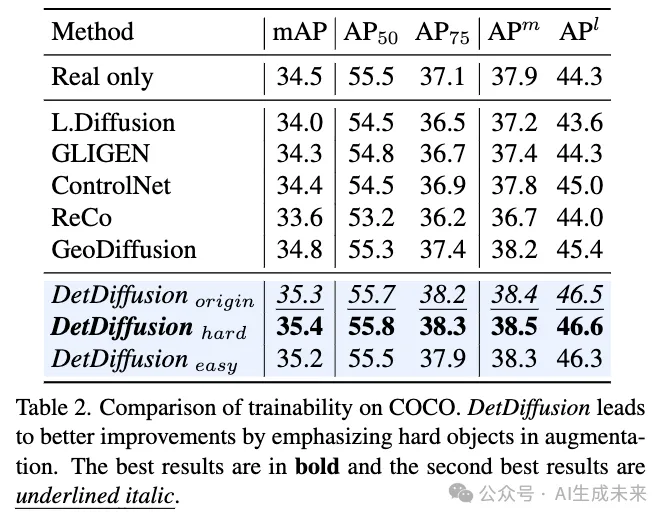

结果。如下表2 所示,ReCO、GeoDiffusion和我们的三种策略都有助于下游检测器的训练,通过这些策略生成的合成图像对检测器的提升更为显著(超过 35.0 mAP)。此外,与“origin”策略相比,“hard”策略在所有检测器指标上展现了最大的改进。这归因于“hard”策略通过生成更具挑战性的实例,这些实例通常代表真实数据集中的长尾数据,或者作为更强大的数据增强形式。总的来说,我们模型生成的数据显著增强了下游检测器的训练,超过了所有其他 L2I 模型,并表明通过感知获得的信息可以进一步有益于下游训练。

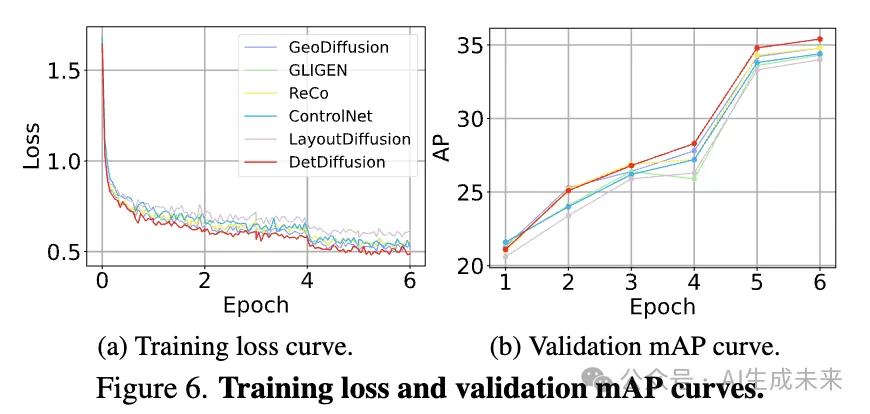

为了验证在相同的训练成本下的训练效果,绘制了训练损失曲线和验证 mAP 曲线,分别在 图6a 和 6b 中。我们的 DetDiffusion 在整个训练过程中表现最佳。

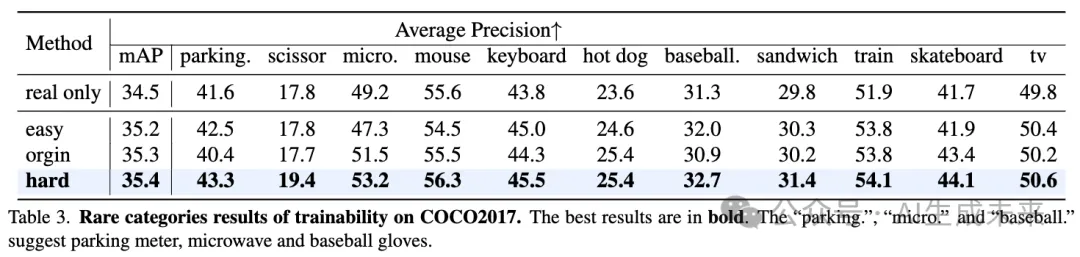

在下表 3 中展示了更多关于可训练性的结果,重点关注 COCO 数据集中较少出现的类别,如停车计时器、剪刀和微波炉,每个类别在数据集中的占比都不到 0.2%。可以看到,我们的 hard 策略在所有类别上都取得了收益,尤其是长尾类别方面取得了显著的改进。

定性结果

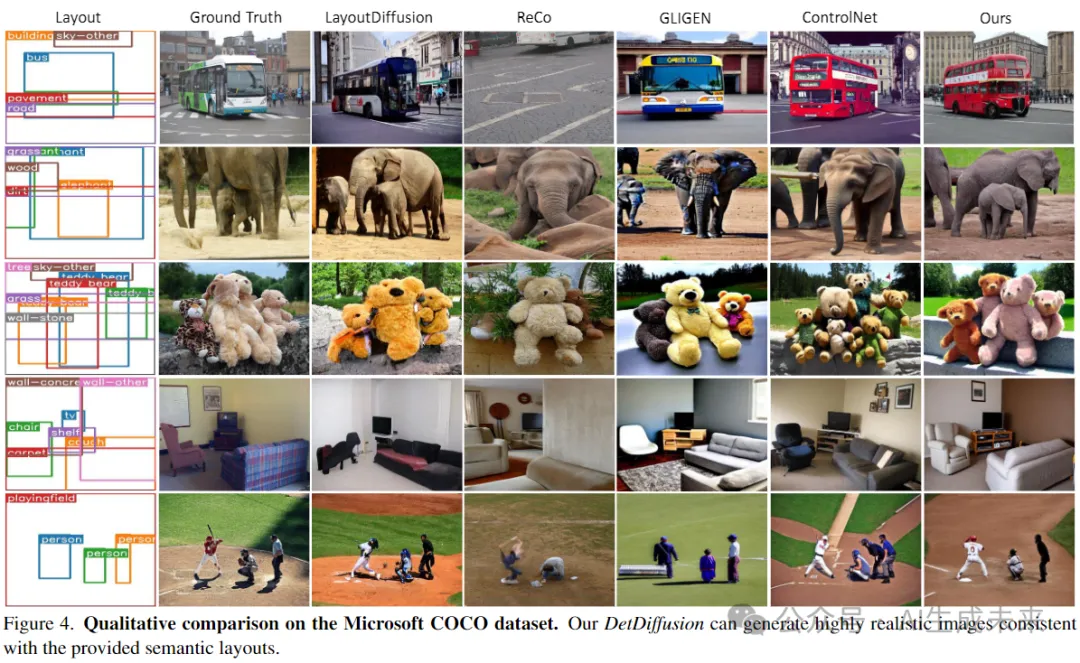

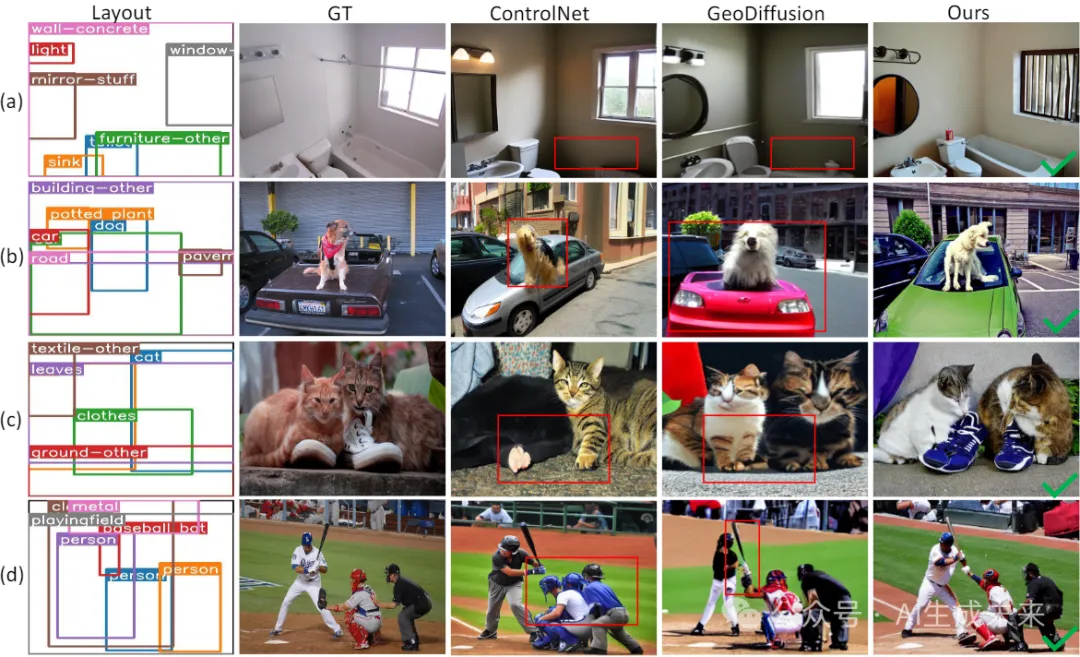

保真度。 下图4展示了验证我们模型在图像生成中的忠实度和准确性的示例。LayoutDiffusion的混乱结果源于其额外的控制模块与扩散过程的冲突。依赖高质量字幕的ReCo经常遭受质量降低和遗漏细节的困扰。GLlGEN和ControlNet,尽管输出质量很高,但缺乏精确的目标监督,导致细节不足和目标数量不稳定。我们对P.A.损失和P.A.属性的实现增强了目标质量,确保了一致的数量和受控的生成,如与P.A.属性对齐的生成目标数量所反映的那样。

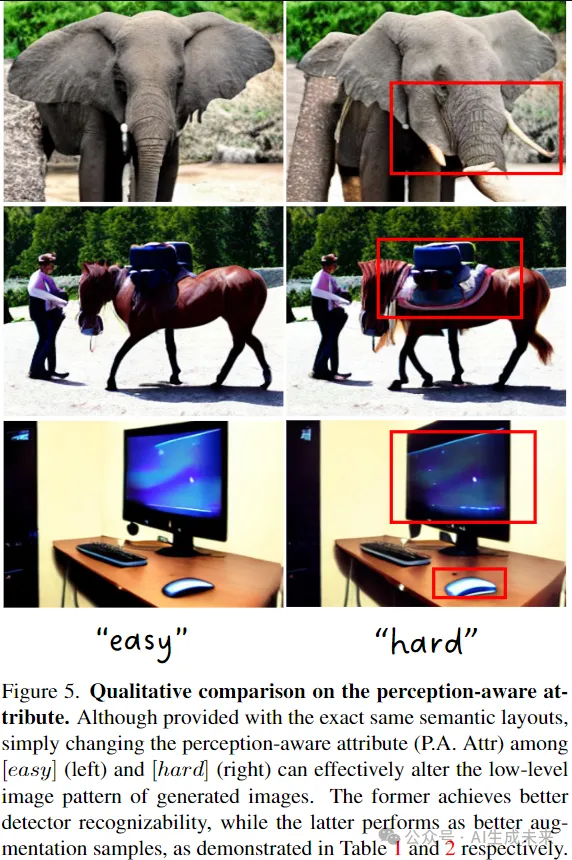

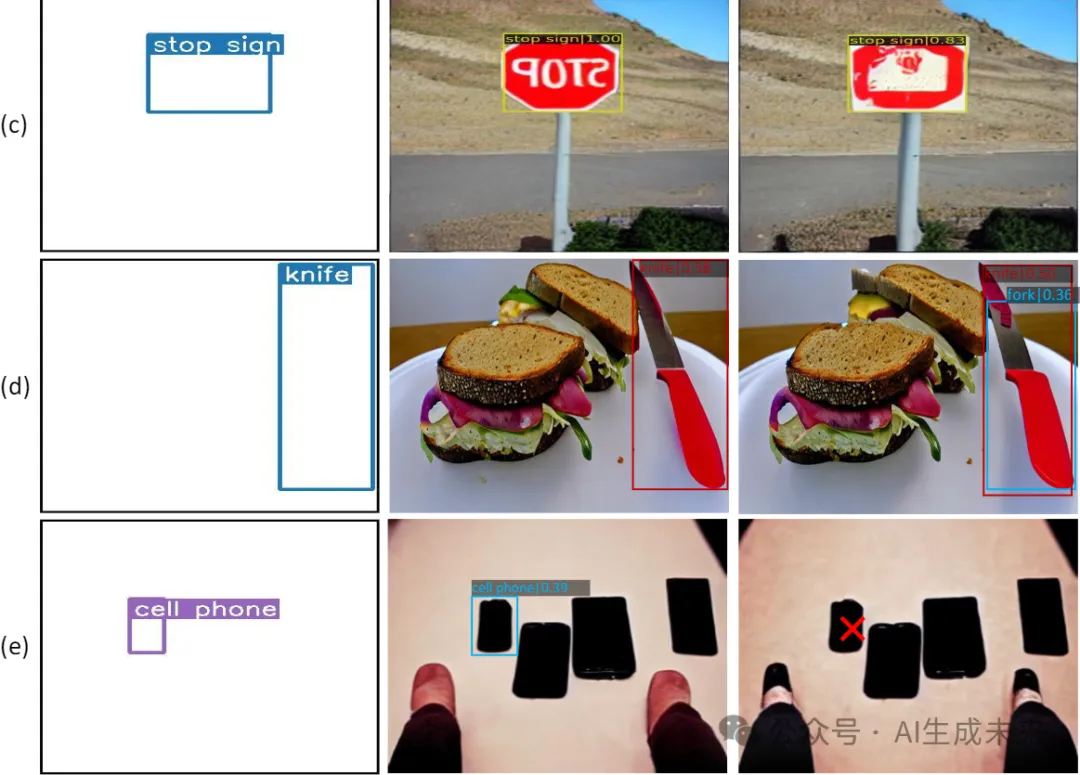

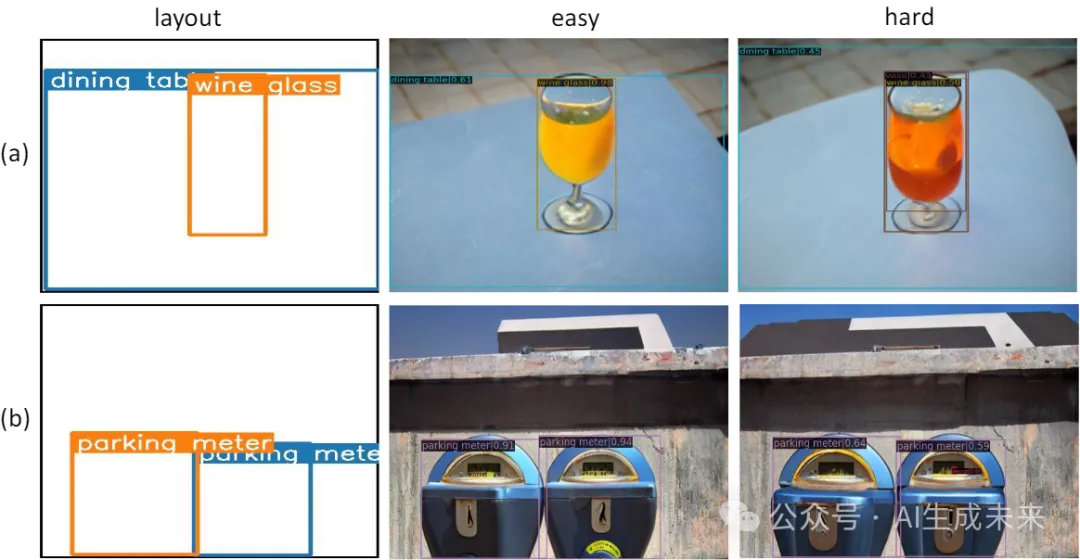

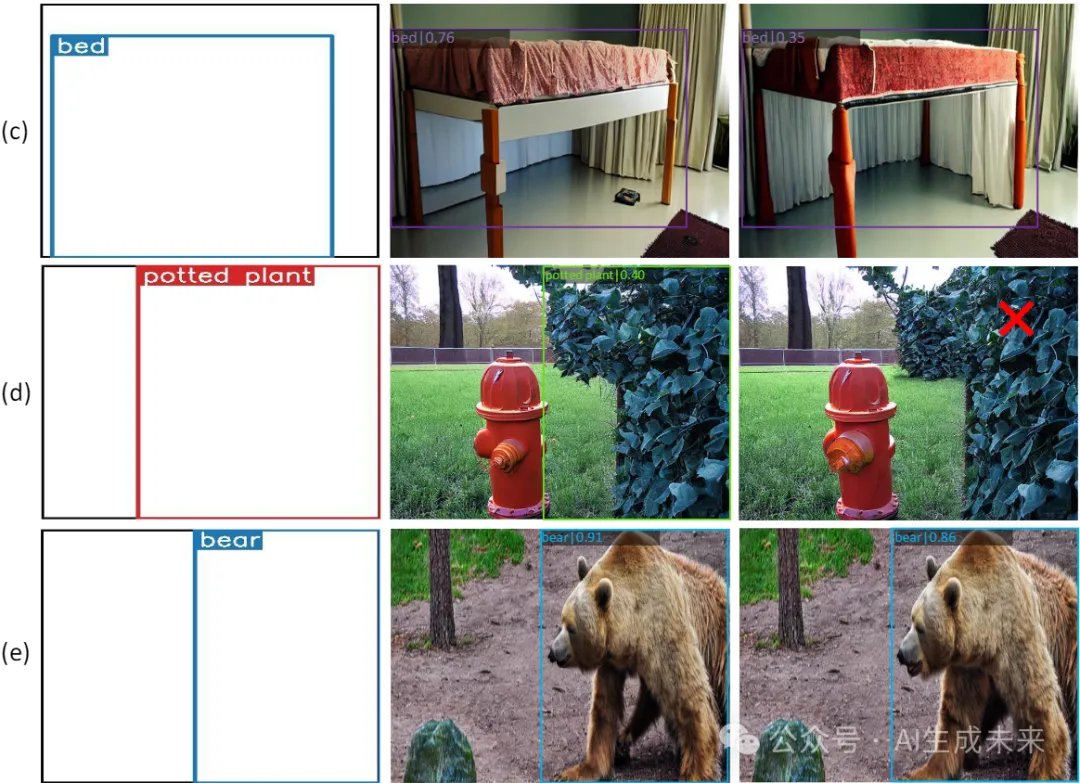

简单与困难。 在下图5中,展示了perception-aware attribute(P.A. Attr)的选择,比较了“简单”和“困难”的实例。通过大象、马、显示器和键盘等示例来说明“简单”图像,这些图像着重展示了内在的目标特征,确保了清晰度和缺乏噪音。相反,“困难”示例,如带长牙的大象、马鞍上的马、昏暗的显示器和反光的鼠标,引入了额外的元素,通过遮挡、光照和其他复杂性引入噪音。这些属性使得目标识别更具挑战性。值得注意的是,既有明显可区分的“简单”和“困难”情况,也有微妙不同的情况,突显了对检测过程的微妙影响。这表明了在没有先验知识的情况下识别具有挑战性的例子的重要性。有关更多示例,请参阅附录D。

消融研究

模型组件。 按顺序将两个模块集成到基线模型中,以评估我们模型的关键元素。为了清楚地展示P.A.损失的效果,所有属性都被设置为[易]。正如表4所示,添加P.A. Attr显著增强了图像的保真度和YOLO Score。这意味着包含感知信息有助于产生更真实、更易识别的图像。此外,实施P.A.损失,监督中间生成图像中的潜在特征,显著提高了模型在图像生成方面的精度,特别是在位置精度方面。

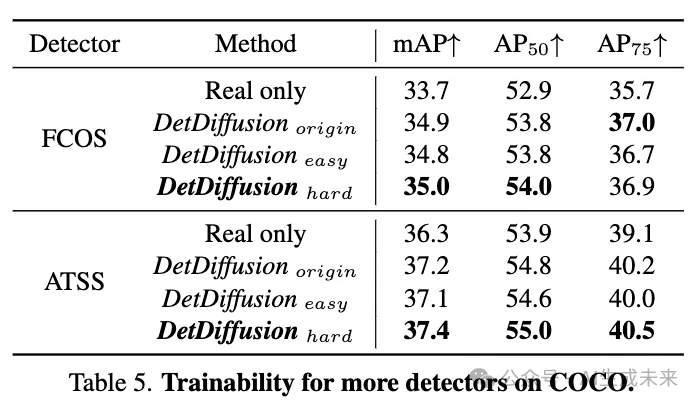

可训练性。 进一步对FCOS和ATSS进行实验。如表5所示,不管是哪种检测器模型,Det-Diffusion生成的图像都取得了显著的改善,这与表2中的结果一致。

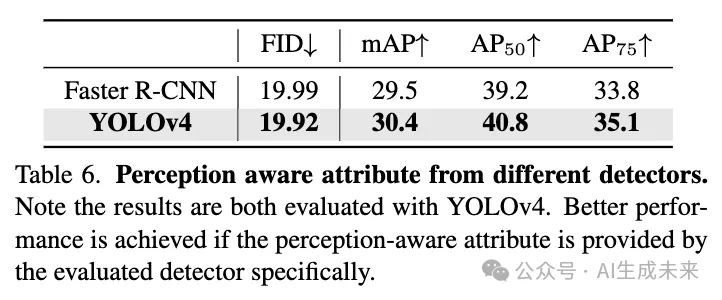

检测器。 探讨了两种广泛认可的检测器[1,39],用于在省略使用P.A.损失的情况下获取P.A. Attr。表6展示了检测器选择对P.A. Attr质量的显著影响,YOLOv4在这方面表现出色。因此,YOLOv4作为保真度的主要检测器,而Faster R-CNN则用于可训练性,因为它是训练后下游检测器的角色。

结论

本文提出了DetDiffusion,这是一种简单而有效的架构,利用了生成模型和感知模型之间的内在协同作用。通过将检测器感知性整合到几何感知模型中,通过P.A. Attr作为条件输入和P.A.损失作为监督,Det-Diffusion可以生成针对检测器定制的图像,以获得更好的识别性和可训练性。

本文转自 AI生成未来 ,作者:Yibo Wang等