LLM的"数数"能力有多弱?一个意想不到的"罪魁祸首"| 专家模型的潜在隐患:用户提示被窃取的背后

大模型领域的发展日新月异,每天都有许多有趣的论文值得深入品读。下面是本期觉得比较有意思的论文:

1、LLM的"数数"能力有多弱?一个意想不到的"罪魁祸首"

2、专家模型的潜在隐患:用户提示被窃取的背后

1、LLM的"数数"能力有多弱?一个意想不到的"罪魁祸首"

你相信大型语言模型(LLM)连简单的"数数"都可能做不好吗?近期一篇震惊学术界的论文揭示了这个令人惊讶的事实:即便是号称"无所不能"的AI模型,在面对基础计数任务时也可能栽跟头。

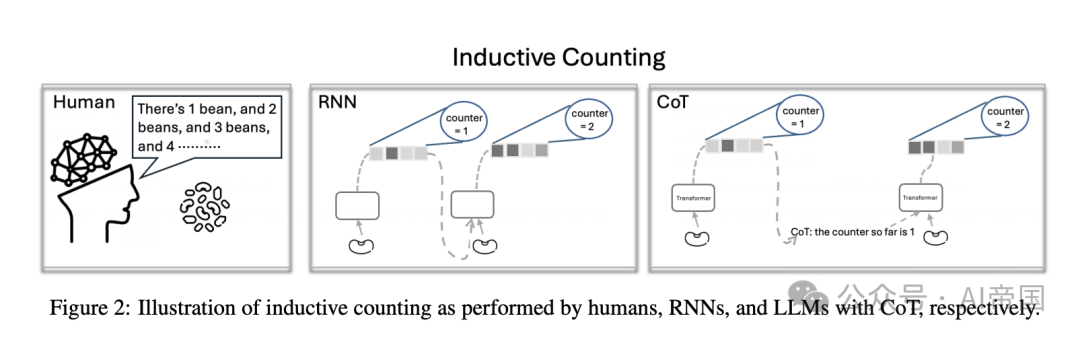

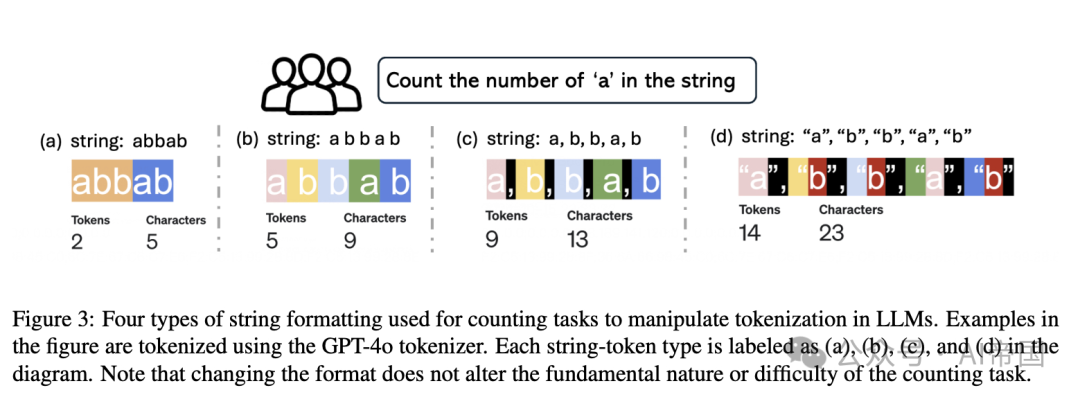

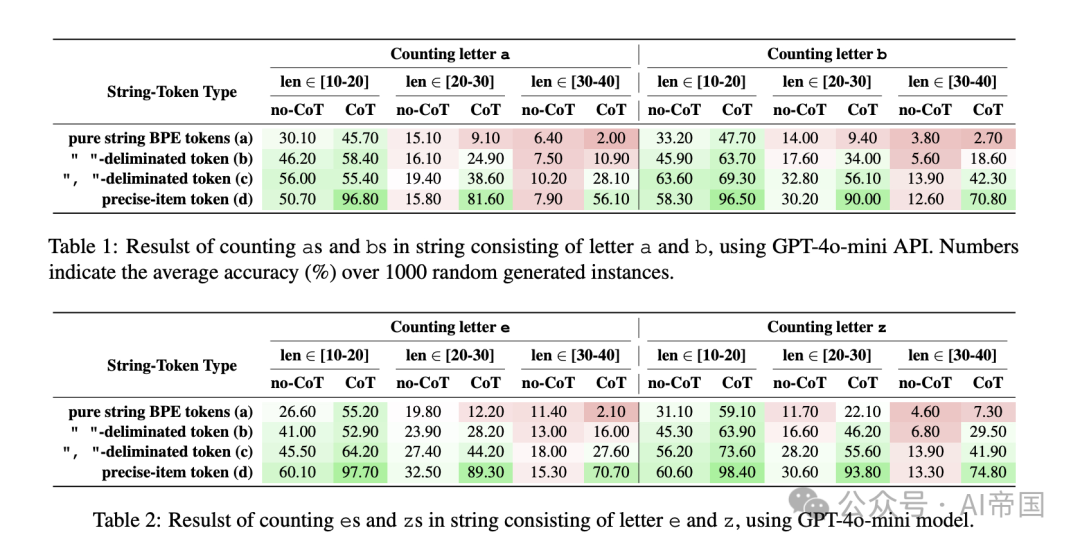

这项研究的关键发现在于:tokenization(分词)可能是影响AI模型计数能力的"幕后黑手"。就像一个翻译员不小心省略或错误理解了部分对话,不恰当的分词方式会导致AI模型丢失关键信息,使其在计数任务中准确率最高可降低80%!研究者们通过大量实验证实,不同的分词策略会极大地影响模型的推理能力。

有趣的是,这个看似技术性很强的发现,实际上揭示了AI模型"思考"的本质机制。传统的Transformer架构本身就存在计算深度的先天局限,而精心设计的分词方法可以在某种程度上"弥补"这一缺陷。这就像是为AI模型配备了一副更精确的"眼镜",帮助它更准确地"看清"和"理解"输入的信息。

对于普通读者和AI从业者来说,这项研究传递了一个重要信息:AI的智能远比我们想象的更加脆弱和依赖细节。在追求"智能"的道路上,每一个看似微不足道的技术细节,都可能成为决定性的关键。

论文标题:Counting Ability of Large Language Models and Impact of Tokenization

论文链接:https://arxiv.org/abs/2410.19730

2、专家模型的潜在隐患:用户提示被窃取的背后

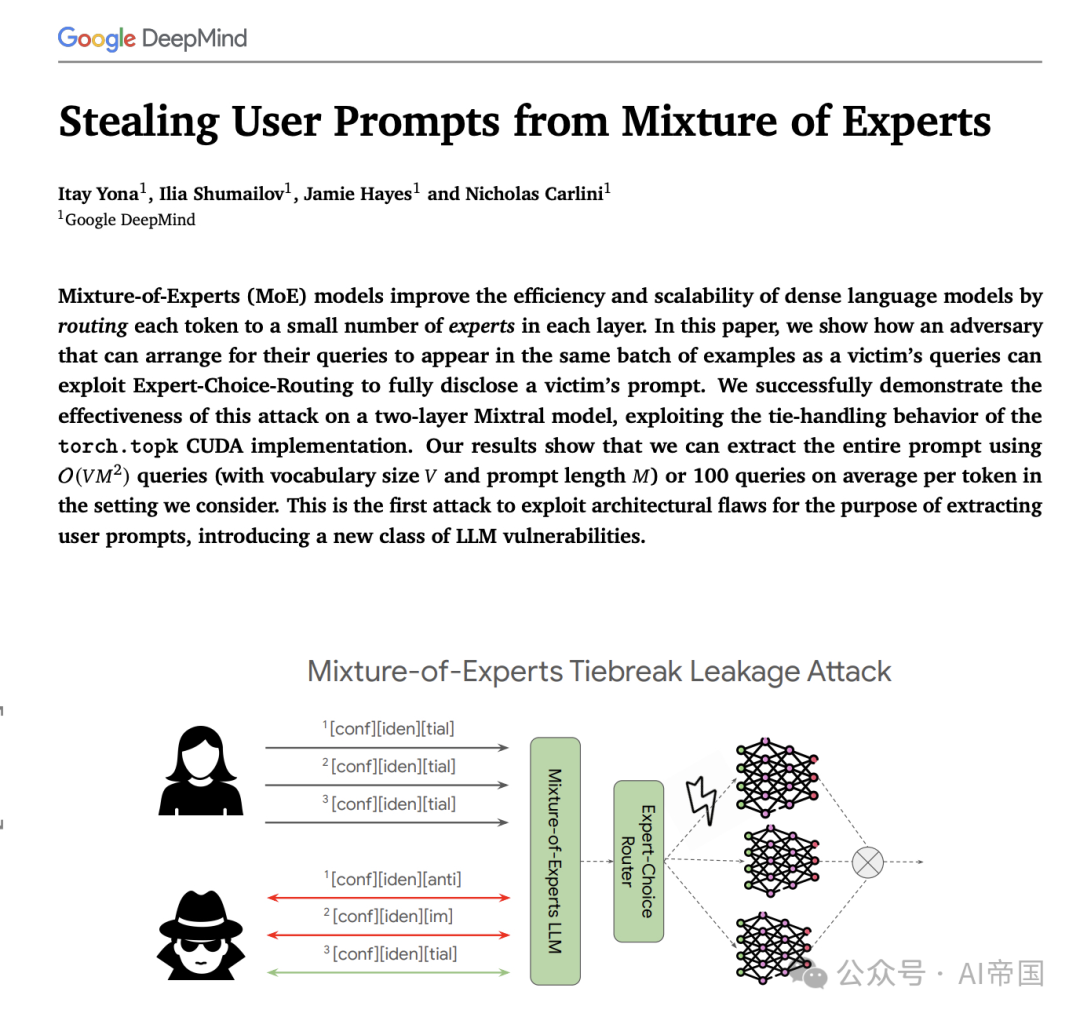

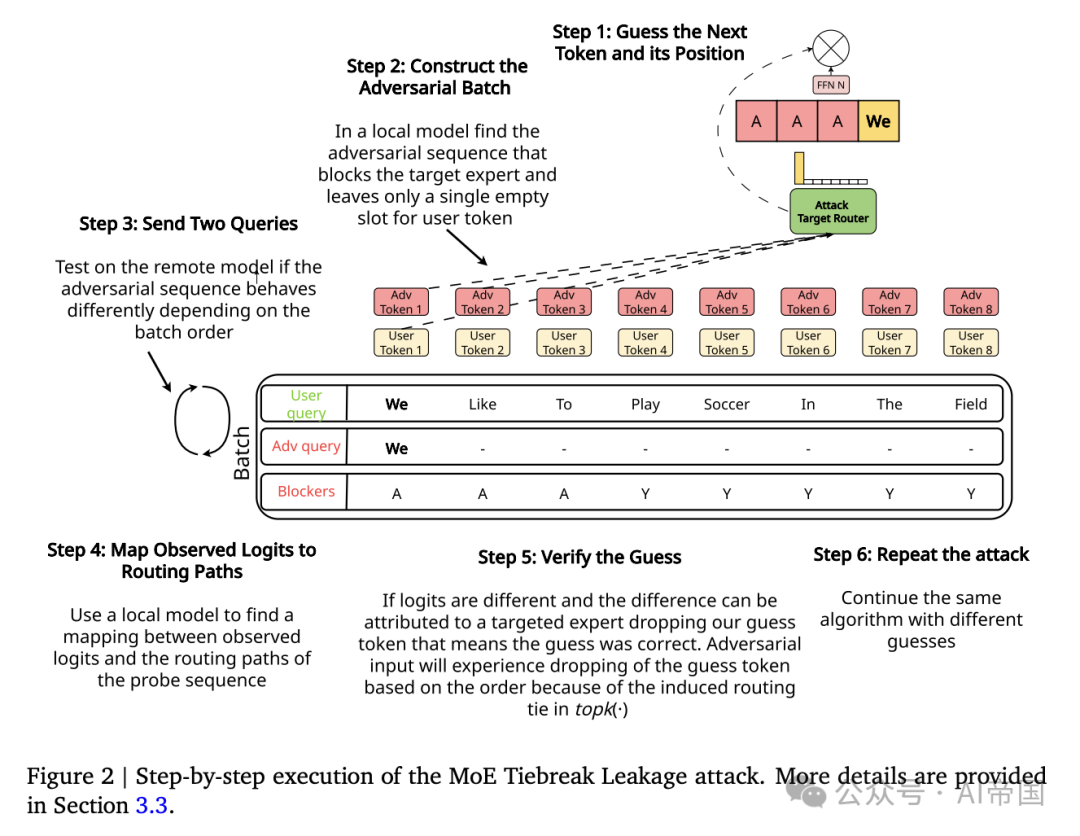

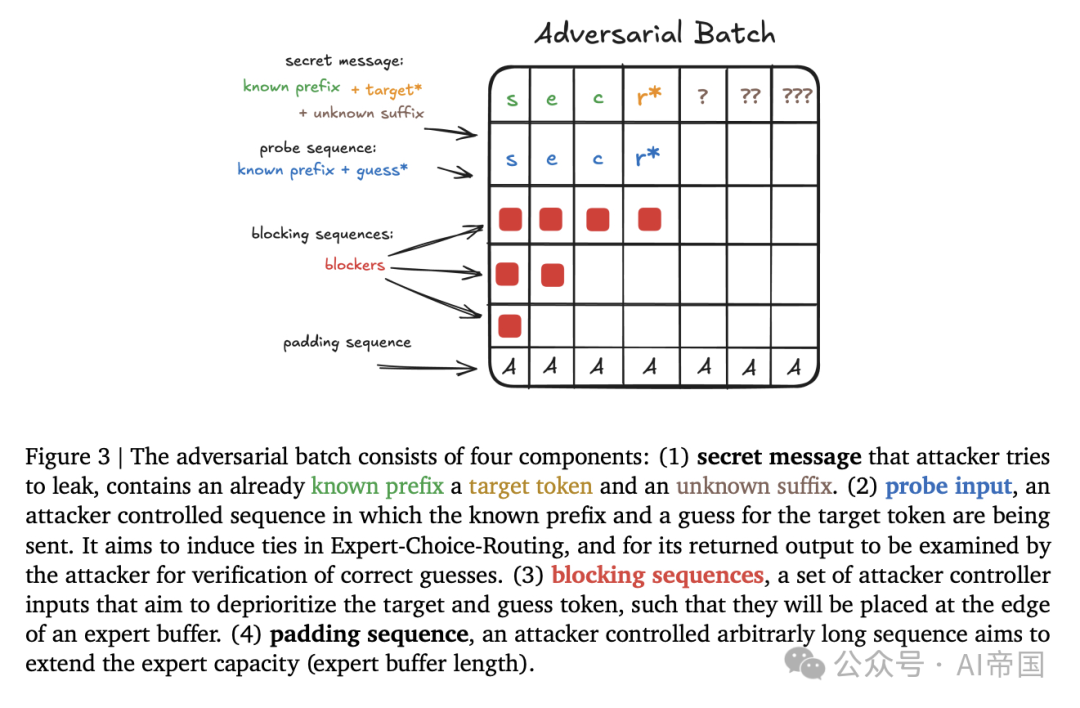

在当今的语言模型中,Mixture-of-Experts (MoE) 架构以其高效性和可扩展性而备受青睐。然而,最新的研究揭示了这种架构中的一个严重安全漏洞——用户输入提示的泄露。本文深入探讨了“MoE Tiebreak Leakage”攻击,揭示了恶意用户如何通过巧妙构造查询批次,利用专家选择路由的缺陷,从而完全窃取目标用户的私人输入。

研究人员成功地在一个两层的Mixtral模型中展示了这种攻击。他们发现,恶意用户只需提交少量精心设计的查询,就能够操控专家路由,使目标用户的提示泄露。具体而言,研究表明,攻击者只需发出平均100个查询,便可提取到整个用户提示,揭示了MoE模型在设计时未能考虑的安全隐患。

该论文不仅介绍了这一新型攻击,还强调了在语言模型设计和部署过程中进行系统安全分析的重要性。由于这种信息泄露现象微妙而难以察觉,研究者呼吁在未来的模型架构中融入安全考虑,以防止类似的攻击再次发生。

随着语言模型的不断发展,确保用户数据安全将是一个亟需解决的重要问题。深入了解MoE模型的安全漏洞,将有助于推动更加安全的AI技术进步。

论文标题:Stealing User Prompts from Mixture of Experts

论文链接:https://arxiv.org/abs/2410.22884

本文转载自 AI帝国,作者: 无影寺