无需昂贵标注!大幅提升SDXL和SD3-Medium效果!文生图偏好优化新宠来了

文章链接:https://arxiv.org/pdf/2410.18013

亮点直击

- 合成标注偏好数据集(Syn-Pic):从不同的T2I模型生成图像,并通过多个预训练的奖励模型对其进行标注,这些模型可以估计人类偏好。因此,数据收集过程中无需人工标注,使得数据收集成本更低且易于扩展。通过聚合多个奖励模型的评分,减轻了奖励过度优化的问题。与传统的成对比较不同,为每个提示生成的图像构建一个排名。虽然聚合多个人工标注者的偏好并构建排名是可行的,但这相比本文的低成本方法会显著增加标注成本。

- 基于排名的偏好优化(RankDPO):为利用排名中更丰富的信号,引入了一种排名增强的DPO目标函数RankDPO,借鉴了“学习排序”领域的广泛文献。它使用折扣累计增益(DCG)对偏好损失进行加权,使其与首选排名对齐。

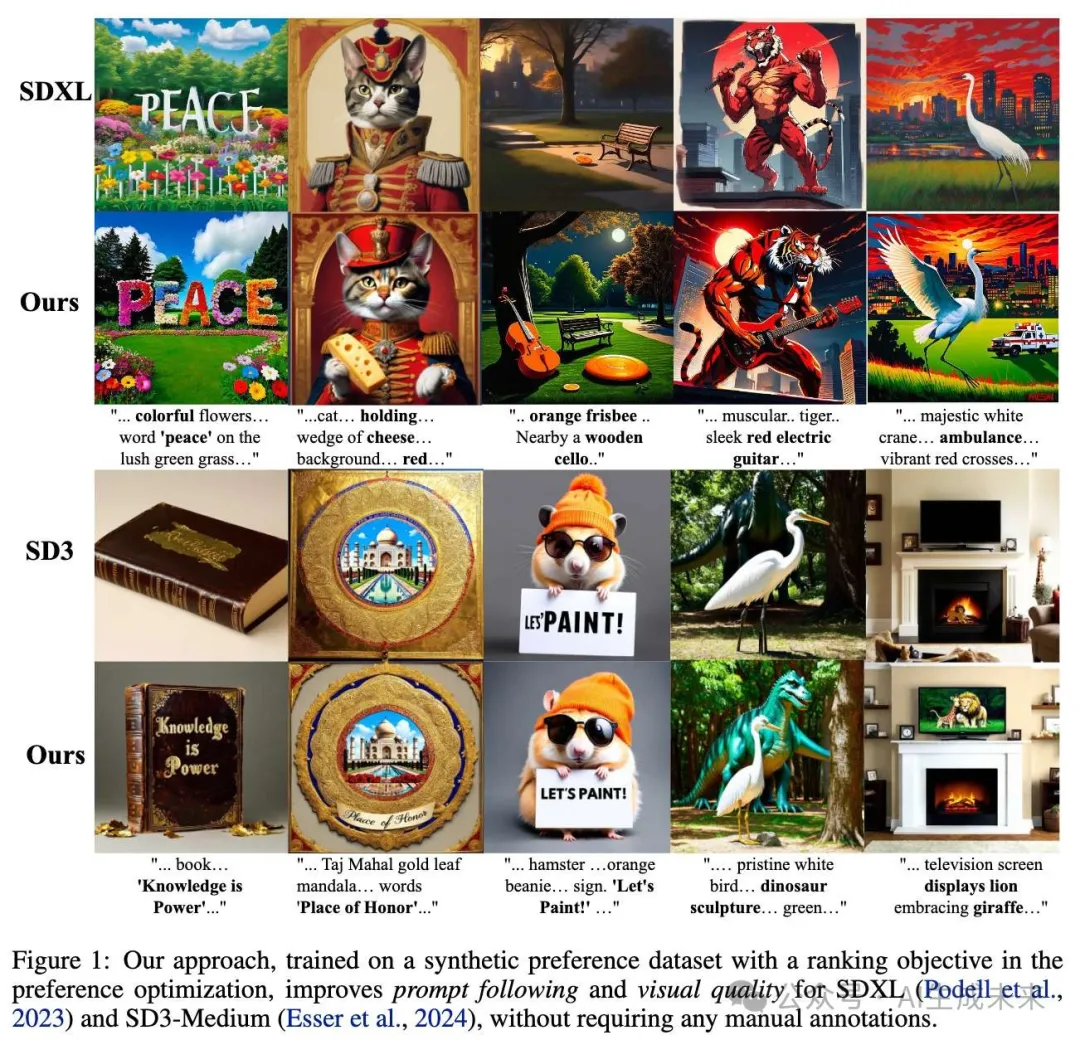

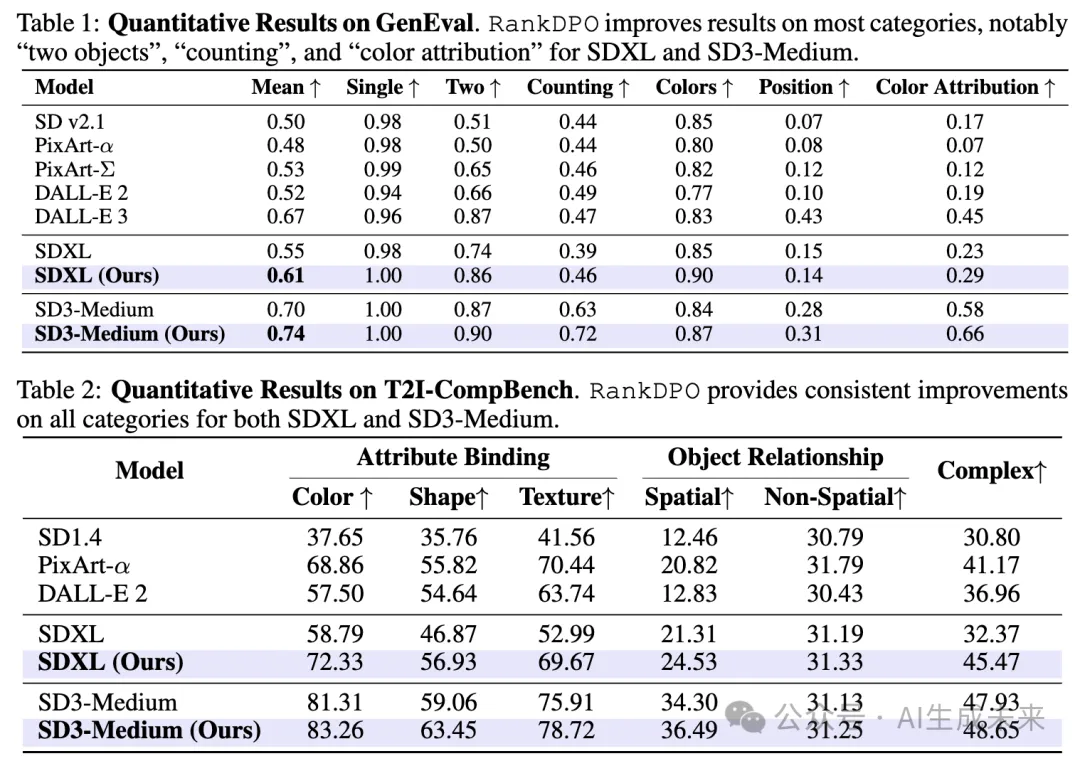

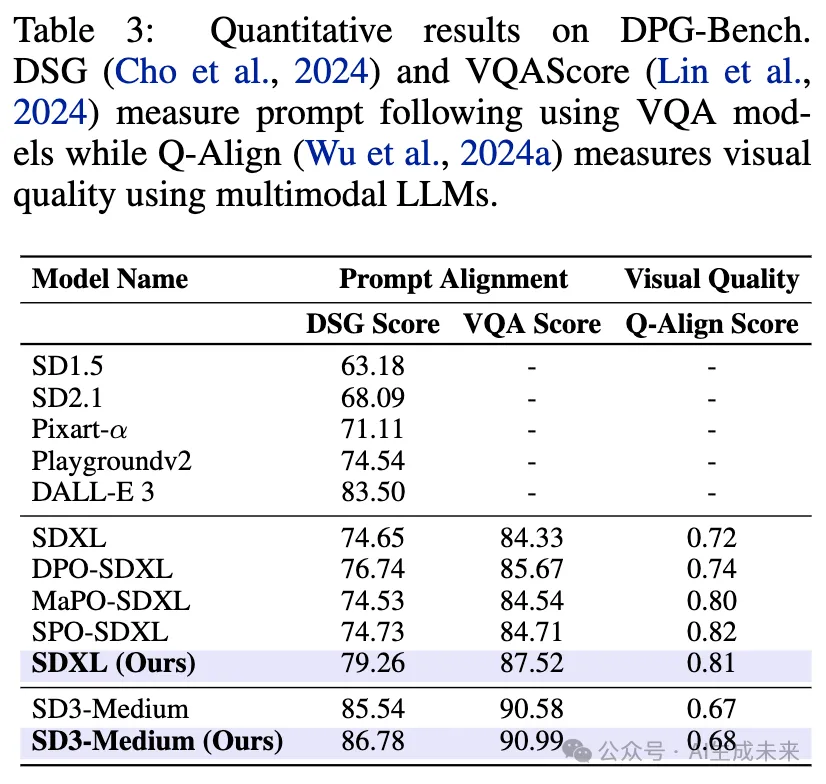

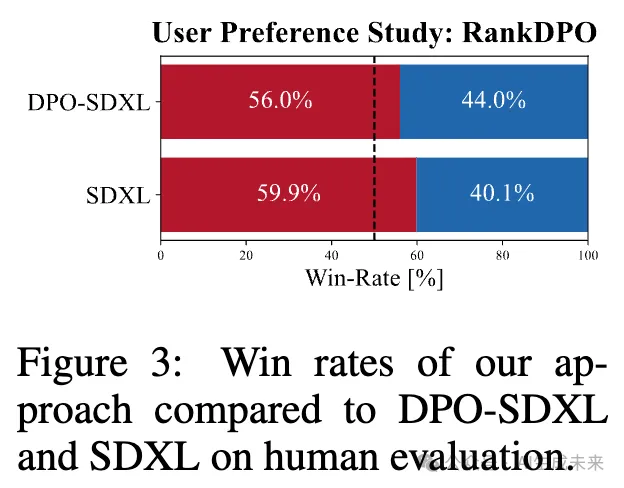

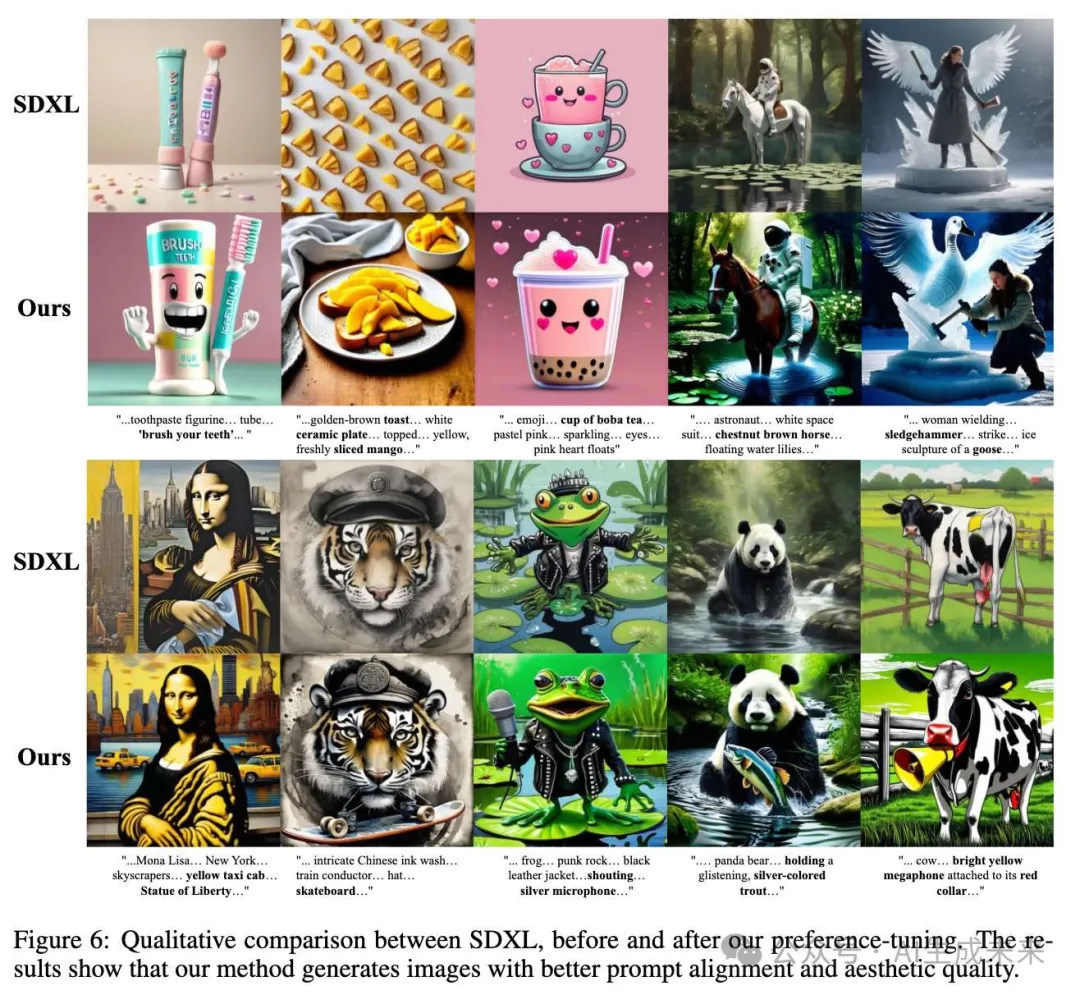

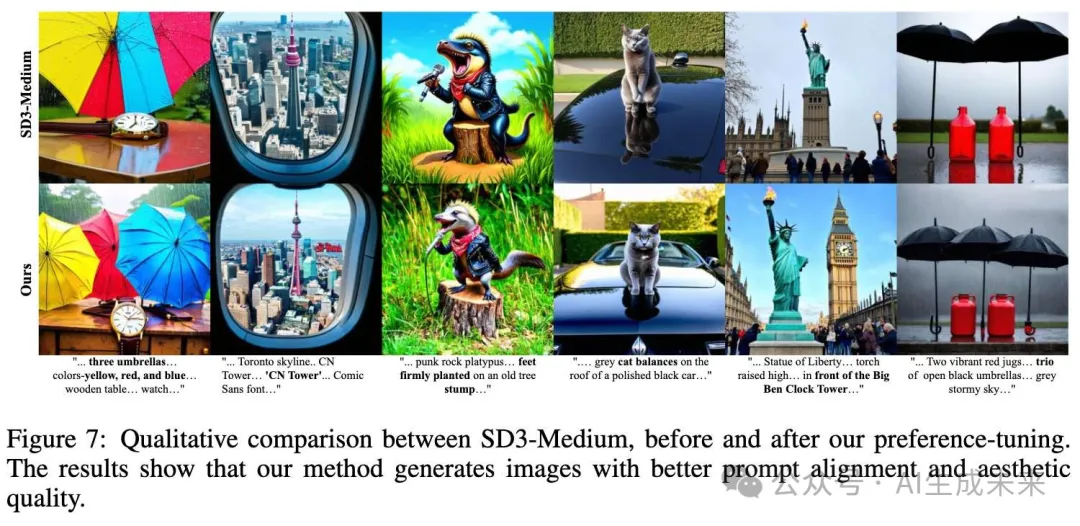

- 使用与Pick-a-Picv2相同的提示,SDXL和SD3-Medium模型的表现显著提升。展示了在多个基准数据集上的改进结果,包括GenEval(表1)、T2I-Compbench(表2)和DPG-Bench(表3),以及用户研究中的视觉对比(图1中的示例和图3)。

- 与现有的偏好优化方法相比,取得了最新的效果,例如表3。更重要的是,仅使用了Pick-a-Picv2所需图像数量的三分之一,即表8。

- 尽管SD3-Medium(20亿参数)已经通过3M个人偏好数据的DPO进行优化,但使用包含24万图像的Syn-Pic数据集仍能进一步实现显著提升,例如表1、2、3。

总结速览

解决的问题

传统的直接偏好优化(DPO)方法依赖大量人工标注的数据集来对文本生成图像(T2I)模型进行对齐,但这种方法成本高昂,且数据容易过时,难以适应T2I模型快速提升的需求。

提出的方案

本研究提出一种完全合成的数据集收集方法,用于DPO训练。通过预训练的奖励函数生成成对图像的偏好数据,替代人工标注,极大地提升数据集的收集效率。同时,引入RankDPO方法,通过排名反馈增强DPO训练,提升模型的偏好学习效果。

应用的技术

采用预训练的奖励函数生成成对图像的偏好数据,并在SDXL和SD3-Medium模型上应用RankDPO技术。数据集“Syn-Pic”用于支持该方法,避免人工参与标注并提供更高效的偏好数据生成方式。

达到的效果

通过使用“Syn-Pic”合成偏好数据集和RankDPO方法,显著提升了模型的文本跟随能力(如T2I-Compbench、GenEval和DPG-Bench基准测试)和视觉质量(通过用户研究验证),为开发更优质的偏好数据集、提升文本生成图像模型的性能和安全性提供了一个实用且可扩展的解决方案。

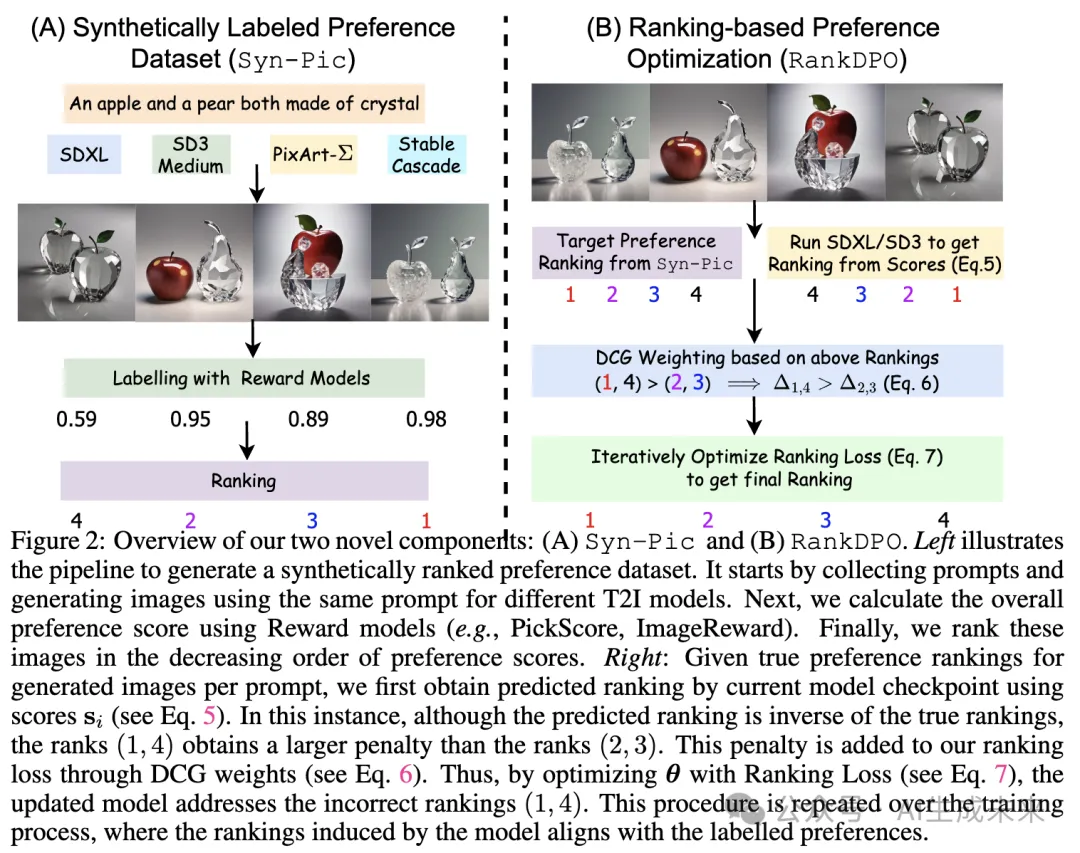

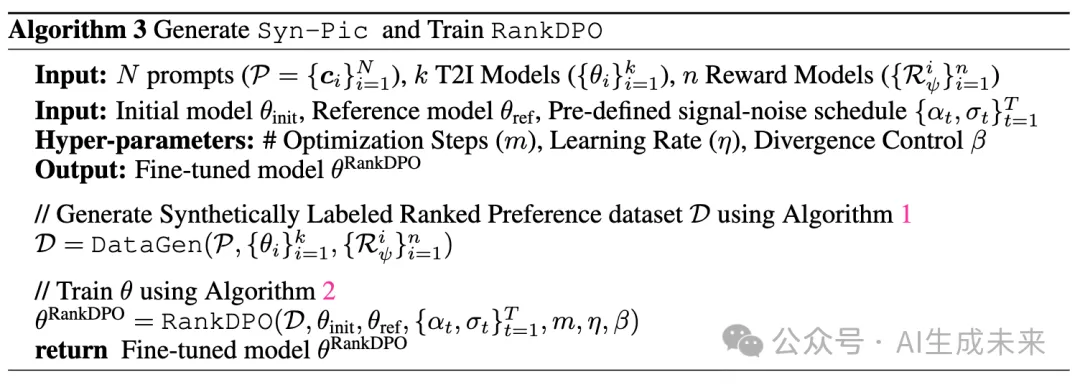

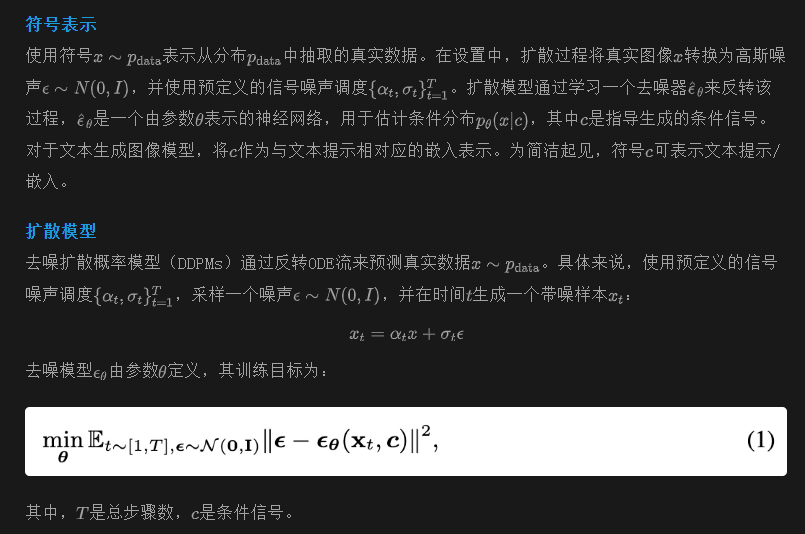

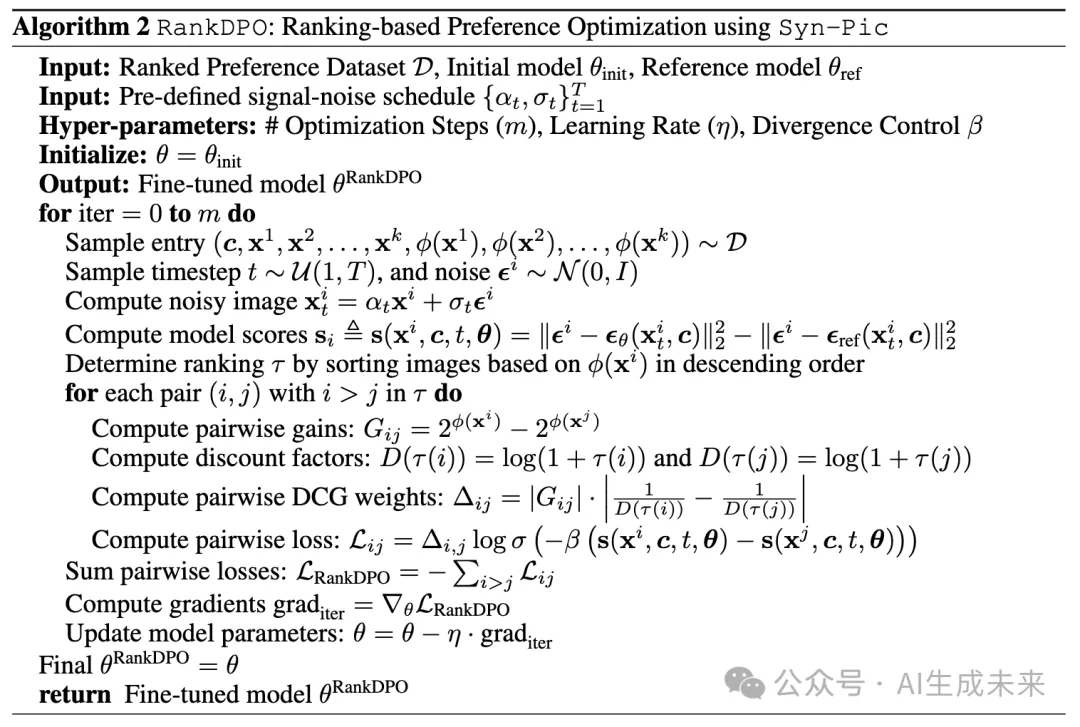

方法

本节首先概述用于文本生成图像的扩散模型及其直接偏好优化方法。接下来,讨论策划和标注可扩展的偏好优化数据集的过程。最后,描述一种基于排名的偏好优化方法RankDPO,以利用该排序偏好数据集。下图2中对这两个组成部分进行了说明。算法3提供了在Syn-Pic上训练RankDPO的伪代码。

用于扩散模型的DPO

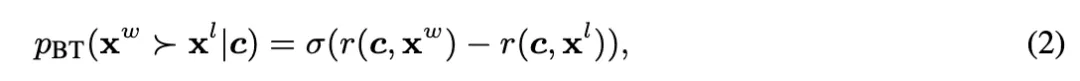

Bradley-Terry(BT)模型通过以下公式定义成对偏好:

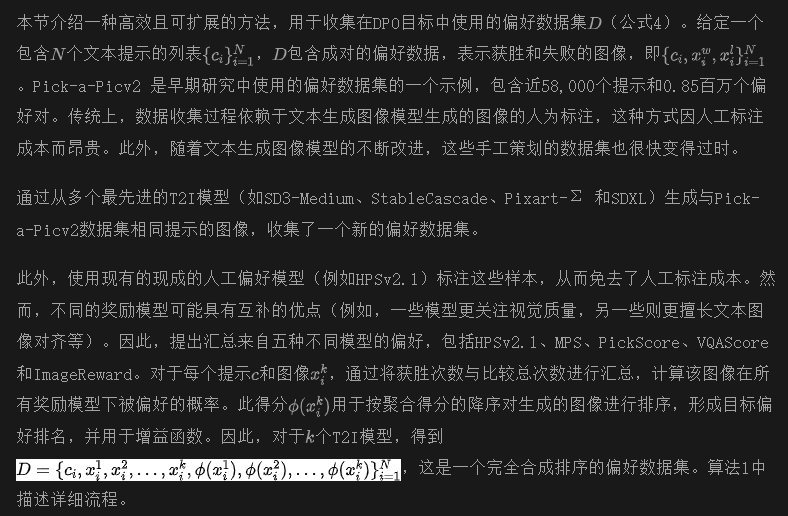

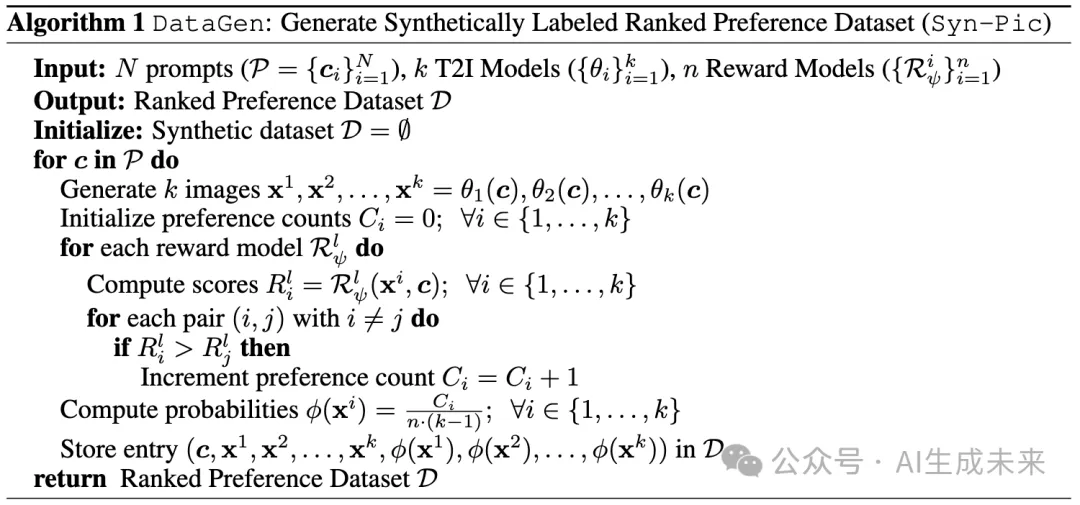

合成标注偏好数据集 (Syn-Pic)

讨论

本文的数据收集方法具有以下几个优点:

- 成本效率:可以生成任意规模的偏好数据集,因为标注环节中没有人为参与,图像生成和标注均使用现成的模型,从而降低数据集策划成本。例如,收集Pick-a-Picv2数据集大约需要50000,可以以约200的成本收集一个类似规模的数据集。

- 可扩展性:随着数据集收集成本的降低,可以针对新的文本生成图像模型进行迭代,从而消除了由于新模型出现而导致旧偏好数据集过时的问题。

- 基于排名的偏好优化:由于每个提示运行多个T2I模型,因此收集到的是一个排名的偏好列表,而不仅仅是早期数据集中成对的数据。这能够在偏好优化中探索排名目标。

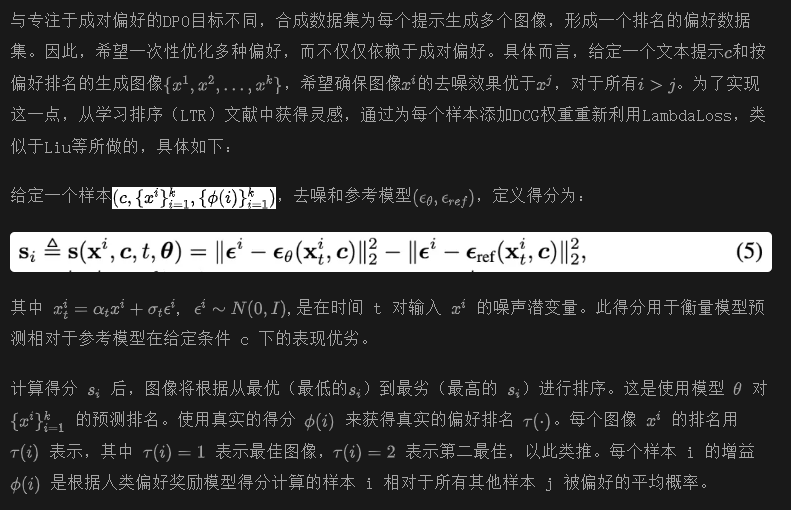

基于排名的偏好优化 (RankDPO)

该损失函数不仅鼓励模型满足成对的偏好,还要尊重为相同提示生成的图像的整体排名。通过使用从排名中获得的增益和折扣来加权传统的 DPO 目标,确保模型根据排名优先生成质量更高的图像,从而在美学和提示对齐方面实现更一致的改进。

实验

实施细节实验中使用开源的 SDXL和 SD3-Medium 模型。从 Pick-a-Picv2 收集了 58K 个提示,并使用四个模型,即 SDXL、SD3-Medium、Pixart-Σ 和 Stable Cascade,准备了 Syn-Pic 数据集。在 8 张 A100 GPU 上训练 RankDPO,持续 16 小时,批次大小为 1024,训练 400 步。

比较结果

短提示在前面表 1 中,报告了 GenEval上的结果。RankDPO 在几乎所有类别上都持续改善了性能,使得 SDXL 的平均性能从 0.55 提高到 0.61,SD3-Medium 的平均性能从 0.70 提高到 0.74。特别是观察到在“两个物体”、“计数”和“颜色归属”等方面有显著提升,增幅近 10%。在前面表 2 中的 T2I-Compbench中,也观察到了类似的趋势,其中 SDXL 在“颜色”和“纹理”上提升超过 10%,并在其他类别中也有改进。

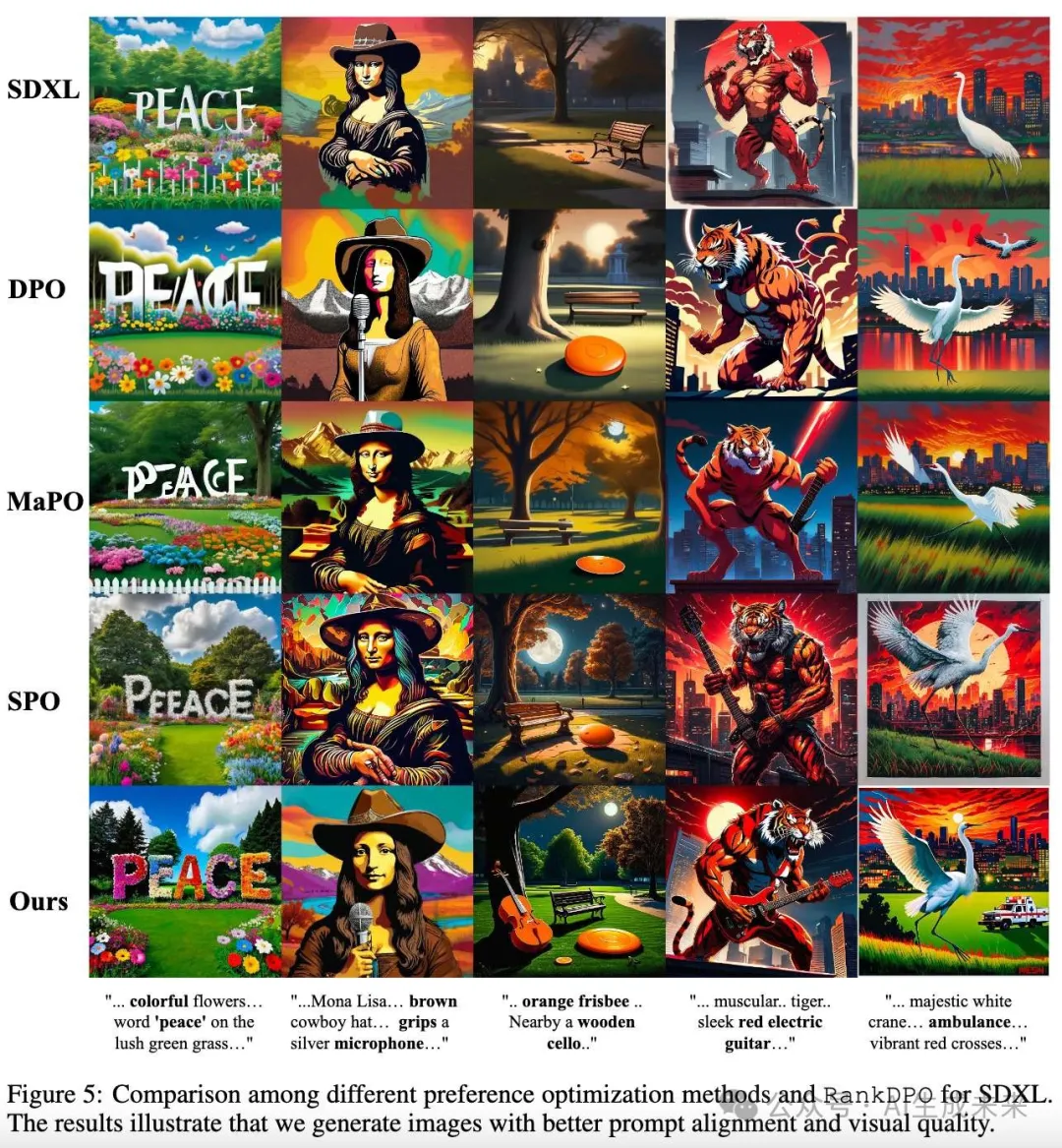

长提示在前面表 3 中,进一步在 DPG-Bench上评估了模型的视觉质量和提示对齐性,该基准包含长且详细的提示。为了测量提示对齐性,使用了原始 DSG 指标和 VQAScore,而对于视觉质量,使用了 Q-Align 模型。

Diffusion-DPO(标记为 DPO-SDXL)在 Pick-a-Picv2 上训练,能够在提示对齐性方面提供有意义的改进,而对 SDXL 进行 MaPO和 SPO的微调(标记为 MaPO-SDXL 和 SPO-SDXL)则提高了视觉质量。然而,尽管 RankDPO 仅在合成偏好上进行训练,但所有指标都有显著提升(例如,SDXL 的 DSG 得分从 74.51 提高到 79.26,Q-Align 得分从 0.72 提高到 0.81),并达到了最新的提示对齐指标。对于 SD3-Medium,在使用RankDPO 进行微调后,继续看到模型性能的提升。

用户研究

为了进一步验证本文方法的有效性,在 DPG-Bench 上对 450 个提示进行了用户研究。要求用户根据他们的整体偏好(即结合文本与图像的对齐性和视觉质量)选择更好的图像。前面图 3 显示,RankDPO 的胜率优于 DPO-SDXL和 SDXL,这表明其在提高生成图像整体质量方面的有效性。

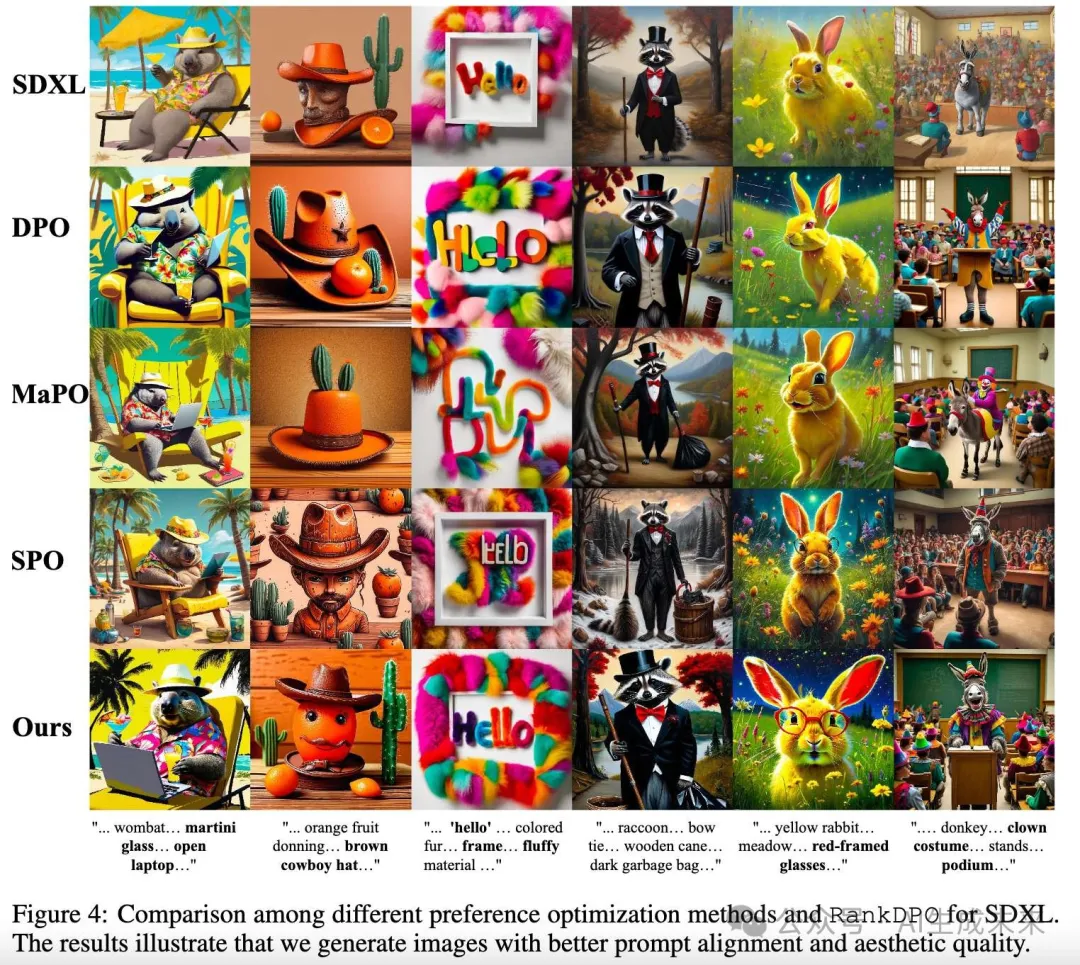

下图 4 中展示了来自 DPG-Bench的提示的定性示例。与基础 SDXL 和其他偏好调整模型相比,RankDPO 在文本渲染方面有显著改进,能够捕捉到所有提示中描述的对象,而其他模型则遗漏了这些对象,并且在图像中对对象之间复杂关系的建模更佳。

计算成本讨论

需要 10 个 A100 GPU 天来生成图像并标注偏好,这是一次性成本。在生成数据上运行 RankDPO 进行 400 步训练,SDXL 在 1024² 像素下大约需要 6 个 GPU 天。相比之下,现有的奖励优化方法在较小的 SD1.5 模型(512² 像素)上需要 64-95 个 A100 GPU 天。类似地,与 Diffusion-DPO相比,RankDPO 在三分之一的数据上训练,同时避免了手动整理的偏好。还有一些通过使用文本编码器(如 T5/LLaMA 模型)来增强文本到图像模型的方法,这些方法需要 1000 万到 3400 万个密集标注的图像,并训练 50-120 个 A100 GPU 天。

消融分析

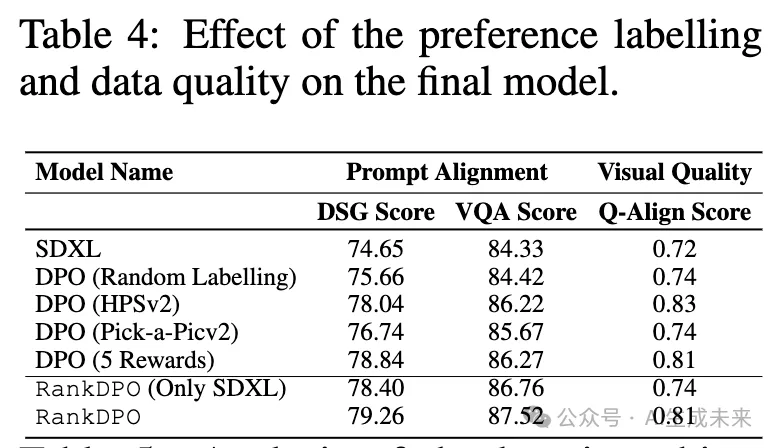

数据和标注函数的影响由于生成偏好是 RankDPO 的关键方面,在下表 4 中评估了不同的标注选择。尝试随机标注,即随机选择偏好并应用 DPO。这仅能提供有限的性能提升(从 74.65 提升至 75.66 的 DSG 得分)。还展示了来自单一奖励模型(HPSv2.1)的成对偏好的结果,以及从 5 个模型中平均偏好的结果。虽然 HPSv2.1 对提示对齐和视觉质量都提供了良好的改进,但跨多个模型的预测集成进一步提高了结果。这些结果优于应用于 Pick-a-Picv2 的 DPO,突显了在构建偏好数据集时图像质量的重要性。最后,调查了用于构建 Syn-Pic 的不同模型的影响。这是通过仅更改种子,构建与 SDXL 图像相似的数据集来完成的。虽然在提示对齐方面几乎得到了相同的改进,但在视觉质量上只看到了小幅提升。这表明,合成偏好调优可以应用于任何模型的输出,但使用不同模型生成的图像可以进一步改善结果。

学习目标分析偏好优化的一个关键方面是学习目标的选择,在上表 4 中进行各种实验进行比较。除了常规的 DPO 公式外,一些研究表明,在经过精心挑选的高质量数据上进行监督微调的好处,也将其纳入比较。基线包括以下几种方法:

- 监督微调:从每对比较中选择获胜的图像,并在此子集上对 SDXL 进行微调。

- 加权微调:在所有样本上对 SDXL 进行微调,但根据 HPSv2.1 分数为每个样本分配权重,类似于 Lee et al.。

- DPO + 增益函数加权:通过使用增益函数对样本加权,可以改善 DPO 目标。

可以看到,RankDPO 实现了最佳结果,突显了基于成对偏好的排名标准的整合对增强偏好优化的好处。

结论与讨论

本文提出了一种强大且具有成本效益的文本到图像模型偏好优化方法。具体而言,展示了如何通过合成生成偏好优化数据集来收集更优的信号(例如,排名与成对偏好、跨模型集成偏好)。还提出了一种简单的方法来利用更强的信号,从而在多个基准测试中实现了针对提示跟随和视觉质量的最新结果,无论是在扩散模型还是修正流模型中。希望本文的工作为未来在文本到图像模型上扩展有效的后期训练解决方案铺平道路。

本文转自AI生成未来 ,作者:AI生成未来