ComfyUI Party:将LLM与图片工作流集成,图片、语音、文本、视觉一体!(graphRAG、ollama)

Hi,这里是Aitrainee,欢迎阅读本期新文章。

我们正在使用一些Agent平台如FastGPT和Dify,他们注重于快速生成文本内容,知识库问答,提供自定义能力和与现有系统的集成性。

同时,在AI绘画方面,我们原来使用SD,后来使用ComfyUI。虽然ComfyUI被广泛用于将文本转化为图像(文生图),但它实际上是一种生成式AI内容(AIGC)的工具,其功能不仅限于此。它还能够处理文本生成(文生文),因此可以实现多种内容的生成。

Dify中也有提供ComfyUI的集成工具,他是调用Comfy UI的服务。

所以,今天我们介绍ComfyUI LLM Party

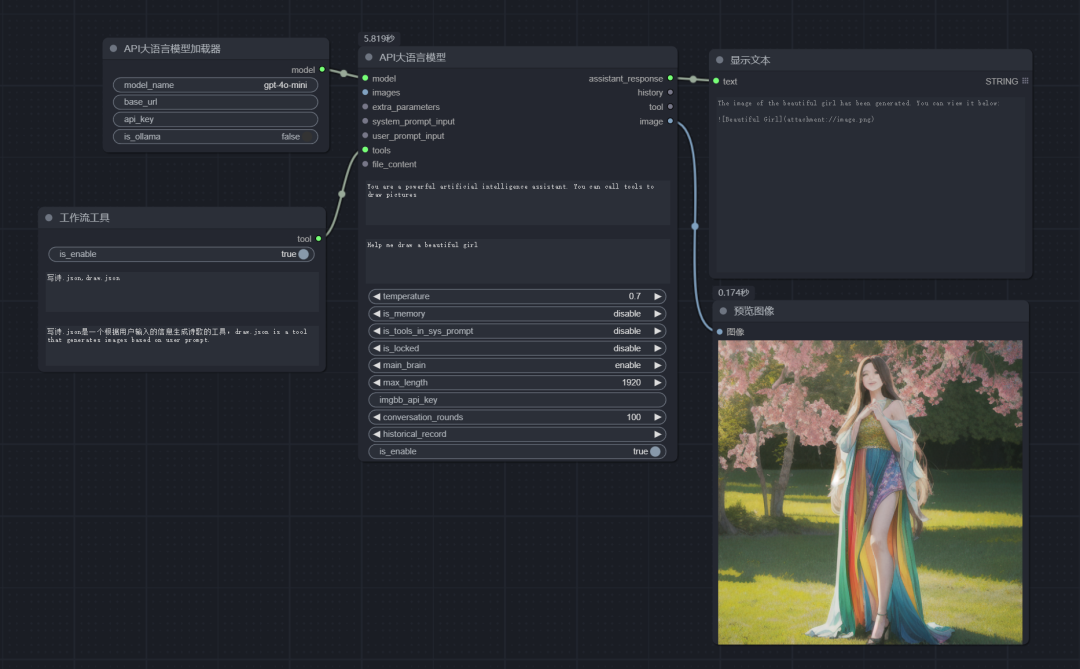

这个工具挺酷的,他专注于LLM集成进ComfyUI里面。旨在基于comfyui作为前端,开发一套完整的LLM工作流构建节点,让用户可以快速便捷地构建自己的LLM工作流,并轻松集成到现有的图片工作流中。

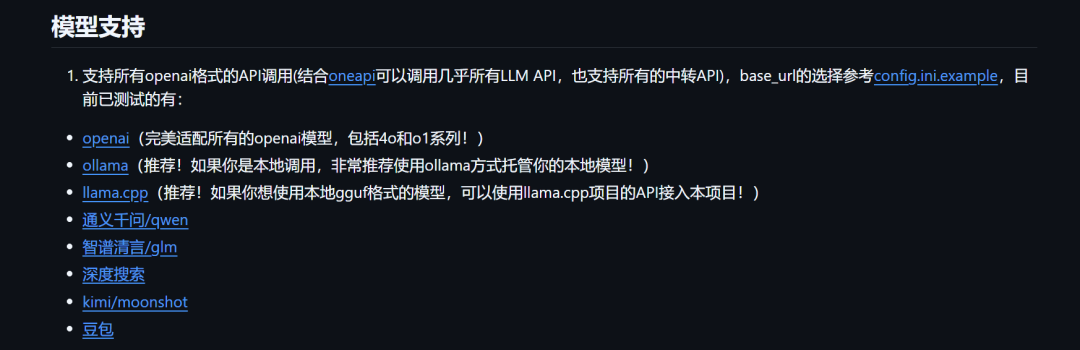

该插件在 ComfyUI 中支持绝大多数大语言模型,兼容 OpenAI 格式的 API 调用,并结合 OneAPI 调用几乎所有 LLM API。支持的模型包括通义千问、智谱清言、DeepSeek 和 Kimi。

额外功能有:支持 Ollama 本地模型,模型链节点选项(LLM、VLM-GGUF、LLM-GGUF),以及 VLM 模型的图像识别和提示词反推。

实用工具包括 OpenAI 语音识别与合成、Markdown 转 HTML、HTML 转图片,以及通过飞书机器人发送消息到多个平台。

项目愿景:

1、从最基础的 LLM 多工具调用、角色设定快速搭建自己的专属AI助手、到可以行业落地的词向量RAG、GraphRAG来本地化的管理行业内知识库;

2、从单一的智能体流水线,到复杂的智能体与智能体辐射状交互模式、环形交互模式的构建;

3、从个人用户需要的接入自己的社交APP(QQ、飞书、Discord),到流媒体工作者需要的一站式LLM+TTS+ComfyUI工作流;

4、从普通学生所需要的第一个LLM应用的简单上手起步,到科研工作者们常用的各类参数调试接口,模型适配。

挺酷的,我们图片生成的工作流,一定有许多地方可以和视觉、语音LLM结合,比如:

上下文增强:通过LLM获取用户的意图和上下文,优化生成过程,使生成的图像更符合用户需求。

图像描述生成:使用视觉模型分析生成的图像并自动生成描述,帮助用户理解图像内容,适用于无障碍应用。

又如官方所说的:

您可以将任何 ComfyUI 工作流封装到 LLM 工具节点中。您可以让您的 LLM 同时控制多个 ComfyUI 工作流。当您希望它完成某些任务时,它可以根据您的提示选择合适的 ComfyUI 工作流,完成您的任务,并将结果返回给您。

“您的提示选择合适的 ComfyUI 工作流”,这在我们Fastgpt、Coze或者Dify 中称为:问题分类或意图识别。

还有一些其他的,比如ComfyUI + GraphRAG,这些就是单纯使用ComfyUI前端实现GraphRAG。

总之,节点式工作流本身就是千变万化的,给ComfyUI引入LLM的支持,会让它更加适合千变万化的场景,创建更多复杂有趣的应用。

看看模型支持部分,基本上再配合One-API,市面上的模型都能支持,生产场景建议使用VLLM做模型加速部署,以API形式接入,而不是直接Hugging Face加载下载的模型,多说一句,ollama也不如Vllm,前者多卡部署大模型如70B的,推理会很慢,生成环境下基本不行。

这个项目包罗万象,一直在兼容各种东西的路上,简单的项目描述也要写上许多字才能尽善尽美。

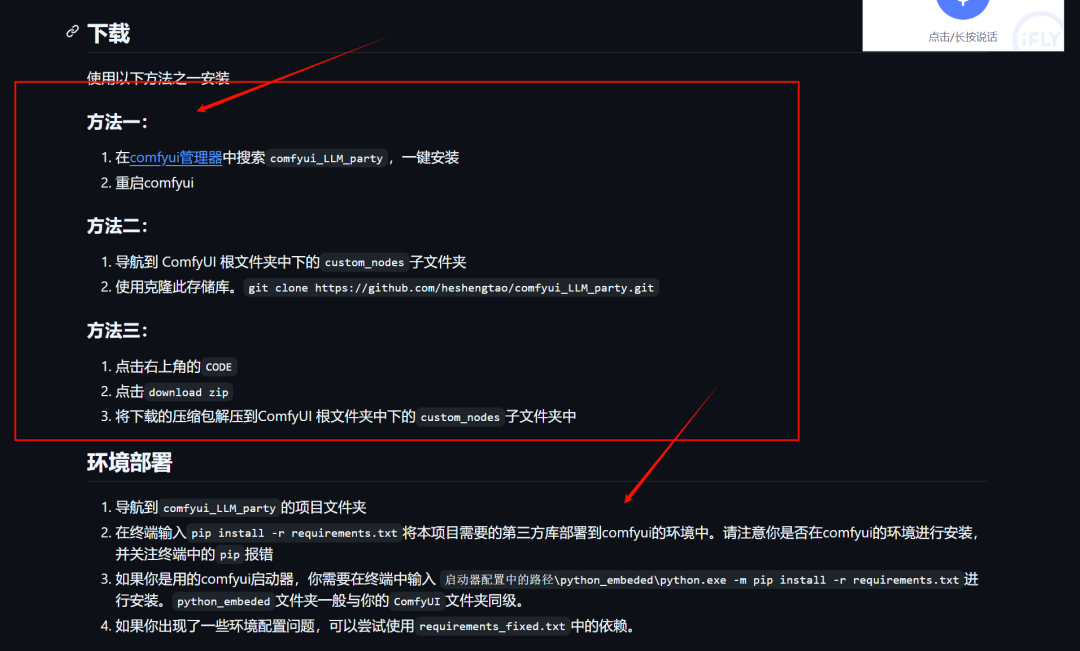

部署方面总共两步吧

方法一下载较方便,可在ComfyUI中直接安装该插件,之后环境部署就是给你的ComfyUI再添加一些这个插件需要的环境。

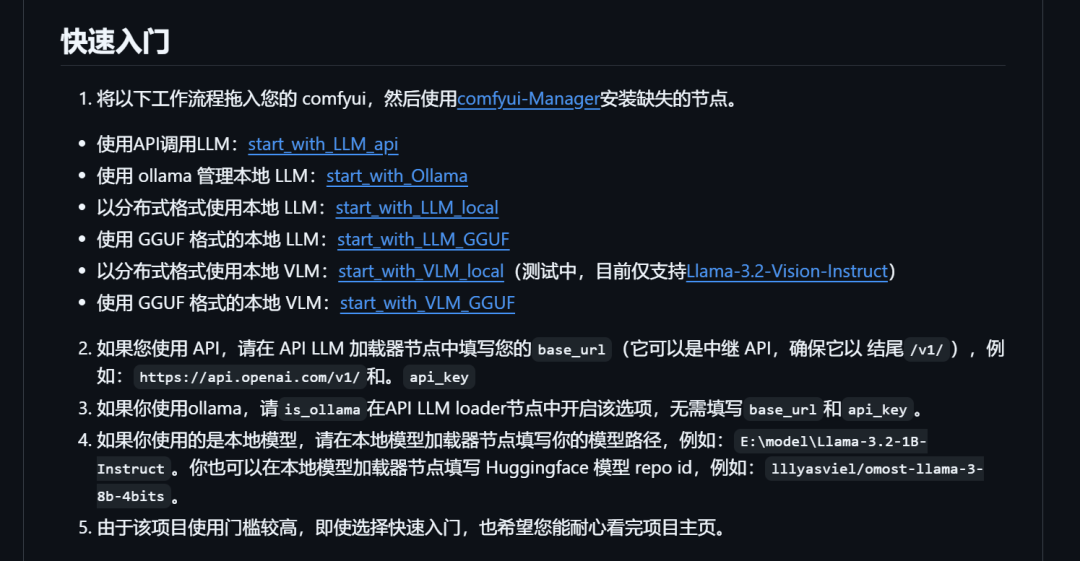

快速开始

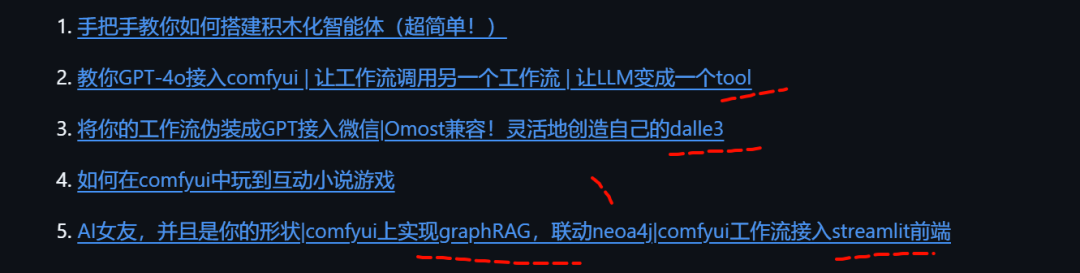

从教程上来看,上手并不难,但是实际上因为它覆盖的东西非常多,你需要深入的话,相应的你需要掌握很多东西,比如一些搜索引擎啊 searxng、neo4j KG、graphRAG、各种LLM的格式、llama.cpp 啊(这些我都弄过,往期文章有,但不全,有一些并没有去写)

具体你可以参考官方介绍。

本文转载自 AI进修生,作者: Aitrainee