327个样本打破常规,这个"OpenAI o1复制之旅"有点燃 | RAG系统迎来重大突破!

1、327个样本打破常规,这个"OpenAI o1复制之旅"有点燃

人工智能领域最近又掀起一阵波澜 —— OpenAI发布了令人瞩目的O1模型。然而,这个模型的具体细节却如同蒙着面纱一般神秘。面对这种情况,一群研究者决定开启了一场别开生面的"O1复制之旅",试图揭开这层面纱。

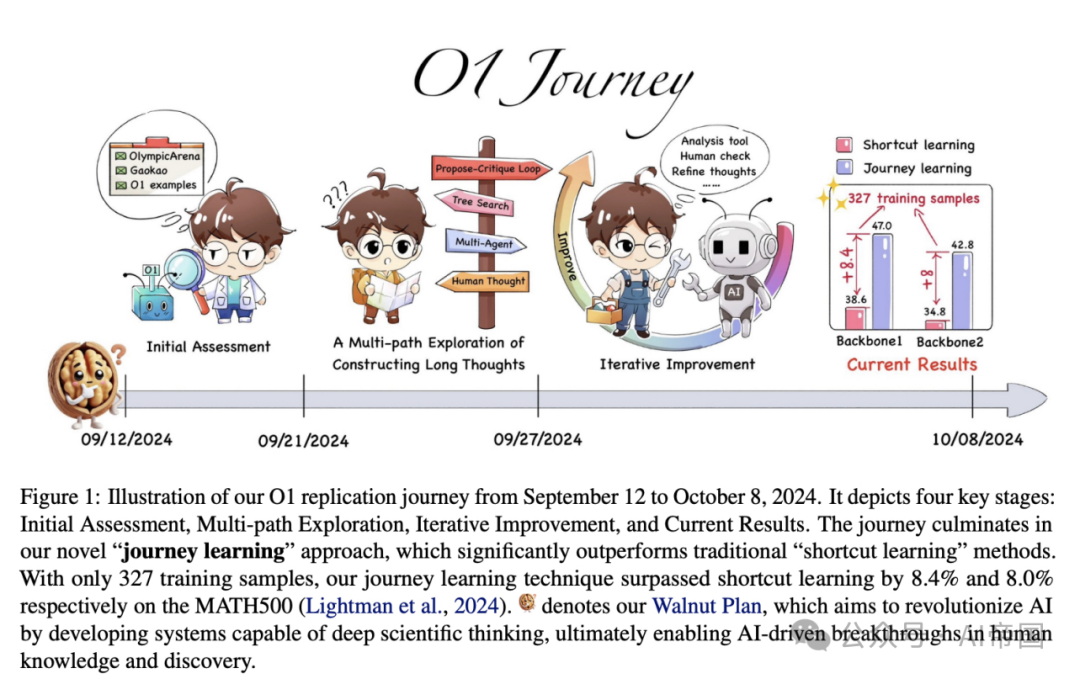

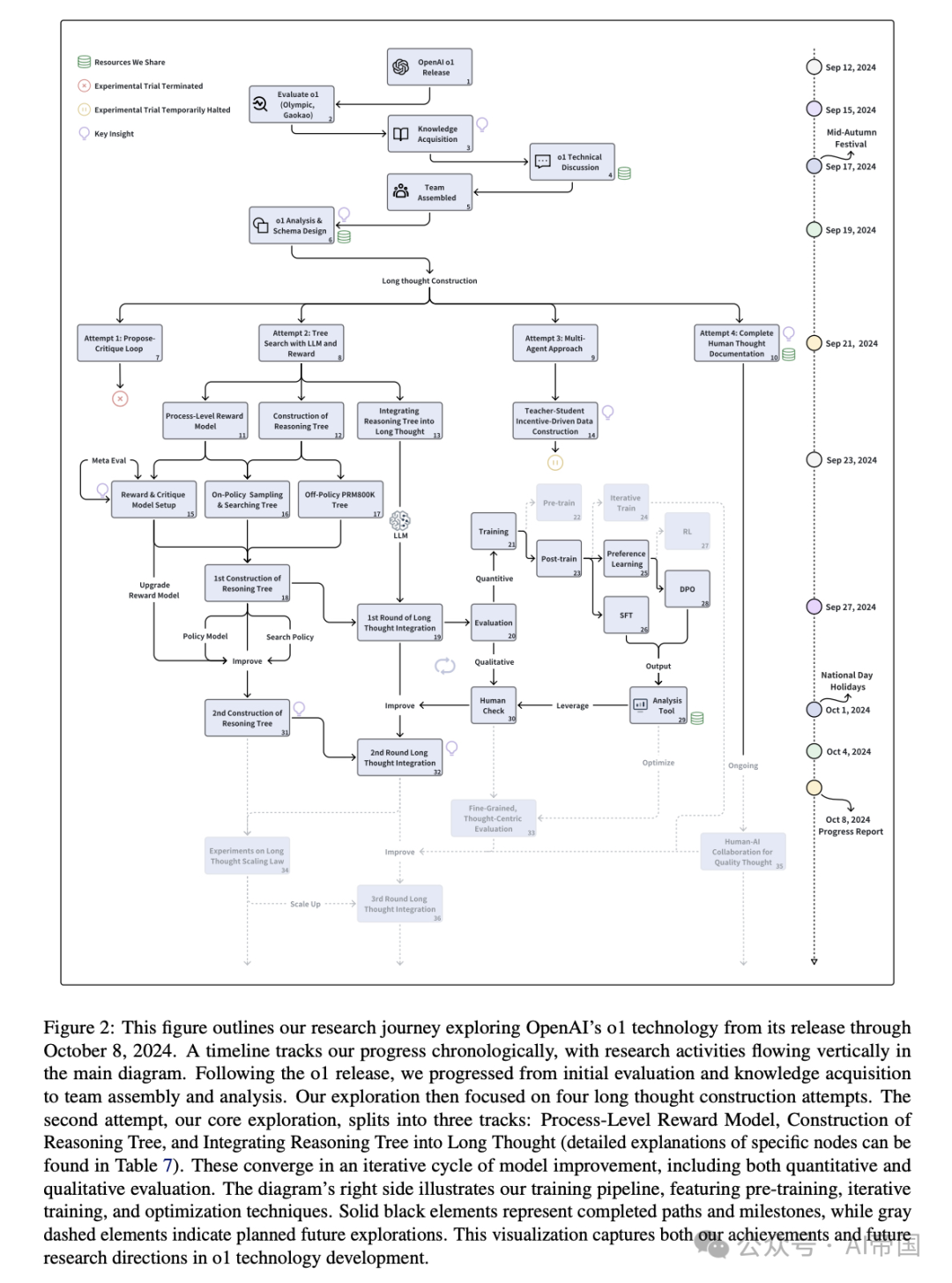

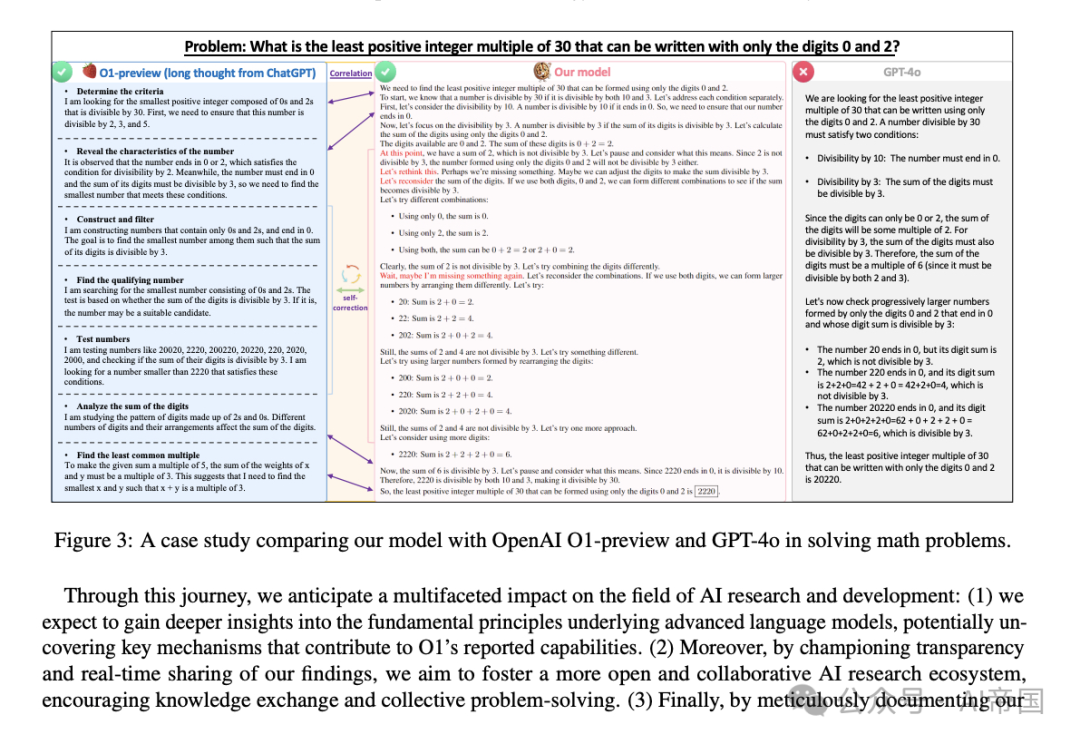

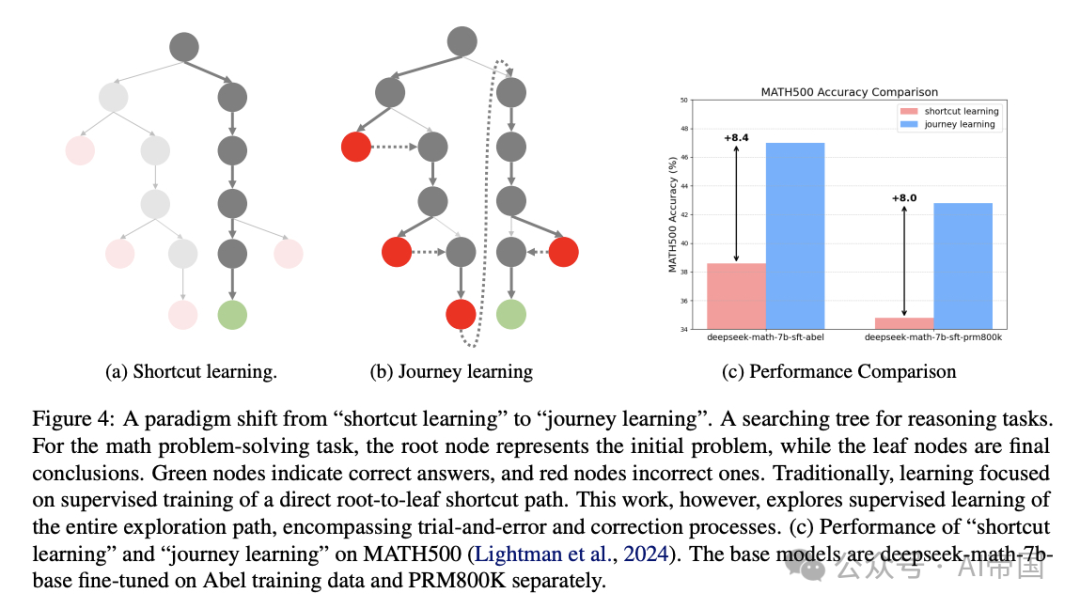

最引人注目的是,研究团队提出了一个创新的"journey learning(旅程学习)"范式。与传统的"死记硬背"式学习不同,这种方法让模型不仅要学会解决问题,还要学习整个探索过程,包括试错、反思和回溯。这个方法的威力令人惊叹:仅用327个训练样本,就在MATH数据集上超越了传统监督学习8%以上的成绩,而且没有使用任何额外技巧!

这个项目的与众不同之处在于其开创性的研究方式。研究团队选择实时公开他们的所有探索过程,包括成功与失败。这就像是在进行一场现场直播的科学探索,任何人都可以第一时间了解他们的发现,参与讨论,共同推进研究进展。

这场"复制之旅"不仅仅是对一个模型的简单模仿,更是对人工智能研究方式的一次革新。研究团队将所有技术假设、认知探索路径、自研工具等资源都开放在GitHub上,为整个AI社区贡献了宝贵的经验。这种开放、透明的研究方式,或许正在开创AI研究的新范式。

论文标题:O1 Replication Journey: A Strategic Progress Report -- Part 1

论文链接:https://arxiv.org/abs/2410.18982

2、RAG系统迎来重大突破!这个方法让大模型答案准确率提升10%

大语言模型的RAG系统虽然强大,但总是会出现一些令人尴尬的"跑偏"现象。比如当你问"法国的首都是哪里"时,它可能会顺带给你讲述其他法国城市的故事。这种"画蛇添足"不仅影响回答的准确性,更可能导致错误信息的产生。

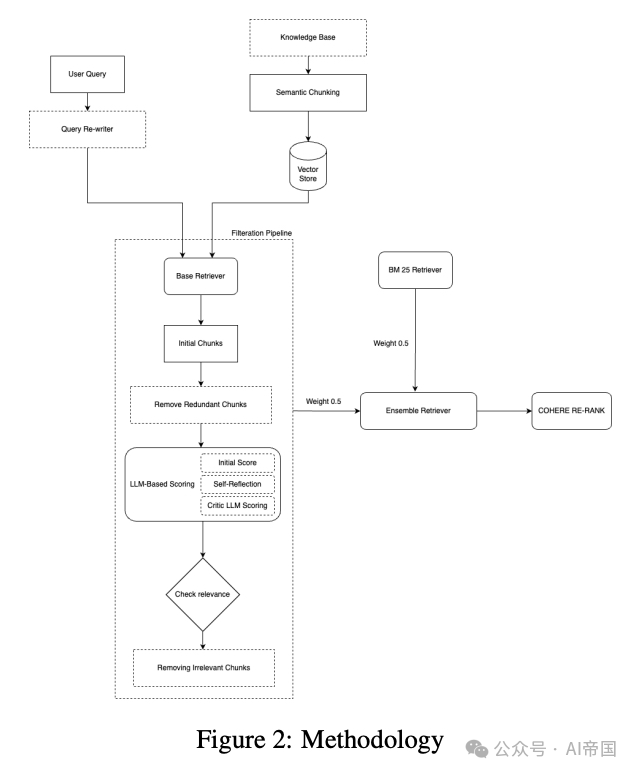

研究者们提出了一个巧妙的解决方案:ChunkRAG。这个方法就像是给RAG系统装上了一个"智能过滤器"。它不再是简单地获取整篇文档,而是先将文档切分成小块,再让大模型仔细评估每个小块与问题的相关性,最后只保留最相关的内容来生成答案。

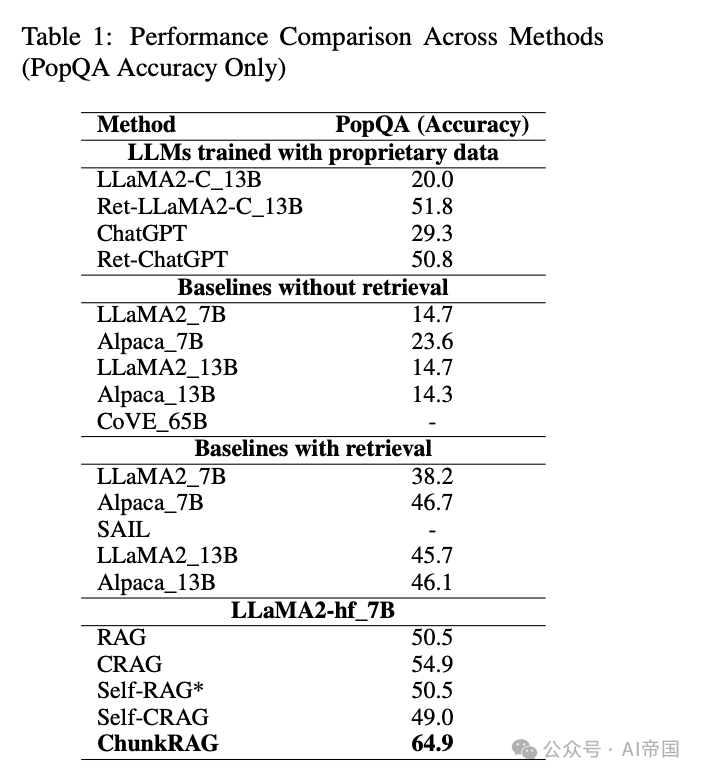

这种创新方法的效果令人振奋。在PopQA数据集上的测试显示,ChunkRAG使系统的准确率提升了惊人的10个百分点!拿之前的例子来说,当你问法国首都时,它现在会干净利落地回答:"法国的首都是巴黎",没有任何多余信息。

这一突破对于需要高度准确性的应用场景,比如事实核查、多跳推理等尤为重要。它让我们离真正可靠的AI助手又近了一步,相信未来会有更多领域因此受益。

论文标题:ChunkRAG: Novel LLM-Chunk Filtering Method for RAG Systems

论文链接:https://arxiv.org/abs/2410.19572

本文转载自 AI帝国,作者: 无影寺