谷歌与学术界联手,研究突破多智能体合作瓶颈的新算法

在人类的合作中,我们可能会遇到囚徒困境(Social Dilemmas)、悲剧的共有(Tragedy of the Commons)、公平分配问题(Public Goods Game)、猎人与收集者困境(Stag Hunt Game)、和合作网络(Networked Cooperation)等诸多社会性合作困境,比如两个人必须决定是否与对方合作(相互协力)或是背叛(选择个人利益)。合作可以带来最大的集体收益,但个体背叛可能会导致更高的个人收益。这种情况下,我们需要在短期的个人利益和长期的集体利益之间做出平衡。在群体合作的情境,我们必须决定是否向公共资源池中投入资源。投入资源的人可能会从公共资源池中获得收益,但也存在不投入却享受收益的可能性。同样,智能体作为智能代理在系统里进行合作时也会遇到同样的问题,比如智能体通过网络相互连接,合作的利益取决于网络中的其他智能体的行为。这种设置中的智能体需要在本地合作和全局合作之间做出选择。

研究者们已经意识到,在多智能体系统中实现合作不仅能提升系统的整体性能,还可以提高智能体在复杂环境中的适应能力。尽管如此,如何设计出能够促使这些独立智能体自愿合作的机制仍然是一个未解难题。

10 月 24日,来自以谷歌为首的联合研究团队发表他们的最新研究《Multi-agent cooperation through learning-aware policy gradients》,他们提出通过学习感知策略梯度的方法来实现多智能体合作。这一研究的主要问题是:在多智能体学习中,如何促使自利、独立的智能体实现合作?传统的独立智能体优化自身目标的方式在一般和博弈中往往表现不佳,难以实现合作。为此研究团队提出了一种新的策略梯度算法,通过考虑其他智能体的学习动态,来实现智能体之间的合作。

他们的主要贡献包括:

- 提出了一种新的无偏、高效的策略梯度算法,能够在多智能体学习中实现合作。

- 利用序列模型,将智能体的行为基于长观测历史进行条件化,从而促进智能体之间的合作。

- 在标准的社会困境中验证了该算法的有效性,展示了其在复杂环境中的出色表现。

- 提出了一个新的理论框架,解释了在何种情况下和如何在自利的学习感知智能体之间产生合作。

研究团队由来自多个知名机构的学者组成,包括Google Paradigms of Intelligence Team、Mila - Quebec AI Institute、Université de Montréal、McGill University以及CIFAR。Alexander Meulemans和Seijin Kobayashi在这项研究中做出了相等的贡献。团队成员背景深厚,研究领域涵盖人工智能、机器学习和多智能体系统等多个方面,体现了跨学科和跨国合作的特点。通过这种多元化的合作,研究团队成功地提出了能够实现多智能体合作的创新算法,对推动多智能体学习领域的发展具有重要意义。

多智能体学习中的合作挑战

在多智能体系统中,每个智能体都致力于优化自己的回报,这通常导致个体之间缺乏合作,产生次优结果。这种现象在博弈论中被称为社会困境,其中最著名的例子就是囚徒困境。在这种情况下,虽然合作能够带来最优的集体回报,但自利的个体由于担心对方的背叛而倾向于选择不合作,从而导致双方都处于次优状态。

自利个体的合作难题在很多现实场景中得到体现。例如,自主驾驶车辆在共享道路时需要互相合作以避免交通事故,然而每辆车都可能选择最优的个人策略而忽视整体安全。类似地在网络安全中,不同系统需要共享信息以防御共同的威胁,但由于担心信息泄露,各系统往往选择不合作,导致安全隐患加大。

现有的多智能体学习研究在应对这一挑战方面取得了一些进展。传统的方法主要集中在通过设计激励机制和约束条件来促进合作。然而这些方法往往依赖于预先设定的规则和模型,对于复杂动态的实际环境表现出局限性。近年来,学习感知策略逐渐成为解决多智能体合作问题的一个重要方向。

一些研究提出了学习感知算法,通过让智能体了解并预测其他智能体的学习动态,从而调整自己的策略来促进合作。这些方法在某些任务中展示了令人鼓舞的效果,证明了学习感知在多智能体合作中的潜力。然而这些方法大多依赖于高阶导数的计算,计算复杂度较高,且在面对不确定和噪声较大的环境时,表现不够稳定。

尽管取得了一些进展,现有方法在多个方面仍然存在不足。例如,许多方法依赖于智能体之间的信息共享,这在分布式系统或隐私敏感场景中难以实现。此外这些方法在处理大规模、多样化的智能体群体时,计算效率和稳定性尚待提高。因此,提出一种高效、稳定且适用于复杂环境的多智能体合作学习算法,依然是一个亟待解决的重要问题。

背景和问题设置

在多智能体学习中,智能体通常在部分可观察随机游戏(POSGs)的框架内进行交互。POSGs是一种由Kuhn于1953年提出的模型,定义为一个包含多个智能体的系统,其中每个智能体只能获得部分状态信息。POSGs的重要性在于它能够模拟现实世界中的复杂场景,如自动驾驶、机器人协作和分布式控制系统。每个智能体在POSGs中都面临不完全信息的挑战,这增加了决策和学习的难度。

在一般和博弈中,智能体不仅要最大化自己的回报,还要考虑其他智能体的策略。这个过程中面临两个主要难题:非静态环境和均衡选择。非静态环境意味着其他智能体也在同时学习和适应,这使得环境从单个智能体的视角来看是不断变化的。均衡选择问题则源于多个纳什均衡的存在,尤其在复杂的POSGs中,某些均衡可能非常次优,导致整体表现不佳。例如,在无限重复的囚徒困境中,完全背叛和合作策略都可以成为纳什均衡,但前者会导致较低的整体回报。

为了应对这些挑战,引入同伴学习意识成为一种有效的方法。学习意识的关键在于智能体能够理解和预测其他智能体的学习动态,并基于这种理解来调整自己的策略。这不仅能帮助智能体在非静态环境中做出更好的决策,还能促使智能体在多个均衡中选择更优的均衡,从而提高整体合作水平。

通过引入同伴学习意识,智能体不仅能在复杂环境中更好地适应,还能在一般和博弈中实现有效合作。这一方法的核心在于智能体通过建模和学习其他智能体的行为动态,从而在决策过程中充分考虑他人的反应和变化,最终实现自利智能体之间的合作。研究表明,这种方法在提高多智能体系统的整体表现方面具有显著优势。

同伴塑造与序列模型

在多智能体系统中,如何塑造其他智能体的学习行为以实现合作是一个重要的研究课题。研究团队提出了一种同伴塑造的元游戏,通过在多智能体部分可观察马尔可夫决策过程(POMDP)中增加一个元层次变量,来表示每个智能体使用的学习算法。这个元游戏的目标是让一个元智能体通过学习感知来塑造天真的共同玩家的行为,从而实现合作。这一元游戏被形式化为单智能体POMDP,元状态包括所有共同玩家的策略参数和智能体自身的参数,元环境动态则表示共同玩家的固定学习规则。

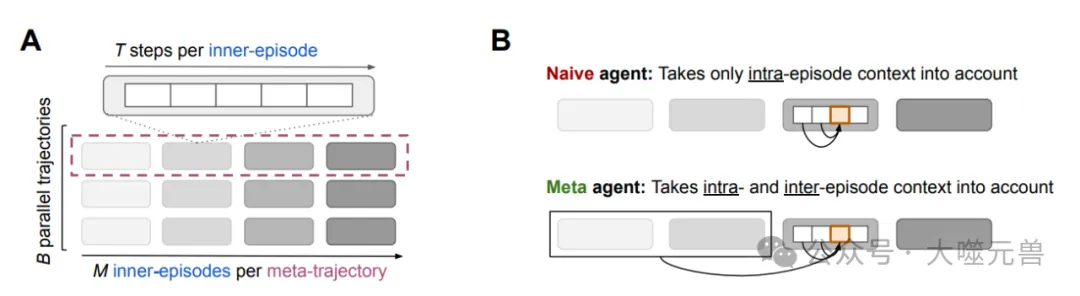

图1|A.经验数据术语。内部情节包括(内部)游戏的𝑇步骤,在代理人之间并行进行𝐵次,形成一批内部情节。一个给定的内部情节序列形成了一个元轨迹,因此包括内部游戏的步骤。𝐵元轨迹的集合形成了一个元情节。B.在游戏过程中,一个天真的代理人只考虑当前的情节背景来做出决策。相比之下,元代理会考虑完整的长上下文。观看多集游戏会赋予元代理学习意识。

为了实现这一目标,研究团队提出了将内层和元策略结合在一个长上下文策略中的方法。通过基于多个内层游戏的长观测历史来决定动作,智能体能够更好地理解和预测其他智能体的学习动态。具体来说,研究团队定义了一种批量同伴塑造POMDP,包含多个并行轨迹的环境动态和批量长历史观测。这种设置允许智能体在多个内层游戏中观察共同玩家的学习行为,并通过这种观察调整自己的策略,以实现更优的合作。

批量同伴塑造POMDP的定义是关键。它包含多个并行运行的内层游戏,每个游戏都有自己的环境状态和共同玩家策略参数。这些环境动态模拟了多个并行的环境,并在每个内层游戏边界更新共同玩家的策略参数。初始状态分布初始化了共同玩家的策略,并为第一个内层游戏批次初始化环境。然后通过一个长上下文策略,智能体可以在长时间范围内基于批量长历史观测进行决策,从而更有效地塑造共同玩家的行为。

通过这种批量同伴塑造POMDP设置,作者提出了一种高效的策略梯度同伴塑造算法。这种算法能够在不依赖高阶导数的情况下,通过测量策略更新对批量内层游戏历史分布的影响来估计策略梯度,从而实现多智能体系统中的合作。

COALA-PG算法的策略梯度

为了实现多智能体系统中的有效合作,研究团队提出了COALA-PG (Co-agent Learning-Aware Policy Gradients) 算法。这是一种新的策略梯度算法,旨在通过考虑其他智能体的学习动态,来实现智能体之间的合作。

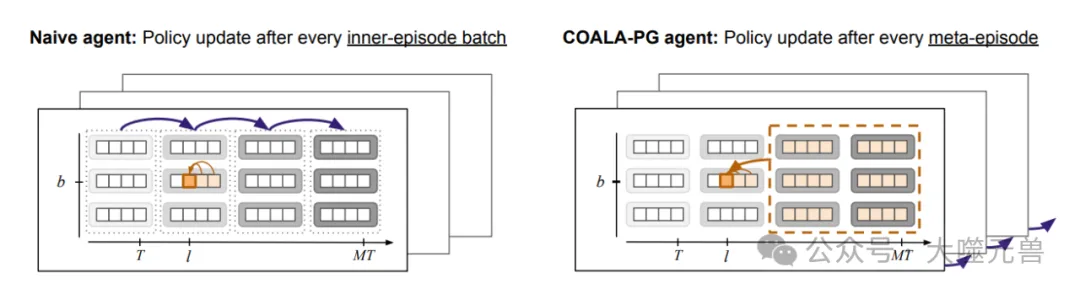

图2|天真代理和元代理的策略更新和信用分配。一个天真的代理(左)只考虑事件内的上下文。COALA代理(右)考虑了批处理维度上的事件间上下文。对于策略更新,天真代理聚合内部批处理维度(虚线块)上的策略梯度,并在事件边界之间更新其策略。相比之下,COALA代理在元事件维度上以较低的频率更新他们的策略。

COALA-PG的提出源自对多智能体学习中的核心挑战的深入理解。传统的策略梯度方法在处理多智能体系统时,往往忽略了其他智能体也在同时学习这一事实,导致环境对单个智能体而言是非静态的。COALA-PG通过在策略更新中引入对其他智能体学习行为的建模和预测,克服了这一问题。

在与现有方法的比较中,COALA-PG展现了明显的优势。例如,LOLA-DICE是现有的一种方法,虽然它考虑了对手的学习动态,但需要计算高阶导数,这增加了计算复杂度和不稳定性。相比之下,COALA-PG采用了一种无偏的梯度估计方法,不需要高阶导数计算,因而更加高效和稳定。此外,COALA-PG能够处理小批量的内层策略历史,从而在多智能体系统中实现更加精确的策略优化。

COALA-PG在元强化学习中的优势主要体现在以下几个方面。

高效性:通过引入长上下文策略,COALA-PG能够在大规模、多样化的智能体群体中高效运行,显著提高了策略更新的速度和准确性。

稳定性:由于采用无偏的梯度估计方法,COALA-PG在面对不确定和噪声较大的环境时,表现出较高的稳定性,避免了高阶导数方法中的数值不稳定问题。

适用性:COALA-PG能够灵活地适用于各种复杂环境,包括标准的社会困境和需要时间扩展动作协调的环境,这在传统方法中是难以实现的。

通过COALA-PG算法,研究团队在实现多智能体合作方面取得了重要突破。该算法不仅克服了传统方法的计算复杂度和不稳定性问题,还通过引入对其他智能体学习行为的建模,提高了策略更新的精度和效率。

学习意识在一般和博弈中的重要性

在多智能体系统中,学习意识指的是智能体能够理解和预测其他智能体的学习动态,并基于这种理解调整自己的策略。这在解决一般和博弈中的合作问题时显得尤为重要。研究团队通过分析学习意识在重复囚徒困境中的表现,揭示了其促成合作的机制。

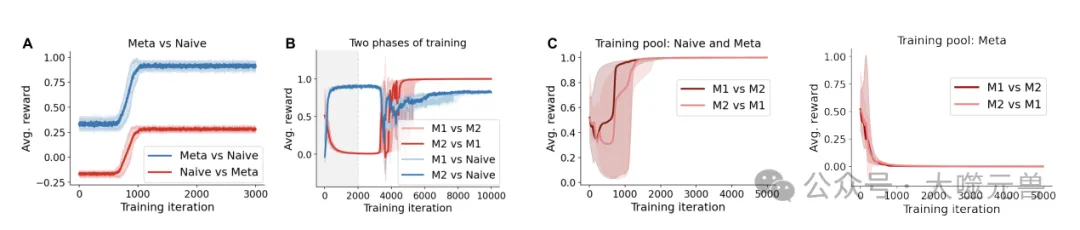

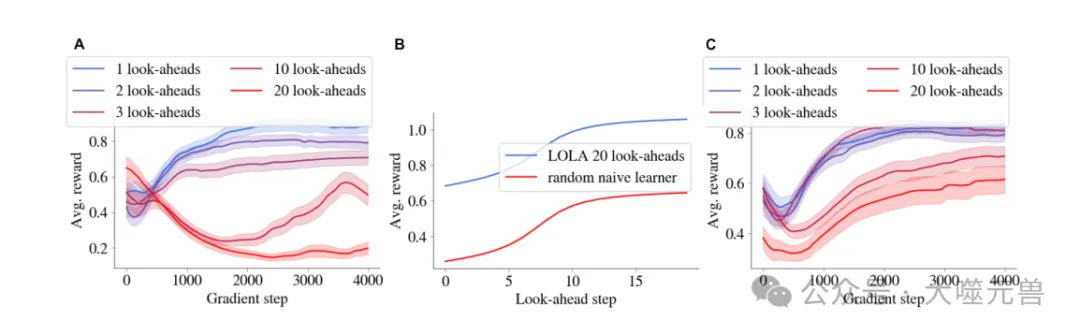

图3|(A)具有学习意识的代理学会勒索天真的学习者,即使在用纯叛逃策略初始化时也是如此。(B) 针对天真智能体(阴影区域期)制定的勒索策略在与另一个学习感知智能体(M1和M2)对抗时变成了合作策略。(C) 合作出现在天真和学习意识代理的混合训练池中,但不仅仅出现在学习意识代理池中。阴影区域表示32个随机种子的四分位数间距(第25至75分位数)。

重复囚徒困境中的合作现象

重复囚徒困境是一个经典的社会困境模型,用于研究自利智能体之间的合作问题。在这个游戏中,两个玩家在每一轮选择合作或背叛,累积的奖励取决于双方的选择。若双方都合作,获得的回报最高;若一方背叛而另一方合作,背叛者获益更多;若双方都背叛,收益最低。在无限重复的囚徒困境中,尽管存在合作的纳什均衡,但自利的个体往往难以稳定地达到这一状态。

图4|(A)由LOLA训练的两个代理在具有各种前瞻步骤的分析梯度的迭代囚徒困境中的性能(仅显示了第一个代理的性能)。(B) 根据(a)训练结束时的固定LOLA 20外观策略训练的随机初始化幼稚学习者的表现。(C) 设置与(A)相同,但具有初始梯度𝜆𝜕𝜕𝜙−𝑖𝐽𝑖(𝜙, 𝜙−𝑖)添加到LOLA更新中,带有𝜆超参数。阴影区域表示在64个种子上计算的标准误差。

研究团队通过实验表明,学习感知智能体能够在重复囚徒困境中逐渐发展出合作策略。这些智能体通过预测对手的学习行为,调整自己的策略,从而在长期博弈中实现互惠合作。

学习意识如何促成合作

研究发现,学习感知智能体通过两种主要机制实现合作。首先,这些智能体能够观察到自己的行动如何影响对手的未来行为。这种观察为智能体提供了从背叛转向勒索的塑造梯度。其次,当两个学习感知智能体相遇时,勒索策略会逐渐转变为合作策略。这是因为在独立学习的情况下,勒索策略会促使对手更多地合作。

研究发现,当学习感知智能体与天真学习者对战时,前者会发展出勒索策略,迫使天真学习者进行不公平的合作。然而,当两个学习感知智能体相遇时,他们会逐渐发展出合作策略,从而实现互惠合作。这一现象不仅在对手之间有效,即使在自我博弈(self-play)的情况下也能观察到。

解释LOLA中的合作机制

LOLA(Learning with Opponent-Learning Awareness)是学习感知领域的先驱工作,研究团队通过COALA-PG算法提供了新的解释。LOLA算法通过预估对手的参数更新来计算总梯度,从而对天真学习者进行策略塑造。研究团队提出了一种不需要高阶导数的新型LOLA梯度估计器,能够在不依赖高阶导数的情况下,通过测量策略更新对批量内层游戏历史分布的影响来估计策略梯度,从而实现多智能体系统中的合作。

通过COALA-PG算法的分析,研究表明,LOLA结合了影响对手未来行为的观察和与其他勒索智能体对战的机制,从而实现了学习感知智能体之间的合作。这一发现不仅解释了LOLA算法中的合作机制,还展示了在复杂环境中实现多智能体合作的新途径。

实验分析

为了验证COALA-PG算法的有效性,研究团队在多个实验中进行了测试。实验主要集中在两个方面:重复囚徒困境和CleanUp游戏。

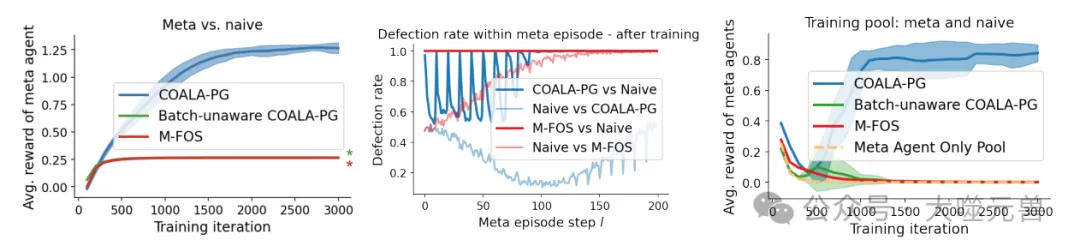

COALA-PG在重复囚徒困境中的表现

在重复囚徒困境实验中,COALA-PG算法展现了其在促成合作方面的卓越表现。实验结果表明,当COALA-PG训练的智能体与天真智能体对战时,COALA-PG智能体通过塑造对手的行为,使其趋向于合作,从而获得了显著更高的回报。这些智能体能够成功地从最初的背叛逐步引导对手进入合作状态,并在整个博弈过程中保持合作。这种行为不仅验证了COALA-PG算法在促进多智能体合作中的有效性,还展示了其在处理复杂的博弈环境中的优势。

图5|COALA-PG训练的特工玩迭代囚徒困境。左:当仅针对天真特工进行训练时,COALA PG训练的特工会勒索后者,并获得比其他基线特工高得多的奖励。星号(★)表示在中心点对应颜色的重叠曲线:在分析一个元事件中代理的行为时,我们观察到COALA PG训练的代理塑造了天真的合作伙伴,导致开始时的低叛逃率,然后在最后被利用。另一方面,M-FOS从一开始就存在缺陷,获得的回报较低,因此未能正确优化成形问题。不知道批次的COALA-PG与M-FOS的性能相同,因此被省略。当训练一组元代理对抗幼稚和其他元代理的混合体时,元代理与其他元代理对抗的平均性能。这些用COALA-PG训练的特工在相互对抗时会合作,但在用基线方法训练时却无法合作。当从池中删除幼稚代理时,元代理也无法合作,如第3节所预测的那样。阴影区域表示在5个种子上计算的标准偏差。

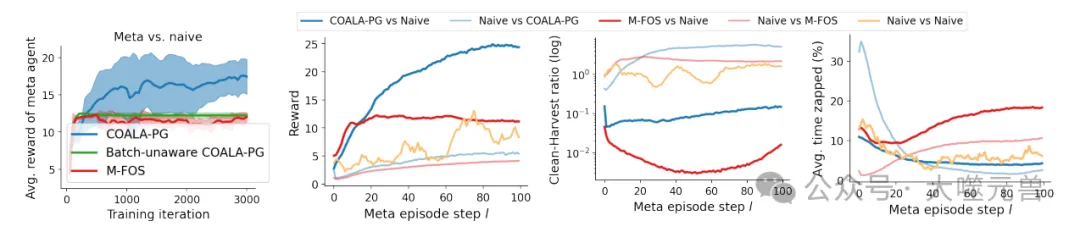

在CleanUp游戏中的表现

除了在重复囚徒困境中的优异表现外,COALA-PG算法在CleanUp游戏中也显示出了显著的优势。CleanUp游戏是一个模拟公共资源悲剧的复杂社会困境,玩家通过清理河流以减少污染,从而增加苹果的生成率。COALA-PG训练的智能体在游戏中不仅能够有效地平衡清理和收获,还能够通过塑造对手的行为,使其减少不必要的干扰(如电击对手)和增加清理工作,从而整体上提高苹果的生成率和最终回报。

图6|COALA-PG针对幼稚代理训练的代理仅在CleanUp中成功塑造了它们。左:与基线相比,COALA PG训练的特工可以更好地塑造天真的对手,获得更高的回报。中左和中右和右:在训练后分析单个元事件中的行为表明,COALA的表现优于基线,并塑造了天真的代理,(i)在整个事件中获得了更高的整体奖励,(ii)表现出更高的清洁收获率,以及(iii)被攻击的频率更低。阴影区域表示在5个种子上计算的标准偏差。

实验结果显示,COALA-PG智能体在与天真智能体混合的环境中能够显著提高合作水平,并在对抗其他学习感知智能体时维持高效合作。通过与基线方法的比较,研究发现COALA-PG算法在处理复杂环境和动态对手方面表现优越。

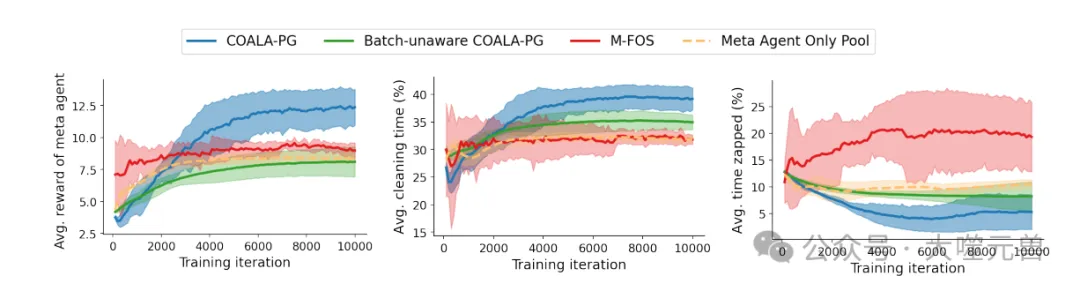

细化的行为分析与对比

为了深入理解COALA-PG算法的行为,研究团队对实验中的智能体行为进行了细化分析。分析结果表明,COALA-PG训练的智能体在元回合中能够成功地塑造天真对手,使其在清理和收获之间找到更好的平衡,从而整体上降低了污染水平并提高了苹果生成率。此外,COALA-PG智能体在与其他学习感知智能体的对战中,也能够通过减少电击行为和增加清理工作,实现高效合作。

图7|使用COALA-PG训练的代理,针对天真代理和其他元代理的混合体,学习在CleanUp lite中合作。左:经过COALA PG训练的特工获得的奖励高于基线特工。中右图:COALA-PG通过更多的清洁和更低的去除率降低了污染,从而提高了苹果产量。阴影区域表示在5个种子上计算的标准偏差。

实验发现COALA-PG智能体通过引导天真对手减少电击行为,使整个博弈过程中的干扰减少,收获效率提高。同时COALA-PG智能体自身也参与清理工作,进一步降低污染水平,从而为所有智能体创造了一个更有利的博弈环境。这种互惠合作的行为模式,不仅验证了COALA-PG算法的有效性,还为多智能体合作提供了新的研究视角。

结论

研究团队通过深入研究和实验分析,展示了学习意识在多智能体合作中的关键作用。在多智能体系统中,自利个体之间的合作一直是一个挑战,而引入学习意识,即智能体能够理解和预测其他智能体的学习动态,成为解决这一问题的重要途径。

通过学习意识,智能体不仅能够在复杂的博弈环境中调整自己的策略,还能有效地塑造其他智能体的行为,从而在多个均衡中选择最优的合作策略。研究团队提出的COALA-PG(Co-agent Learning-Aware Policy Gradients)算法,正是基于这一理念,通过无偏的梯度估计方法,不需要高阶导数计算,展现了显著的性能优势。

COALA-PG方法的创新与优势

高效性和稳定性:COALA-PG算法通过引入长上下文策略,能够在大规模、多样化的智能体群体中高效运行,显著提高了策略更新的速度和准确性。同时,由于采用无偏的梯度估计方法,COALA-PG在面对不确定和噪声较大的环境时,表现出较高的稳定性。

适用性:COALA-PG能够灵活地适用于各种复杂环境,包括标准的社会困境和需要时间扩展动作协调的环境,这在传统方法中是难以实现的。

合作机制:实验结果显示,COALA-PG在模拟的重复囚徒困境和CleanUp游戏中,均能实现高效合作。这表明COALA-PG在实际应用中具有广泛的前景。

未来的研究方向和应用前景

进一步优化算法:研究可以继续优化COALA-PG算法,提高其在更大规模和更复杂环境中的性能。

扩展应用领域:COALA-PG算法在自动驾驶、分布式控制系统和网络安全等多个领域都有潜在应用,可以进一步探索其实际应用场景。

跨学科合作:通过与其他领域的合作,如心理学和行为科学,进一步理解和模拟多智能体系统中的合作机制。

总的来说,研究团队通过提出和验证COALA-PG算法,为多智能体合作研究提供了新的方向和可能性。学习意识在多智能体合作中的关键作用不可忽视,未来研究将继续推动这一领域的发展,探索更多创新应用。(END)

参考资料:https://arxiv.org/pdf/2410.18636

本文转载自大噬元兽,作者: FlerkenS