昨天,国产大模型接管了人类的手机、电脑! 原创

整理 | 言征

国产多模态、智能体版本的GPT-4o终于来了!

10月25日,国内大模型独角兽智谱连发两个大招,小编当时差点愣住,不愧国产大模型之光!

废话不多说,直接上干货。这次智谱推出了一个模型GLM-4-Voice ,一款应用AutoGLM。

图片

图片

开源地址:https://github.com/THUDM/GLM-4-Voice

GLM-4-Voice 是智谱 AI 推出的端到端语音模型。GLM-4-Voice 能够直接理解和生成中英文语音,进行实时语音对话,并且能够遵循用户的指令要求改变语音的情感、语调、语速、方言等属性。

图片

图片

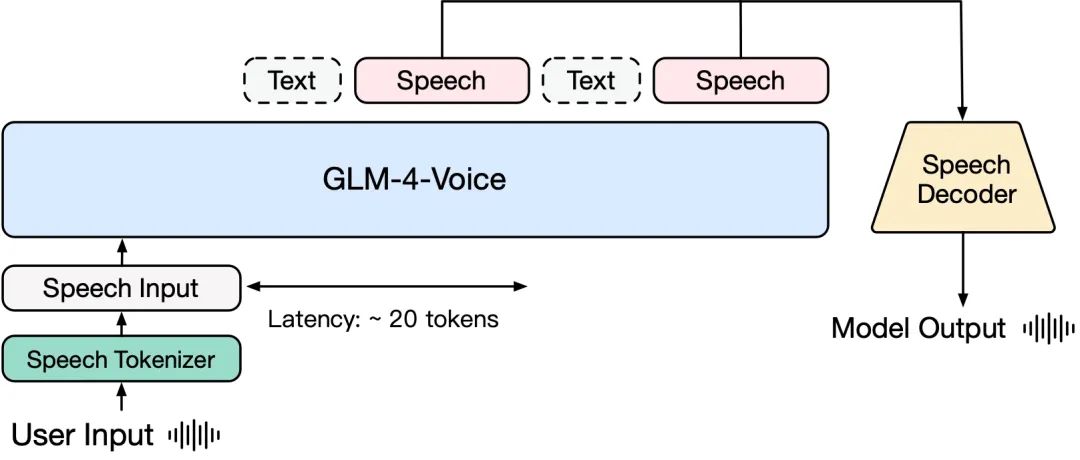

模型架构

GLM-4-Voice 由三个部分组成:

GLM-4-Voice-Tokenizer: 通过在 Whisper 的 Encoder 部分增加 Vector Quantization 并在 ASR 数据上有监督训练,将连续的语音输入转化为离散的 token。每秒音频平均只需要用 12.5 个离散 token 表示。

GLM-4-Voice-Decoder: 基于 CosyVoice 的 Flow Matching 模型结构训练的支持流式推理的语音解码器,将离散化的语音 token 转化为连续的语音输出。最少只需要 10 个语音 token 即可开始生成,降低端到端对话延迟。

GLM-4-Voice-9B: 在 GLM-4-9B 的基础上进行语音模态的预训练和对齐,从而能够理解和生成离散化的语音 token。

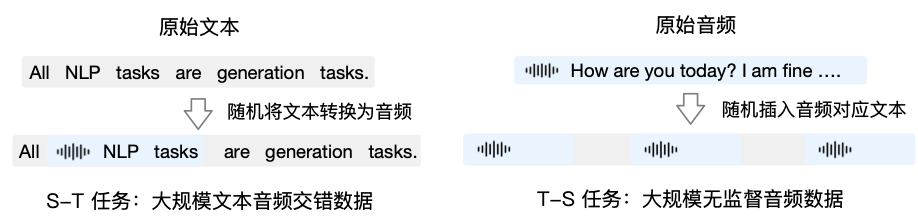

预训练方面,为了攻克模型在语音模态下的智商和合成表现力两个难关,我们将 Speech2Speech 任务解耦合为“根据用户音频做出文本回复”和“根据文本回复和用户语音合成回复语音”两个任务,并设计两种预训练目标,分别基于文本预训练数据和无监督音频数据合成语音-文本交错数据以适配这两种任务形式。

GLM-4-Voice-9B 在 GLM-4-9B 的基座模型基础之上,经过了数百万小时音频和数千亿 token 的音频文本交错数据预训练,拥有很强的音频理解和建模能力。

GLM-4-Voice 预训练数据构造

GLM-4-Voice 预训练数据构造

对齐方面,为了支持高质量的语音对话,我们设计了一套流式思考架构:根据用户语音,GLM-4-Voice 可以流式交替输出文本和语音两个模态的内容,其中语音模态以文本作为参照保证回复内容的高质量,并根据用户的语音指令要求做出相应的声音变化,在最大程度保留语言模型智商的情况下仍然具有端到端建模的能力,同时具备低延迟性,最低只需要输出 20 个 token 便可以合成语音。

电脑、手机听从指令帮你操作AutoGLM 同步上线

在情感语音通话全面开放的同时,智谱也宣布了另一项前沿成果:AutoGLM。

一句话让AutoGLM点喜茶视频来源:数字生命卡兹克

一句话让AutoGLM点喜茶视频来源:数字生命卡兹克

让 AI 像人类一样操作电脑和手机,是近期领域内的热点话题。以往这是一项颇具挑战性的任务,因为在此类场景下,AI 需要根据用户的要求拆解指令背后蕴含的步骤,感知环境、规划任务、执行动作,逐步完成任务。某种程度上说,这突破了大模型的常规能力边界,更加注重其「工具」属性。

很多大模型公司都在探索这一方向,锚定其为「下一个 AI 前沿」。基于大语言模型(GLM 系列模型)、多模态模型和工具使用(CogAgent 模型)等方面的探索,智谱已经在由自主智能体(Agent)驱动的人机交互新范式方面取得了一些阶段性成果。

在智谱最新发布的 AutoGLM App 中,用户可以凭借一句指令让 AI 自动完成许多任务,比如阅读网页信息、电商产品购买、点外卖、订酒店、评论和点赞微信朋友圈等。目前,AutoGLM 已开启内测(暂时仅支持 Android 系统)。

在 AutoGLM App 发布之前,AutoGLM-Web 已经通过「智谱清言」插件对外开放使用。这是一个能模拟用户访问网页、点击网页的浏览器助手,可以根据用户指令在私域网站上完成高级检索并总结信息、模拟用户看网页的过程进行批量、快速的浏览并总结多个网页,结合历史邮件信息回复邮件。

本文转载自51CTO技术栈,作者:言征