Meta AI发布全新量化版本Llama 3.2(1B & 3B):推理速度提升2-4倍,模型大小减少56% 原创

01 概述

在人工智能的世界里,大型语言模型(LLMs)的飞速发展无疑为各行各业带来了翻天覆地的变化。然而,这些模型的庞大身躯和对计算资源的渴求也给实际应用带来了不小的挑战。高昂的能源成本、漫长的训练周期以及对昂贵硬件的需求,都成了阻碍许多组织和研究者利用AI能力的门槛。这些挑战不仅对环境造成了影响,也在科技巨头与小型实体之间划出了一道鸿沟。

02 Meta AI的量化Llama 3.2模型(1B和3B)

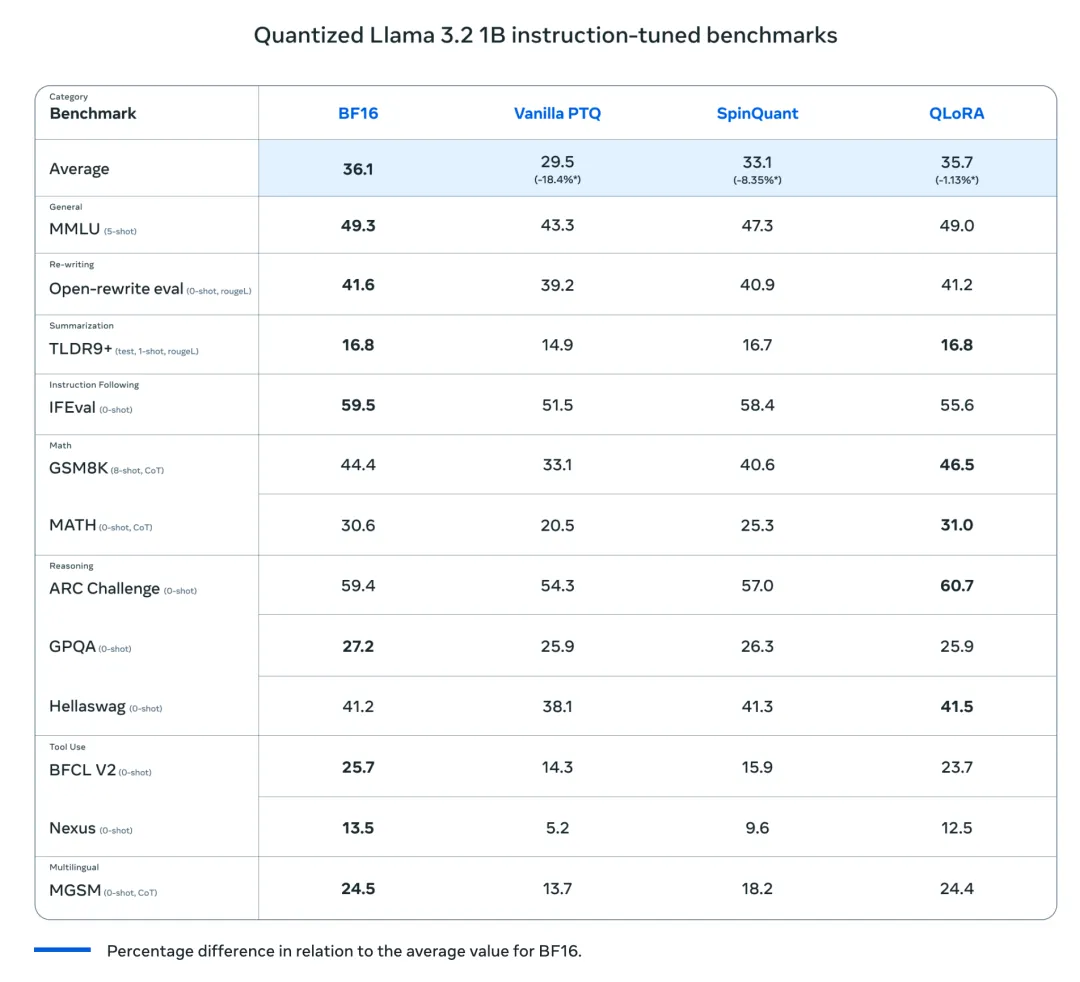

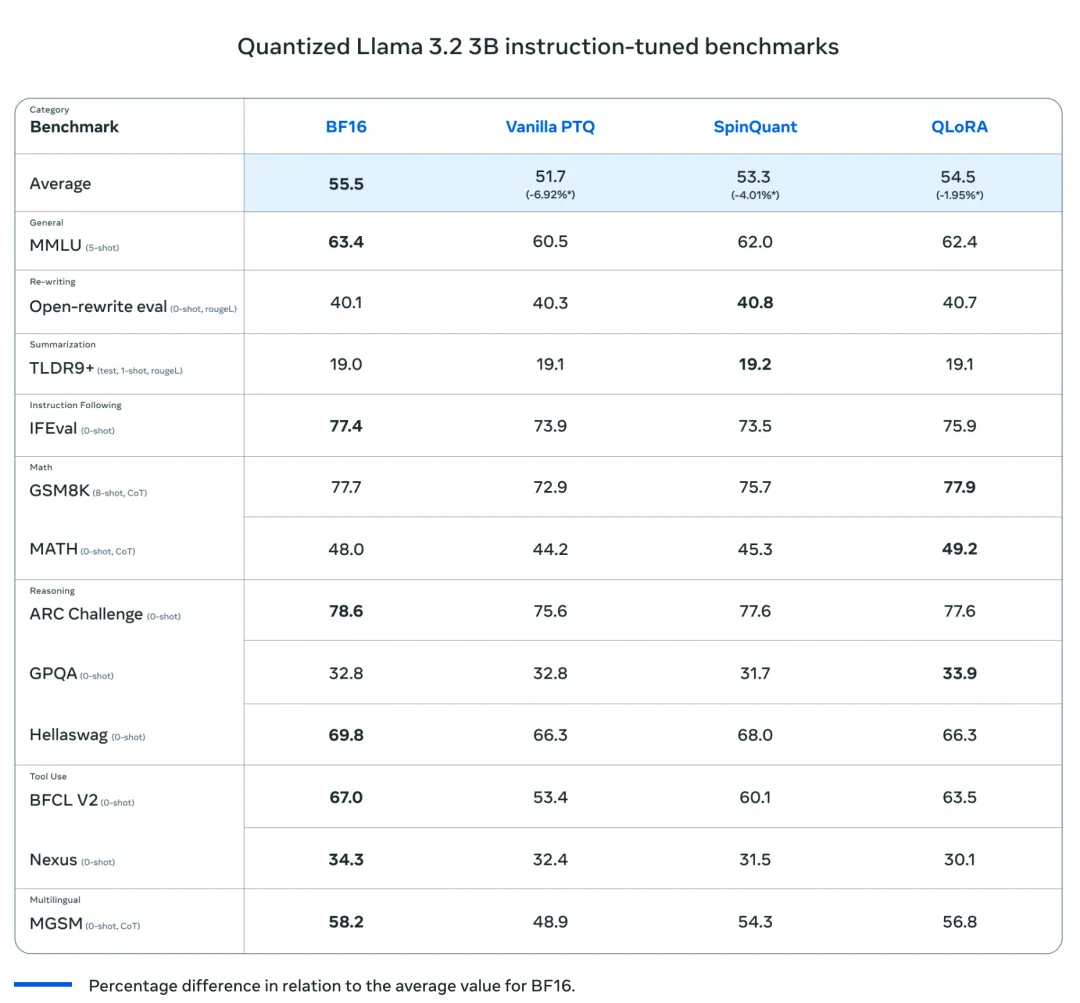

最近,Meta AI发布了量化版本的Llama 3.2模型(1B和3B),这是将尖端AI技术普及给更广泛用户群体的重要一步。这些模型是首批轻量级的量化Llama模型,它们的体积小到足以在许多流行的移动设备上运行。研究团队采用了两种不同的技术来量化这些模型:一种是以准确性为优先的量化感知训练(QAT)与LoRA适配器,另一种是专注于便携性的先进后训练量化方法SpinQuant。这两个版本都可以在这次发布中下载。这些模型代表了原始Llama 3系列的量化版本,旨在优化计算效率,并显著减少运行它们的硬件足迹。通过这样做,Meta AI旨在在减少部署所需的计算资源的同时,增强大型模型的性能。这使得研究人员和企业能够在不需要专门的、昂贵的基础设施的情况下利用强大的AI模型,从而实现尖端AI技术的民主化。

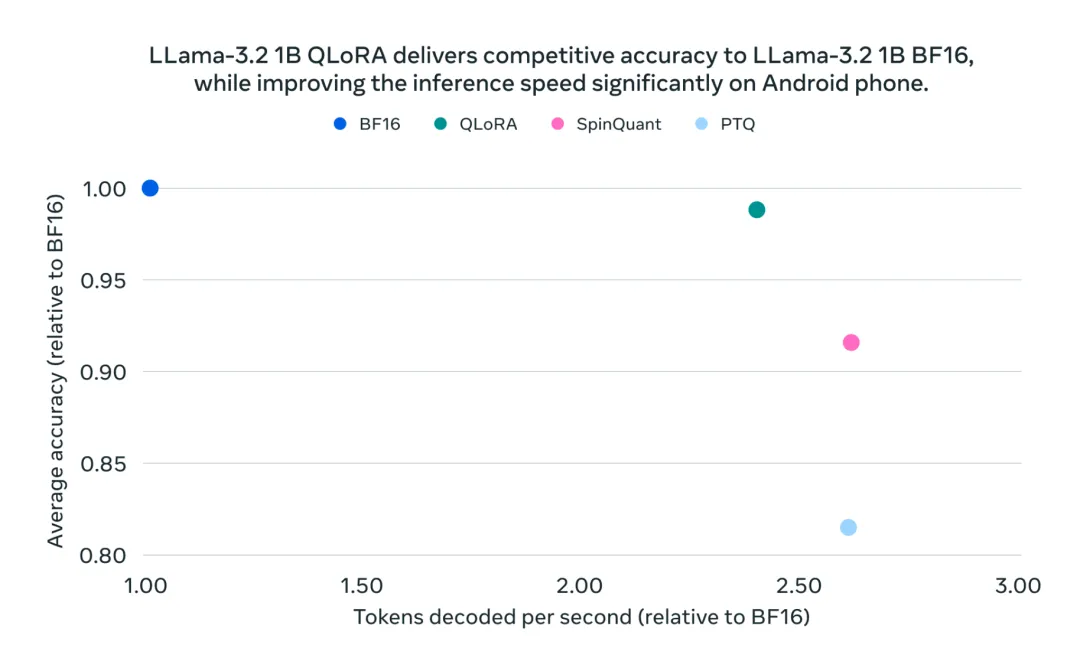

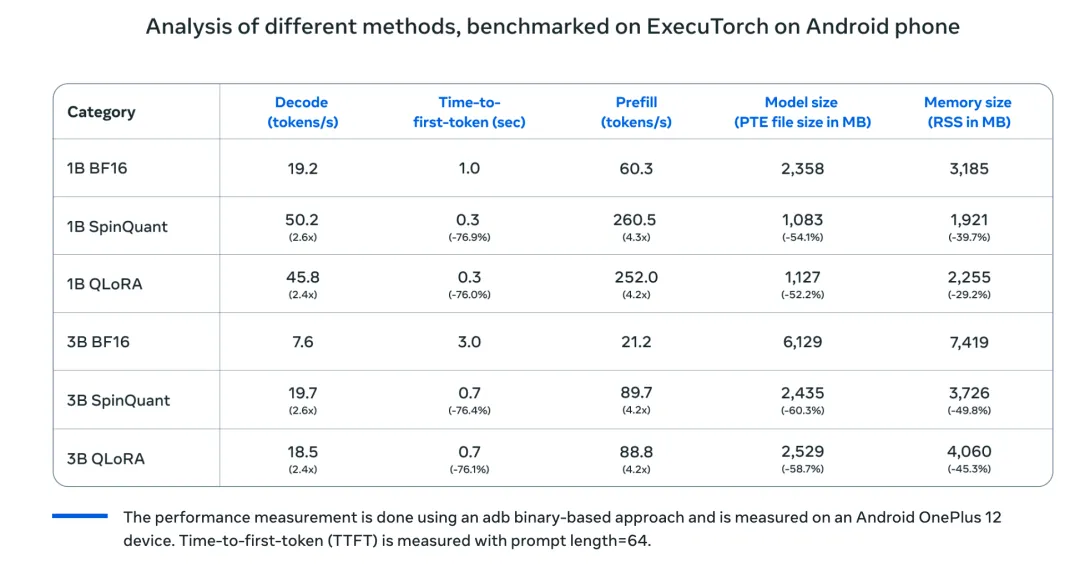

Meta AI之所以能够提供这些量化模型,得益于其对广泛的计算资源、训练数据、全面评估以及对安全的重视。这些模型在保持与原始Llama 3模型相同的质量和安全要求的同时,实现了显著的2-4倍速度提升。与原始的BF16格式相比,它们还实现了平均56%的模型大小减少和41%的平均内存使用减少。这些令人印象深刻的优化是Meta在保持高性能和安全标准的同时,使先进AI更加易于获取的努力的一部分。

03 技术细节和优势

量化Llama 3.2的核心是基于量化技术,该技术将模型的权重和激活的精度从32位浮点数降低到更低位的表示。具体来说,Meta AI采用了8位甚至4位的量化策略,这使得模型能够在显著减少内存和计算能力的情况下有效运行。这种量化方法保留了Llama 3的关键特性和能力,如执行高级自然语言处理(NLP)任务的能力,同时使模型更加轻量化。好处是显而易见的:量化Llama 3.2可以在不那么强大的硬件上运行,例如消费级GPU甚至CPU,而不会显著损失性能。这也使得这些模型更适合实时应用,因为较低的计算需求导致更快的推理时间。

两种量化技术的推理都支持在Llama Stack参考实现中通过PyTorch的ExecuTorch框架进行。此外,Meta AI还与行业领先的合作伙伴合作,使这些模型可以在配备Arm CPU的高通和联发科系统级芯片(SoC)上高效部署。这种合作确保了模型可以在包括流行移动平台在内的广泛设备上部署,进一步扩大了Llama 3.2的覆盖范围和影响力。

04 重要性和早期结果

量化Llama 3.2之所以重要,是因为它直接解决了与LLMs相关的可扩展性问题。通过在保持高性能的同时减少模型大小,Meta AI使这些模型更适合边缘计算环境,其中计算资源是有限的。早期的基准测试结果表明,量化Llama 3.2在关键NLP基准测试中的性能大约是完整Llama 3模型的95%,但内存使用减少了近60%。这种效率对于希望在不投资高端基础设施的情况下实施AI的企业和研究人员至关重要。此外,能够在普通硬件上部署这些模型也符合当前可持续AI的趋势,减少了训练和部署LLMs的环境影响。

05 结语

Meta AI发布量化Llama 3.2标志着高效AI模型发展的重要一步。通过专注于量化,Meta提供了一个平衡性能与可访问性的解决方案,使更广泛的受众能够从高级NLP能力中受益。这些量化模型解决了采用LLMs的关键障碍,如成本、能源消耗和基础设施要求。这项技术的更广泛影响可能导致对AI的更公平获取,促进了以前对小型企业和研究人员来说遥不可及的领域的创新。Meta AI推动高效AI建模的界限的努力突显了对可持续、包容性AI发展的日益重视——这一趋势肯定会塑造AI研究和应用的未来。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯

原文链接:https://mp.weixin.qq.com/s/ccIxhzciFXRFAV3O5RzrwA