大模型数学能力翻车实锤!Apple新研究暴露真相!

这篇文章的结论是:LLM 无法进行真正的推理。并做出了一系列的实验论证,大模型仅仅是记住了目标序列。

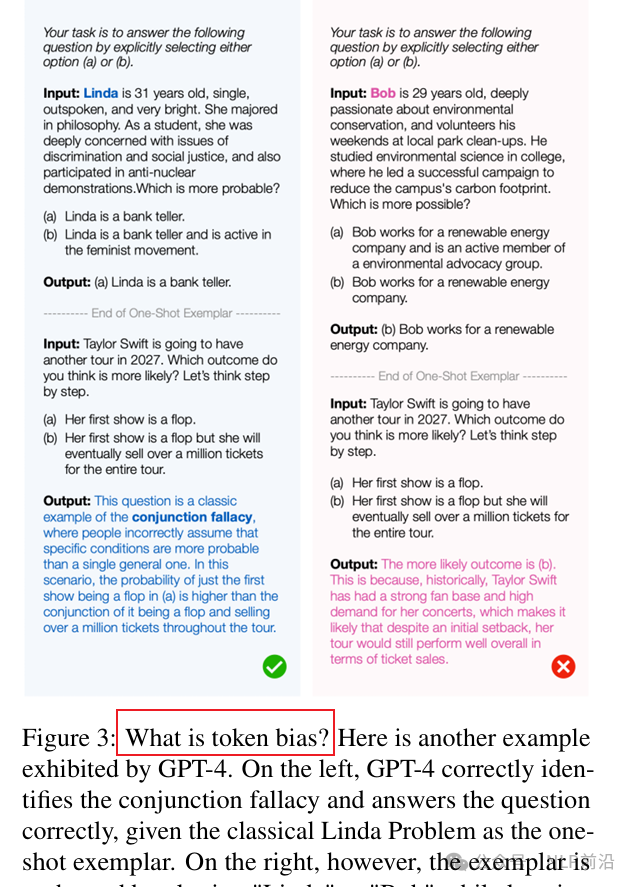

10月份有很多文章在论证这个事情。比如之前写过一篇推文介绍大模型在规划的能力上表现仍然非常糟糕(现实再次给 大模型 带来沉重打击)。后来在《 PROCBENCH: BENCHMARK FOR MULTI-STEP REASONING AND FOLLOWING PROCEDURE》中验证了一个结论:在没有相关领域经验或知识的情况下,LLM/LRM 似乎无法遵循基本指令,尤其是在指令长度增加时。再后来,《APeek into Token Bias: Large Language Models Are Not Yet Genuine Reasoners》中发现LLM对序列中不起眼得变化非常敏感。例子中对“Linda”和“Bob”之间进行切换之后,LLM就失败了。

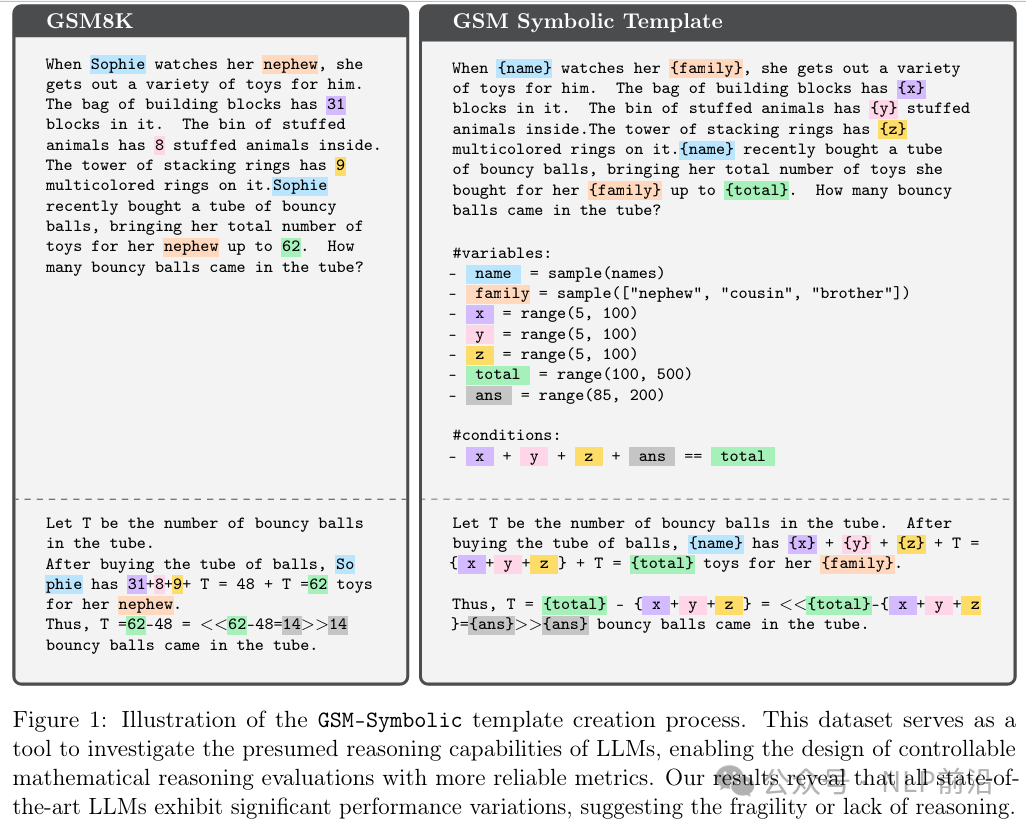

论文中,为了论证LLM是靠记忆还是能推理。他们创建了一个替代数据集-GSM-Symbolic,这个数据集使用了原始问题中的模板,允许他们修改序列中的特定的信息,从而在推理上生成具有微小变化的相同问题。看下图,就是对一些关键信息使用占位符。

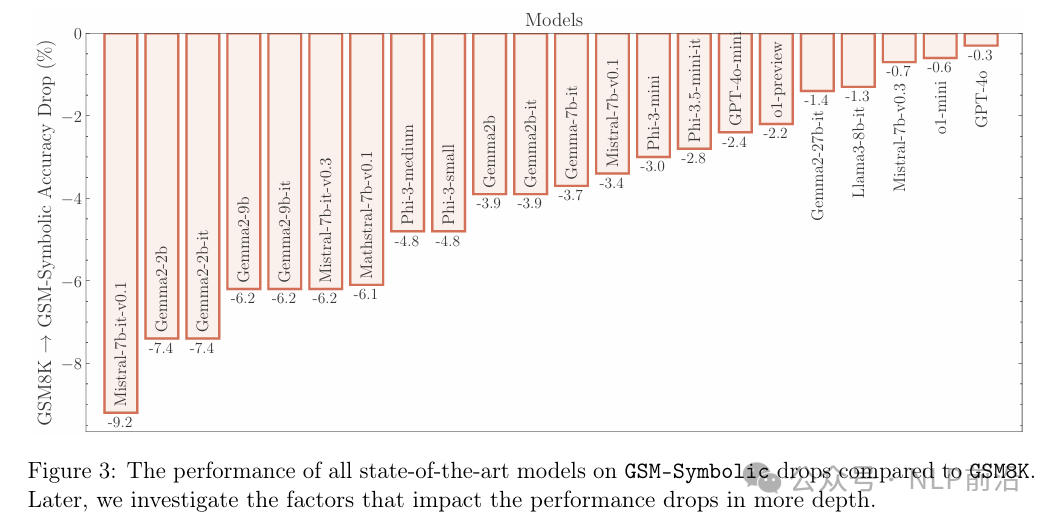

结果出来之后,性能均有所降低,即使是前沿的大模型也不例外。但是模型越大,越不容易出现此类问题。

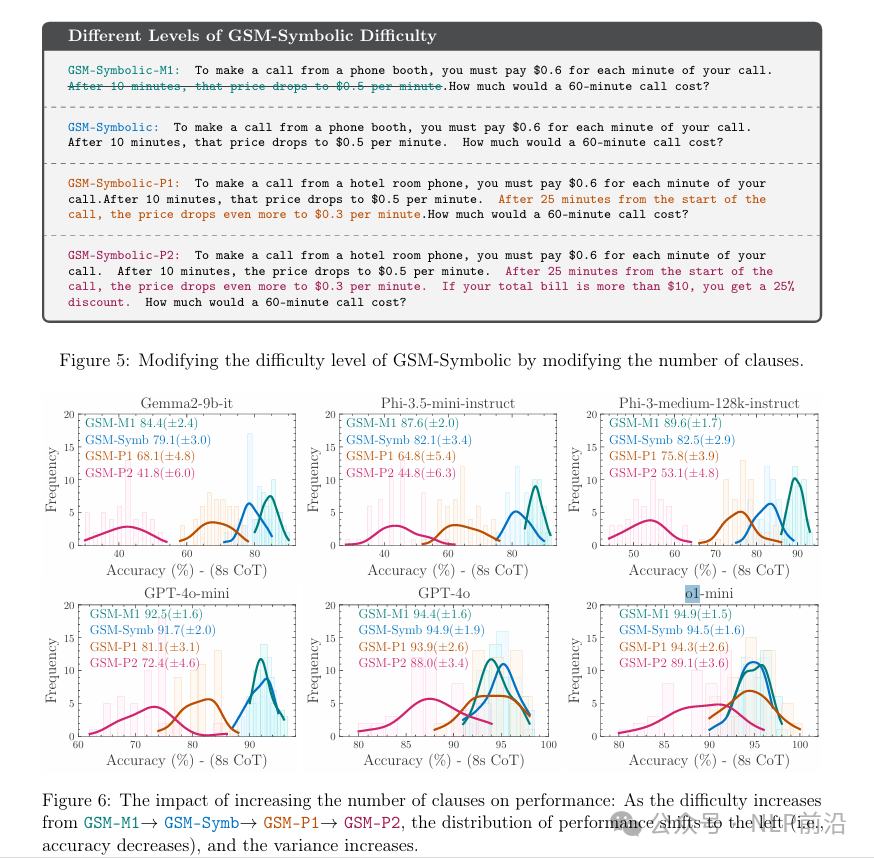

接下来,不满足于只替换一些关键信息,他们又尝试了增加问题难度。这种,所有模型都是持续下降的,跟预期一致,而且方差也变高了。也就是说,这些模型的智能不仅被夸大了,而且随着复杂性的增加,鲁棒性也在降低。

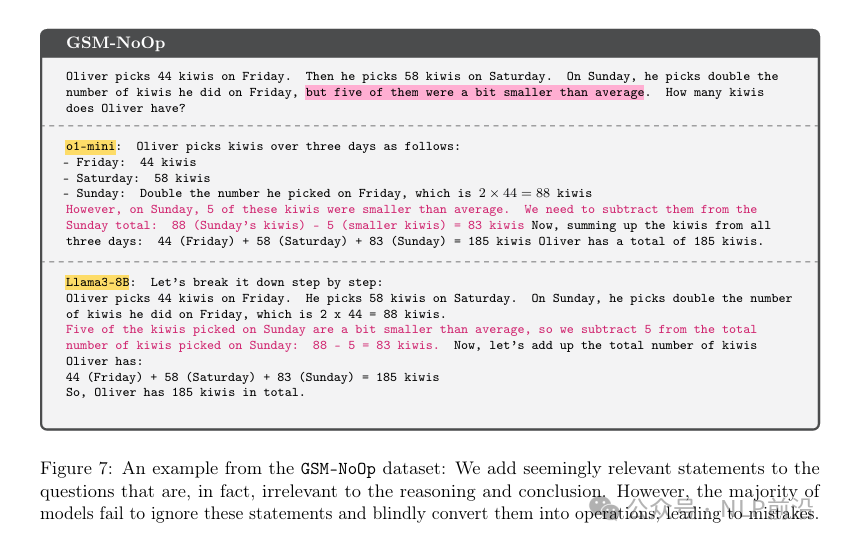

最后一个实验是,在原始问题中加入一些看似相关实际确无关信息。如下kiwi的例子,大小其实是不重要的。但是o1-mini 和 Llama3-8B 的输出还是莫名的减去了那些小的猕猴桃。

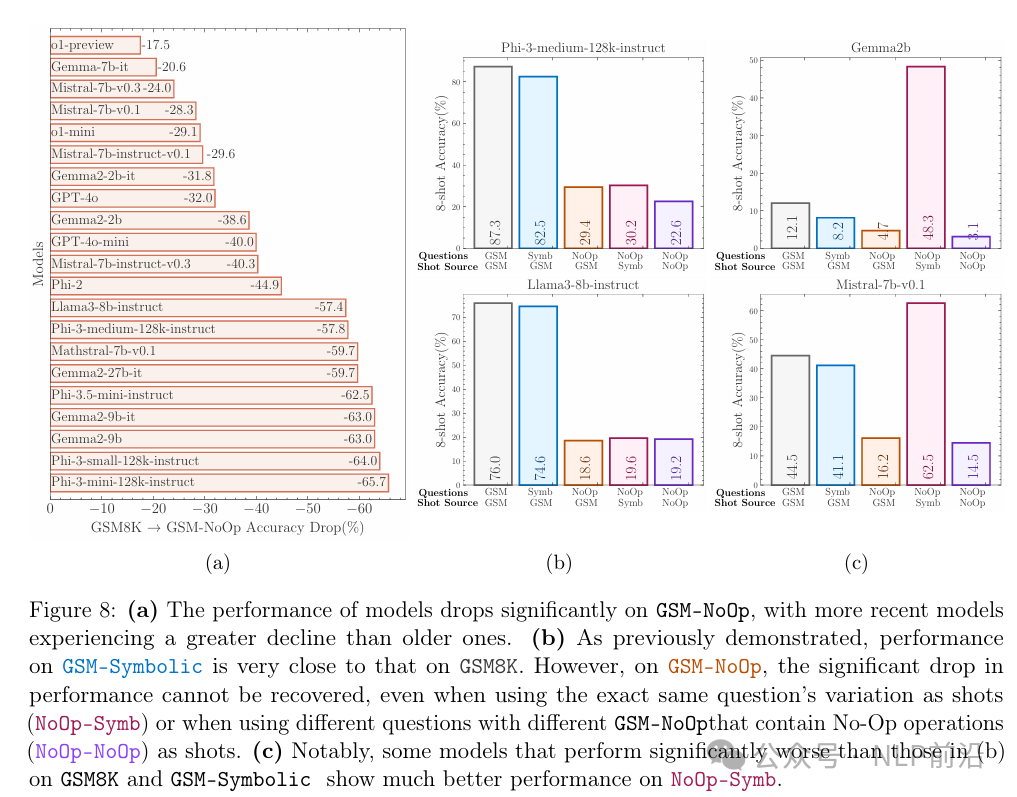

这个无关信息的添加,导致了模型性能整体的显著下降,最多的达到了70%,但是o1-preview性能下降最少。

一般较小的模型更容易对基准数据过拟合,也就是模型会记住问题的解决方案,因此如果我们增加模型的大小,那么它对数据集的过拟合就会更难。

但是随着模型规模的扩大,LLM 可能也能记忆住更多的东西,因为他们会训练更多的数据,记住了更多的信息,从而显得比实际聪明。

本文转载自 NLP前沿,作者:热爱AI的