一文彻底搞懂深度学习 - 神经网络(Neural network) 原创

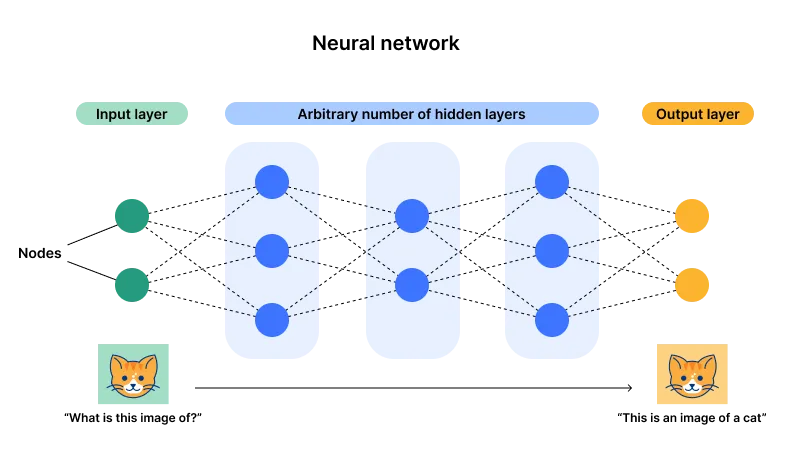

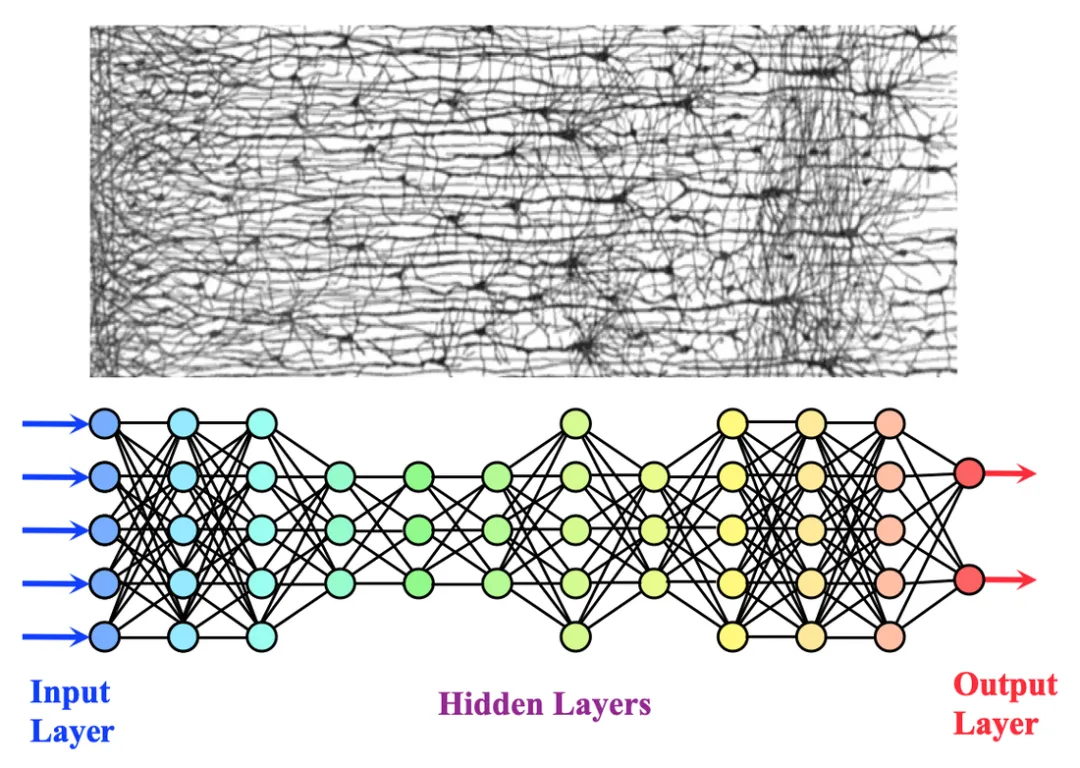

神经网络是一种受人脑启发的机器学习算法,它模仿大脑中神经元相互发出信号的方式。它由互连的节点或“神经元”组成,这些节点被组织成层。通过对输入进行加权、计算总和以及应用非线性激活函数,神经网络能够将输入数据转换为不同的表示形式,直到产生输出。

Neural network

一、神经网络

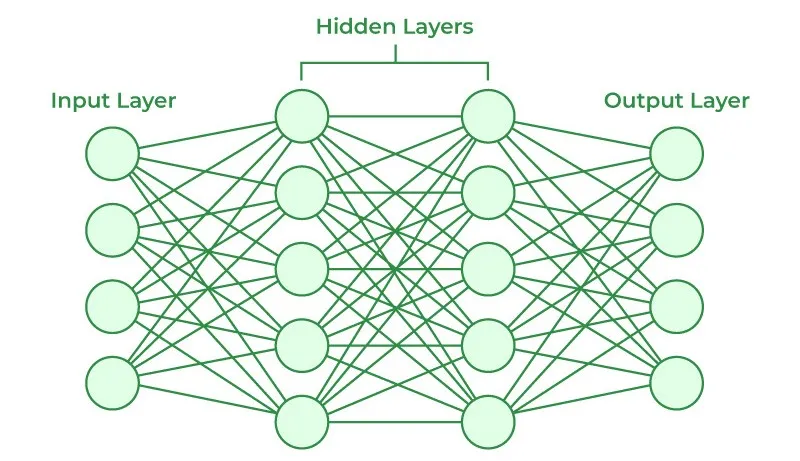

神经网络(Neural Network)是什么?神经网络是由大量的节点(“神经元”)相互连接而成的网络结构,这些节点在网络中相互连接,可以处理复杂的数据输入,执行各种任务,如分类、回归、模式识别等。

- 前馈神经网络(Feedforward Neural Network):数据在这种网络中单向流动,从输入层到输出层,没有反馈(即网络中没有循环)。

- 卷积神经网络(Convolutional Neural Network, CNN):特别适用于处理图像数据,通过卷积运算提取图像特征。

- 循环神经网络(Recurrent Neural Network, RNN):适用于处理序列数据,如时间序列分析、自然语言处理等。

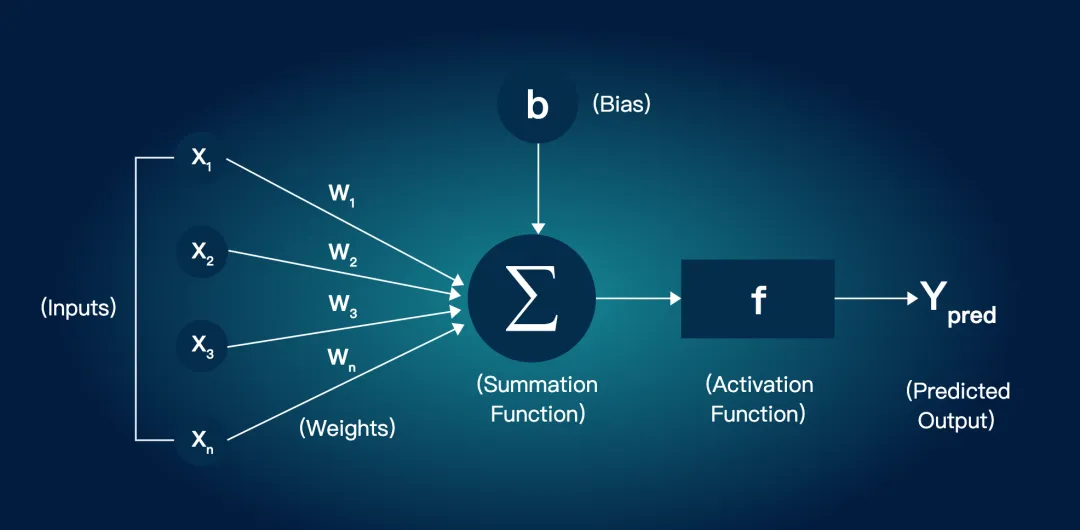

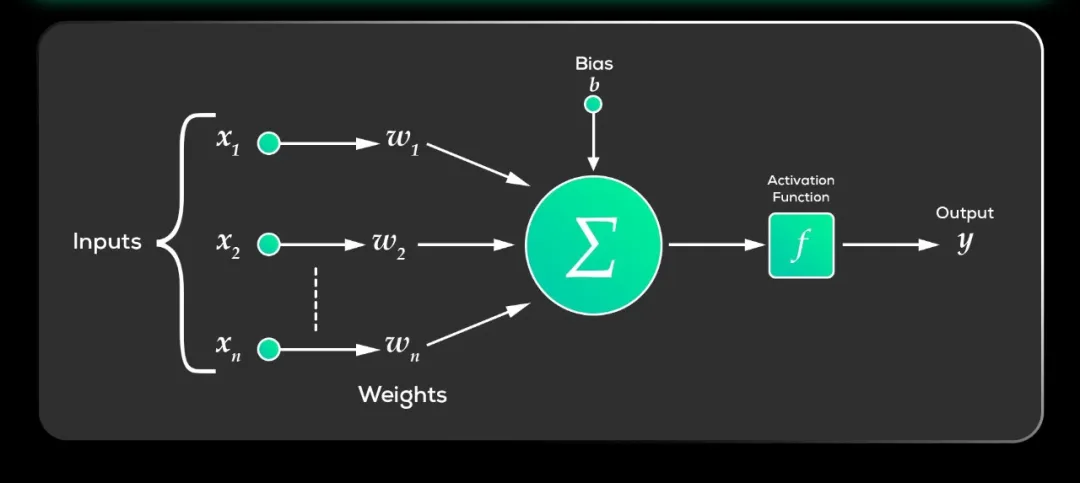

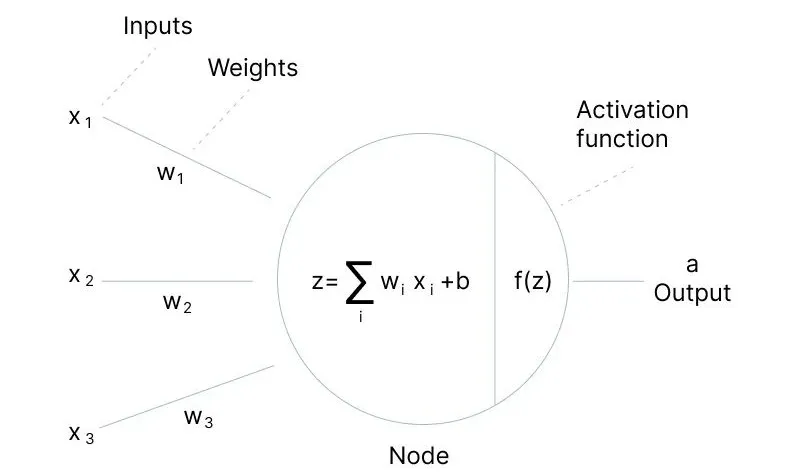

神经网络的工作原理是什么?模拟人脑神经系统的功能,通过多个节点(神经元)的连接和计算,实现非线性模型的组合和输出。每个节点接收来自前一层节点的输入,进行加权和,加上偏置,然后通过激活函数处理,输出到下一层。

- 节点(神经元):神经网络的基本单元,模拟生物神经元的功能。

- 层次:包括输入层、隐藏层和输出层。输入层负责接收输入数据,隐藏层位于输入层和输出层之间,进行数据的加工和转换,输出层输出最终的计算结果。

- 权重:连接不同神经元的参数,代表一个神经元输出对另一个神经元输出的影响力。在训练过程中,神经网络通过调整权重来学习数据中的模式。

- 偏置:加到加权和上的一个常数,可以看作是每个神经元的一个额外输入。偏置允许神经元即使在所有输入都为零时也有非零的输出。

- 激活函数:决定神经元是否应该被激活(即输出信号)的函数。常见的激活函数包括Sigmoid、ReLU等。

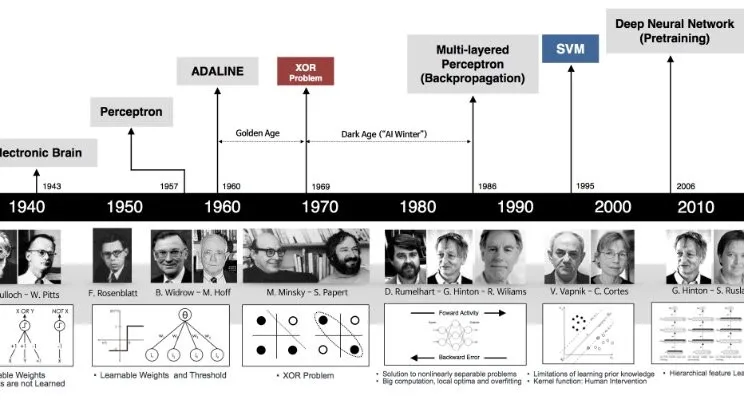

从感知机到神经网络:神经网络起源于20世纪40-50年代的MP模型和感知机,历经两次低谷与两次兴起。

- 起源:20世纪40-50年代,受生物神经元启发,MP模型提出,感知机诞生,为神经网络奠定基础。

- 第一次低谷:60-70年代,因感知机局限性及计算能力不足,神经网络研究陷入低谷。

- 第二次兴起:80年代,多层感知机(MLP)及反向传播算法出现,解决非线性问题,推动神经网络发展。

- 第二次低谷:90年代,因训练困难等问题,神经网络再次低谷。

- 深度学习兴起:21世纪10年代,硬件性能提升、大数据出现,深度学习兴起,卷积神经网络(CNN)、循环神经网络(RNN)等算法涌现,神经网络性能大幅提升。

二、激活函数

激活函数(Activation Function)是什么?激活函数是神经网络中神经元节点上的一种函数,用于将神经元的输入映射到输出。它决定了节点是否应该被激活(即,是否让信息通过该节点继续在网络中向后传播)。

在神经网络中,输入通过加权求和(权重(W)和偏置(b)),然后被一个函数作用,这个函数就是激活函数。

为什么神经网络需要激活函数?神经网络中的线性组合(即加权和)本身只能表示线性关系。然而,现实世界中的大多数问题都是非线性的。通过引入激活函数,神经网络能够学习并表示这些非线性关系,从而解决更复杂的问题。

本文转载自公众号架构师带你玩转AI 作者:AllenTang

原文链接:https://mp.weixin.qq.com/s/xlwTaPghPrP0gk_F4YbN5A