矛盾之争,AI合成数据可以骗过大模型吗?中山大学联合上海AI Lab提出合成检测基准LOKI

文章链接: https://arxiv.org/pdf/2410.09732

项目链接: https://opendatalab.github.io/LOKI/

数据&代码:https://github.com/opendatalab/LOKI

总结速览

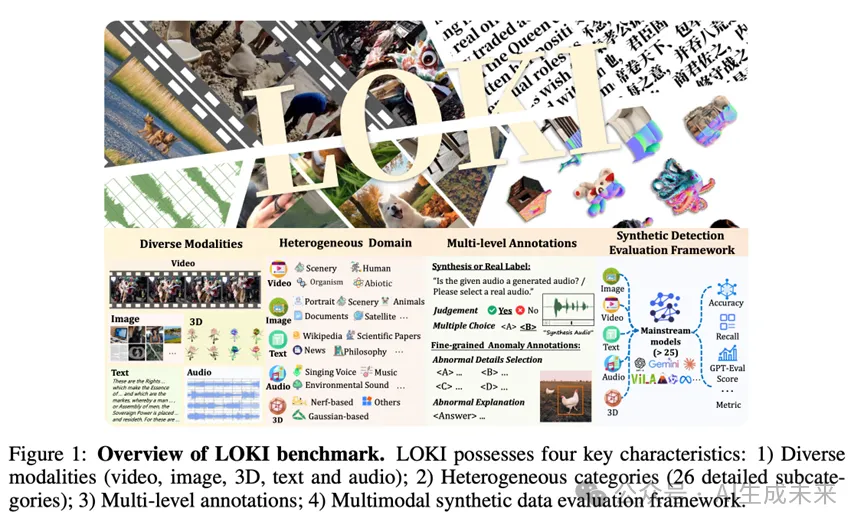

引入了LOKI基准,以全面评估LMMs在区分合成数据上的表现。LOKI基准的亮点包括:

- 全面模态评估。收集了近期热门合成模型生成的高质量多模态数据,涵盖视频,图像,3D数据,文本,音频等多个模态。

- 异构数据覆盖。数据集中包括28个不同模态的细致分类,包括有专业的卫星,医学等图像,哲学,文言文等文本作品,环境音,音乐等音频。

- 多层次标注。基准包括了生成/真实标签,可用于判断题,多选题等基础问题设置。还包含了细粒度异常注释,可用于原因解释等探究LMMs在可解释合成数据检测方面的题目。

- 多模态合成数据评测框架。我们提出了一种全面的多模态评测框架,支持目前主流多模态大模型使用多种数据格式输入,包括视频,图像,文本,音频,点云等。

评估结果

在 LOKI 基准测试中,评估了 22 个开源 LMMs、6个 闭源LMMs 和几个专家合成检测模型。

主要发现总结如下:

对于合成数据检测任务:

- LMM 在合成数据检测任务中表现出中等能力,具有一定程度的可解释性和泛化能力,但与人类表现相比仍然存在差距;

- 与专家合成检测模型相比,LMM 表现出更高的可解释性,并且与人类相比,可以检测到肉眼看不见的特征,显示出良好的发展前景。

对于LMMs能力:

- 大多数 LMM 表现出一定的模型偏差,倾向于在其响应中偏向合成或真实数据;

- LMM 缺乏专业领域知识,在卫星和医学图像等专业图像类型上表现不佳;

- 当前的 LMM 表现出不平衡的多模态能力,在图像和文本任务中表现出色,但在 3D 和音频任务中表现不佳;

- 思路链提示增强了 LMM 在合成数据检测中的表现,而简单的少量提示无法提供必要的推理支持。

动机

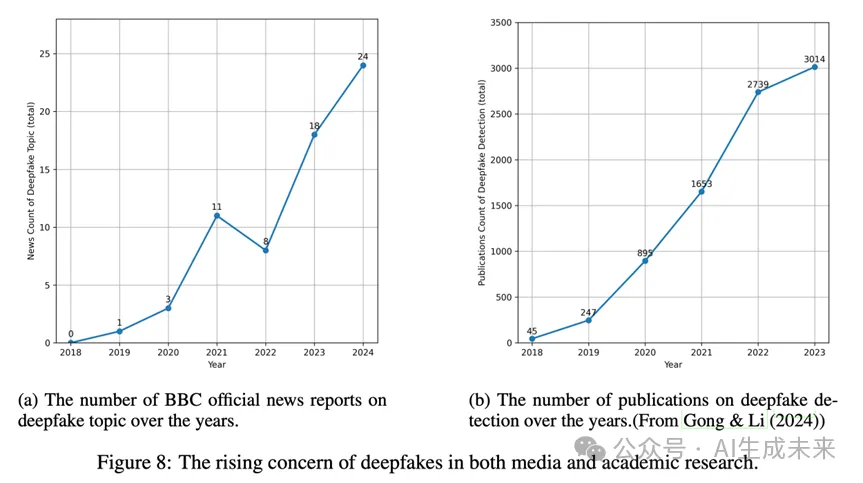

随着扩散模型和大型语言模型(LLM)的快速发展,人工智能生成内容 (AIGC) 技术合成多模态数据已越来越多地将融入我们的日常生活。例如,SORA可以制作高度逼真的视频,Suno可以创作出与专业艺术家相当水平的音乐。然而,合成多模态数据也带来了重大风险,包括潜在的滥用和社会风险,包括使用LLM生成虚假新闻、使用扩散模型合成人脸以进行诈骗,以及互联网训练数据的潜在污染风险。由于人工智能综合的便利性,未来的互联网可能会充斥着人工智能生成的内容,使得辨别多模态数据的真实性和可信度的任务变得越来越具有挑战性。

为了应对此类威胁,合成数据检测领域近年来引起了广泛关注。然而,目前大多数合成数据检测方法主要侧重于真实性评估,对预测结果的人为可解释性存在一定的局限。多模态大模型 (LMMs) 近年来的快速发展引发了人们对其在检测合成多模态数据方面性能的好奇。一方面,对于合成数据检测任务,LMMs 可以用自然语言提供真实性判断背后的推理,为增强可解释性铺平了道路。另一方面,区分真实数据和合成数据的任务涉及多模态数据的感知、知识和推理能力,本身就是对 LMM 能力的良好测试。因此,本文的重点是评估 LMM 在合成数据检测任务中的性能。

LOKI基准构建

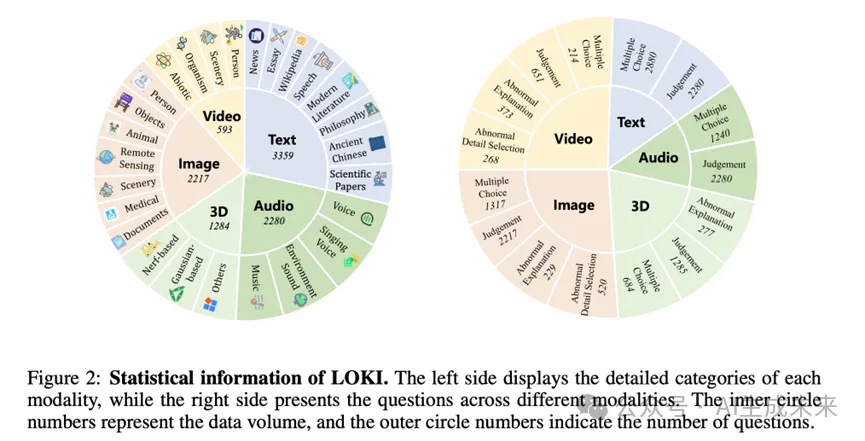

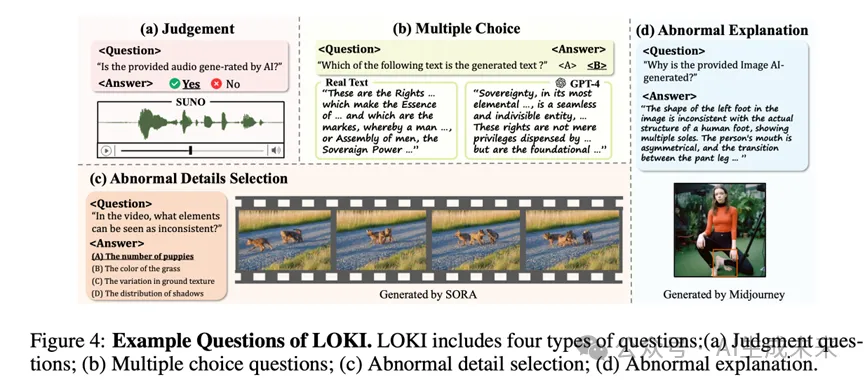

多模态合成数据检测基准LOKI,专门用于全面评估 LMM 检测合成数据的能力。如下图所示,LOKI 涵盖了多种模态,包括视频、图像、3D、文本和音频,拥有超过 26 个特定的数据子类别。该基准利用细粒度异常注释来构建各种分层的问题类型,包括判断问题、多项选择题、异常细节选择和异常解释问题,总计超过 18,000 个问题。

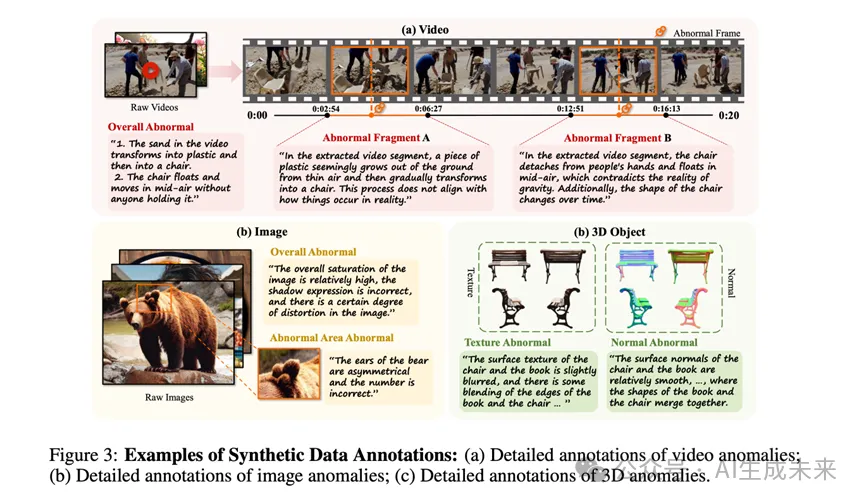

视频: 收集了SORA、Keling、Open_sora等闭源和开源模型收集了500+高质量文本生成片段及其对应的真实领域样本数据。对于 AI 生成的视频片段,使用 LabelU工具来注释异常细节,包括异常片段及其描述、异常关键帧和全局异常描述。如下图所示,视频中的“违反自然物理”和“帧闪烁”等异常也得到了全局注释。此外,还突出显示了从 02:54 到 06:27 的异常片段,并由人类注释者解释了相应的异常原因。此外,每个异常片段都包含一个异常关键帧,以便后续的 LMM 在处理视频数据时准确读取异常帧。

图像:通过现有数据集提取、互联网收集和新合成等方式,收集了来自 7 个子类别的 2,200 多幅图像。图像合成方法包括 FLUX、Midjourney、Stable Diffusion等,以确保数据的高质量和多样性。对于合成的图像数据,除了整体注释外,我们还执行了异常区域标记和解释,区域异常注释允许更细粒度和更具体的标记,可用于生成后续的异常细节问题。

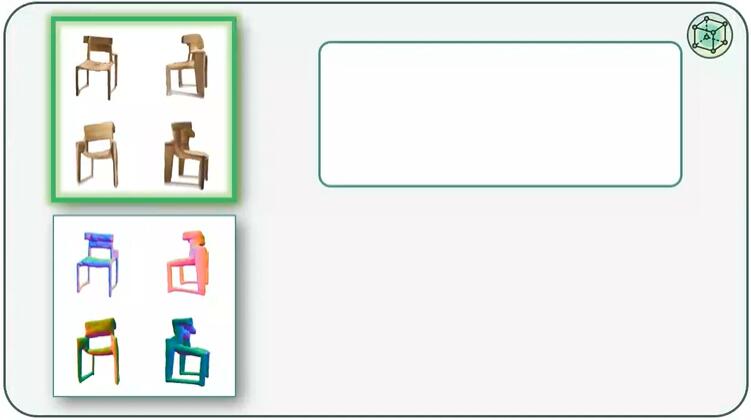

3D:基于OmniObject3D进行了全面分析,选择同一域内的扫描实例作为地面实况。通过构建提示文本,合成了三个 Nerf 模型和三个 3D GS 模型,并使用来自高级商业模型 Clay 的结果和来自 GPTEval3D 的一些基于 Nerf 的结果对其进行了补充。我们总共收集了来自十种不同合成方法的 1,200 多个 3D 模型,包括合成数据和真实扫描数据。此外,我们对合成的 3D 数据的 RGB 四个视图执行了纹理异常描述注释,以及正常异常描述注释。

音频:收集了各种类别的音频,包括语音、歌声、环境声音和音乐。语音和歌声数据确保了说话者音色的一致性,来源于ASVSpoof2019和CtrSVDD Benchmark,涵盖四个生成范式:TTS、VC、SVS 和 SVC。环境音频数据来自 DCASE 2023 Task 7,其中真实音频来自开发集,合成音频使用多种方法从 Track A 生成。音乐数据来源于MusicCaps,合成音乐根据描述使用MusicGen、AudioLDM2-Music和 Suno生成。

文本:基于主流LLM模型(如 GPT-4、Qwen-Max、Llama 3.1-405B),使用总结再生方法生成了与原文相似的伪造文本。我们收集了八类文本数据,每个样本与一段真实文本和一段模型生成的相似文本配对,共计 3,359篇文本。我们的文本数据按长度和语言分类,包括短文本(50-100 字)、中文本(100-200 字)和长文本(200 字以上),中文和英文数据比例为 1:1。

题目概览

判断题: 此任务需要大型语言模型 (LMM) 来确定输入数据是合成的还是真实的。例如“提供的音频是由 AI 生成的吗?”

多选题:

异常细节选择: 基于来自视频、图像和 3D 等模态的细粒度异常注释数据,有效地设计提示并利用 GPT-4o 生成异常细节选择问题。例如,于视频内容的细节异常,提问“哪些元素可以是不连续的?”

异常解释:要求 LMM 独立识别异常并解释其原因。例如,提问“为什么提供的图像是 AI 生成的?”

LMMs评估结果

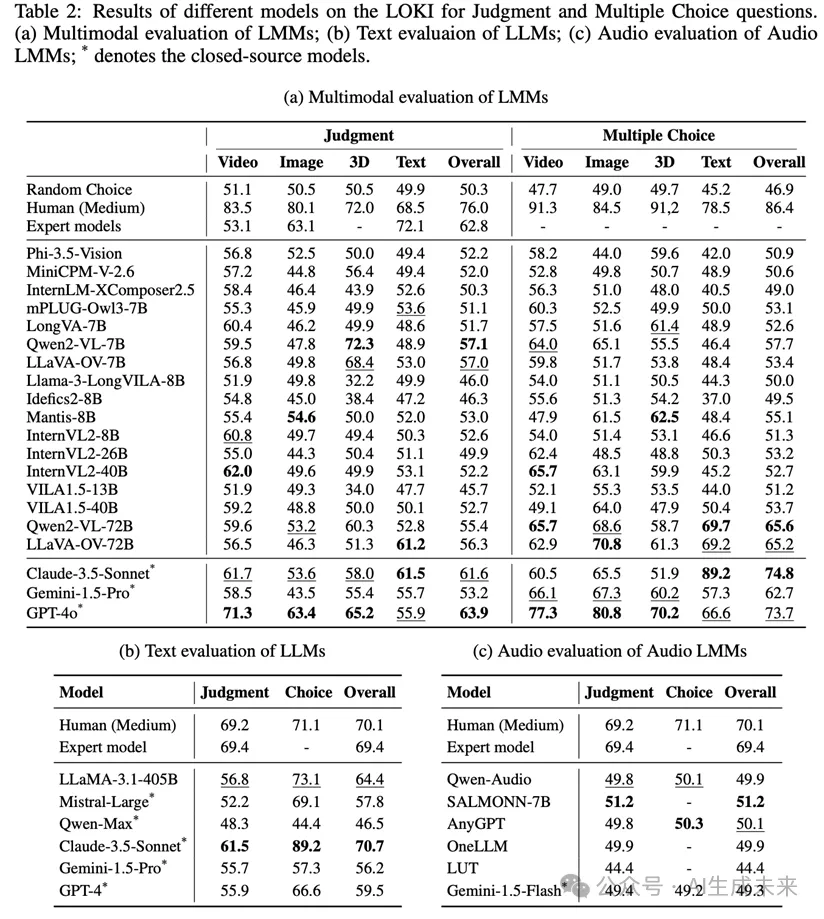

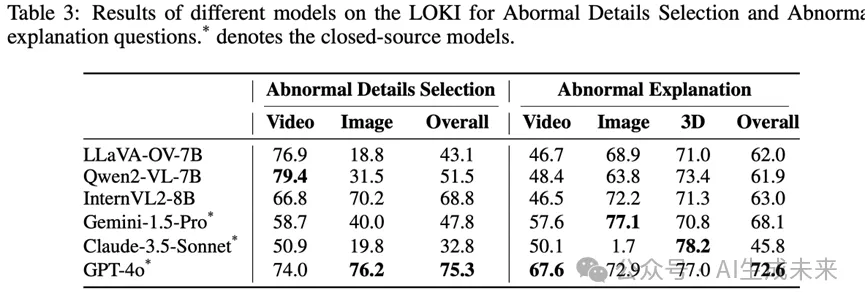

下表展示了 LOKI 中各种模型在判断和多项选择题上的表现。对于合成数据判断任务,闭源模型 GPT-4o 取得了最好的结果,总体准确率(不包括音频)为 63.9%。当在多项选择题中加入真实配对数据进行比较时,准确率进一步提高到 73.7%。在文本模态中,Claude-3.5 的表现优于其他 LMM 和 LLM,准确率超过 70%。在音频 LMM 类别中,开源和闭源模型都表现出与随机选择相当的性能。对比不同模型在异常细节选择和异常原因解释任务上的表现。GPT-4o 在异常细节选择中的准确率超过 75%,在异常原因解释中的得分超过 70%。这表明像 GPT-4o 这样的高级 LMM 已经展示了强大的细节理解能力,有效地分析和解释“合成痕迹”。

人类在判断任务中的平均表现为 76%,在多项选择题中的平均表现为 86.4%,均比 LMM 方法高 10%。值得注意的是,如果 LMM 工具要应用于生产,其在判断任务中的决策性能必须超过 90% 才能令人信服。随着合成技术的进步,合成数据的明显“痕迹”变得越来越微妙。然而,LMM 可以捕捉到微小的细节,例如人眼无法察觉的图像特征,显示出超越人类的潜力。同时LMM 在大多数任务中都表现出优于专家模型的性能。这主要是因为 LOKI 收集的合成数据来源丰富多样,与现有数据域存在显著差异,导致专家模型的泛化性能不佳。使用类似数据训练的专家模型进行合成检测的准确率应该会显著提高。目前,LMM 在合成数据检测中表现中等,但在泛化能力上超越专家模型。与传统专家模型不同,LMM 具有解释异常背后原因的能力,凸显了其作为合成检测器的独特优势。

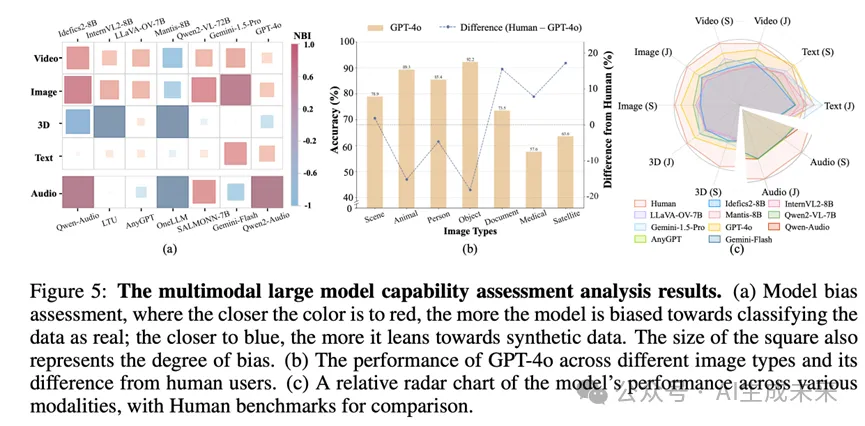

模型偏差。 LOKI基于召回率计算的归一化偏差指数热图用于分析模型偏差。结果表明,大多数模型在合成数据检测任务中表现出显著的偏差,倾向于将数据错误地归类为真实或合成。例如,GPT-4o 倾向于将文本数据归类为真实,而倾向于将 3D 数据判断为 AI 生成的。尽管实施了多种提问技巧来最大限度地减少提示效应,但大多数模型仍然存在明显的偏差。

专家领域知识匮乏。 LOKI展示了 GPT-4o 在不同图像子类别中的不同性能。实验结果清楚地表明,GPT 对物体和风景等常见图像类型表现出强大的识别能力,甚至超越了人类用户。然而,GPT-4o 在卫星和医学成像等专业领域以及文档等较少训练的图像类型上的表现显著下降。这表明当前的 LMM 仍然缺乏某些专家领域知识。

多模态能力不均衡。 通过比较各种 LMM 在不同模态下的性能。结果表明,目前的模型在图像和文本等经常训练的模态上表现出色,甚至在某些测试中超越了人类的表现。然而,它们在 3D 和音频任务上的性能显著下降,大多数开源模型缺乏相应的能力。未来的 AGI 要发展成为一个多功能的助手,需要具备更均衡的多模态能力。

结论

本文介绍了 LOKI,旨在评估大型多模态模型在检测各种模态合成数据方面的性能。对 LMM 在视频、图像、3D、音频、文本和专门子域上的性能进行了全面研究,还分析了 LMM 解释合成数据中详细异常的能力。实验结果表明,LMM 在检测合成数据方面具有一定的能力,并具有初步的解释异常的能力。合成数据检测任务还有效地评估了 LMM 在开发过程中的各种能力。这些发现突出了 LOKI 任务的挑战性和综合性,以及 LMM 在未来合成数据检测任务中的潜力。我们旨在通过 LOKI 激发更强大、更可解释的合成数据检测方法,以应对快速发展的 AI 合成技术带来的潜在风险。此外,合成和检测之间的关系是对抗发展的,但它们是互惠互利的;更好、更可解释的合成检测器将进一步推动 AI 合成技术的发展。

本文转自 AI生成未来 ,作者:AI生成未来