“左脚踩右脚”提升文生图模型综合能力!清北牛津普林斯顿联合发布IterComp 精华

文章链接:https://arxiv.org/pdf/2410.07171

项目链接:https://github.com/YangLing0818/IterComp

亮点直击

- 提出了第一个基于奖励控制的迭代组合感知框架IterComp,以全面提升基础扩散模型的组合性。

- 精心挑选了模型库,并开发了一个高质量的组合感知模型偏好数据集,该数据集包含大量图像排序对。

- 使用了新的迭代反馈学习框架,逐步增强奖励模型和基础扩散模型。

- 与之前的SOTA方法进行的大量定性和定量比较表明,本文的方法在组合生成能力上具有显著优势。

总结速览

解决的问题

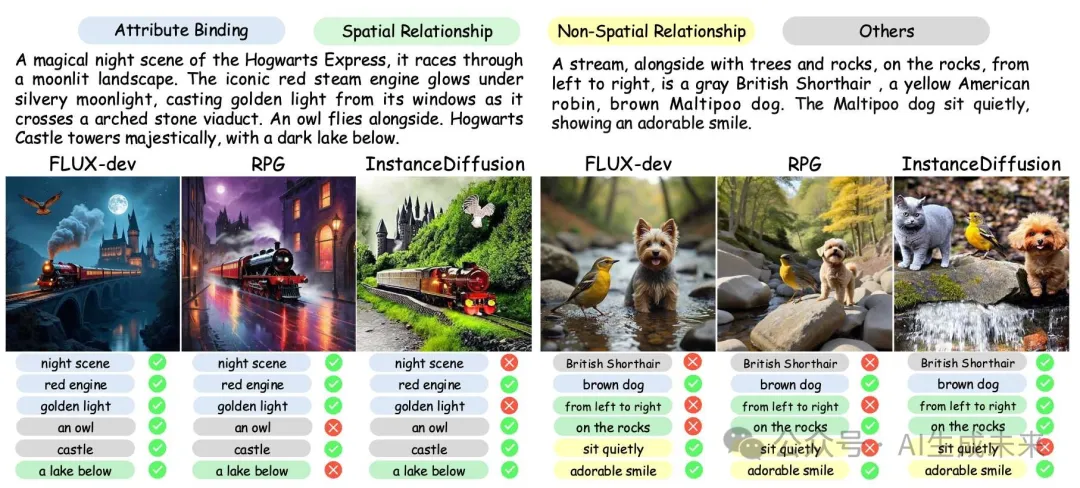

现有的扩散模型(如RPG、Stable Diffusion 3 和 FLUX)在生成组合性图像时各有所长,有的擅长属性绑定,有的则在空间关系上表现更好。然而,这些模型无法全面解决组合性生成的多方面需求,缺乏一种能够综合各模型优势的方法。

总之,要解决以下两个问题:

1. 如何提取不同模型在各自领域的优势,并引导模型进行有效学习?

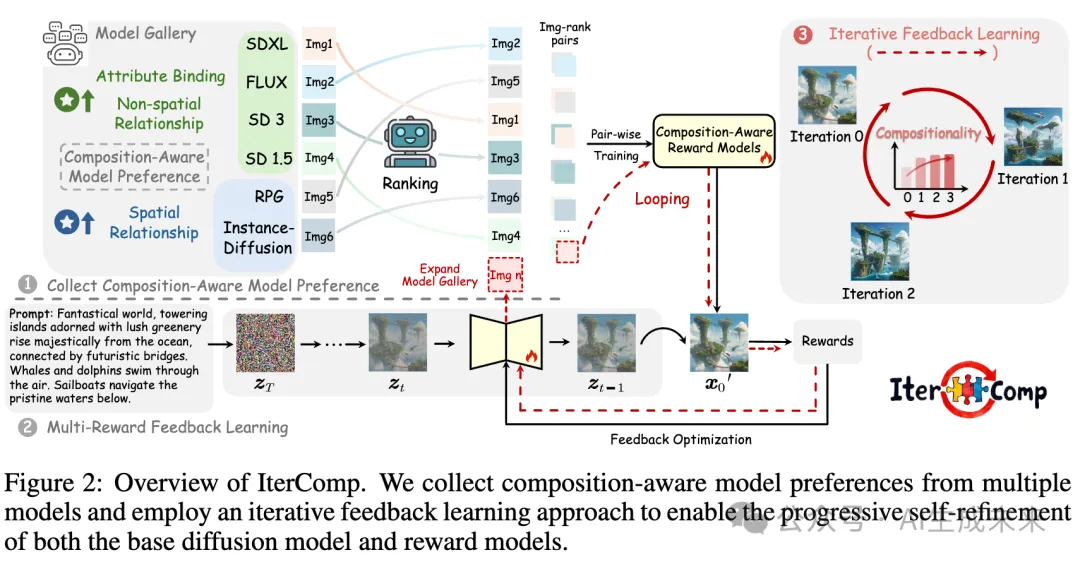

针对该问题,我们首先构建了模型库(model gallery),其包含多种在不同方面表现出色的模型,每个模型都具备特定的组合生成偏好(composition-aware model preference)。我们尝试通过扩散模型对齐方法,将base diffusion model与模型库中的组合生成偏好进行对齐。

我们聚焦于compositional generation的三个关键方面:属性绑定(attribute binding)、空间关系(spatial relationship)和非空间关系(non-spatial relationship)。为此,我们收集了不同模型在这些方面的偏好数据,并通过人工排序,构建了一个面向组合生成的模型偏好数据集(composition-aware model preference dataset)。针对这三个方面,我们分别训练三个composition-aware reward models,并对base模型进行多奖励反馈优化。

2. 组合生成任务很难优化,如何更充分地学习到不同模型的组合偏好?

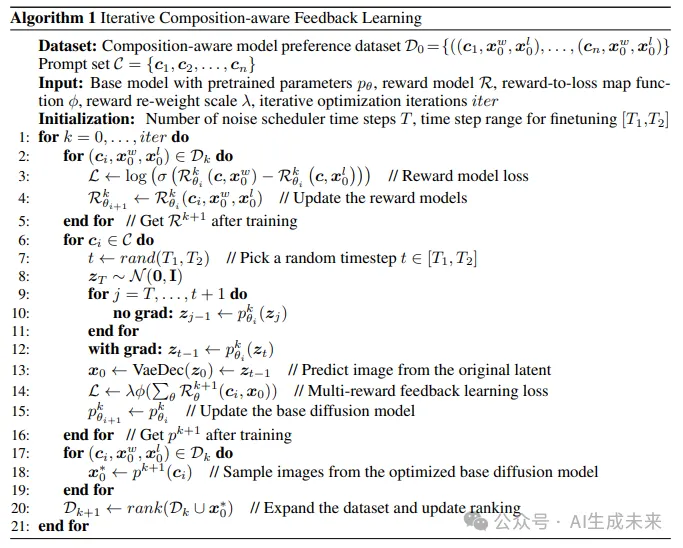

我们在diffusion领域创新地引入迭代式学习框架(iterative feedback learning),实现reward models与base diffusion model之间“左脚踩右脚登天”。

具体地,在上述第一轮优化后,我们将optimized base diffusion model以及额外选择的其他模型(例如Omost等)添加进model gallery。对新增模型进行偏好采样,与初始model gallery中的图像按照预训练的reward model构建图像对。这些图像对被用于进一步优化奖励模型,随后继续用更新的奖励模型优化基础扩散模型。具体的流程如下伪代码所示:

提出的方案

本文提出了一个名为IterComp的框架,通过聚合多个模型在组合生成任务中的偏好,利用迭代反馈学习方法,逐步优化组合性生成能力。该框架构建了一个由六个强大的开源扩散模型组成的模型库,并基于三项关键组合性指标(属性绑定、空间关系、非空间关系)评估这些模型。随后,通过图像排序对的数据集训练组合偏好奖励模型,并在封闭循环中使用迭代反馈学习方法逐步优化基础模型和奖励模型的组合性生成能力。

应用的技术

- 多模型组合偏好聚合

- 迭代反馈学习方法

- 奖励模型训练

- 组合性生成指标评估(属性绑定、空间关系、非空间关系)

达到的效果

理论证明了IterComp的有效性,实验结果表明,与现有的SOTA方法(如Omost和FLUX)相比,IterComp在多类别对象组合和复杂语义对齐方面表现出明显的优势,显著提高了组合性生成的效果。

动机

自2022年以来,基于diffusion的文生图模型取得了快速的发展,尤其在复杂组合生成(complex/compositional generation)任务上取得了显著进展。例如,今年8月发布的FLUX展现出了十分震撼的复杂场景生成能力与美学质量;RPG通过MLLM的辅助,将复杂的组合生成任务分解为简单子任务;InstanceDiffusion通过布局控制(layout-based),实现了与布局分布高度一致的精确图像生成。

然而,我们发现这些模型的优势仅限于某些特定的组合生成任务,且存在诸多局限。基于文本(text-based)的生成方法(如SDXL、SD3、FLUX等)由于其训练数据和框架的优势,在物体与场景的模拟上表现出色,特别在美学质量、属性绑定和非空间关系(non-spatial relationships)方面表现出色。然而,当涉及多个物体,且存在复杂的空间关系时,这类模型往往表现出明显的不足。

基于大语言模型(LLM-based)的生成方法,如Omost和RPG,通常需要对LLM进行额外训练或设计复杂的提示提示。然而,对于LLM处理后的复杂指令,diffusion backbone并不具备复杂指令下精确生成的能力。基于布局(layout-based)的生成方法,如Instancediffusion和LMD+,虽然提供了精确的控制,但在图像的美学质量和真实性上存在明显下降,并且需要人为设计布局。

因此,一个值得深入探讨的问题是:我们能否设计出一个强大的模型,在上述多个方面都表现出色,同时不引入额外的复杂指令或增加计算开销?

基于此,我们提出一个全新的文生图框架:IterComp。

方法

本节介绍了方法IterComp,它从模型库中收集组合感知的模型偏好,并利用迭代反馈学习来增强基础扩散模型在组合生成中的综合能力。下图2展示了IterComp的概览。首先介绍了从模型库中收集组合感知模型偏好数据集的方法。再描述了组合感知奖励模型的训练过程及多奖励反馈学习。然后提出了迭代反馈学习框架,以实现基础扩散模型和奖励模型的自我优化,逐步提升组合生成能力。

收集组合性的人类偏好

组合性指标与模型库

专注于组合性的三个关键方面:属性绑定、空间关系和非空间关系,以收集组合感知的模型偏好。初步选择了六个在不同组合生成方面表现突出的开源模型作为我们的模型库:FLUX-dev、Stable Diffusion 3、SDXL、Stable Diffusion 1.5、RPG、InstanceDiffusion。

属性绑定的人工排名

对于属性绑定,我们从T2I-CompBench的颜色、形状和纹理类别中随机选择了500个提示。三位专业专家对六个模型为每个提示生成的图像进行了排名,并通过加权得出了最终结果。主要标准是生成的图像是否准确反映了提示中提到的属性,尤其是属性是否正确绑定到相应的对象上。

复杂关系的人工排名

对于空间和非空间关系,从T2I-CompBench中为每个类别选择了1,000个提示,并使用相同的人工注释方法来获得排名。对于空间关系,主要排名标准是对象是否被正确生成以及它们的空间位置是否与提示匹配。对于非空间关系,重点是对象是否展示了自然和逼真的动作。

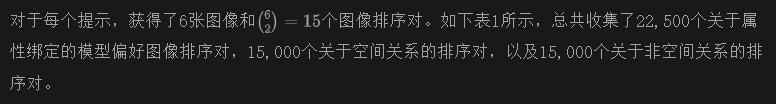

组合感知模型偏好数据集分析

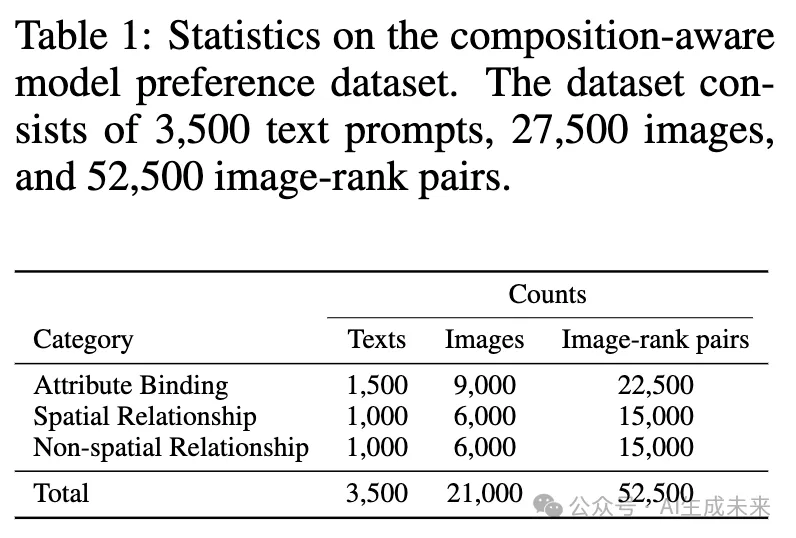

在下图3中可视化了每个模型生成的图像中排名第一的比例。结果表明,不同模型在组合生成的各个方面表现出不同的优势,该数据集有效地捕捉了多样的组合感知模型偏好。

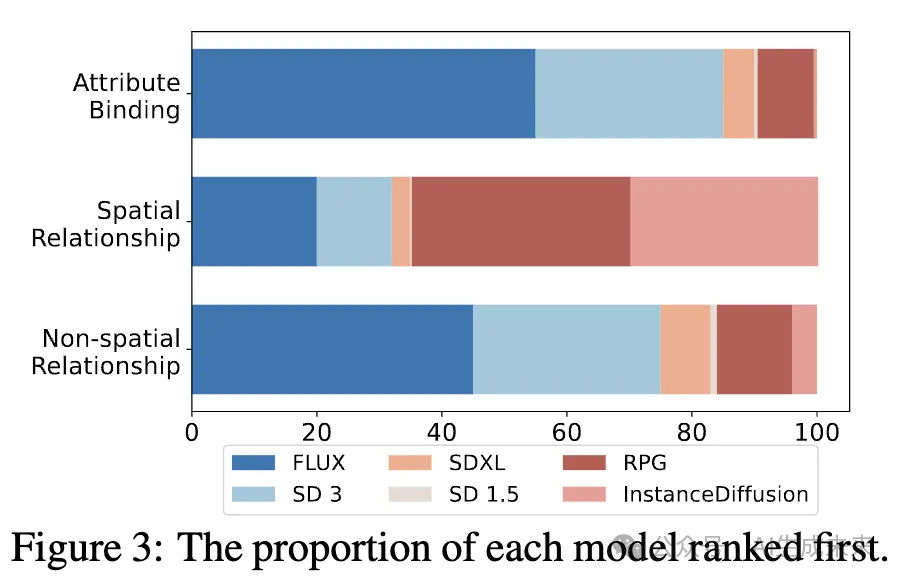

组合感知的多奖励反馈学习

组合感知奖励模型训练

为了在组合生成中实现全面的提升,我们利用3.1节中描述的三类组合感知数据集,将组合性分解为三个子任务,并为每个子任务训练一个特定的奖励模型。

多奖励反馈学习

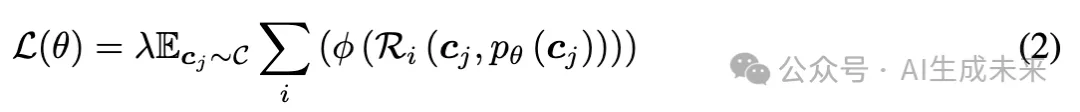

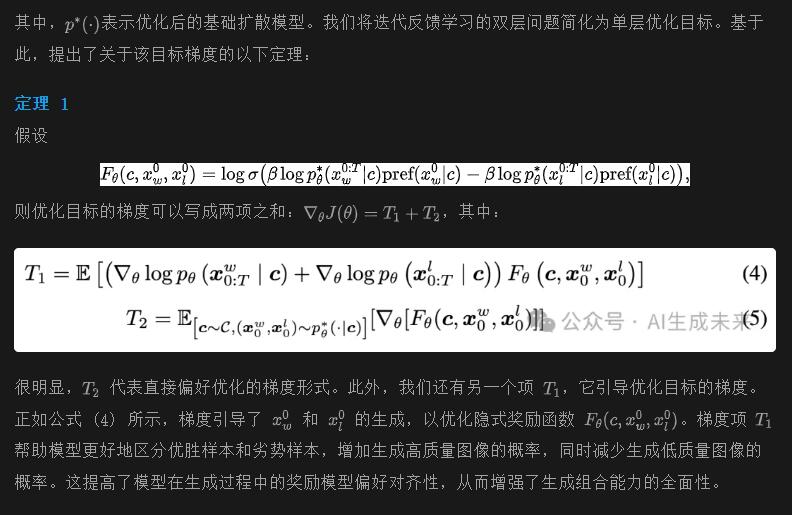

由于扩散模型中的多步去噪过程,无法为其生成结果提供概率,因此在语言模型中使用的RLHF方法不适用于扩散模型。一些现有的方法通过将奖励模型的分数视为人类偏好损失,直接微调扩散模型。为了使用多个组合感知奖励模型优化基础扩散模型,我们设计了以下损失函数:

组合感知反馈学习的迭代优化

组合生成因其复杂性和多方面特征而难以优化,这需要我们的奖励模型和基础扩散模型在复杂文本理解以及复杂关系生成等方面表现出色。为了确保更彻底的优化,我们提出了一个迭代反馈学习框架,逐步优化奖励模型和基础扩散模型。

迭代反馈学习的有效性

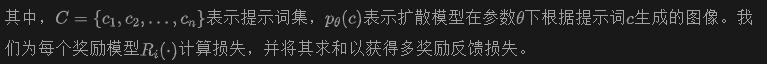

通过这个迭代反馈学习框架,奖励模型在理解复杂的组合提示词方面变得更加有效,并为基础扩散模型的组合生成提供了更全面的指导。迭代反馈学习过程的优化目标在以下引理中形式化:

引理 1

迭代反馈学习的统一优化框架可以表述为:

优于 Diffusion-DPO 和 ImageReward

在此,我们阐明 IterComp 相较于 Diffusion-DPO 和 ImageReward 的一些优势。首先,IterComp 专注于组合感知的奖励,旨在优化文本到图像 (T2I) 模型,使其能够应对复杂的生成场景,并构建了一个强大的模型库来收集多个组合感知的模型偏好。其次,我们创新的迭代反馈学习框架能够有效实现基础扩散模型和奖励模型在多个迭代中的渐进自我优化。

实验

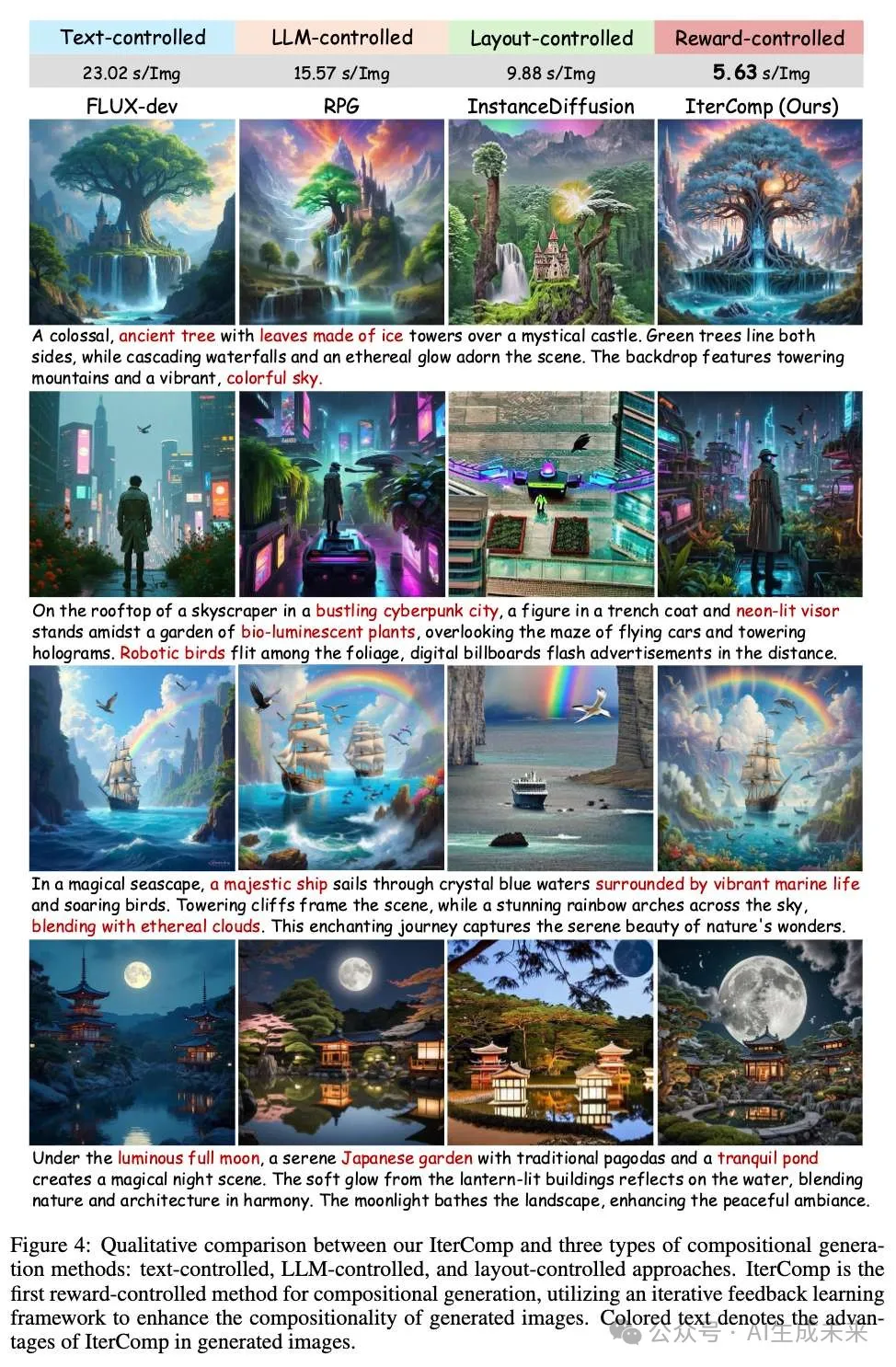

实验设置

数据集和训练设置

基线模型

研究者们策划了一个包含六个开源模型的模型库,每个模型在组合生成的不同方面表现优异:FLUX、Stable Diffusion 3、SDXL、Stable Diffusion 1.5、RPG 和 InstanceDiffusion。为了确保基础扩散模型能够充分、全面地学习组合感知模型偏好,我们通过在每次迭代中引入新模型(如 Omost 、Stable Cascade 、PixArt-α)来逐步扩展模型库。为了在组合生成性能上进行比较,我们选择了几种最先进的方法,包括 FLUX、SDXL 和 RPG 与我们的方法进行比较。我们使用 GPT-4o 进行 LLM 控制的方法,并根据提示推断布局以实现布局控制的方法。

主要结果

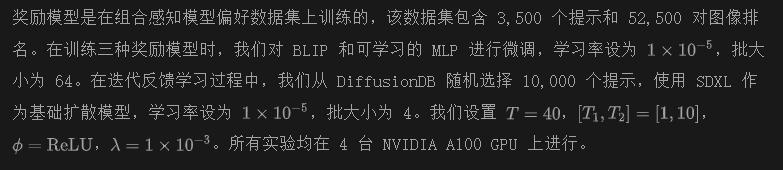

定性比较

如下图 4 所示,IterComp 在组合生成结果上优于三种主要类型的组合生成方法:文本控制、LLM 控制和布局控制的方法。与文本控制方法 FLUX相比,IterComp 在处理空间关系方面表现出色,显著减少了诸如物体遗漏和数量及位置不准确等错误。与 LLM 控制方法 RPG 相比,IterComp 产生了更合理的物体放置,避免了 LLM 幻觉造成的不切实际的定位。与布局控制方法 InstanceDiffusion 相比,IterComp 在语义美学和组合性方面明显占优势,特别是在复杂提示下的生成表现更佳。

定量比较

在 T2I-CompBench 上将 IterComp 与之前出色的组合文本/布局到图像模型进行了比较,涵盖六个关键组合场景。如表 2 所示,IterComp 在所有评估任务中表现出色。布局控制的方法,如 LMD+ 和 InstanceDiffusion ,在生成准确的空间关系方面表现优异,而文本到图像模型,如 SDXL 和 GenTron,在属性绑定和非空间关系上具有特别优势。相比之下,IterComp 在组合生成方面实现了全面的改进。它通过收集组合感知模型偏好,整合了各种模型的优点,并采用了新颖的迭代反馈学习方法,以闭环的方式实现基础扩散模型和奖励模型的自我优化。IterComp 在提高生成图像的真实感和美学的同时,实现了高水平的组合性。

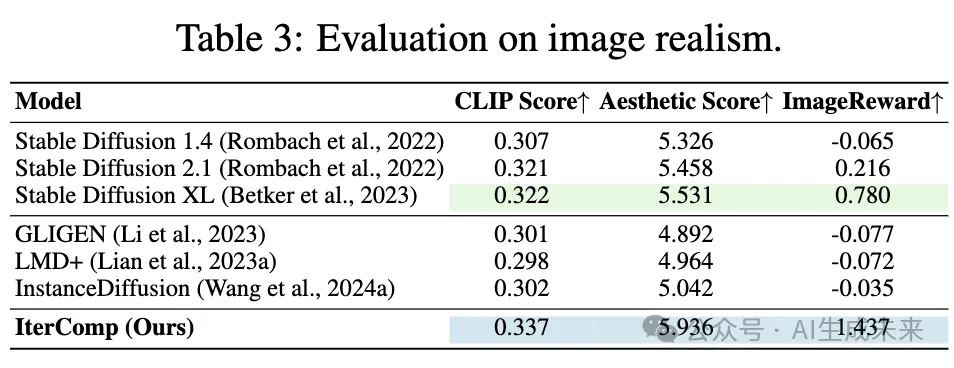

如下表 3 所示,我们通过计算 CLIP 分数、美学分数和图像奖励来评估图像真实感的提升。IterComp 在所有三个场景中显著优于之前的模型,在与复杂文本提示对齐时展现出卓越的保真度和精确性。这些令人鼓舞的结果突显了 IterComp 在组合性和保真度方面的多样性。在附录 A.3 中提供了 IterComp 与其他扩散对齐方法之间的更多定量比较结果。

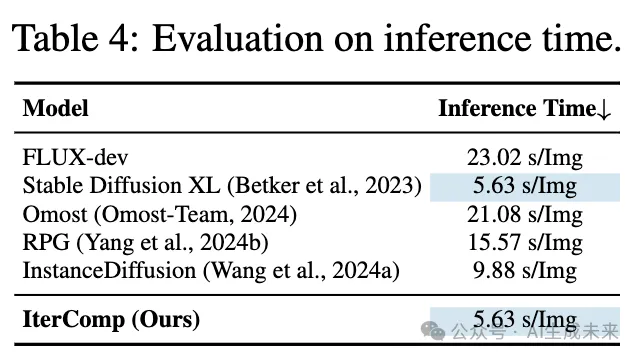

IterComp 生成高质量图像所需的时间更少。在下表 4 中,将 IterComp 的推理时间与其他优秀模型(如 FLUX、RPG)生成单张图像的时间进行了比较。使用相同的文本提示,并将去噪步数固定为 40,IterComp 显示出更快的生成速度,因为它避免了 RPG 和 Omost 中复杂的注意力计算。我们的方法能够在不增加任何计算开销的情况下,整合来自不同模型的组合感知知识。这种效率凸显了其在各种应用中的潜力,并为处理复杂生成任务提供了新的视角。

用户研究

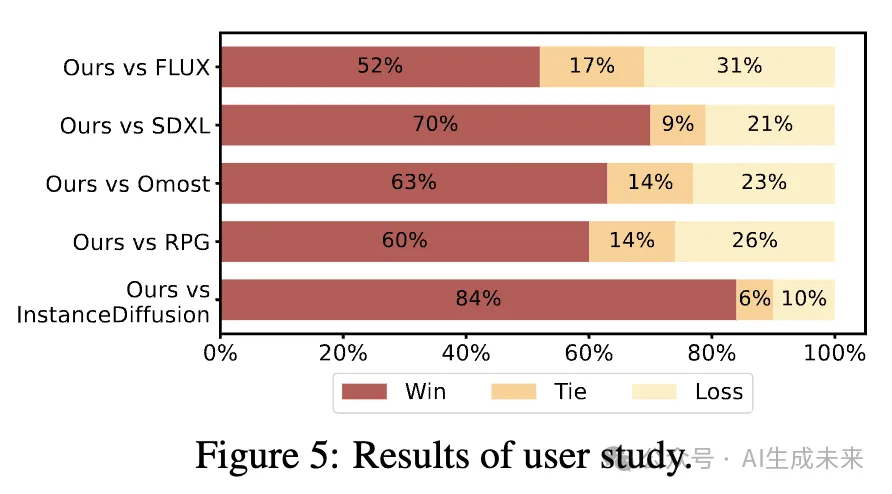

我们进行了一个全面的用户研究,以评估 IterComp 在组合生成中的有效性。如下图 5 所示,我们随机选择了 16 个提示进行比较,并邀请了来自不同背景的 23 位用户对图像组合性进行投票,共获得 1,840 票。结果显示,IterComp 在组合生成方面获得了广泛的用户认可。

消融研究

模型库大小的影响

在模型库大小的消融研究中,如下图 6 所示,我们观察到增加模型库的大小会提高 IterComp 在各项评估任务上的性能。为了利用这一发现并提供更细粒度的奖励指导,我们通过逐步扩展模型库,结合优化后的基础扩散模型和新模型(如 Omost)来进行多次迭代。

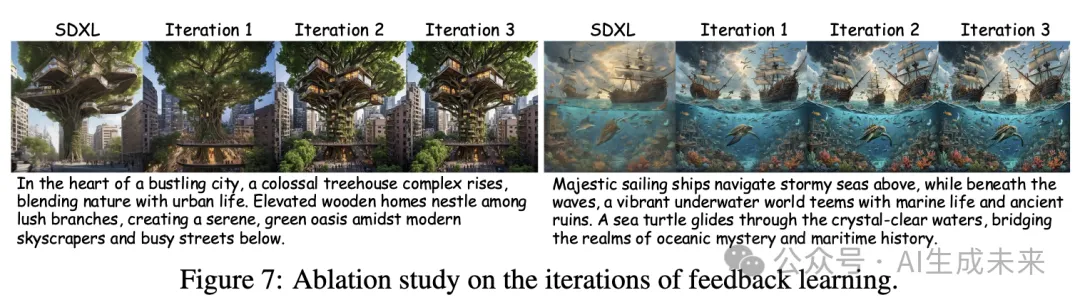

组合感知迭代反馈学习的影响

研究者们进行了消融研究(见下图 7),以评估组合感知迭代反馈学习的影响。结果显示,这种方法显著提高了组合生成的准确性和生成图像的美学质量。随着迭代次数的增加,模型的偏好逐渐收敛。基于这一观察,在 IterComp 中将迭代次数设置为 3。

泛化研究

IterComp 可以作为各种组合生成任务的强大基础,充分利用其在空间意识、复杂提示理解和更快推理方面的优势。如下图 8 所示,将 IterComp 集成到 Omost 和 RPG 中。结果表明,配备更强大 IterComp 骨干的 Omost 和 RPG 实现了出色的组合生成性能,突显了 IterComp 的强泛化能力和更广泛应用的潜力。

结论

本文提出了一种新颖的框架,IterComp,旨在解决复杂的组合文本到图像生成的挑战。IterComp 从模型库中聚合组合感知模型偏好,并采用迭代反馈学习方法,逐步优化奖励模型和基础扩散模型,以实现多次迭代的精细化。未来的工作中,我们计划通过引入更复杂的输入条件以及将其扩展到更实用的应用中,进一步增强该框架的能力。

本文转自AI生成未来 ,作者:AI生成未来