阿里巴巴达摩院、新加坡科技设计大学和南洋理工大学联合团队提升AI多步推理能力的新方法

大模型在处理更复杂的问题时,仍然容易在推理过程中出现错误,导致推理路径偏离,最终影响模型的整体性能。现有的大语言模型在多步推理任务中,通常会由于推理路径中某一步骤的错误而影响整个推理过程。这些错误不仅降低了模型的准确性,还增加了计算成本和执行延迟。传统的方法如强化学习需要复杂的奖励模型,而其他偏好优化方法往往忽视了多步推理任务中错误发生的具体步骤及其后续分支。

为了解决这些问题,阿里巴巴达摩院、新加坡科技设计大学和南洋理工大学联合团队提出了一种新的训练框架——Reasoning Paths Optimization(RPO)。该框架通过探索和学习多样化的推理路径,优化大语言模型的推理能力。具体而言,RPO在每个推理步骤中鼓励有利分支,惩罚不利分支,从而提高模型的整体问题解决能力。与需要大规模人工注释的传统方法不同,RPO利用模型自身生成的推理路径,使其具备可扩展性和数据高效性。10 月 16 日,他们的技术论文《Reasoning Paths Optimization:Learning to Reason and Explore From Diverse Paths》发表于arXiv,引起广泛关注。

研究团队结合了来自学术界和工业界的资源与智慧,成员包括新加坡科技设计大学、阿里巴巴达摩院和南洋理工大学的专家。他们的跨机构合作为研究提供了强大的技术支持和创新能力,展示了推理路径优化在前沿科技研究中的巨大潜力。主要成员包括新加坡科技设计大学与阿里巴巴达摩院联合博士项目的Yew Ken Chia 和 Guizhen Chen;阿里巴巴达摩院的研究员Weiwen Xu;南洋理工大学的研究人员Luu Anh Tuan 和 Soujanya Poria;阿里巴巴达摩院和新加坡科技设计大学的Lidong Bing。通过此次合作,该团队展示了Reasoning Paths Optimization框架的潜力,不仅在理论上提供了新的方法,也在实际应用中展现了良好的效果。

研究方法

大语言模型在解决复杂问题时,经常需要进行多步推理。为了提高模型的推理能力,研究团队提出了一种新的框架,即Reasoning Paths Optimization(RPO)。该框架旨在生成并优化推理路径,确保模型能在复杂问题中更准确地找到正确答案。推理路径生成的核心在于链式思维提示。

链式思维提示是一种通过展示多个逐步推理示例,来引导模型逐步推理的方法。具体来说,链式思维提示通过给出问题及其对应的推理步骤,帮助模型学习如何进行多步推理。为了生成参考推理路径,首先,他们需要准备一系列示例,每个示例包含一个问题及其对应的推理路径。接着,利用这些示例通过温度采样技术从基础模型中生成推理路径。

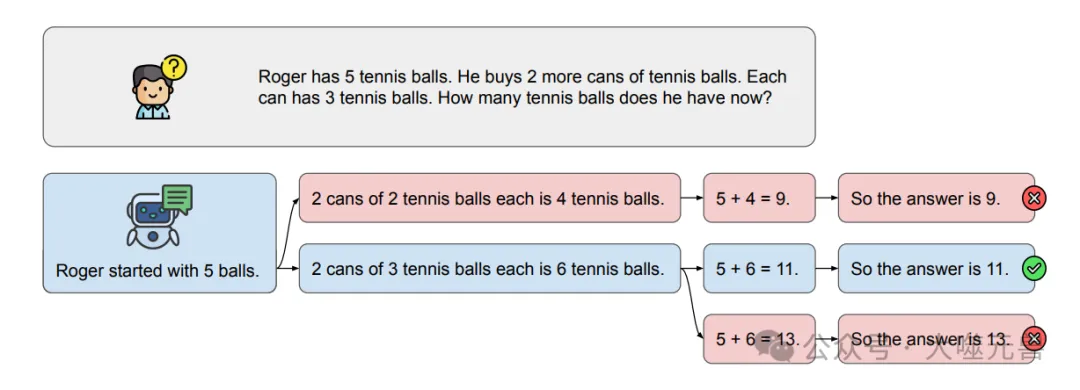

图1:模型的推理路径如何很容易地分叉到无法达到正确解的不利分支的示例。虽然我们在这里展示了一个简化的例子,但对于需要更长推理路径的更复杂的问题,挑战被放大了。

在生成参考推理路径的过程中,模型会生成多个可能的推理路径,并最终选择其中能够达到正确答案的路径作为参考路径。如果生成的路径在最后一步包含正确答案,他们将其视为正确路径。如果未能生成正确路径,则继续采样和验证,最多尝试十次。通过这种方式,他们可以确保生成的推理路径尽可能准确,避免错误累积导致推理失败。

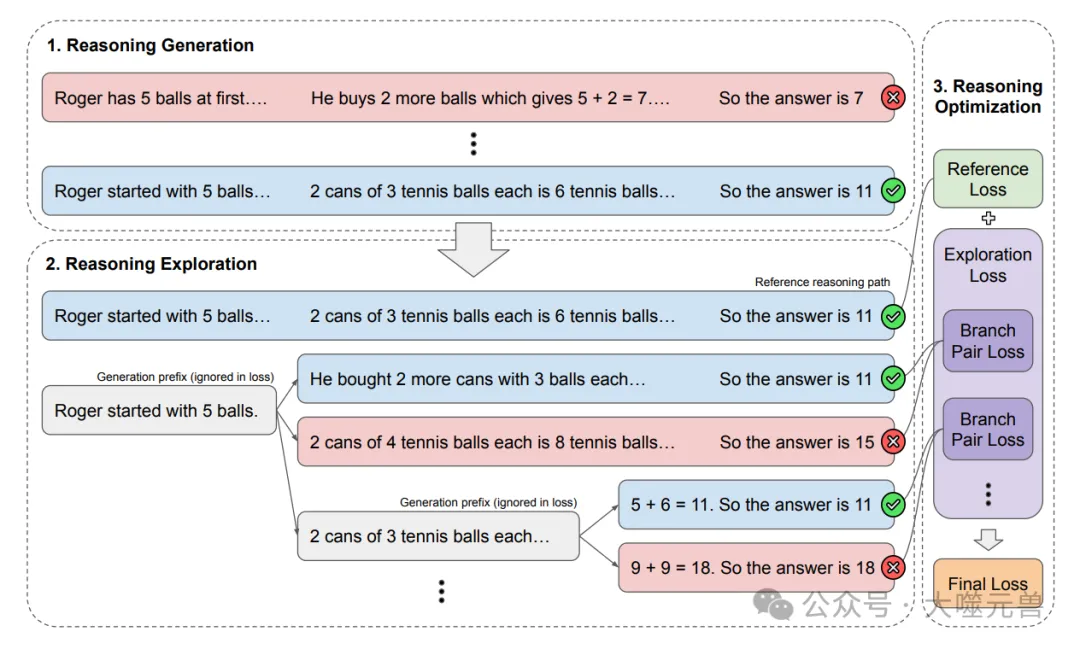

为了进一步提高模型的推理能力,他们需要考虑每个推理步骤中可能出现的错误。因此,在推理探索阶段,他们通过多分支探索方法来生成多个可能的解决分支,从而找出有利与不利分支对。

具体来说,在生成参考路径后,他们从每一步开始,生成多个可能的分支,并通过温度采样技术探索这些分支。在这个过程中,他们目标是找到一个有利分支和一个不利分支,其中有利分支能够通向正确答案,而不利分支则不能。通过迭代采样和验证,每一步都会形成一个推理分支对,这些分支对将用于后续的对比反馈和优化过程。

图2:我们用于探索和学习不同推理路径的推理路径优化框架概述。

在推理优化阶段,他们结合参考路径和探索得到的分支对,通过计算参考路径损失和分支对损失,实现对基础模型的优化。首先,参考路径损失是通过标准的因果语言模型损失计算的,目的是提高模型生成参考路径的概率。具体公式为:

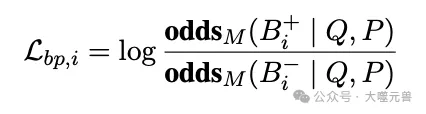

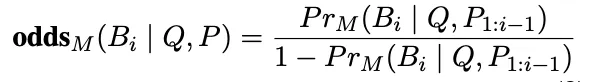

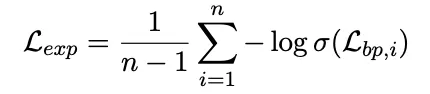

其次,对于分支对损失,通过对比有利和不利分支,提供对模型优化的指导。分支对损失的计算基于对数赔率差,具体公式为:

生成分支的赔率通过以下公式计算:

通过聚合每一步的分支对损失,他们可以得到总体的探索损失:

最终,他们综合参考路径损失和探索损失,通过以下公式实现总损失函数的优化:

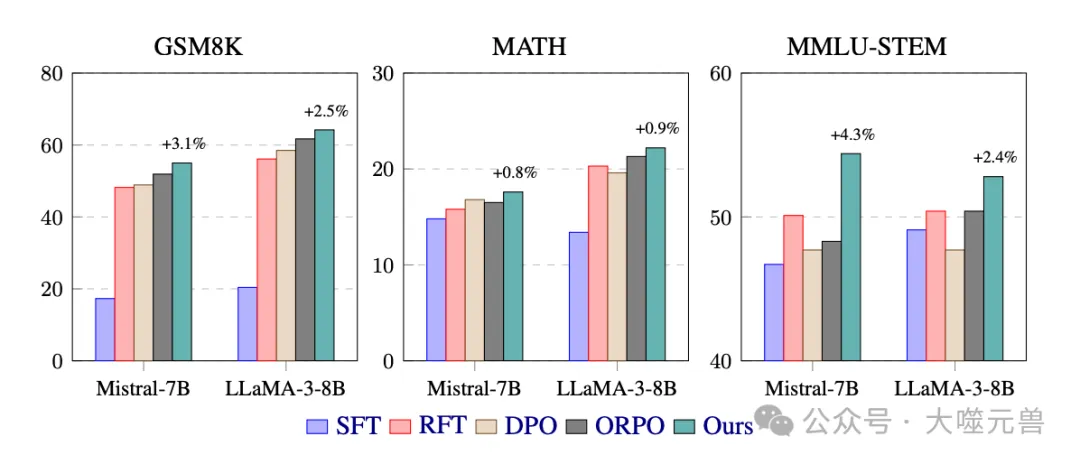

其中,λ是平衡参考路径优化和探索分支优化的超参数。通过这种方式,RPO框架能够有效提高模型在复杂问题求解中的推理能力,减少错误的发生,提升整体性能。

这部分内容详细介绍了论文中提出的Reasoning Paths Optimization框架的研究方法,包括推理路径生成、推理探索和推理优化的具体步骤和计算方法。接下来,将进一步讨论实验结果和对比分析,以验证该方法的有效性和优势。

实验与结果

在实验部分,他们详细介绍了使用的数据集、实验方法及其结果。这些实验展示了Reasoning Paths Optimization(RPO)框架在提高模型推理能力方面的有效性。通过对比不同基线方法和调整实验参数,他们进一步验证了该方法的优势。

数据集介绍

为了全面评估RPO框架的性能,他们选择了多个具有代表性的数据集进行实验。这些数据集包括GSM8K、MATH和MMLU-STEM。

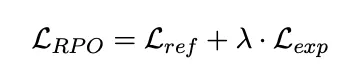

图3:GSM8K和math中数学推理问题以及MMLU-STEM中基于科学的考试问题的不同训练方法的评估准确率(%)的主要结果。我们还指出,与性能最高的基线相比,我们的方法有所改进。

GSM8K数据集主要用于数学文字问题的推理评估,该数据集包含了8000多个经过人工标注的数学题目,涵盖了从简单到复杂的各种难度等级。由于其多样性和高质量标注,GSM8K成为了评估语言模型推理能力的重要基准。

MATH数据集则专注于竞赛级数学题目,这些题目通常需要复杂的多步推理才能得出正确答案。MATH数据集的引入能够帮助他们评估模型在高难度推理任务中的表现,检测RPO在应对复杂问题时的有效性。

MMLU-STEM数据集是MMLU考试问题数据集的一个子集,专注于科学、技术、工程和数学(STEM)领域的问题。该数据集包含了多个需要多步推理才能解决的问题,能够全面评估RPO在不同领域推理任务中的适用性和效果。

实验方法

在实验过程中,他们采用了多种基线方法进行比较,以验证RPO框架的性能提升。主要的基线方法包括监督微调(SFT)、拒绝采样微调(RFT)、直接偏好优化(DPO)和赔率比偏好优化(ORPO)。

监督微调方法不使用推理路径,仅训练模型生成最终答案。拒绝采样微调方法利用模型自生成的推理路径进行训练,类似于RPO框架的推理生成阶段。直接偏好优化和赔率比偏好优化则提供对比反馈,帮助模型在有利和不利分支之间进行选择。

在模型训练和评估过程中,他们首先通过链式思维提示生成参考推理路径,并结合多分支探索方法生成多个可能的分支对。然后,通过计算参考路径损失和分支对损失,优化模型的推理能力。为了确保结果的可靠性,他们在训练和评估过程中保持一致的实验设置,采用固定的采样温度和批量大小。

实验结果

通过对比不同基线方法,他们发现RPO框架在多个数据集上均表现出了显著的性能提升。特别是在GSM8K和MMLU-STEM数据集上,RPO分别取得了3.1%和4.3%的性能提升。这表明RPO框架能够有效减少推理过程中错误的发生,提高整体推理能力。

此外,他们还研究了不同权重λ值对性能的影响。结果显示,λ值过低会导致对推理探索重视不够,结果不佳;而过高则会影响参考路径的优化效果。因此,在优化参考路径和探索分支之间找到平衡是至关重要的。

图4:LLaMA-3-8B的勘探损失权重对MATH数据集性能的影响。

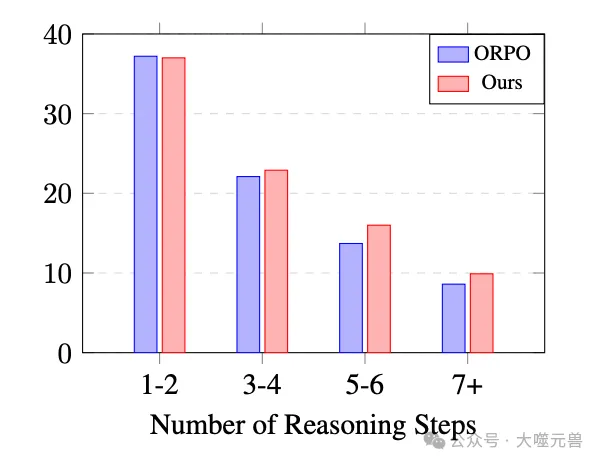

图5:LLaMA-3-8B在MATH数据集上的推理路径长度性能。

推理路径长度对结果的影响也进行了分析。与最高性能基线ORPO相比,RPO在较长推理路径上的表现更好,表明该方法能够有效减少复杂问题中的错误发生。

案例研究

为了进一步验证RPO框架的有效性,他们进行了案例研究。通过对具体问题的详细分析,他们发现RPO不仅能够得出正确答案,还能通过连贯的推理过程展示推理步骤。相比之下,其他基线方法在没有详细解释的情况下,容易在第一步就出现错误。

常见错误及其修正也在案例研究中得到了详细讨论。通过逐步验证推理路径,RPO框架能够有效减少错误,提升模型的推理能力和可靠性。

基于代码的推理

除了自然语言推理,RPO框架还在代码推理中展现了良好的适用性。他们通过代码示例生成Python程序,得到输出答案。实验结果表明,RPO在文本和代码推理中均表现出相似的优势。这表明该框架不仅在自然语言处理任务中有效,还可以推广到其他领域,如代码生成和代码增强推理。

对比目标和参考路径的影响

在实验中,他们研究了不同对比目标和参考路径的影响。结果显示,RPO框架在不同对比目标下表现出一致的稳健性和性能提升。此外,使用多个参考路径能够进一步增强模型的推理能力,证明了RPO在处理复杂推理任务时的有效性。

通过这些实验结果,他们可以得出结论,Reasoning Paths Optimization框架通过优化推理路径,有效提高了大语言模型在复杂问题求解中的可靠性和效率。这进一步展示了该方法在多步推理任务中的巨大潜力,并为未来研究提供了重要的启示。

相关工作

一致性和基于偏好的优化

在人类反馈强化学习(RLHF)领域,很多研究致力于使大语言模型(LLMs)更好地与人类偏好对齐,并能够遵循指示。RLHF方法通过训练一个单独的奖励模型来提供标量反馈,然后使用该反馈对LLMs进行微调。然而,PPO算法虽然广泛应用,但其复杂性和不稳定性让训练过程充满挑战。此外,RLHF需要分阶段训练奖励模型和策略模型,这进一步增加了技术难度。为了解决这些问题,近来涌现了多种技术,包括直接偏好优化(DPO)、无偏好优化(IPO)、简化偏好优化(SimPO)和赔率比偏好优化(ORPO),这些技术在一定程度上消除了对奖励模型的需求,大大稳定并简化了训练过程。

这些优化方法通过成对比较模型生成的两个响应,推动模型为更有利的响应分配更高的概率。然而,这些偏好优化方法通常在整体上比较两个响应,忽视了多步推理任务中特定步骤及其后续分支中错误的影响。因此,他们提出了Reasoning Paths Optimization(RPO),该方法关注每个中间步骤,提供更精细的对比反馈,有效提高模型的推理能力。

大语言模型中的多步推理

大语言模型在多步推理任务中表现出色,能够通过逐步生成推理步骤来解决复杂的问题。研究表明,通过引导模型生成推理步骤,可以显著提升其多步推理能力。例如,链式思维提示通过向模型展示逐步推理的示例,帮助其学习如何逐步推理。尽管如此,LLMs在推理过程中仍然容易出现错误,特别是在面对复杂的多步推理任务时。为了解决这一问题,逐步验证推理路径成为一种有效的方法,能够在每个推理步骤中捕捉并纠正错误。

此外,最新研究尝试通过构建逐步标签来验证中间步骤,从而减少人工注释的成本。这些方法主要集中在训练验证器(即奖励模型),而他们的RPO框架则通过流程监督将验证方法应用于偏好优化,无需单独的奖励模型。

人工智能中的路径探索

在人工智能领域,路径探索技术被广泛应用于提高复杂任务的性能。比如,AlphaGo使用蒙特卡洛树搜索(MCTS)来探索可能的移动空间。类似地,树状提示(Tree-of-Thought prompting)通过探索语言模型生成的可能解决方案空间,提高模型的决策能力。其他研究也设计了基于树的解码策略,以寻找最佳解决方案。在推理任务中,先前的研究通过自采样解决方案进行训练,并通过树搜索生成路径,进一步优化模型性能。

受这些工作的启发,研究团队提出的RPO框架通过探索多样化的解决方案空间,并在训练期间利用有利和不利分支的对比反馈来优化模型。通过这种方式,他们不仅能够捕捉到推理过程中的错误,还能够通过对比反馈进一步提升模型的整体推理能力。

总结起来,研究团队提出的Reasoning Paths Optimization框架在推理路径生成、推理探索和推理优化方面提供了一种全新的方法。通过对比现有的偏好优化方法和多步推理技术,RPO框架展示了其在提高大语言模型推理能力方面的潜力和优势。

结论与未来工作

研究团队提出了一种新颖的训练框架,即推理路径优化(Reasoning Paths Optimization,简称RPO),旨在提升大语言模型在多步推理任务中的性能。通过生成、探索和优化多样化的推理路径,RPO框架展示了其在复杂问题求解中的卓越能力。该方法通过链式思维提示生成参考推理路径,并在推理过程中探索多个可能的解决分支,形成有利和不利的推理分支对。最终,通过对比反馈和优化,总损失函数结合参考路径损失和探索损失,有效提高了模型的整体推理能力。

实验结果表明,RPO在多个数据集上均表现出显著的性能提升,尤其是在GSM8K和MMLU-STEM数据集上,分别提高了3.1%和4.3%。这些结果证明了RPO框架在减少推理过程中错误发生,提高复杂问题求解中的可靠性和效率方面的优势。

尽管RPO框架展示了显著的性能提升,但其方法仍存在一些局限性。首先,RPO依赖于模型在训练阶段生成正确推理路径的能力,如果基础模型表现不佳,可能难以生成必要的正确路径,从而限制了方法的有效性。其次,生成和探索多个推理路径的过程相对计算密集,尽管这是训练中的一次性成本,但仍需大量计算资源支持,这在资源受限的环境中可能会成为瓶颈。

此外,RPO框架虽然无需大规模人工注释,但在生成初始参考路径和探索分支时,仍可能受到模型自身生成质量的影响。如果生成的参考路径不够准确,或者探索到的分支存在较多错误,可能会影响最终优化结果的质量。

未来的研究可以从以下几个方面进一步改进和扩展RPO框架。

增强基础模型的推理能力:可以考虑结合更多的训练数据和更先进的预训练模型,以提高基础模型在生成正确推理路径时的性能,从而增强RPO的整体效果。

优化计算资源的使用:针对生成和探索过程中的计算密集问题,研究可以尝试引入更加高效的采样和验证方法,以减少计算资源的消耗,提升训练效率。

扩展应用领域:RPO框架在自然语言处理中的推理任务表现优异,未来可以探索其在其他领域的应用,例如代码生成、科学计算和复杂系统建模等,验证其在更多任务中的适用性和有效性。

开发更健壮的验证机制:引入更加智能和自动化的验证机制,减少对模型生成质量的依赖,确保探索到的推理分支更加准确和有效。

人机协作优化:探索人类专家与RPO框架的协作,通过专家指导和反馈进一步优化推理路径,提升模型的整体推理能力和准确性。

总之,Reasoning Paths Optimization框架通过创新的方法和严谨的实验,展示了其在提升大语言模型多步推理能力方面的巨大潜力。尽管存在一些局限性,但随着技术的发展和研究的深入,RPO有望在更多复杂任务中发挥重要作用,推动人工智能技术的持续进步和应用。(END)

参考资料:https://arxiv.org/pdf/2410.10858

本文转载自 大噬元兽,作者: FlerkenS