KDD'24大厂推荐系统优化工作总结

今天这篇文章给大家介绍几篇KDD2024中,大厂在推荐系统领域的优化工作,论文来自爱彼迎、腾讯、快手、美团等公司,设计多目标建模、多样性、搜索意图建模、ranking loss等问题。

1.爱彼迎:多目标建模和模型蒸馏

论文标题:Multi-objective Learning to Rank by Model Distillation

下载地址:https://arxiv.org/pdf/2407.07181

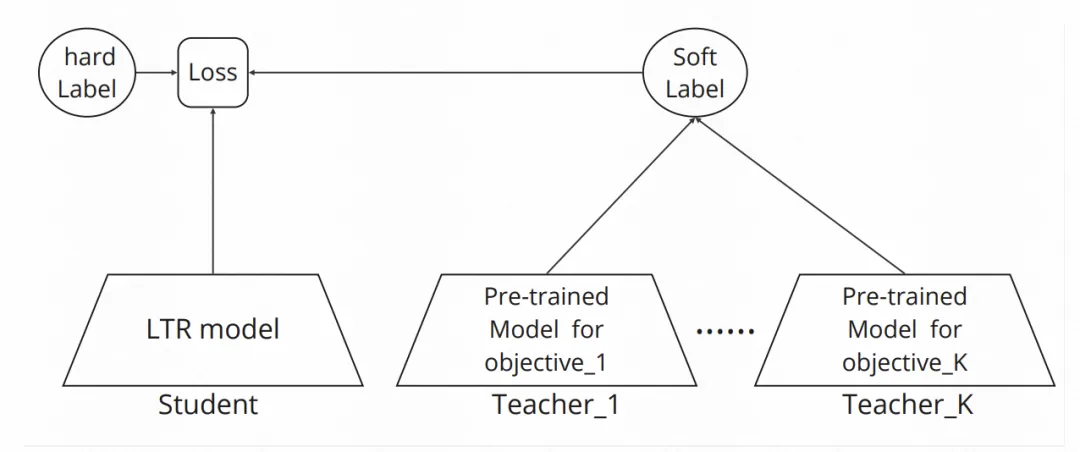

多目标建模转换成模型蒸馏问题。多目标的场景要求最小化一个目标的预测误差,同时其他目标的预估误差在一个约束内。假设单独训练的一个单目标模型,效果一定比多目标一起训练的这个目标的预测误差要小,上述问题就等价于一个模型蒸馏损失函数。这个损失函数一方面包括主目标的hard label的优化目标,另一方面包括每个其他目标下,多目标蒸馏单目标最优模型soft label的优化目标。通过各个辅助目标蒸馏损失的权重,以及主目标hard label和辅助目标soft label的权重,调节模型优化过程。

2.Ranking Loss有效性分析

论文标题:Understanding the Ranking Loss for Recommendation with Sparse User Feedback

下载地址:https://arxiv.org/pdf/2403.14144

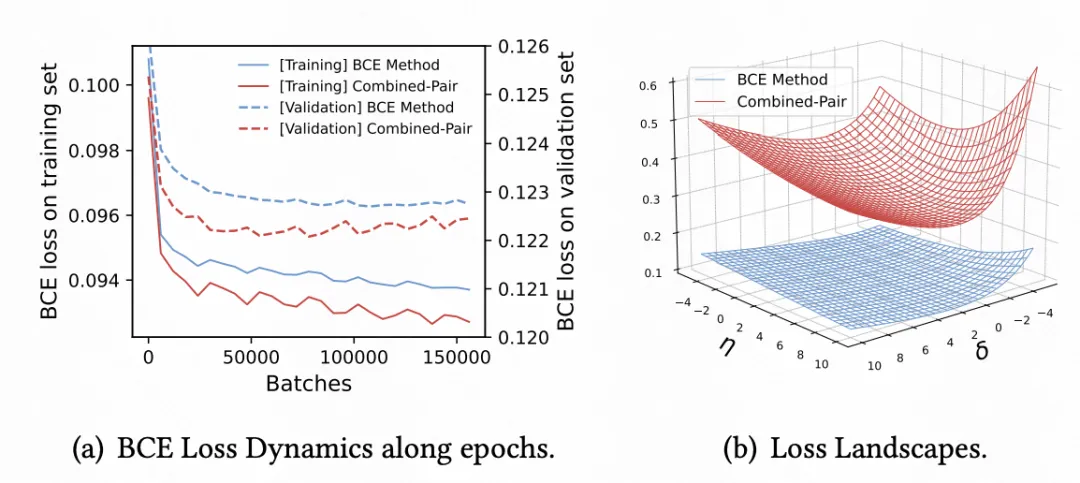

推荐系统的预估模型一般采用Binary Cross Entropy训练,一些研究发现引入list-wise或者pair-wise的ranking loss可以显著提升模型AUC。本文探索了ranking loss的引入带来效果提升的原因。通过对比在BCE基础上是否引入ranking loss,模型在梯度更新、训练超平面等角度的分析,本文发现ranking loss有效的核心原因是在正样本稀疏的场景下,相比单独BCE模型,引入ranking loss可以让梯度变得更大,模型训练更容易收敛,负样本优化超平面更加陡峭,进而带来效果提升。

3.快手:上下文蒸馏提升精排多样性

论文标题:Contextual Distillation Model for Diversified Recommendation

下载地址:https://arxiv.org/pdf/2406.09021

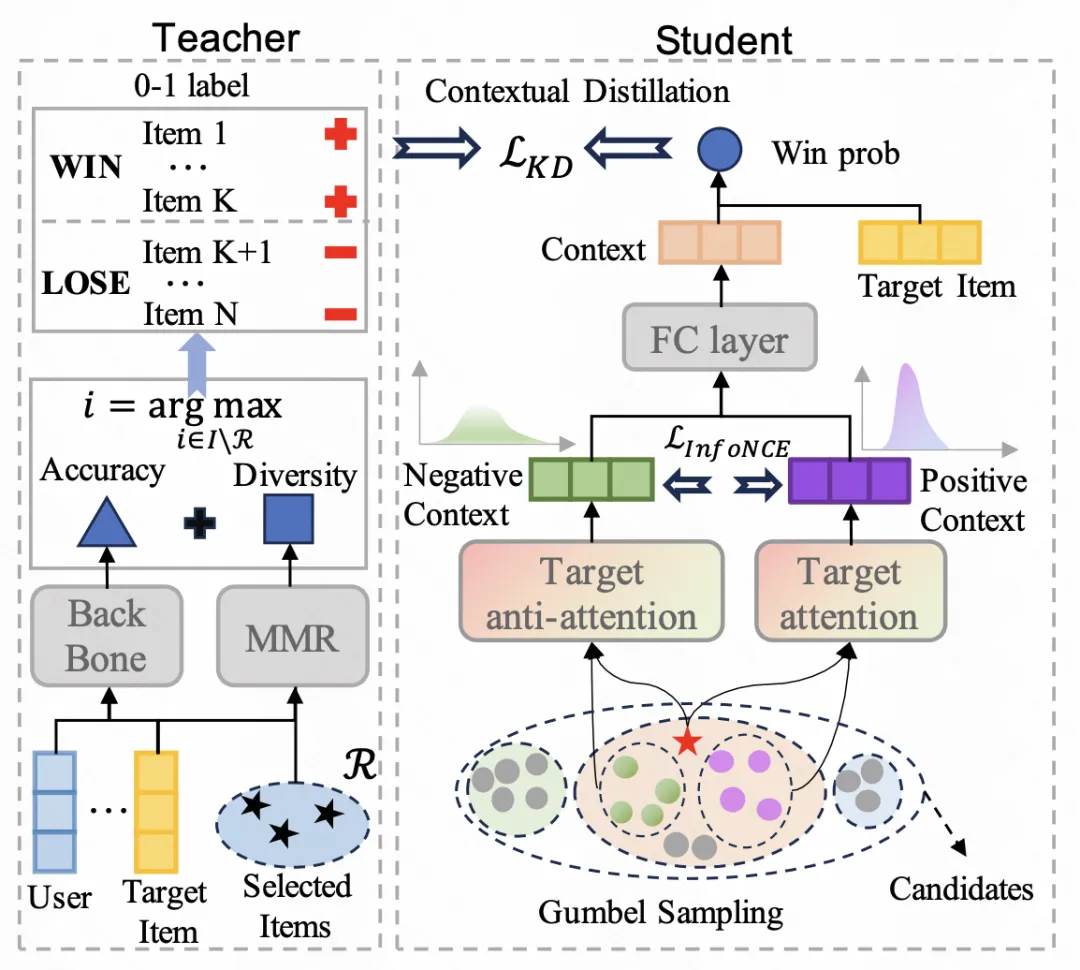

本文提出了一种在精排阶段提升推荐系统多样性的建模方法。一般提升推荐系统多样性都是在重排阶段使用NMR算法实现,该算法每次将精排打分最高且和已经选择的候选相似度最低的样本加入结果集,迭代该过程实现考虑推荐结果多样性的重排。然而,如果精排阶段没有较好的考虑多样性,会导致送入重排阶段的多样性较差,进而影响了整体推荐系统的多样性。

为了解决上述问题,本文提出了一种基于上下文信息的多样性蒸馏方法。该方法在精排模型中,以NMR的排序结果作为Teacher,将多样性信息蒸馏到精排模型中。由于NMR算法需要输入上下文信息,文中将所有精排候选当做上下文。同时,根据attention和anti-attention,从精排候选中采样和当前item相关及对抗的候选,丰富上下文信息,并通过对比学习获取两类item的embedding,输入MLP网络蒸馏NMR Teacher的多样性预测结果。

4.美团:搜索意图引入推荐模型

论文标题:Unified Dual-Intent Translation for Joint Modeling of Search and Recommendation

下载地址:https://arxiv.org/pdf/2407.00912v1

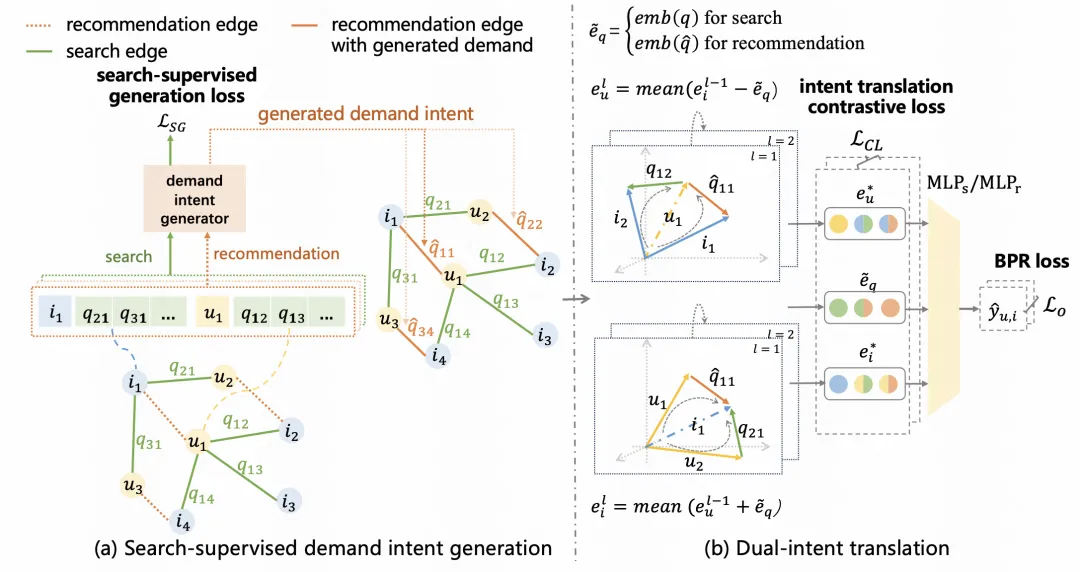

推荐系统相比搜索场景,一个核心难点是缺少像query那样的显示用户意图表达。本文提出利用搜索场景的用户、item历史搜索query,建模用户的query意图表征,相当于学习一个虚拟的用户query,再将其表征应用到推荐系统中,提升推荐系统建模效果。

用户意图可以分为稳定意图和变化意图。针对这两类意图信息,文中构建了一个dual-intent转化表征学习方法。首先基于用户的历史搜索query和点击的item,构建异构图,图中节点是user或item,边是用户和item交互时搜索的query。对于query和user使用term embedding pooling以及引入user个性化门控等方式获取query表征,并以用户真实搜索query的表征作为进行监督学习,以此作为用户的动态意图。同时,使用GNN融合图上用户的临接节点信息,刻画用户的固有意图。最后,结合用户交互item=用户静态意图+动态意图的转化逻辑,建立表征优化的训练目标。这些搜索意图表征信息最后输入到推荐系统模型底层进行最终目标拟合。

本文转载自 圆圆的算法笔记,作者: Fareise