LeCun转发!已开源!大连理工卢湖川、贾旭团队提出可插入图像/视频/3D生成的StableIdentity

Github:https://github.com/qinghew/StableIdentity(代码已全部开源)

Project Page:https://qinghew.github.io/StableIdentity/

Paper:https://arxiv.org/abs/2401.15975

最近,来自大连理工大学的IIAU团队提出StableIdentity,允许用户只需上传一张图片,通过优化学习身份,即可结合包含动作、背景、风格的文本提示实现图像定制生成,并且无需微调即可插入视频/3D生成。

Yann LeCun此前也点赞转发,调侃自己从没戴过这样的帽子。

一、引言:

随着扩散模型的发展,定制化生成任务受到广泛关注。这项任务旨在为文本到图像模型注入新的主题(如身份),并在对齐输入文本提示的同时,生成在不同语境下主题一致的图像。例如,用户可以上传自己的照片以获得有趣的图片,如 "穿着超人服装"。定制生成的成功可以促进许多应用,如个性化肖像照片虚拟试穿和艺术设计。然而,现有的定制方法是通过微调模型的部分/全部参数或学习通用编码器来解决这一问题的。参数微调方法需要花费很长时间来搜索最佳参数,但往往会返回一个不准确的平凡解来表示身份。尤其是在只有单张图像的情况下,这些方法往往会过拟合输入图像,导致可编辑性下降。另外,基于编码器的方法需要大规模的数据集进行训练,很难捕捉到独特的身份和细节。此外,目前的方法所学习到的身份在不同的语境下容易与目标身份不一致。因此,迫切需要提出一种新的框架来解决这一任务所面临的巨大挑战(如身份保持不稳定、可编辑性差等)。

二、方法

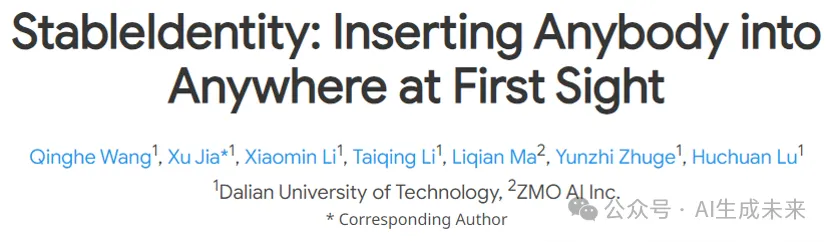

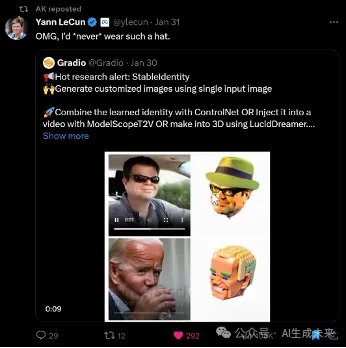

在这项工作中,研究者们提出了 StableIdentity,如图所示,给定一张输入人脸图像,它将身份先验和可编辑先验集成到了人的定制生成中,旨在通过优化学习可以表示目标身份的词向量。

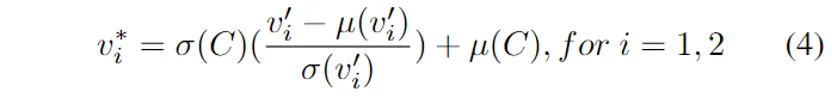

具体来说,本文首先引入了一个经过人脸识别任务预训练的编码器来精确地捕捉身份表示。此外,研究者们收集了在Stable Diffusion中可以在不同上下文中生成一致身份的名人姓名,构建了统一维度的嵌入空间,以作为定制生成的先验身份分布。为了激励目标身份在预训练扩散模型中表现得像名人姓名一样,本文进一步将身份表示通过AdaIN落入到这一先验空间。

此外,为了学习更稳定的身份和细粒度重建,本文设计了一种two phase扩散损失,分别在降噪训练的前期和后期阶段分配专门的目标函数。其中降噪前期已被证明决定了生成图像的布局,因此前期使用原始的降噪损失以保证学到的身份可以适应多样的布局。降噪后期使用对预测的的重建损失,以提升对输入图像的像素级感知,从而学习更稳定的身份。

三、实验结果

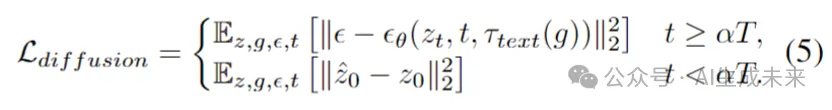

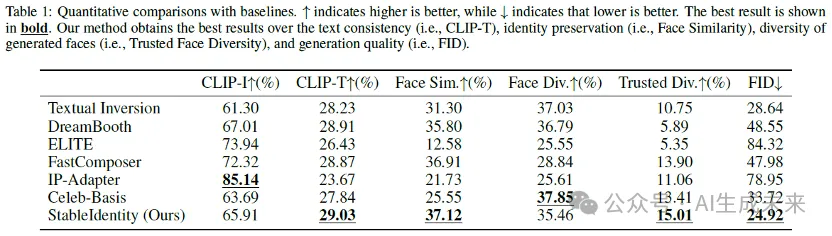

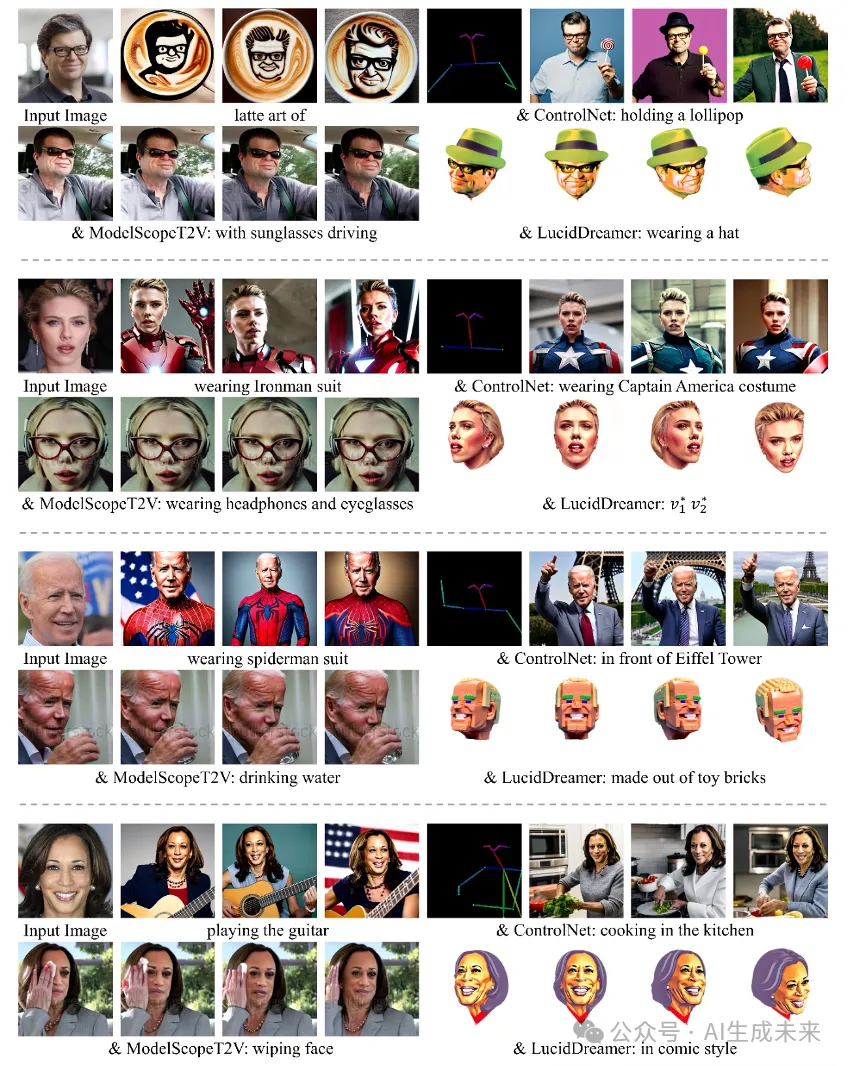

- 在实验环节,本文在多个指标上与6个baselines进行了定性和定量的对比。如图1和表4所示,本文的方法取得了最佳的人脸相似性、可编辑性、图像质量。

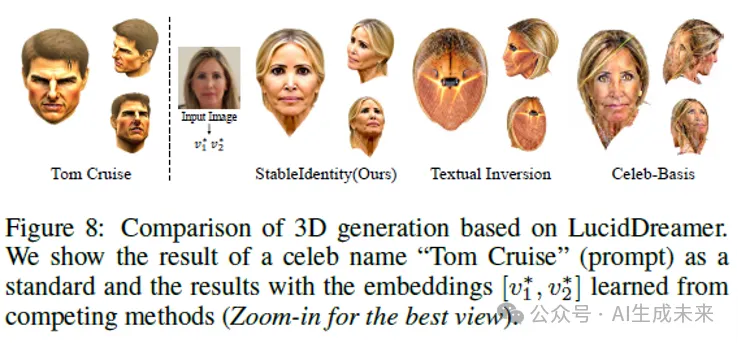

- 此外,本文进一步在与3D模型的结合上与同类型基于词向量的方法进行了对比,可以看出StableIdentity可以更好地插入到3D生成中。

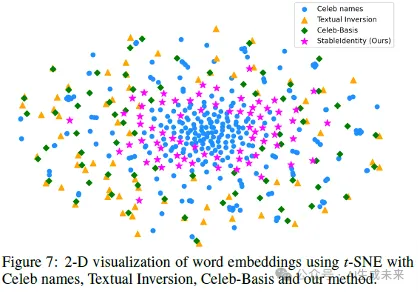

本文用TSNE可视化了学到的身份编码与具有可编辑性的名人名字编码的2D分布。可以看出,本文的StableIdentity学到的embedding分布更加紧凑,更接近于真实的名人名字embedding的分布。

3. 本文也用单张名人照片作为输入进行了实验,可以看出,学到的身份在图像/视频/3D上都表现不错。

更多的结果可以在https://qinghew.github.io/StableIdentity/中查看。

四、展望

这一方法可以直接与ControlNet等基于Stable Diffusion的即插即用的模块配合使用,甚至可以将学习到的身份插入现成的视频/3D生成的模型中,而无需进行微调即可产生出色的效果。这项工作被认为是统一图像、视频和3D定制化生成任务的重要一步。未来的工作将进一步探索通过更高效的方式学习泛化性强的身份表示,以更好地适应和解决实际应用中的挑战。

本文转自 AI生成未来 ,作者:Qinghe Wang