打破视觉-语言预训练的瓶颈:新算法解决噪声和标注问题 精华

引言:探索视觉-语言对比预训练中的噪声和低质量标注问题

在视觉-语言对比预训练中,噪声和标注质量被认为是影响训练效果的重要因素。本文通过深入研究和分析训练过程中的两个主要问题——错误的负样本对分配和低质量及多样性不足的标注——揭示了通过解决这些问题来提高训练质量的潜力尚未被完全实现。

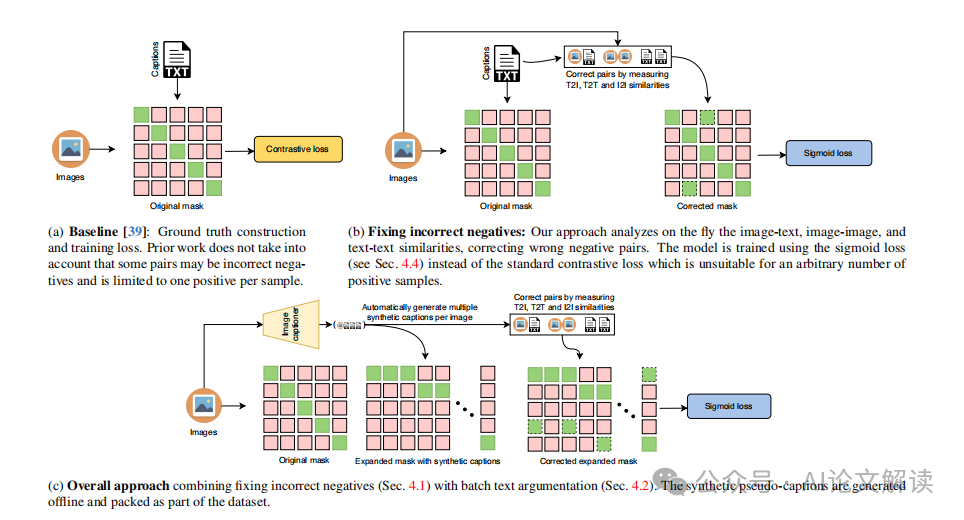

首先,我们研究了影响对比学习的噪声问题,即在一个批次中可能会发现语义相似甚至相同的图像/标注被错误地视为负样本对。其次,我们探讨了标注的低质量和多样性不足问题,标注可能简短且缺乏细节,嘈杂,或与图像完全无关。

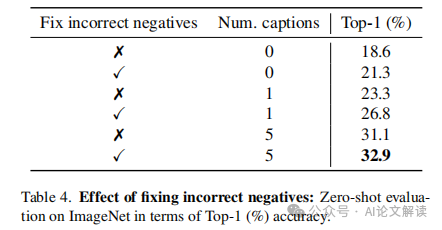

为了解决第一个问题,我们提出了一种算法,通过图像-文本、图像-图像和文本-文本的相似性来挖掘新的正样本对,以减少因语义相似的图像/标注而产生的错误负样本。对于第二个问题,我们首先使用最先进的图像描述生成技术为每个训练图像生成伪标注,这些伪标注将作为给定图像的新真实正样本。然后,我们提出在同一批次中使用多个伪标注进行训练,以有效增加标注的多样性。

通过应用所提出的解决方案,我们最终获得了每个图像的多个正样本对,这意味着我们需要使用一种能够适应多个正样本的损失函数来训练我们的模型。在这里,我们提出使用sigmoid损失来满足这一需求,该损失允许每个样本和每个批次动态变化的正样本数量,且对噪声具有鲁棒性。

- 论文标题:FFF: Fixing Flawed Foundations in contrastive pre-training results in very strong Vision-Language models

- 机构:Samsung AI Center Cambridge, UK; Technical University of Iasi, Romania; Queen Mary University of London, UK

论文链接:https://arxiv.org/pdf/2405.10286.pdf

问题分析:错误负样本对和低质量标题的影响

1. 错误负样本对的识别与修正

在大规模对比图像-文本预训练中,错误地将近似重复的样本视为负样本对是一个常见问题。这种错误的负样本对会显著阻碍训练过程和模型质量。为了解决这一问题,我们提出了一种算法,通过计算图像-文本、图像-图像和文本-文本的相似性,来重新分配这些错误的负样本对为正样本。这种方法可以有效减少训练数据中由于语义相似的图像或标题而产生的错误负样本。

2. 标题质量与多样性的提升策略

低质量和多样性不足的标题会影响模型的训练效果。为了提高标题的质量和多样性,我们首先使用先进的图像描述生成技术(如BLIP2)为每个训练图像生成伪标题,这些伪标题将作为给定图像的新真正正样本。然后,我们提出在同一批次中使用多个伪标题(例如,每个图像选择五个标题)进行批量文本增强,以有效增加标题的多样性。

解决方案:新正样本的挖掘与伪标题的批量文本增强

1. 基于相似性挖掘新的正样本对

我们提出的算法不仅修正了错误的负样本对,还能够基于图像和文本特征的余弦相似性挖掘新的正样本对。这一过程通过动态调整正样本的数量来适应模型训练,从而提高了训练的准确性和效率。

2. 使用伪标题进行批量文本增强

为了进一步提高模型对图像描述的准确性,我们采用批量文本增强的策略,将多个伪标题纳入同一批次的训练中。这种方法不仅增加了文本的多样性,还通过集成多个伪标题来改善了单个错误标题可能带来的负面影响,从而提高了模型的鲁棒性和描述能力。

模型训练:采用sigmoid损失函数

1. Sigmoid损失函数的选择与优势

在处理视觉-语言对比预训练中,特别是在面对数据质量和噪声问题时,传统的对比损失函数(如InfoNCE)可能不足以处理多个正样本的情况。这是因为这些损失函数通常假设每个样本只有一个正样本。为了解决这一问题,我们采用了sigmoid损失函数。Sigmoid损失函数的主要优势在于它能够自然地处理每个样本动态变化的正样本数量,且对噪声具有较强的鲁棒性。

在我们的设置中,每个图像不仅与其原始标注配对,还可能与通过算法生成的多个伪标注配对,这些伪标注是通过高级图像标题生成技术(如BLIP2)创建的。这种方法增加了训练过程中的正样本数量,有助于模型更好地理解和描述图像内容。sigmoid损失函数能够有效地处理这种多正样本的情况,而不会引入额外的计算成本。

2. 多正样本对训练的实现

为了增加训练数据的多样性和质量,我们采用了批量文本增强技术,即在同一批次中为每个图像生成多个伪标注。这些伪标注作为正样本输入模型,通过sigmoid损失函数进行训练。这种方法不仅提高了标注的多样性,还通过集成多个伪标注来减少单个错误标注对模型训练的影响。

此外,我们还采用了一种新的正样本挖掘算法,通过分析图像-文本、图像-图像和文本-文本之间的相似性来动态地识别和校正错误的负样本对,将其转换为正样本。这一策略进一步增加了正样本的数量和质量,为模型训练提供了更丰富的学习信号。

实验验证:数据集和实验设置

我们的模型在多个公开可用的视觉-语言数据集上进行了预训练和测试,包括YFCC15M-v2、CC3M和CC12M等。这些数据集包含大量的图像-文本对,适用于视觉-语言对比学习的大规模训练。

在实验中,我们使用了与CLIP相同的模型架构和设置,采用AdamW优化器,学习率设置为1e-3,权重衰减为0.1。图像通过随机缩放和裁剪至224×224像素,应用随机翻转、高斯模糊和颜色抖动等增强技术。文本数据则被截断至77个令牌。

所有模型均在8块NVIDIA A100 GPU上训练32个周期。我们的实验设置旨在公平地与先前的工作进行比较,并展示我们方法在处理多正样本和噪声数据时的优势。通过这些实验,我们证明了采用sigmoid损失函数和多正样本策略的有效性,实现了在多个基准测试上的显著性能提升。

实验结果与分析:模型性能的显著提升

1. 图像识别与检索的改进

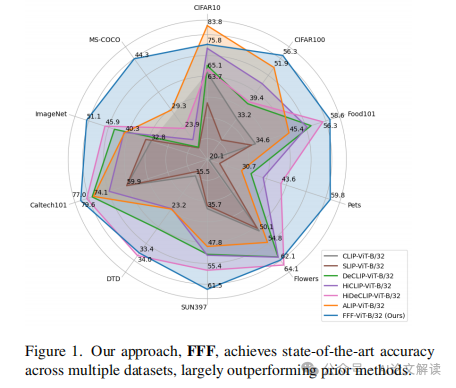

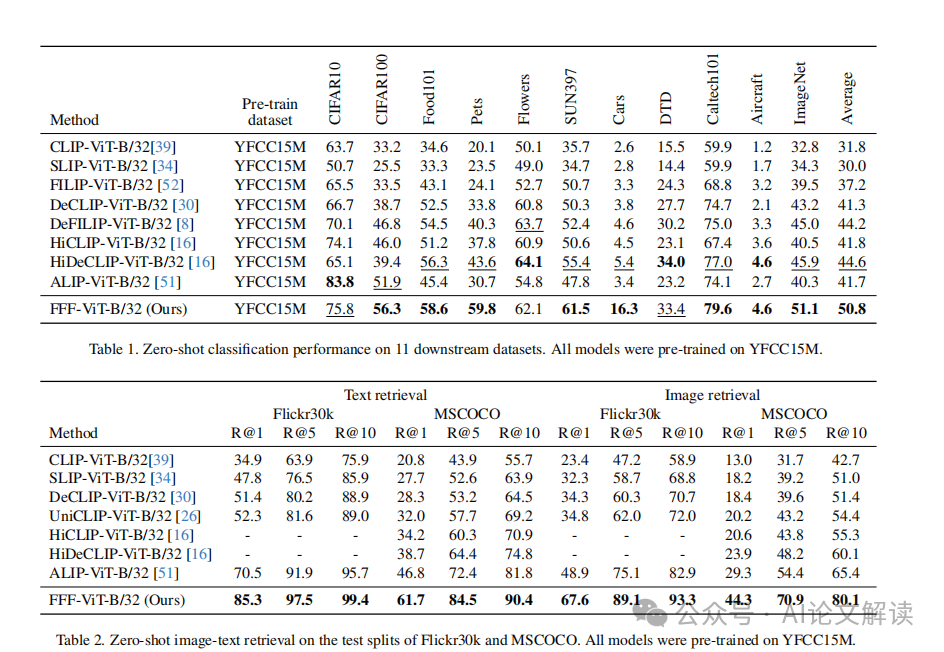

在图像识别和检索方面,通过对比训练数据中的噪声和低质量标注的处理,我们的方法在多个数据集上都显示出了显著的性能提升。具体来说,我们的模型在11个数据集上的图像识别平均提升了约6%,在Flickr30k和MSCOCO的图像检索任务上分别提升了约19%和15%。这一成绩的提升归功于我们对错误负样本对的纠正以及对训练数据质量的改进。

2. 不同组件的影响分析

我们的方法包括两个主要的技术改进:错误负样本对的纠正和批量文本增强。通过对这些组件的单独分析,我们发现图像-文本相似度矩阵(Sit)是最有影响力的,因为它不仅帮助过滤掉错误的配对,还调整了语义上相似的样本。此外,我们还观察到,使用多个伪标题进行训练可以显著提高模型的准确性,这验证了批量文本增强的有效性。

结论与展望:多正样本对策略的前景与挑战

通过本研究,我们展示了在视觉-语言对比预训练中处理多个正样本对的潜力和效果。我们的方法不仅显著提高了模型在图像识别和检索任务上的性能,而且还提出了一种新的损失函数——sigmoid损失,以适应训练样本中正样本数量的动态变化。

尽管我们的方法取得了显著的进步,但在实际应用中仍面临一些挑战。例如,如何有效地从大规模噪声数据中挖掘和利用真正的正样本对,以及如何进一步优化模型以处理更大规模的数据集。此外,多正样本对策略在不同类型的视觉-语言任务中的普适性和效果还有待进一步研究。

总之,多正样本对策略为视觉-语言模型的训练提供了新的视角和可能性,预示着在自动图像标注、图像检索以及其他相关领域的广泛应用前景。

总结:视觉-语言预训练的新方向及其潜在影响

在视觉-语言预训练领域,最新的研究提出了一种新的方法,通过解决错误的负样本配对和低质量的图像描述问题,显著提高了模型的性能。这些问题一直是影响训练质量的关键因素,而现有的解决方案尚未完全发挥其潜力。通过深入分析和新算法的应用,研究者们成功地推动了这一领域的发展。

1. 错误的负样本配对问题

在传统的对比学习中,每个批次中可能会错误地将语义相近的样本视为负样本对。这种现象在数据集中普遍存在,尤其是在大规模的图像-文本数据集中。为了解决这一问题,研究者提出了一种新的算法,通过分析图像-图像、文本-文本和图像-文本之间的相似性,动态地重新分配正负样本对。这种方法有效减少了因语义近似而产生的错误负样本,从而提高了模型的训练效果。

2. 图像描述的质量和多样性问题

传统的数据集中的图像描述往往质量不高,缺乏详细信息,这严重影响了模型的学习效果。为了提高描述的质量和多样性,研究者采用了最先进的图像描述生成技术,为每张图像生成多个伪描述。这些伪描述作为新的正样本参与训练,显著增加了描述的多样性和质量。此外,通过批量文本增强技术,同一批次中的多个伪描述可以同时用于训练,进一步提升了模型的性能。

3. 新的损失函数

由于引入了多个正样本对,传统的对比损失函数已不再适用。研究者提出使用sigmoid损失函数,这种损失函数可以灵活地处理每个样本的动态正样本数量,且对噪声具有较强的鲁棒性。这一改进使得模型训练更加高效,同时也减少了因错误标注带来的负面影响。

通过这些创新方法的应用,研究者在多个标准数据集上取得了显著的性能提升,不仅在图像识别任务上平均提高了约6%,在图像检索任务上也分别在Flickr30k和MSCOCO数据集上提高了约19%和15%。这些成果不仅展示了处理错误负样本配对和提高图像描述质量的重要性,也为未来的视觉-语言预训练研究提供了新的方向。

本文转载自 AI论文解读,作者:柏企