多模态大模型中,多模态融合后怎样知道最终结果受哪种模态影响更大? 原创

本篇介绍多模态大模型中如何基于最终结果分析各模态的影响。

具身智能被众多大佬看好,通往AGI的路最终肯定需要多个模态的大模型互相融合。多个模态配合好也是有可能去构建一个模拟现实的世界模型的。

最近一直在研究和尝试多模态大模型在一些VQA领域的前瞻研究和实际落地部署问题,遇到一个值得思考的问题:如果当预测结果出问题的时候,怎么去溯源是哪个模态的数据出的问题呢?这个方向感觉探索的足够深入是可以发论文的。

由于基于注意力机制去溯源的方法在大模型时代成本极高,因此最后还是需要考虑建模后的可解释性方法,目前主要是找到一些比较经典的可解释性机器学习方法,大家有更好的思路也可以提一提啊~

下面是一个快捷目录。

1. 可解释性机器学习分类

2. 推荐方法

一、可解释性机器学习分类

1. 内置 or 建模后

- 内置可解释性:将可解释模块嵌入到模型中,比如说线性模型的权重、决策树的树结构。

- 建模后可解释性:在模型训练结束后使用解释技术去解释模型。

2. 特定于模型 or 模型无关

- 特定于模型的解释:意味着必须将解释方法应用到特定的模型体系结构中

- 模型无关:解释方法与所用模型无关联,应用范围广

3. 全局解释 or 局部解释

- 全局解释:解释模型的全局行为

- 局部解释:在单条数据或者说单个实例上的解释

二、推荐方法

主要推荐两个方法:Permutation Importance 和 SHAP;另外还介绍了一下类似于LIME (Local Interpretable Model-agnostic Explanations) 的思路,大家还可以基于这个思路去延伸~

1. Permutation Importance

前提:在model训练完成后,才可以计算

思想:

基于“置换检验”的思想对特征重要性进行检测。简单来说,就是打乱某种模态的数据,保持其余特征不动,看其对预测精度的影响有多大。

计算步骤:

1)用多模态数据训练一个MLLM。(也可以直接用开源的)

2)验证集预测得到得分。

3)验证集的某个单模态数据进行随机打乱,比如把文本给打乱,预测得到得分。

4)将上述得分做差即可得到该模态对预测的影响。

5)同理可以在3)中把另一个模态的数据随机打乱进行验证,最后比较即可。

2. SHAP (SHapley Additive exPlanation)

前提:在model训练完成后计算

思想:

计算特征对模型输出的边际贡献,再从全局和局部两个层面对“黑盒模型”进行解释。

SHAP构建一个加性的解释模型,所有的特征都视为“贡献者”:

对于每个预测样本,模型都产生一个预测值,SHAP value就是该样本中每个特征所分配到的数值。

具体来说,计算一个特征加入到模型时的边际贡献,然后考虑到该特征在所有的特征序列的情况下不同的边际贡献,取均值,即某该特征的SHAP baseline value,包括Kernel Shap,Deep Shap和Tree Shap。

这也是目前可解释机器学习在风控、金融中最实用的一个方法。

3. 类似于LIME (Local Interpretable Model-agnostic Explanations) 的思路

之所以说“类似于”是因为LIME暂时无法实现对图像的解释,但这个思路本身是值得借鉴的。

前提:在model训练完成后计算

思路:

使用训练的局部代理模型来对单个样本进行解释。

假设对于需要解释的黑盒模型,取关注的实例样本,在其附近进行扰动生成新的样本点,并得到黑盒模型的预测值,使用新的数据集训练可解释的模型(如线性回归、决策树),得到对黑盒模型良好的局部近似。

实现步骤

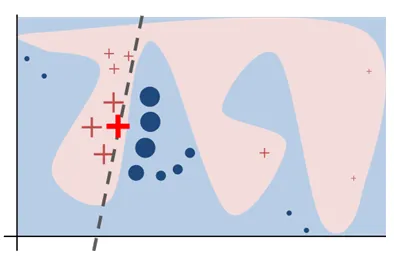

1)如上图是一个非线性的复杂模型,蓝/粉背景的交界为决策函数;

2)选取关注的样本点,如图粗线的红色十字叉为关注的样本点X;

3)定义一个相似度计算方式,以及要选取的K个特征来解释;

4)在该样本点周围进行扰动采样(细线的红色十字叉),按照它们到X的距离赋予样本权重;

5)用原模型对这些样本进行预测,并训练一个线性模型(虚线)在X的附近对原模型近似。

这样就可以使用可解释性的模型对复杂模型进行局部解释。

上述方向只是一些示例和思路,具体一些实现可以看看参考文献。

本文只是抛砖引玉,大家如果有更好的思路也可以一起讨论看看有没有论文可发~

参考文献

[1] 可解释性机器学习_Feature Importance、Permutation Importance、SHAP — (https://blog.csdn.net/weixin_44803791/article/details/109776357)

[2] 机器学习模型可解释性进行到底 —— SHAP值理论(一) — (https://zhuanlan.zhihu.com/p/364919024)

[3] 机器学习可解释性Lime方法小结 — (https://zhuanlan.zhihu.com/p/193152643)

[4] LIME - Local Interpretable Model-Agnostic Explanations – Marco Tulio Ribeiro — (https://homes.cs.washington.edu/~marcotcr/blog/lime/)

[5] “Why Should I Trust You?” Explaining the Predictions of Any Classifier— (https://arxiv.org/pdf/1602.04938)

文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷