OpenAI o1:用内部思维链进行复杂推理 原创 精华

本篇将介绍OpenAI o1。

OpenAI o1,这是一种新的大型语言模型,经过强化学习训练,可以执行复杂的推理。O1 在回答之前会思考 - 在响应用户之前,它可以产生一个很长的内部思维链。

OpenAI o1 在竞争性编程问题 (Codeforces) 中排名89百分位,在美国数学奥林匹克竞赛 (AIME) 资格赛中跻身美国前 500 名学生之列,在物理、生物和化学问题的基准 (GPQA) 上超过了人类博士水平的准确性。

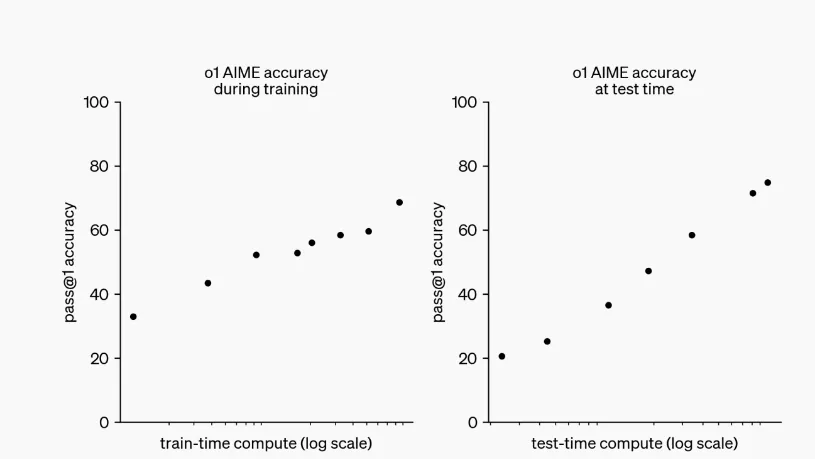

OpenAI的大规模强化学习算法教会模型如何在高度数据高效的训练过程中使用其思维链进行高效思考。OpenAI发现,随着强化学习(训练时计算)的增加和思考时间的增加(测试时计算),o1 的性能会不断提高。扩展这种方法的限制与 LLM 预训练的限制有很大不同。

训练时计算和测试时计算增加都有助于提升o1表现

评测

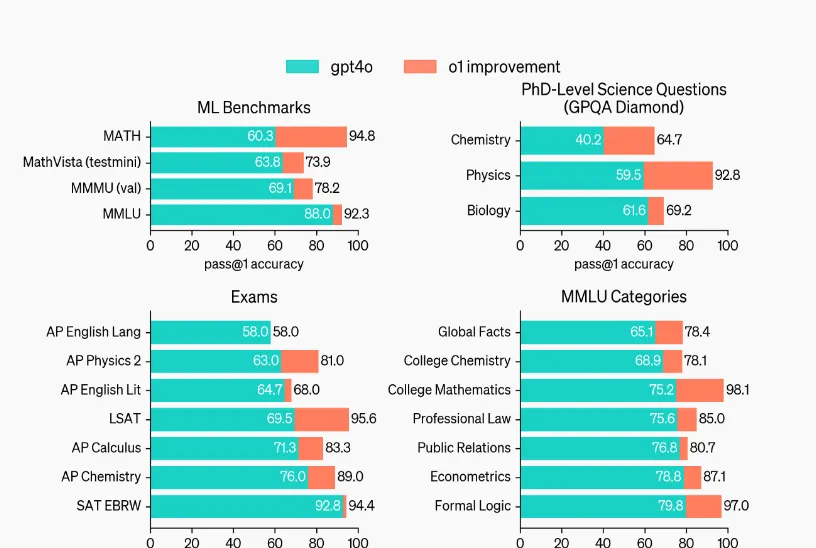

通过大范围的测试可以证明o1的推理能力显著强于GPT-4o

在许多推理密集型基准测试中,o1 的性能可与人类专家的性能相媲美。AIME 是一项旨在挑战美国最聪明的高中数学学生的考试。在 2024 年 AIME 考试中,GPT-4o 只解决了 12% (1.8/15) 的问题。O1 平均 74% (11.1/15), 每个问题只有一个样本;在 64 个样本中达成一致时,o1达到83% (12.5/15) ;在使用一个习得的评价函数给 1000 个样本时重排序时,能达到93% (13.9/15)。13.9 分的成绩跻身全国前 500 名学生之列,高于美国数学奥林匹克竞赛的分数线。

OpenAI 还在 GPQA 上评估了 o1,这是一个困难的智力基准,用于测试化学、物理和生物学方面的专业知识。为了将模型与人类进行比较,OpenAI 聘请了具有博士学位的专家来回答 GPQA 问题。OpenAI 发现 o1 的性能超过了那些人类专家,成为第一个在此基准测试中做到这一点的模型。这些结果并不意味着 o1 在所有方面都比博士更有能力——只是说该模型更擅长解决一些博士应该解决的问题。在其他几个 ML 基准测试中,o1 的改进超过了最先进的。开启视觉感知能力后,o1 在 MMMU 上的得分为 78.2%,成为首个与人类专家竞争的模型。在 57 个 MMLU 子类别中,它还在 54 个子类别中的表现优于 GPT-4o。

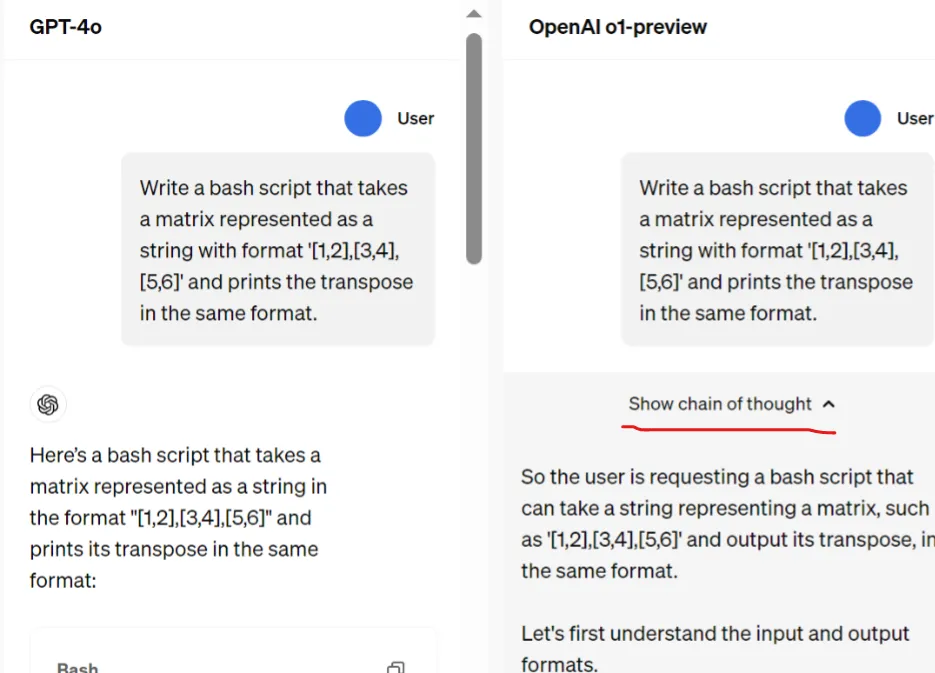

CoT

类似于人类在回答困难问题之前可能会思考很长时间,o1 在尝试解决问题时使用思维链(CoT)。通过强化学习,o1 学会磨练其思维链并改进它使用的策略。它学会识别和纠正错误。它学会了将棘手的步骤分解为更简单的步骤。它学会了在当前方法不起作用时尝试不同的方法。此过程显著提高了模型的推理能力。

o1在回答时自带内部思维链

编程

OpenAI训练了一个在 2024 年国际信息学奥林匹克竞赛 (IOI) 中获得 213 分并排名第 49 个百分位的模型,这个模型从 o1 初始化并进行训练,以进一步提高编程技能。该模型在与人类参赛者相同的条件下参加了 2024 年 IOI 的比赛。它有 10 个小时来解决 6 个具有挑战性的算法问题,每个问题允许提交 50次。

对于每个问题,OpenAI的系统对许多候选提交的内容进行了抽样,并根据测试时选择策略提交了其中的 50 个。提交的内容是根据 IOI 公共测试用例、模型生成的测试用例和学习的评分函数的性能来选择的。如果OpenAI随机提交,OpenAI平均只会得到 156 分,这表明在比赛限制下,这种策略值近 60 分。

在宽松的提交约束下,OpenAI发现模型性能显著提高。当每个问题允许提交 10,000 次时,该模型获得了 362.14 分——高于金牌阈值——即使没有任何测试时间选择策略。

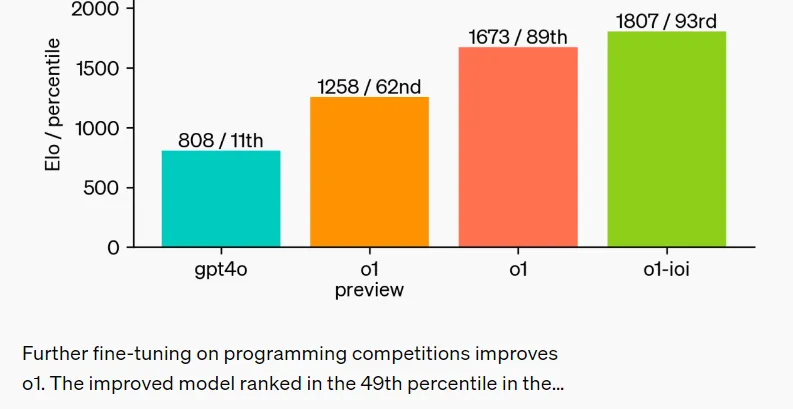

OpenAI模拟了由 Codeforces 主办的竞争性编程竞赛,以展示该模型的编码技能。OpenAI的评估与比赛规则非常匹配,并允许 10 份提交。GPT-4o 获得 Elo 评级 的 808 ,位于人类竞争对手的第 11 个百分位。该模型远远超过了 GPT-4o 和 o1——它的 Elo 评分为 1807,表现优于 93% 的竞争对手。

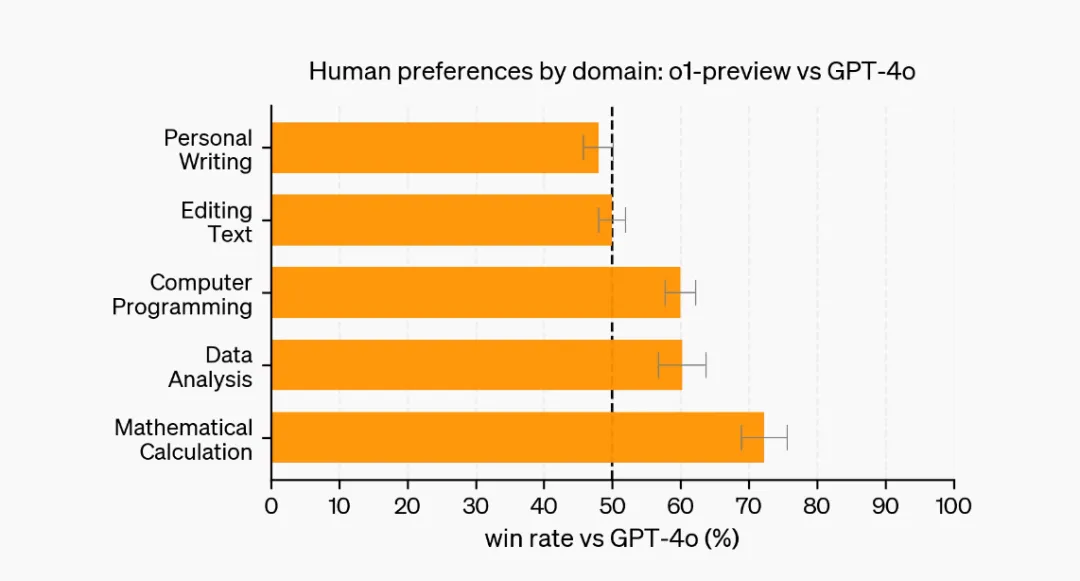

人类偏好评估

除了考试和学术基准之外,还评估了人类对 o1-preview 与 GPT-4o 在广泛领域中具有挑战性的开放式提示的偏好。在这项评估中,人类培训师对来自 o1-preview 和 GPT-4o 的提示进行了匿名响应,并投票选出他们更喜欢哪种响应。O1-Preview 在数据分析、编码和数学等推理密集型类别中比 GPT-4O 更受欢迎。但是,在某些自然语言任务中,o1-preview 不是首选,这表明它并不适合所有用例。

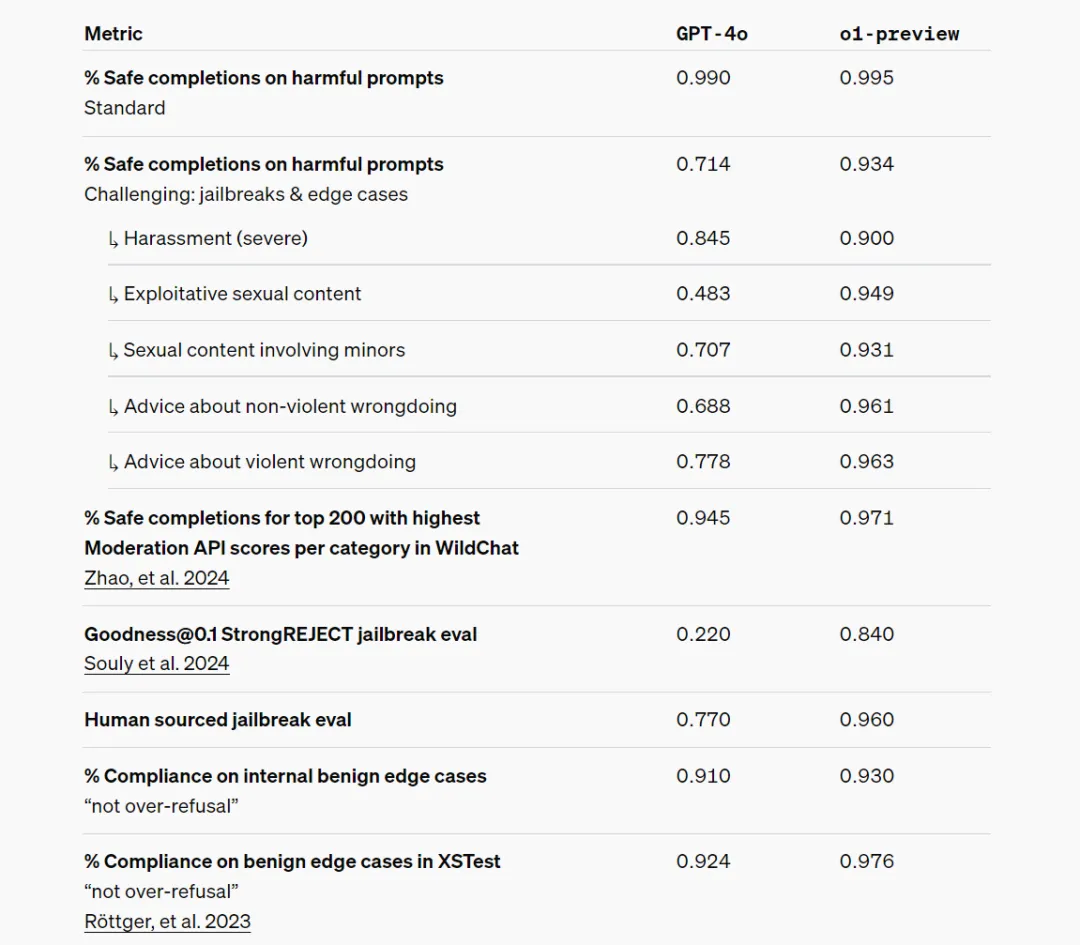

安全

思维链推理为对齐和安全提供了新的机会。OpenAI发现,将模型行为政策整合到推理模型的思维链中是稳健地教授人类价值观和原则的有效方法。通过向模型传授OpenAI的安全规则以及如何在上下文中对其进行推理,OpenAI发现了推理能力直接有利于模型稳健性的证据:o1-preview 在关键越狱评估和评估模型安全拒绝边界的最难的内部基准上实现了显著提高的性能。OpenAI相信,使用思维链为安全性和一致性提供了重大进步,因为 (1) 它使OpenAI能够以清晰的方式观察模型思维,以及 (2) 关于安全规则的模型推理对于分布外场景更加稳健。

为了对OpenAI的改进进行压力测试,OpenAI在部署前根据OpenAI的准备框架进行了一系列安全测试. OpenAI发现,思维链推理有助于评估中的能力改进。

隐藏思维链

OpenAI相信,隐藏的思维链为监控模型提供了独特的机会。假设它是忠实且清晰的,隐藏的思维链使OpenAI能够“读取模型的思想”并理解其思维过程。例如,将来OpenAI可能希望监控思路是否有操纵用户的迹象。然而,要做到这一点,模型必须能够自由地以不变的形式表达其想法,因此OpenAI不能将任何政策合规性或用户偏好训练到思维链上,也不想让用户直接看到一个不对齐的思路。

因此,在权衡了包括用户体验、竞争优势和追求思维链监控选项在内的多种因素后,OpenAI决定不向用户展示原始思维链。它承认此决定有缺点,努力通过教模型在答案中重现思维链中的任何有用想法来部分弥补它。对于 o1 模型系列,OpenAI展示了模型生成的思路链摘要。

文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷

原文链接:https://mp.weixin.qq.com/s/n_cHpeUGJXOfsgQhO4Ka9A

-

-

- PaperAgent 刚刚 最后回复来自 • 套马中汉子

-

-

-

-

-

-

-

-

-

-

-