回复

开源大模型如何治理?斯坦福基础模型研究中心给您支招 原创 精华

人工智能领域正经历着范式转变,基础模型(如GPT - 4、LLAMA 2)处于核心位置,驱动着技术创新和大量投资。这引发了对其监管的广泛需求。而在关于如何监管基础模型的讨论中,模型的发布过程至关重要。近日,由斯坦福大学基础模型研究中心主任Percy Liang领导的论文《Considerations for Governing Open Foundation Models》发表在Science,对开源大模型治理与监管进行了深入探讨,今天我们就一起学习一下这篇重要论文吧!

一、基础模型的发布方式多样

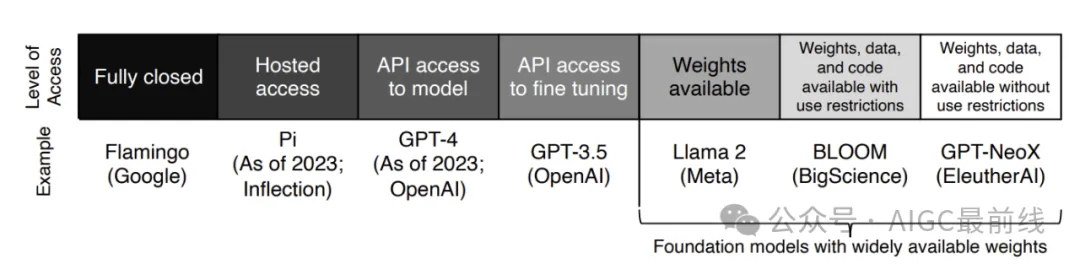

基础模型的发布呈现出多维的态势。从完全封闭(如Google DeepMind的Flamingo,仅模型开发者可用),到有限访问(如OpenAI的GPT - 4,公众可使用但为黑箱模式),再到更开放的形式(如Meta的Llama 2,模型权重广泛可用,允许下游修改和审查)。截至2023年8月,英国竞争与市场管理局的数据显示,公开披露模型最常见的发布方式是开放发布。

二、开放基础模型的利弊分析

(一)优势显著

- 权力分散

- 基础模型创造了新的社会经济权力形式。封闭模型开发者在定义和限制使用案例上权力更大,而开放模型能让下游消费者更好地自己做决策。例如,封闭模型开发者可能通过垂直整合塑造下游市场,导致单一化,而开放模型可避免权力过度集中在开发者手中。

- 创新催化

- 基础模型是通用技术,能大幅提高创新。开放基础模型对多种研究形式是必要的,如可解释性工作、水印技术开发、安全研究以及模型训练和推理效率技术等。它更具可定制性,能提供更深入的访问,是创新的关键要素。据预测,到2032年生成式AI将成为1.3万亿美元的市场。

- 确保透明

- 数字技术存在不透明问题,而基础模型开发者的透明度很重要。2023年基础模型透明度指数显示,主要的开放基础模型开发者平均比封闭模型开发者更透明,在供应链各部分的透明度上都表现更好。这种透明度有助于避免过去不透明数字技术带来的危害。

(二)风险存争议

- 生物风险

- 有研究称开放基础模型可指导用户构建生物武器,但证据薄弱。即使模型能提供相关信息,实际制造生物武器还需要实验室的专业知识、设备和经验等。可能更好的政策干预点在下游,比如加强对生物序列购买者的筛选。

- 虚假信息

- 基础模型可能降低生成有说服力的虚假信息的成本。但对于封闭模型提供者来说,拒绝生成虚假信息的请求在技术上可能存在困难,而且虚假信息传播的关键在于传播平台,目前没有证据表明开放基础模型会增加社会对虚假信息的敏感性。

- 网络安全

- 开放代码模型可能提高攻击性网络攻击的速度和质量,但同时网络防御也可能提高。例如谷歌证明代码模型可大幅提高开源软件漏洞检测能力,广泛使用开放模型并配合相关工具投资,可能会加强网络安全。

- 鱼叉式网络钓鱼诈骗

- 基础模型能生成高质量的鱼叉式网络钓鱼邮件,但关键危险在于邮件附带的恶意软件,而不是邮件文本本身。现代操作系统和浏览器有多层防护,而且现有保护措施可能使钓鱼邮件无法到达收件人。

- 语音克隆诈骗

- 现实中出现了语音克隆诈骗案例,但目前不清楚与传统诈骗相比其是否更有效或可扩展。封闭模型开发者可通过一些措施起到威慑作用,如要求用户用信用卡注册并能追溯音频来源。

- 非自愿亲密图像和儿童性虐待材料

- 开放的文本到图像模型在生成此类内容上风险独特,因为其降低了生成门槛。封闭模型在这方面的防护相对更有效,监测封闭模型可阻止此类图像生成。对于此类问题,政策干预在下游平台是否更有效还有待研究。

三、政策对开放基础模型的影响

(一)政策现状

世界各地政府都在出台与基础模型相关的政策。例如,美国行政命令要求国家电信和信息管理局为总统准备一份关于开放基础模型的报告;欧盟对计算量少于1025浮点运算的开放基础模型可能有豁免;英国的AI安全研究所将考虑开源系统等。此外,人工智能伙伴关系也提出了基础模型安全部署的指导方针,不建议对最强大的基础模型进行开放发布。

(二)潜在问题

- 合规负担不均

- 一些政策提案可能对开放基础模型开发者造成不成比例的影响。例如,要求开发者对模型生成的内容负责的立法,会伤害开放开发者,因为用户可修改模型生成非法内容。

- 风险评估不准确

- 一些监管方法可能没有充分考虑开放基础模型相对于封闭模型或现有技术的边际风险。例如,通过对计算密集型模型授权来限制基础模型发布的提案,对于一些低资源需求的文本到图像模型造成的危害可能并不适用。

四、治理建议

- 考虑潜在影响

- 政策制定者应明确考虑AI监管对开放基础模型周围充满活力的创新生态系统的潜在意外后果。在制定政策时,应考虑到开放基础模型在权力分配、创新和透明度方面的社会利益,以及其可能存在的风险。

- 精准定义模型

- 当法规直接涉及开放基础模型时,应仔细考虑用于识别这些模型和开发者的精确定义。仅基于开放权重来制定法规可能不合适,因为恶意行为者可能利用开放数据和源代码(无模型权重)重新训练模型并造成类似危害。

- 直接咨询开发者

- 如果要实施相关干预措施,应与开放基础模型社区进行直接咨询,充分考虑他们的利益。例如,在考虑下游使用责任和严格的内容溯源要求等问题时,要考虑到开放基础模型开发者对下游使用控制有限的情况。

开放基础模型具有重要意义,政策制定应综合考虑其利弊,避免对其创新生态造成不良影响。

本文转载自公众号AIGC最前线

原文链接:https://mp.weixin.qq.com/s/BL9vJGBzt46zAquJ8_qO1w

©著作权归作者所有,如需转载,请注明出处,否则将追究法律责任

标签

已于2024-10-21 10:21:10修改

赞

收藏

回复

相关推荐