VideoLLaMB:创新开源框架,引领多模态长视频理解

随着互联网技术的发展和智能设备的普及,视频内容正以前所未有的速度增长。长视频,尤其是那些包含丰富信息和复杂场景的视频,对于理解人类行为、环境变化以及时间序列事件具有重要价值。然而,随着视频长度的增加,如何有效地处理和理解这些视频内容,成为了人工智能领域中的一个挑战。

- 视频内容的挑战

传统的视频理解模型通常专注于短视频片段,这些片段由于时间跨度小,因此容易处理和分析。但对于长视频,尤其是那些时长可达几分钟甚至几小时的视频,传统的模型往往难以捕捉和理解视频中的长期依赖关系和复杂的语义信息。这导致了在长视频内容的自动分析和理解方面存在显著的局限性。

- VideoLLaMB的兴起

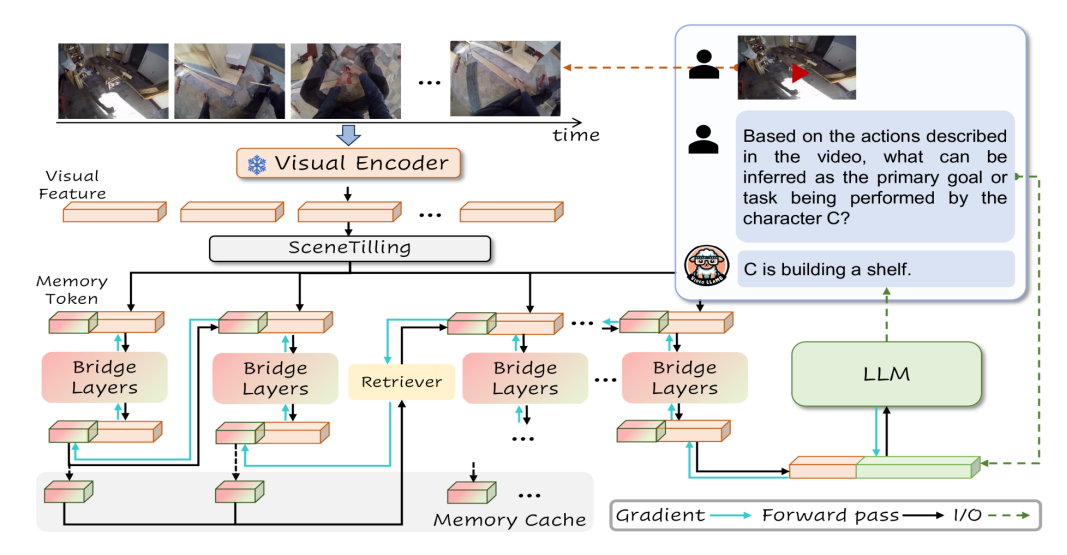

为了克服这些挑战,研究人员一直在探索新的技术和方法。最近,一种名为VideoLLaMB的新型框架引起了广泛的关注。VideoLLaMB是一种开源的多模态长视频理解框架,它通过引入记忆桥接层和递归记忆令牌来处理视频数据,确保在分析时不丢失关键视觉信息。这种创新的方法特别设计用于理解长时间视频内容,保持语义连续性,并在多种任务中表现出色。

技术特点

VideoLLaMB框架的创新之处在于其对长视频内容的处理能力,它通过以下几个关键技术特点实现了这一点:

1、长视频理解

VideoLLaMB专门设计用于处理和理解长时间的视频内容,包括复杂的场景和活动,而不丢失关键的视觉信息 。这对于实时规划和详细交互等任务至关重要。

2、记忆桥接层

框架的核心是记忆桥接层(Memory Bridge Layers),它使用递归内存令牌(recurrent memory tokens)来编码整个视频序列。这种设计允许模型在不改变视觉编码器和大型语言模型(LLM)架构的情况下,有效地处理和记忆视频内容 。

3、递归内存令牌

递归内存令牌用于存储和更新视频的关键信息。在处理视频片段时,模型更新这些令牌,保持长期依赖性的同时,也能反映当前处理的视频内容 。

4、SceneTilling算法

SceneTilling算法用于视频分割,通过计算相邻帧之间的余弦相似度来识别视频中的关键点,将视频分割成多个语义段。这有助于模型更好地理解和处理视频中的场景变化 。

5、内存缓存与检索机制

为了缓解梯度消失问题并保持长期记忆,VideoLLaMB采用了内存缓存和检索策略。这允许模型在每个时间步存储先前的记忆令牌,并在需要时检索和更新记忆,维持对视频内容的长期理解 。

应用场景

VideoLLaMB框架因其先进的技术特点,在多个领域都有广泛的应用潜力。以下是一些主要的应用场景:

1、视频内容分析

VideoLLaMB能够理解和分析长视频内容,这对于视频内容审核、版权检测、内容推荐系统等场景非常有用。它能够捕捉视频中的细微动作和长期记忆,提供详细的互动和规划支持。

2、视频问答系统

在视频问答(VideoQA)任务中,用户提出关于视频内容的问题,VideoLLaMB能够提供准确的答案。这适用于教育、娱乐和信息检索等领域,能够增强用户的互动体验。

3、自我中心规划

在需要根据视频内容进行实时规划的场景中,比如规划一系列动作来完成某个任务,VideoLLaMB能够提供有效的决策支持。这对于家庭环境或个人助理等场景尤其有用。

4、视频字幕生成

基于其流式字幕生成能力,VideoLLaMB为视频自动生成实时字幕,这对于听障人士访问视频内容或为外语视频提供即时翻译非常有价值。

这些应用场景展示了VideoLLaMB如何帮助不同领域的专业人员更有效地处理和理解视频数据,提高决策质量和操作效率。随着技术的不断进步和优化,VideoLLaMB在未来可能会解锁更多创新的应用方式。

部署实践

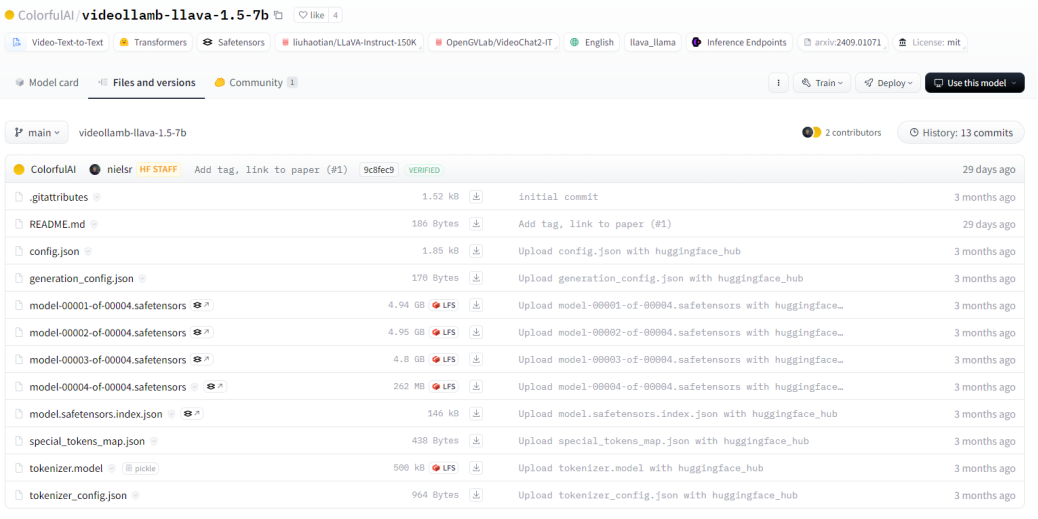

1、下载模型

从huggingface下载相关模型文件

2、环境准备

1)克隆VideoLLaMB仓库

2)创建环境&安装包

3、使用CLI的快速入门

下载模型文件,将其放置到 checkpoints 目录,然后运行以下命令:

4、使用CLI流式传输视频字幕

下载模型文件,将其放置到 checkpoints 目录,然后运行以下命令:

5、Gradio演示

下载检查点,将其放置到 checkpoints 目录,然后运行以下命令:

结语

VideoLLaMB 作为一款创新的长视频理解框架,为人工智能领域在处理长视频内容方面带来了新的突破。它的出现不仅解决了传统模型在长视频处理上的难题,还为多个领域的应用提供了强大的技术支持。相信在未来,随着技术的不断发展和完善,VideoLLaMB 将在更多领域发挥重要作用,为我们的生活和工作带来更多的便利和创新。让我们共同期待 VideoLLaMB 在人工智能领域创造更加辉煌的成就。

相关资料

1. 项目官网:https://videollamb.github.io

2.GitHub仓库:https://github.com/bigai-nlco/VideoLLaMB

3. 技术论文:https://arxiv.org/pdf/2409.01071

本文转载自 小兵的AI视界,作者: 小兵