ICLR'24 | 对比学习引入全周期时间序列信息提升长周期时序预测效果

这篇文章给大家介绍一下ICLR2024中,用对比学习强化时间序列预测的一篇工作。这篇文章是韩国KAIST发表的工作,通过在时间序列预测中引入对比学习,实现对Encoder建模窗口以外全周期时间序列信息的应用。

论文标题:SELF-SUPERVISED CONTRASTIVE FORECASTING

下载地址:https://arxiv.org/pdf/2402.02023v1.pdf

1.背景

长周期时间序列预测一直是业内研究的焦点,但是现有的方法,大多数都是在一个时间窗口内建模,即将原来的时间序列分割成多个片段,每个片段内部单独的进行训练和预测。

比如原来的完整时间序列长度是10000,每个训练的时间序列长度可能只有200。这种只在一个窗口内进行建模的方式,没有考虑完整时间序列的信息。这会导致,两个时间序列片段本来属于同一个完整的时间序列,有一些规律信息是相似的,但是模型在训练时却无法捕捉这个信息。

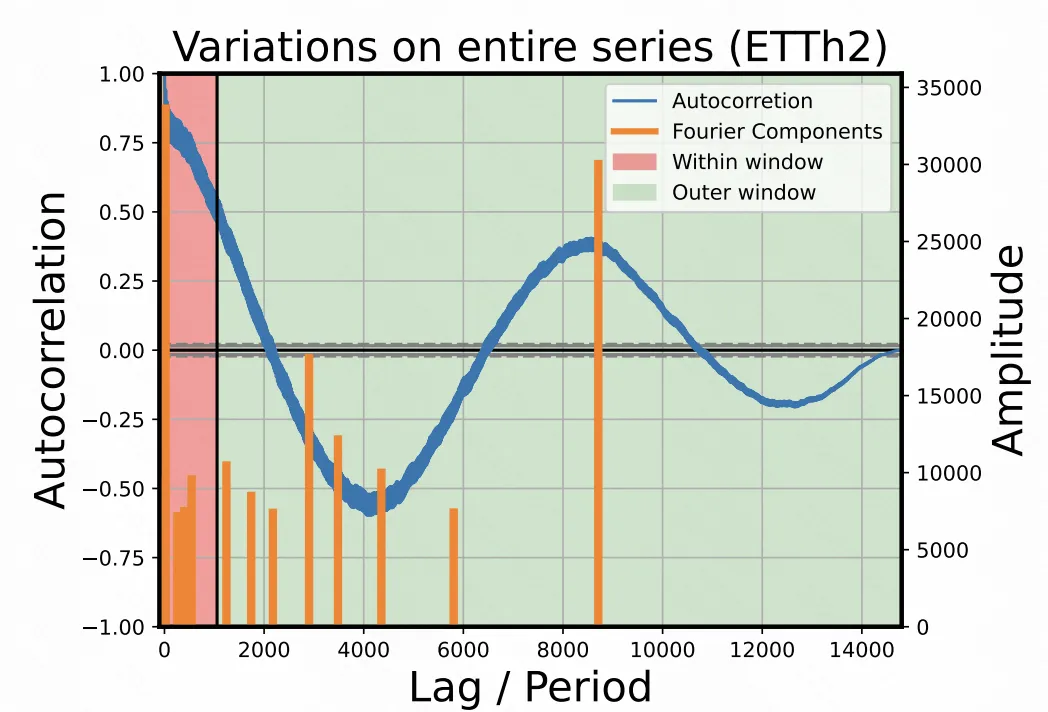

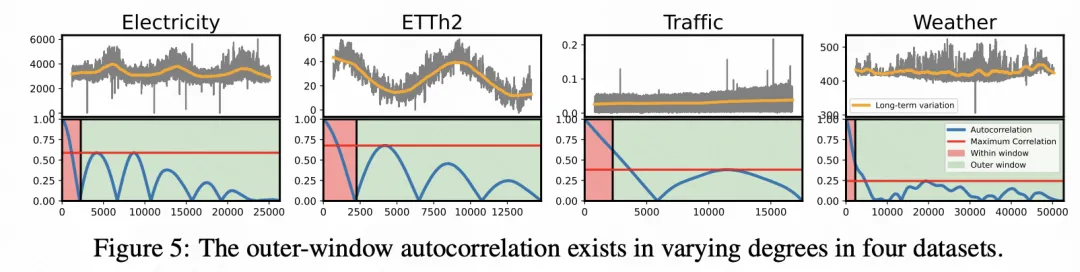

如下图所示,完整的时间序列存在一定的周期性,整个长度为14000。但是如果以一个正常的Encoder长度训练模型,提取的片段完全体现不出这种长周期性信息。

2.建模方法

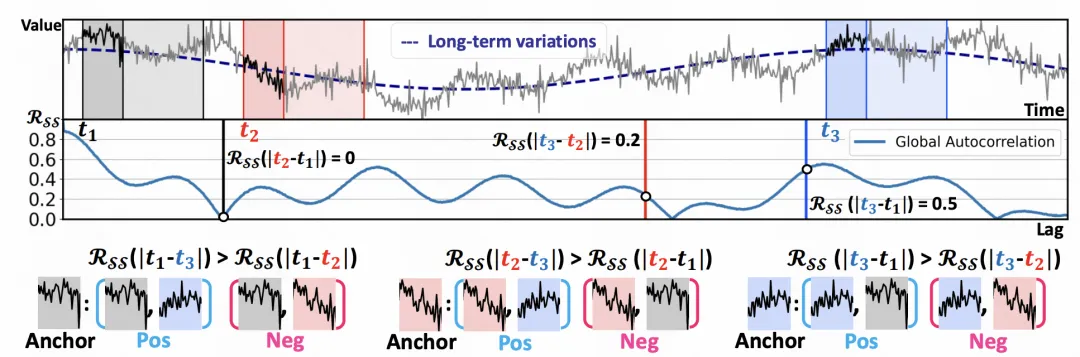

为了解决这个问题,本文的核心提出了一种基于自相关系数的对比学习loss。自相关系数衡量了一个时间序列和自身T个时间步延迟后的相关系数,自相关系数越大,说明时间序列具有更强的T周期性。比如一个完全以年为周期的时间序列,如果把时间序列移动365个时间步,将移动前后的时间序列计算相关系数,其结果是1。

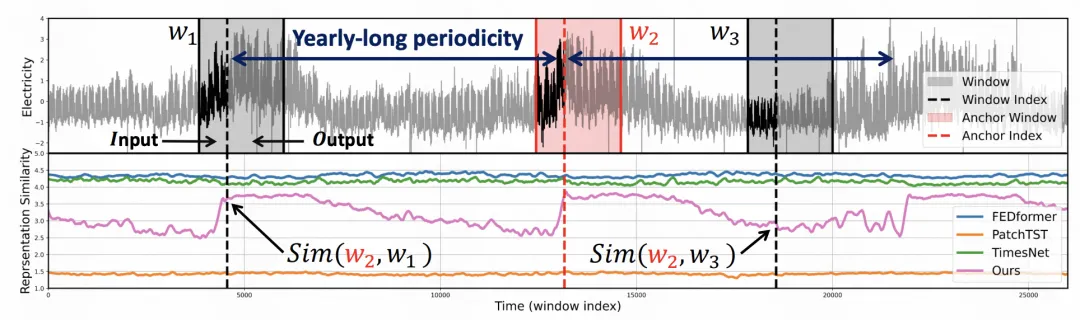

文中便利用这个信息优化时间序列表示的学习。在一个batch内,时间序列是来自同一个完整时间序列的多个窗口(也可能来自多个,本文主要以一个完整序列进行研究),并且这些窗口大概率具有比较大的时间间隔,因为是随机采样的。

首先标记出每两个时间序列之间的时间间隔T,然后计算两两时间序列间隔为T的自相关系数,这个自相关系数刻画了这两个时间序列的相关关系。以这个自相关系数为label,构建对比学习的正样对,并以对比学习为目标优化序列表征。

通过这种方式,实现了利用完整时间序列信息的目的,在表示空间中拉近在完整时间序列中T自相关性系数高的时间序列片段表征。

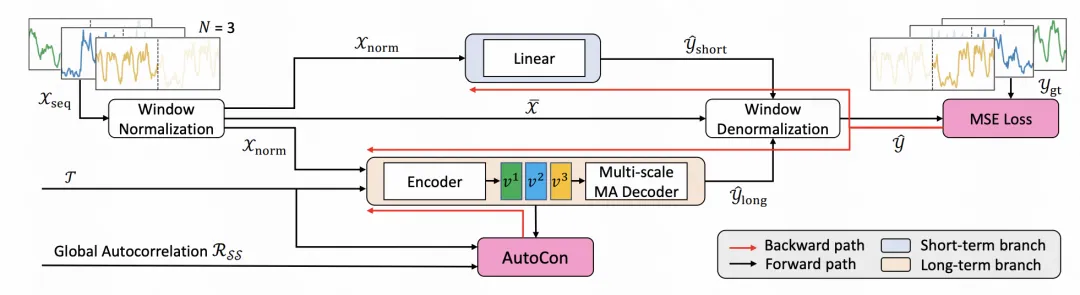

基于上述的对比学习框架,文中提出了一种新的长周期时间序列预测模型。在常见的基于趋势项、季节项分解的时间序列预测模型结构基础上,引入了一个基于上述对比学习提取长周期表示的分支,最后由3个分支融合到一起进行预测。

其中,长周期分支的Encoder部分使用了TCN模型,也可以替换成其他模型。通过ReVIN和逆向ReVIN操作对输入的时间序列进行标准化。最后以MSE为loss进行模型优化。

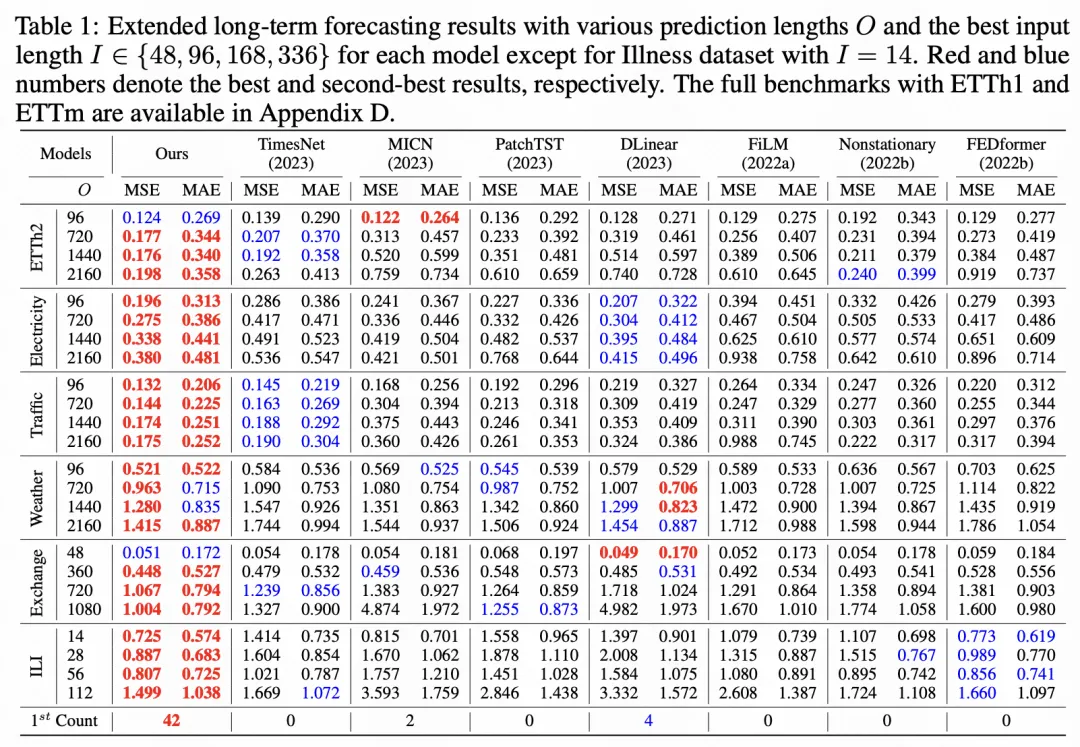

3.实验效果

在实验中,本文对比了多种长周期时间序列预测的效果,本文提出的方法取得了显著的效果提升。

同时,文中也分析了在实验数据集中,窗口外的自相关性是广泛存在的,也从一个角度验证了这种全周期时间序列信息提取的必要性。

本文转载自 圆圆的算法笔记,作者: Fareise