回复

注意力机制的变体之MLA 原创

本文介绍注意力机制的变体-MLA。

MLA(Multi-head Latent Attention),是由杭州深度求索人工智能在DeepSeekV2提出的一种注意力机制变体。MLA主要旨在解决推理过程中由于attention机制中KV Cache占用过多内存而导致的性能瓶颈问题。为此,MLA引入了低秩KV压缩技术,有效减少了KV Cache的大小,从而缓解了这一问题。

有兴趣小伙伴可以看官方技术报告的介绍:https://arxiv.org/pdf/2405.04434v2

原理介绍

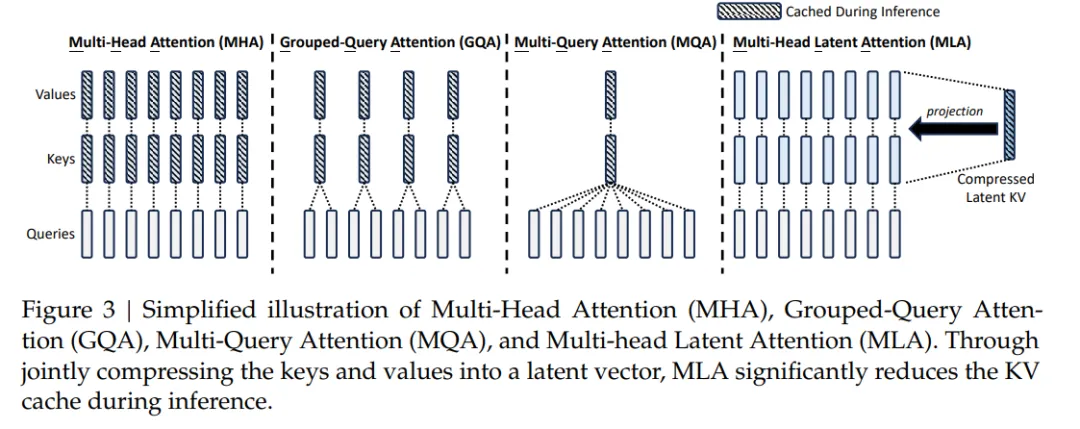

上图为MHA、GQA、MQA、MLA的原理对比图。从上图可知传统Transformer采用MHA,但KV Cache在推理过程中可能成为性能瓶颈。MQA和GQA虽然在一定程度上可以减少KV Cache的占用,但其效果通常不如MHA。MLA通过低秩的Key-Value联合压缩技术,不仅实现了比MHA更优的效果,还大幅减少了所需的KV Cache大小。

具体来说,MLA通过低秩联合压缩key和value来减少kv cache。从注意力机制的步骤来分析:

- 通过输入x乘以不同的矩阵参数Wq、Wk、Wv得到不同的QKV向量

- 在转换到QKV向量时候,将x乘以一个低秩矩阵,得到低阶矩阵表示

- 再通过一个高阶矩阵来恢复原来的特征空间。由于矩阵是模型的权重参数已经保存,所以只需要保存一个低秩的潜层特征就可以恢复成KV,而不是像之前需要同时缓存KV。

代码实现

以上为MLA的核心部分代码实现,里面有相应的代码注释。

本文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷

©著作权归作者所有,如需转载,请注明出处,否则将追究法律责任

赞

收藏

回复

相关推荐