AI数学天才还是数字骗子?GSM-Symbolic揭秘大语言模型的数学推理能力

1、AI模型升级有妙招!"废物利用"让大语言模型更强大

想象一下,如果能把你的旧手机变成最新的智能设备,是不是很酷?在AI领域,研究人员就实现了类似的"魔法"!他们提出了一种叫做"upcycling"的方法,可以将现有的大语言模型(LLM)升级成更强大的"专家混合模型"(MoE)。这项技术不仅能提高模型性能,还能大幅节省训练成本和时间。

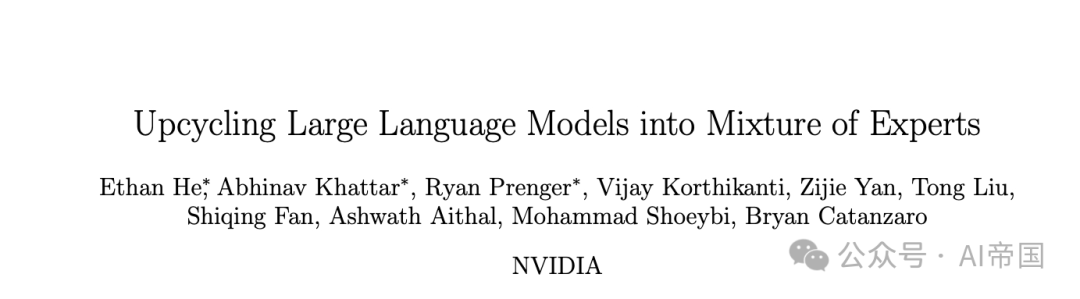

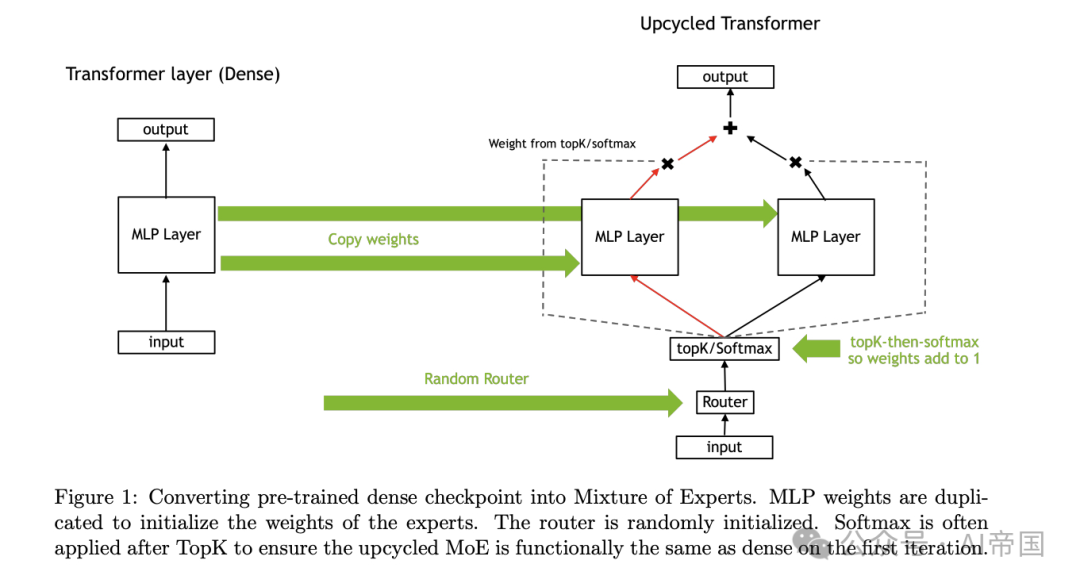

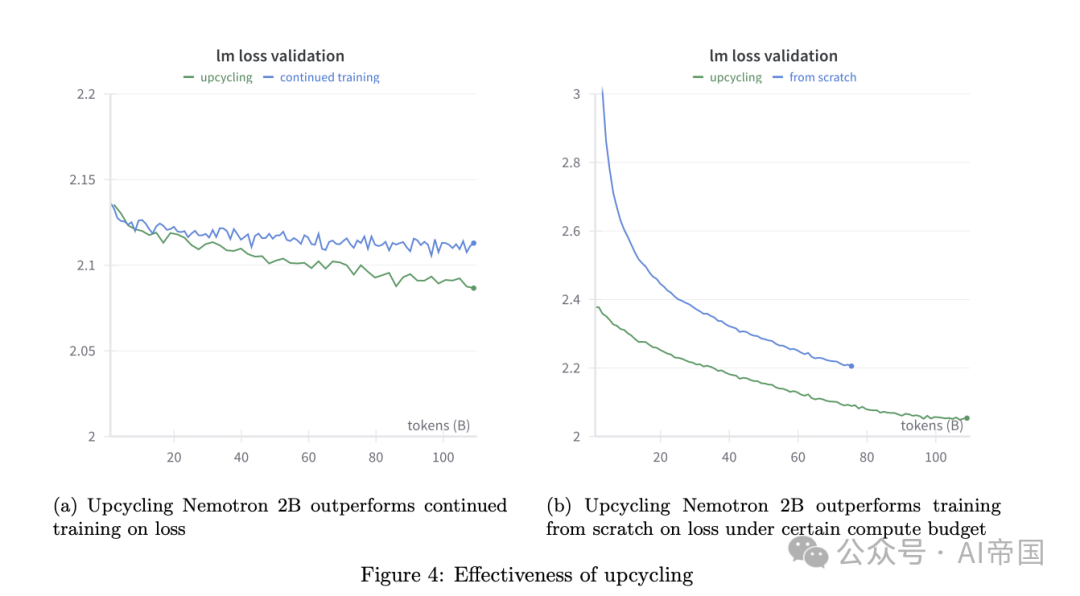

那么,这种"升级魔法"是如何实现的呢?研究团队进行了大量实验,探索了各种升级技巧和参数设置。他们发现,通过精心设计的训练方案、新颖的"虚拟分组"初始化方法,以及巧妙的权重缩放策略,可以让升级后的模型性能显著提升。更令人兴奋的是,他们还发现了一种新的"专家路由"方法,让模型在处理信息时更加高效。

为了证明这种升级方法的威力,研究人员对Nemotron-4 15B模型进行了升级实验。结果令人惊喜:在相同的训练数据量下,升级后的模型在MMLU测试中的得分从65.3%提升到了67.6%。这意味着,通过"upcycling",我们可以让现有的AI模型变得更聪明、更高效,而无需从头开始训练新模型。

这项研究不仅为AI领域带来了新的发展方向,也为我们提供了一种全新的思路:如何更好地利用和提升现有资源。在未来,我们可能会看到更多的AI模型通过这种"升级魔法"变得更加强大,为各行各业带来更智能、更高效的解决方案。AI的未来,也许就藏在这种创新的"废物利用"中!

论文标题:Upcycling Large Language Models into Mixture of Experts

论文链接:https://arxiv.org/abs/2410.07524

2、AI数学天才还是数字骗子?GSM-Symbolic揭秘大语言模型的数学推理能力

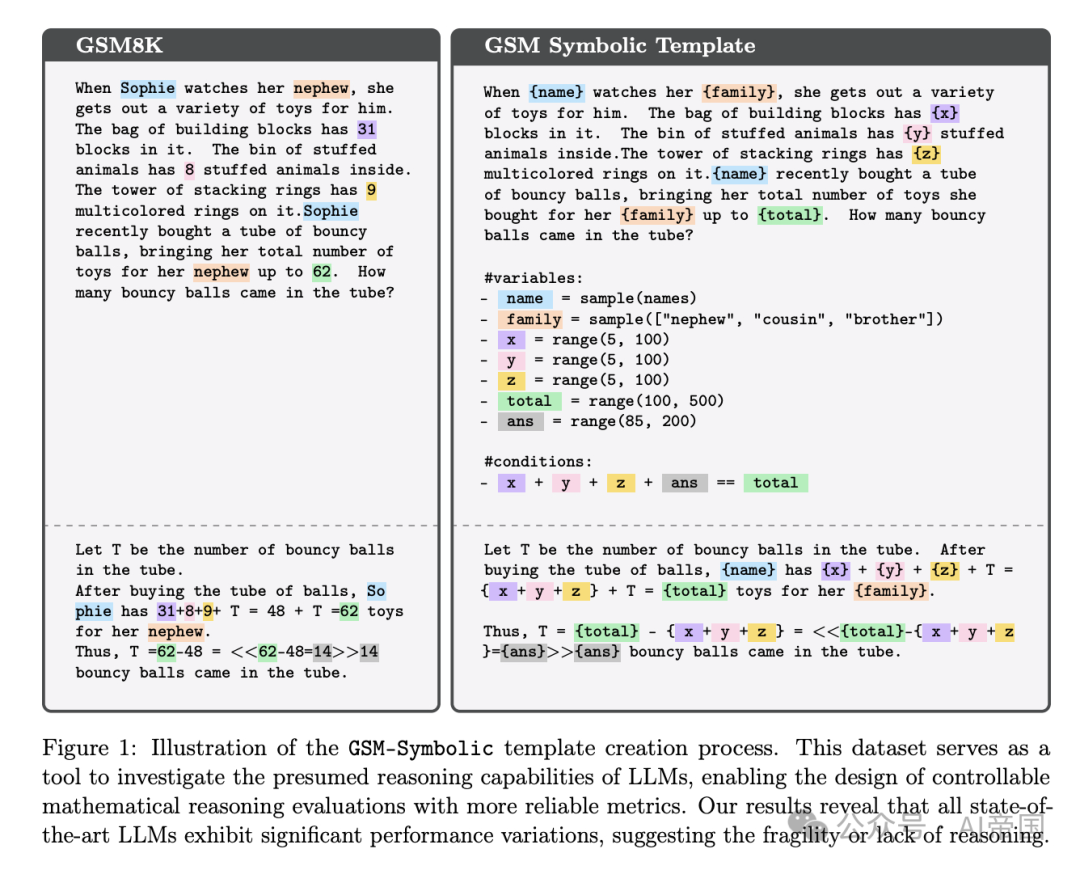

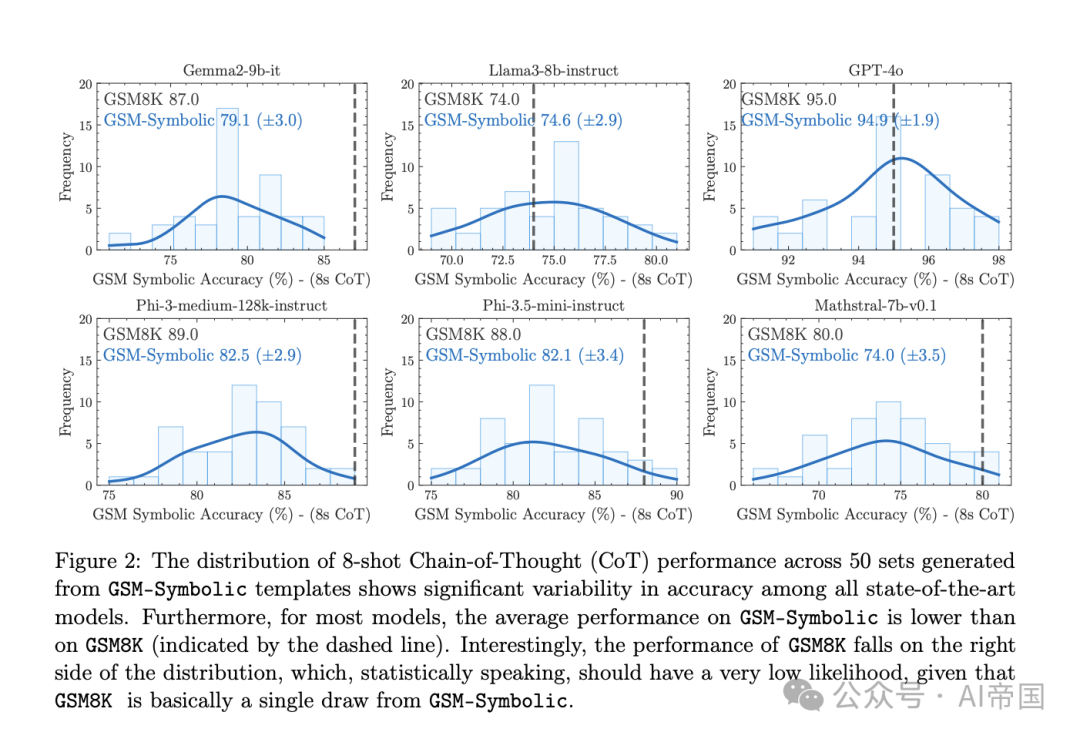

你可能听说过AI在数学测试中表现惊人,但它们真的懂数学吗?最新研究GSM-Symbolic给出了令人深思的答案。研究团队通过创新的符号化模板,生成了大量变体问题,深入探究了大语言模型(LLMs)的数学推理能力。结果揭示,这些AI"数学天才"可能并不如我们想象的那么聪明!

研究发现,当面对GSM-Symbolic生成的新问题时,所有模型的表现都出现了下滑。这不禁让人怀疑,之前在GSM8K测试中的高分是否只是数据污染导致的"假象"?更有趣的是,AI们对人名等表面变化还算"淡定",但一旦数字发生变化,它们就会变得"手足无措"。随着问题复杂度增加,AI的表现更是每况愈下,暴露出其推理能力的局限性。

最令人惊讶的是GSM-NoOp实验。研究者只是在问题中添加了一些看似相关但实际无关的信息,结果AI的表现就大幅下滑,最高降幅竟达65%!这说明AI在分辨关键信息方面还很"幼稚",其所谓的"推理"可能更像是一种模式匹配,而非真正的逻辑思考。即便给AI多个相似例子,它们仍然难以克服这一挑战,暴露出其推理过程中的深层问题。

这项研究不仅揭示了当前AI在数学推理方面的局限性,也为我们提供了一个全新的视角来评估和改进AI系统。它提醒我们,在为AI的"聪明"欢呼之前,我们还需要更深入、更全面的评估方法。未来,如何让AI真正掌握逻辑推理能力,而不是仅仅依赖表面模式匹配,将成为AI研究的一个重要方向。AI的数学之路,似乎还有很长的路要走!

论文标题:GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models

论文链接:https://arxiv.org/abs/2410.05229

本文转载自 AI帝国,作者: 无影寺