自回归视觉生成里程碑!比ControlNet和T2I-Adapter 快五倍!北大&腾讯等重磅发布CAR

文章链接:https://arxiv.org/pdf/2410.04671

项目链接:https://github.com/MiracleDance/CAR

亮点直击

- CAR是首个为自回归模型家族设计的灵活、高效且即插即用的可控框架。

- CAR基于预训练的自回归模型,不仅保留了原有的生成能力,还能在有限资源的情况下实现可控生成——所用数据量不到预训练所需数据的10%。

- 设计了一个通用框架来捕捉多尺度的控制表示,这些表示具有鲁棒性,并能无缝集成到预训练的基础模型中。

- 大量实验表明,CAR在各种条件信号下实现了精确的细粒度视觉控制。CAR有效地学习了这些条件的语义,能够在训练集中未见过的类别上实现鲁棒的泛化。

总结速览

解决的问题:

当前的视觉生成模型主要有两种技术路径:扩散模型和自回归模型。扩散模型在生成控制上表现出色,但自回归模型虽然具备强大的生成能力和可扩展性,控制性和灵活性方面仍然未被充分探索。

提出的方案:

提出了一种名为可控自回归建模(CAR) 的全新框架,该框架可作为插件,整合条件控制机制到多尺度潜变量建模中,允许在预训练的视觉自回归模型中进行高效的控制生成。CAR逐步细化并捕捉控制表示,并将其注入到预训练模型的每个自回归步骤中,以引导生成过程。

应用的技术:

- 多尺度潜变量建模:用于捕捉和细化控制表示。

- 预训练视觉自回归模型:在预训练模型的基础上注入控制,逐步指导生成。

- 条件控制机制:整合到自回归生成的每个步骤中,以实现细粒度控制。

达到的效果:

- 在各种条件下实现了出色的控制能力。

- 在图像质量上优于以往的方法。

- 与预训练模型相比,CAR在实现良好泛化能力的同时显著减少了训练资源需求。

- CAR是首个针对预训练自回归视觉生成模型的控制框架。

方法

首先介绍视觉自回归建模中“下一尺度预测”范式的基础概念。接着解释了CAR框架如何通过多尺度潜变量建模控制视觉生成。通过应用贝叶斯推理,我们识别出CAR的学习目标是获取一个鲁棒的控制表示。最后详细讨论了控制表示的表达以及网络优化策略。

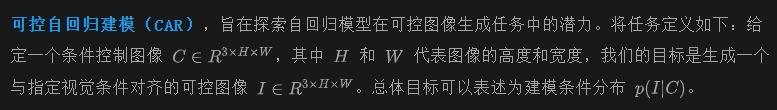

自回归建模的基础知识

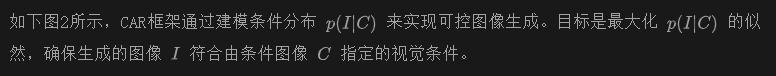

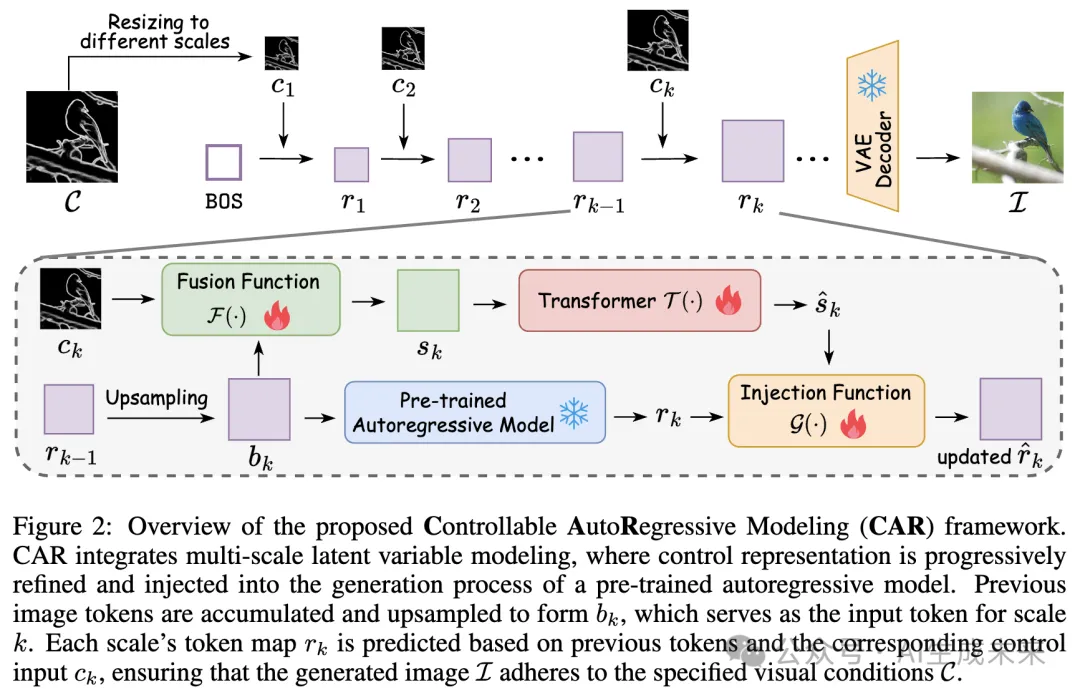

可控视觉自回归建模

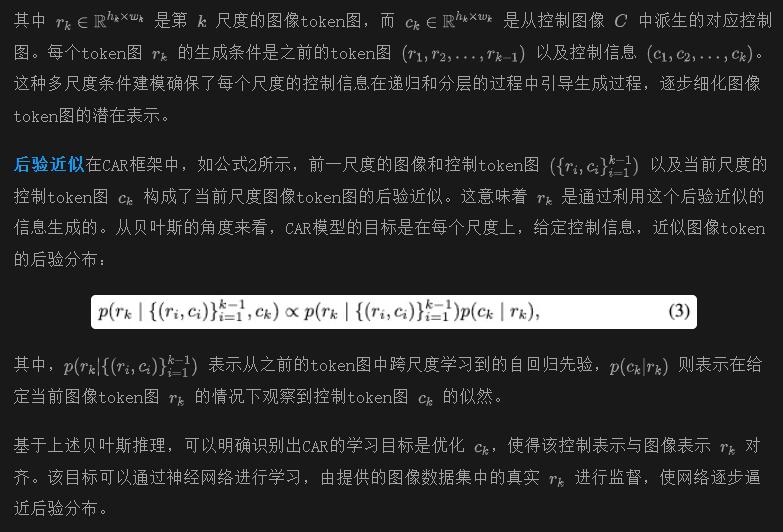

遵循VAR的“下一尺度预测”范式,CAR模型采用了多尺度潜变量框架,其中每个尺度的潜变量(token图)捕捉逐步更高分辨率的图像结构。控制信息提供了额外的观测,用于辅助推断每个尺度的潜变量。

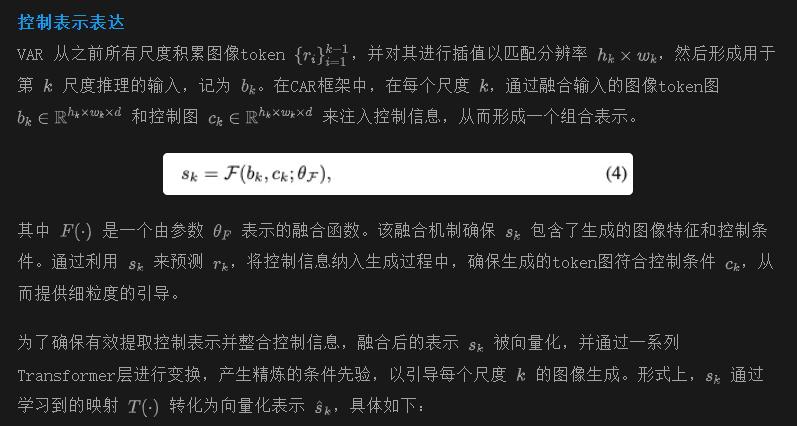

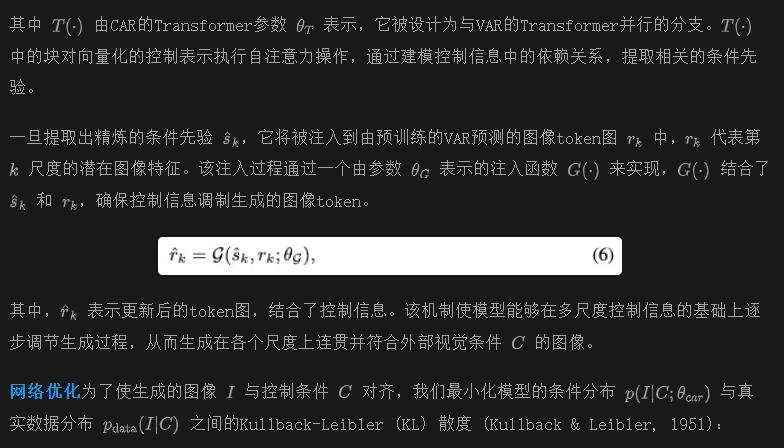

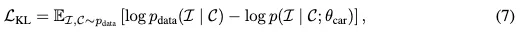

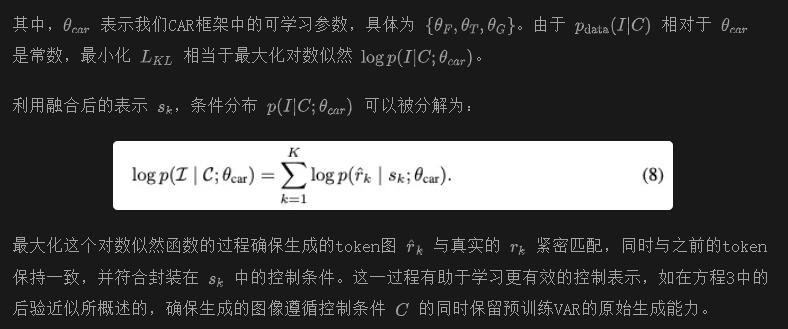

控制表示和优化

控制表示表达

实验

实验设置

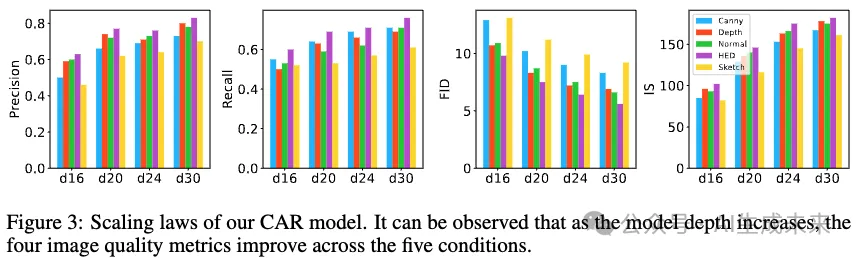

模型架构设计

数据集

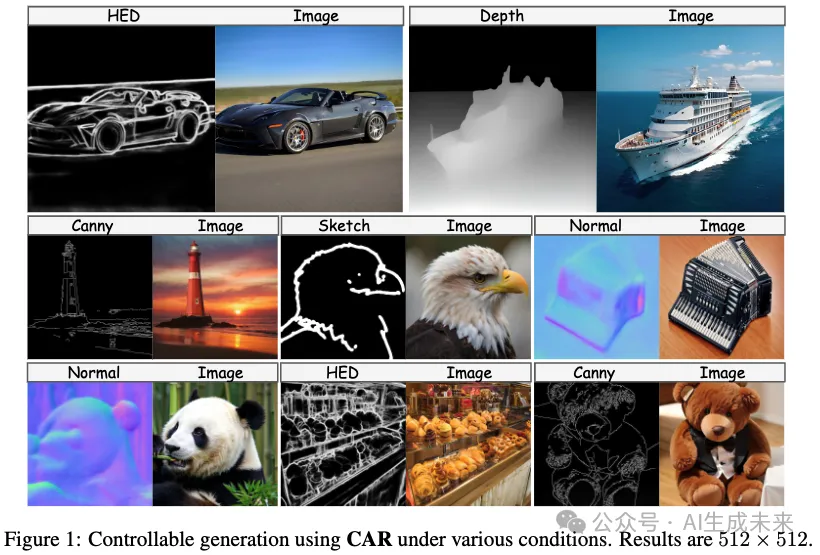

在 ImageNet数据集上进行实验。首先,为训练集伪标记了五个条件:Canny 边缘、深度图、法线图、HED 图和草图,允许 CAR 在不同的条件控制下分别进行训练。从总共 1000 个类别中随机选择 100 个用于训练 CAR,并在剩余的 900 个未见类别上进行评估,以评估其可泛化的可控性。

评估指标

利用 Fréchet Inception Distance (FID)、Inception Score (IS)、精准度和召回率指标来评估生成结果的质量。还与现有的可控生成方法(如 ControlNet和 T2I-Adapter)比较推理速度。

训练细节

将预训练的 VAR 深度设置为 16、20、24 或 30,并使用 VAR 的前半部分的权重初始化控制 Transformer T(.),以加速收敛。CAR 模型在 8 个 NVIDIA V100 GPU 上训练 100 轮,推理速度在单个 NVIDIA 4090 GPU 上进行评估。

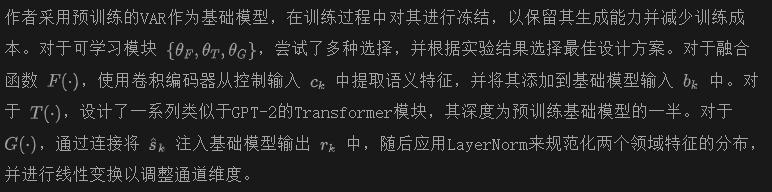

定量评估

与以前方法的比较

将 CAR 模型与两个经典的可控生成基线 ControlNet 和 T2I-Adapter 进行了比较。为确保公平,我们在 ImageNet 数据集上重新训练了这两个模型,并对每个模型在所有五个条件注释上分别进行训练。如下表 1 所示,CAR 显示出显著的改进,FID 分别在 Canny、深度、法线、HED 和草图条件下减少了 3.3、2.3、2.3、3.0 和 5.1,相较于 ControlNet。IS 指标也观察到类似的改进。将这些收益归因于自回归模型的最新进展,这些模型通过在生成过程中逐步扩大分辨率,超越了扩散模型的图像生成能力。除了图像质量外,还比较了推理速度,CAR 的速度比 ControlNet 和 T2I-Adapter 快五倍以上,进一步凸显了 CAR 在实际应用中的效率优势。总体而言,这些令人鼓舞的定量结果表明,CAR 可以作为一种比基于扩散模型的 ControlNet 更高效、可扩展的可控生成范式。

不同类型条件的评估值得注意,HED 图、深度图和法线图显示出相对较优的指标,这可能归因于输入条件的清晰性和明确的目标。这些因素为模型提供了更精确的指导,提升了高质量图像的生成。相比之下,草图条件往往比较简单,仅由基本轮廓构成,视觉细节较少,使其可控性较差,导致模型生成更自由。这可能导致图像质量波动。

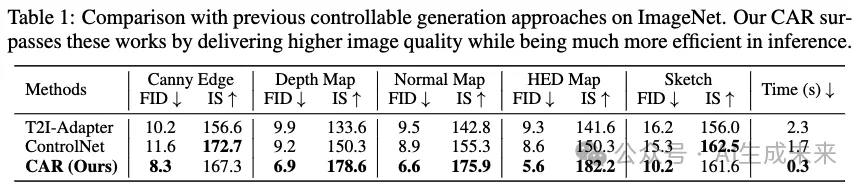

规模法则

评估 CAR 模型在其深度增加时的图像质量。如下图 3 所示,随着模型深度的增加,CAR 在五种不同条件下生成更高质量的图像,表现出更低的 FID 指标以及更高的 IS、精准度和召回率,这与自回归生成建模的规模法则一致。在 HED 图、深度图和法线图中观察到最高的指标,而 Canny 边缘和草图则相对较低,这与表 1 的观察结果一致。

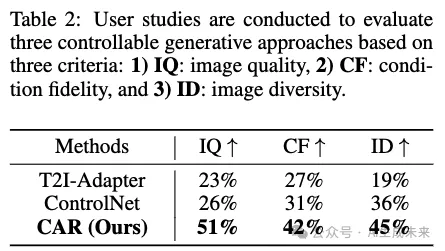

用户研究

研究者们邀请了 30 位参与者进行用户研究,以评估CAR 在与之前的方法 ControlNet 和 T2I-Adapter 的生成性能比较。对于五种类型的条件,输入 30 张条件图像,并为每种方法生成相应的结果,每种方法生成 150 个结果。对于每个条件输入,参与者需要根据三个标准选择最佳结果:1)图像质量,2)条件保真度,3)图像多样性。如下表 2 所示,CAR 在这三个方面均优于 ControlNet 和 T2I-Adapter,证明了所提出的可控自回归建模的有效性。

消融研究

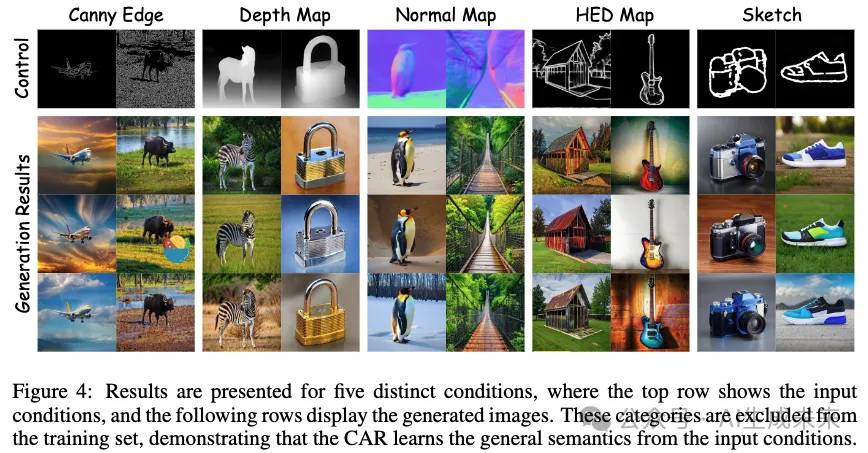

整体可控性和图像质量

下图 4 展示了CAR 模型根据给定的条件控制生成高质量和多样化的结果。各种条件输入的视觉细节在生成的图像中得到了有效反映,确保了图像与其对应条件之间的强对齐。值得注意的是,展示的类别不在训练期间使用的 100 个类别之内,但 CAR 仍然能对这些未见类别实现精确控制,这表明CAR 学会了从给定的条件控制中提取一般语义信息,而不是对训练集进行过拟合。这一优势突显了CAR 框架的跨类别泛化能力和强大的可控性。

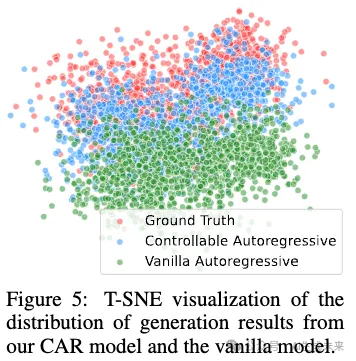

数据分布分析从数据分布的角度分析 CAR 的可控性。具体而言,HED 图被用作一种条件,引导图像生成过程,这一条件是从真实图像中提取的。我们采用一种不可控的传统自回归模型来生成比较样本。我们应用 t-SNE可视化所有生成图像的嵌入特征的前两个主成分。这些嵌入特征是使用 HED 图提取方法的主干提取的。

如下图 5 所示,传统自回归模型的生成分布与真实图像之间存在显著的不对齐,因为传统模型缺乏条件控制信息。相比之下,CAR 模型生成结果的分布与真实图像密切对齐,表明我们的样本准确捕捉了 HED 图的视觉细节,使 HED 嵌入特征更接近真实图像。这突显了CAR 模型增强了基于提供的条件控制 C 生成结果的可控性和准确性。

消融研究

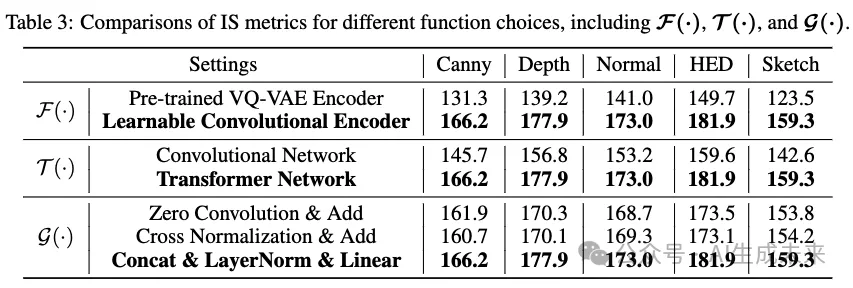

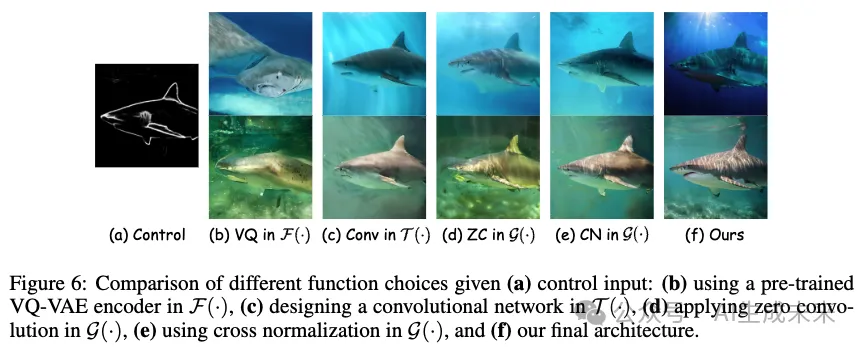

在 ImageNet 验证集上进行消融研究,以探索 CAR 框架中每个组件(包括 F(·)、T(·) 和 G(·))不同功能选择的影响。

F(·) 的不同功能选择

探讨了不同方法引入条件控制 ck 以形成 sk 在 F(·) 中的影响。具体而言,比较了两种策略:1)使用 VAR 模型的预训练 VQ-VAE 编码器直接将条件图像映射到不同尺度的标记图;2)我们的方法,通过像素级调整条件图像至不同尺度,使用共享的可学习卷积编码器进行控制特征提取。

结果如表 3 所示,可学习编码器在 IS 分数上显示出显著改善,表明图像质量得到提升。我们推测,预训练的 VQ-VAE 编码器设计用于图像重建,可能无法有效捕捉图像语义,因此不太适合提取控制语义。图 6 的可视化结果也证明了这一点,使用 VQ-VAE 编码器的生成图像存在失真和质量差的问题。

T(·) 的不同功能选择

我们设计了 T(·) 的编码器以提取准确有效的控制表示 ˆsk。具体而言,我们比较了两种架构:1)简单卷积网络;2)GPT-2 风格的 Transformer。下表 3 和图 6 显示,Transformer 相比简单卷积网络基线在图像质量上显著更高,这归因于其强大的表示能力。同时,基于 Transformer 的编码器与预训练自回归模型的架构相匹配,可能导致更接近的分布,增强后续注入过程。

G(·) 的不同功能选择

我们比较了不同的注入函数 G(·),在预训练自回归模型中将控制表示 ˆsk 注入图像表示 rk,以更新图像表示 ˆrk。具体而言,我们比较了三种技术:1)对控制表示应用零卷积(Zhang et al., 2023),然后加上控制和图像特征;2)应用交叉归一化,使用图像表示的均值和方差归一化控制表示,然后将这两个特征相加;3)我们的方法,将两个表示进行拼接,应用可学习的 LayerNorm 进行归一化,然后进行线性变换以调整通道维度。如上面表 3 所示,无论在加法之前是否应用零卷积和交叉归一化,添加图像和控制特征都会导致 IS 指标下降。这表明这些操作导致的图像质量降低,与我们的方法相比,生成结果在图像质量和自然性上表现较差。我们将此归因于两种不同领域表示的不兼容性。尽管交叉归一化试图对齐领域间的分布差异,但这种操作是不够的。因此,拼接这两个表示,再进行 LayerNorm,更有效地协调条件特征和主干特征,从而解决数据分布中的差异。

结论

本文提出了可控自回归建模(CAR),该模型建立了一种新颖的控制 VAR 生成的范式。CAR 捕捉了强大的多尺度控制表示,这些表示可以无缝集成到预训练的自回归模型中。实验结果表明,CAR 在可控性和图像质量方面均优于现有方法,同时降低了所需的计算成本。CAR 代表了自回归视觉生成的一个重要进展,为各种可控生成任务提供了一种灵活、高效且可扩展的解决方案。

讨论与未来工作

尽管所提出的 CAR 框架在可控视觉生成方面表现出色,但仍面临 VAR 模型固有的一些限制。具体而言,依赖于顺序token预测有时会限制模型的效率,特别是在处理长图像序列或需要在高分辨率下进行精细控制时。CAR 中使用的多尺度注入机制也可以扩展,以探索替代注入策略,例如基于注意力的或自适应注入,以进一步增强控制精度。此外,尽管当前设计在递归方式中优秀地注入了控制信号,但扩展框架以处理更复杂的任务,如视频生成,仍然是未来工作的一个开放挑战。

本文转自 AI生成未来 ,作者:Ziyu Yao等