现实再次给大模型带来沉重打击

论文笔记分享,标题:LLMS STILL CAN’T PLAN; CAN LRMS? A PRELIMINARY EVALUATION OF OPENAI’S O1 ON PLANBENCH

一个偏实验性的文章,这篇文章的主要的结论是。LLMs不擅长规划,LRMs看似有希望,但是希望不大

当故事看把~

规划简单定义就是说,在面对一些较复杂的开放式问题时,需要进行一些搜索以确定最佳的解决方案。这个过程,不仅仅是思考可行的方向,还需要将问题分解成更简单的任务。

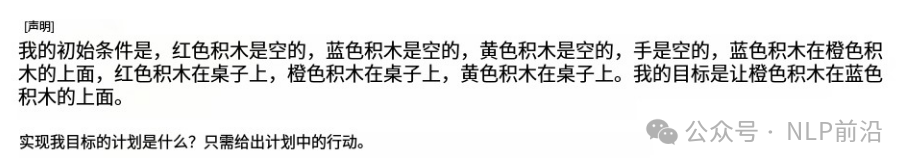

当使用目前最牛的LLM来测试这些能力时候,如下图,对于人来说相对容易解决:

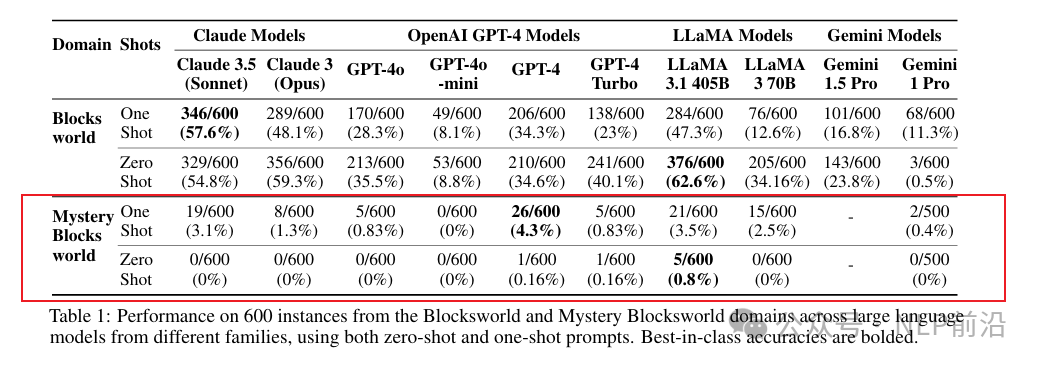

但是结果比较糟糕,Mystery Blocks world 基准结果, ChatGPT、Claude、Gemini 和 Llama 的正确问题率为 0% 。

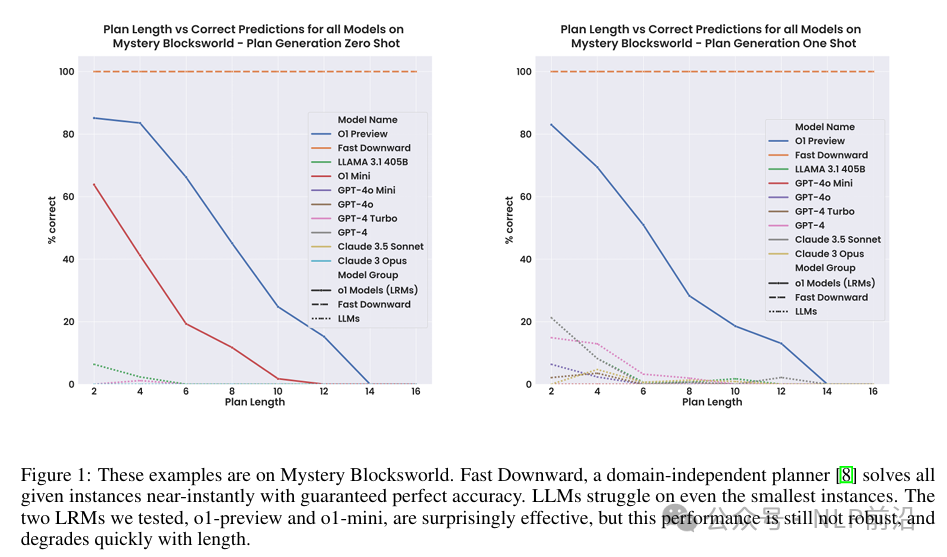

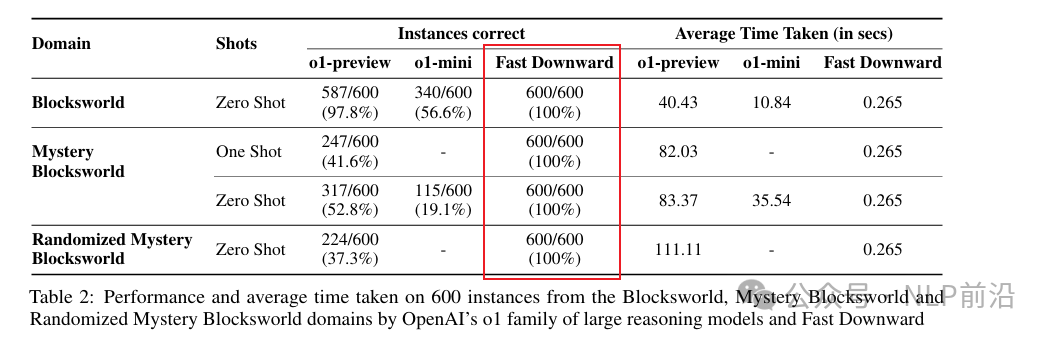

Openai O1目前通过更多的思考,天生就是为了这些复杂的任务而生的,当在相同的数据集上测试, o1 的结果初看确实很惊艳,使第一个简单的数据集达到97.8% 准确率,几乎饱和了。

但是,仔细分析之后,一旦增加计划的步骤数,准确曲线很快就崩溃了,当计划需要 14 个或更多步骤时,准确率会回到 0% 。

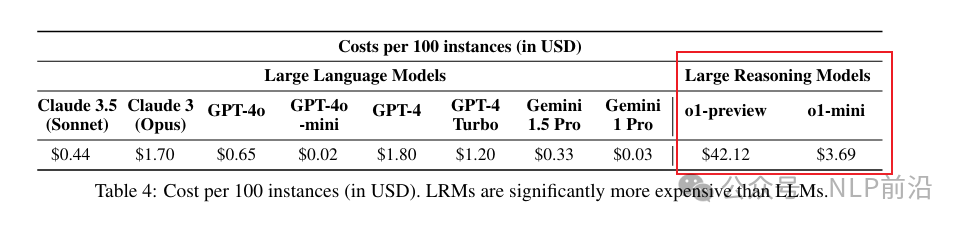

当然,必须考虑到成本问题,生成成本比prompt编码成本高很多。所以相比于LLM模型,LRM模型的推理成本达到了恐怖的100到1000倍

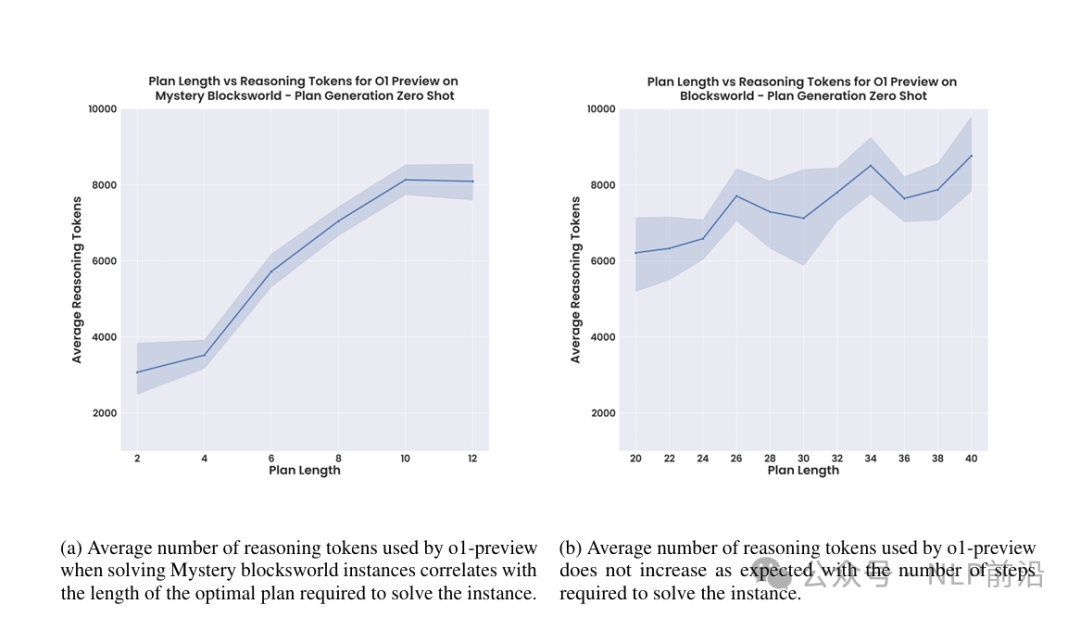

另一方面,模型很容易自嗨看下图,要完成一个需要 20 步的计划,模型需要生成 6000 个token。比实际的单词数量超出了1500+~。

成本与效果的权衡,O1真的值得么?2011年就出现的AI算法,FastForward,在这个评测中可以达到100%的准确率,赤裸裸的贴脸开大。并且,FastDownward 运行速度快且成本便宜。比 o1 型号的成本效益高出几个数量级,并且至少具有三倍的性能。

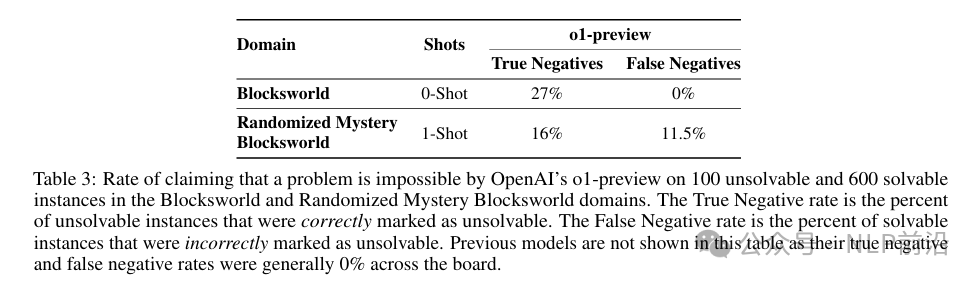

最后,在评估人工智能是否可以承认一个计划,自身是否是无法解决时。o1 表现出,没有能力来评估这个事情。o1-preview 仅在 16% 的情况下将问题识别为无法解决。在很多例子中,模型产生了完全不可行且愚蠢的结果,同时又很能bb。

本文转载自 NLP前沿,作者: 热爱AI