长动画上色质量再创新高!首个基于参考线稿的动画上色视频扩散框架LVCD发布

文章链接:https://arxiv.org/pdf/2409.12960

项目链接:https://luckyhzt.github.io/lvcd

今天和大家分享的工作是香港城市大学、微信团队、香港大学的研究人员提出的,首个基于参考线稿的动画上色视频扩散框架,效果非常好,往下有demo视频展示。

亮点直击

- 第一个基于参考的线稿动画着色视频扩散框架,利用预训练视频扩散模型的能力生成高质量、长时间一致的动画。

- 引入了用于SVD的参考注意力,增强了模型生成快速运动动画的能力。

- 设计了一种新颖的序列采样机制,包括重叠混合模块和前参考注意力,扩展模型以生成具有长期时间一致性的长动画。

解决的问题

现有的视频上色技术主要依赖图像生成模型逐帧对线稿进行上色,导致时间一致性差和对大幅运动处理能力不足。

提出的方案

- 提出了第一个基于参考线稿的视频扩散框架,用于线稿视频的着色。

- 引入了Sketch-guided ControlNet,增强图像到视频扩散模型的可控性,实现基于线稿的动画视频生成。

- 采用Reference Attention技术,帮助在快速和广泛运动的情况下,从参考帧向其他帧转移颜色。

应用的技术

- 大规模预训练的视频扩散模型,用于生成彩色动画视频。

- Sequential Sampling的新方案,结合Overlapped Blending Module和Prev-Reference Attention,克服视频扩散模型固定长度的限制,实现长视频着色。

达到的效果

- 通过定性和定量结果验证,该方法在帧质量、视频质量和时间一致性方面显著优于现有技术。

- 能够生成高质量、长时间一致的动画视频,并有效处理大幅运动,这是以往技术无法实现的。

方法论

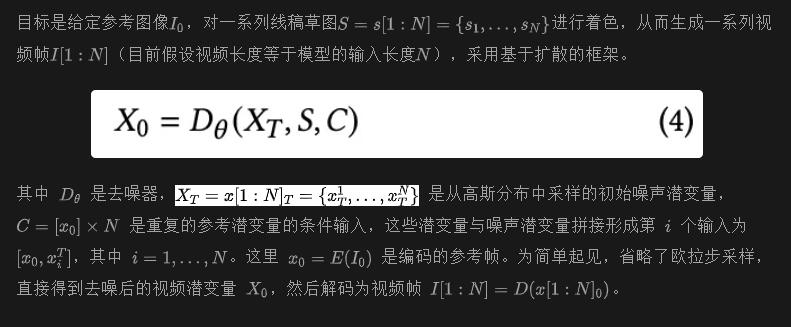

旨在设计一个用于参考线稿视频着色的视频扩散框架,能够生成时间一致的大运动长序列动画。首先,讨论模型架构,包括草图引导的ControlNet和参考注意力,使得模型能够根据线稿草图生成快速和扩展运动的动画。在修改模型架构后,使用动画视频对其进行微调,以执行我们的任务。在推理过程中,扩展原始的SVD,通过序列采样生成长时间一致的动画,结合重叠混合模块和前参考注意力。

模型架构

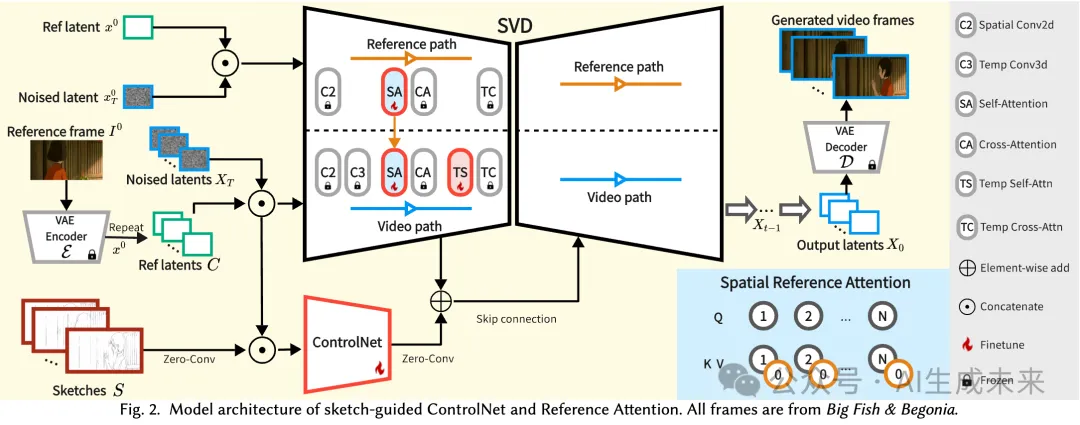

本框架的概述如图2所示。

草图引导的 ControlNet

除了参考图像,另一个关键条件是线稿草图,这在原始 SVD 中并不支持。如图 2 所示,借鉴了 ControlNet的设计,将草图作为附加条件进行整合。首先,复制原始 U-Net 的编码器,克隆所有层,包括时间注意力和 3D 卷积层,以及它们的权重。其次,引入几个零初始化的卷积层来编码线稿草图,并将其拼接到克隆编码器的输入中。最后,将 ControlNet 每层的输出添加到原始 U-Net 解码器的跳跃连接中。在训练过程中,ControlNet 中的所有层都被微调,以生成基于参考图像和线稿草图的动画序列。

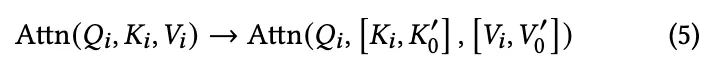

参考注意力

最后,使用公式 (1) 中的损失对修改后的网络进行微调,结合草图引导的 ControlNet 和参考注意力。我们更新 ControlNet 中的所有层,以及 U-Net 中的空间和时间自注意力层,如图 2 所示。

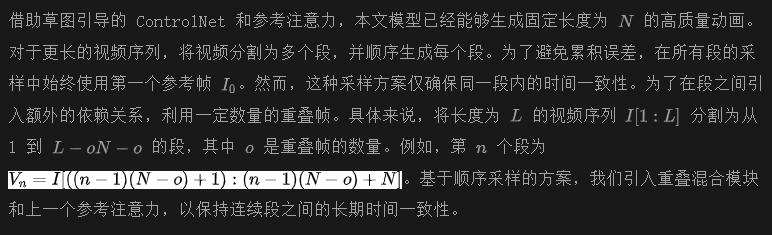

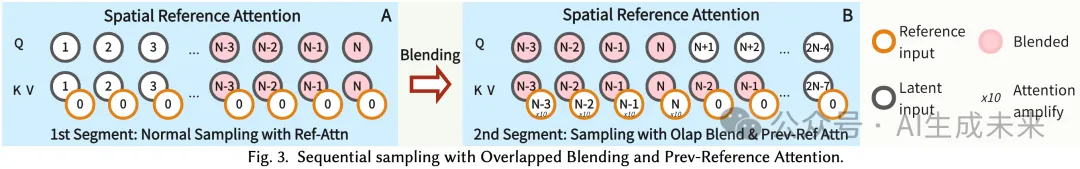

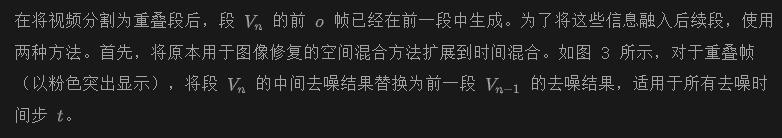

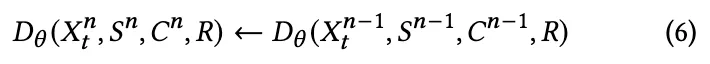

长动画的序列采样

重叠混合模块

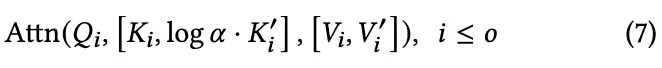

其次,通过参考注意力进一步插入先前生成帧的内容。如图 3-B 所示,我们首先将所有先前生成的重叠帧结果(在橙色块中)作为参考输入送入参考路径,以捕获来自这些输入的完整信息。然后,重叠帧的空间参考注意力定义为:

Prev-Reference Attention

为了有效地将重叠帧的内容传播到远处的帧,进一步提出在空间自注意力层内增强时间传播。如图 3-B 所示,我们将非重叠帧的原始自注意力向左移动三帧。

通过使非重叠帧能够查询来自重叠帧的信息,这些重叠帧的内容通过重叠混合模块恢复为先前生成的结果,有效地保持了连续段之间的内容一致性。

实验结果

实验设置

测试数据集。 选择了四部宫崎骏执导的电影,分别是《哈尔的移动城堡》、《红猪》、《幽灵公主》和《千与千寻》,作为我们的测试集,标记为“相似测试集”,这些电影展现了相似的艺术风格,但内容与训练数据集不同。此外,为了评估我们模型在不同动画风格和内容上的泛化能力,我们选择了三部其他导演制作的电影,包括《大鱼海棠》、《喵小咪》和《罗小黑》,标记为“通用测试集”。将视频分割成片段,并使用与训练数据集相同的方法提取线条草图。对于每个测试集,均匀选择1,000个视频片段进行评估,平均长度为59帧。使用分辨率为256 × 256的光流来测量两个测试集的平均运动,其中排除了静止位置。发现55%的片段的平均运动超过5个像素,28%的片段超过10个像素。

评估指标。 通过四个方面评估彩色动画的质量:

- 帧和视频质量:我们使用FID和 FVD 分别评估生成视频的帧和视频质量。

- 帧相似度:由于动画是基于线条草图和第一帧参考图像生成的,这两者均来自原始动画,我们使用PSNR、LPIPS和SSIM测量生成帧与原始动画帧之间的相似度。

- 草图对齐:为了评估生成帧是否与输入线条草图的结构对齐,提取生成帧的草图并计算欧几里得距离图(ED图),该图测量每个像素到其最近草图的距离。随后,计算欧几里得距离图差异(EDMD),以均方根误差(RMSE)表示,相对于输入草图的平均像素偏移量。

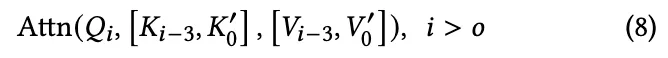

- 时间一致性:将时间一致性(TC)定义为

在这里,( I_{tg} ) 是生成视频中的第 ( t ) 帧,( I_t ) 表示原始帧,而 ( I_{t \to t+1} ) 代表从帧 ( t ) 到帧 ( t + 1 ) 的扭曲帧。这里,利用RAFT [Teed and Deng 2020] 从原始动画中预测的光流用于原始帧和生成帧的扭曲。对于所有指标,将帧大小调整为 ( 256 \times 256 ),并将像素值归一化到 ([0.0, 1.0]) 进行计算。

基于参考的工作比较

将所提方法与两个现有的基于参考的线条视频上色框架进行比较:ACOF (一种基于光流的方法)和TCVC(一种图像到图像框架),这两者都是基于GAN的图像模型。由于没有广泛接受的线条视频上色基准数据集,为确保公平比较,利用我们的数据集生成帧对,以训练ACOF和TCVC,使用它们的官方代码。

对于这两种方法,评估两个版本:原始版本Prev Sample将参考帧更新为先前生成的帧,而修改版本First Sample始终使用第一帧作为参考。考虑到我们的任务中没有基于扩散的框架,我们采用了图像ControlNet ,与AnythingV3一起使用,从Stable Image Diffusion卡通图像和线条控制中微调而来。此外,在采样过程中使用Reference-only提供参考帧作为指导。进一步选择了一项动画插值工作EISAI和一项基于扩散的视频插值工作SEINE进行比较。由于这两种方法在固定间隔内插值颜色化的参考关键帧,首先应用ControlNet + Reference-only方法为每13帧颜色化关键帧,然后应用EISAI和SEINE插值剩余帧。

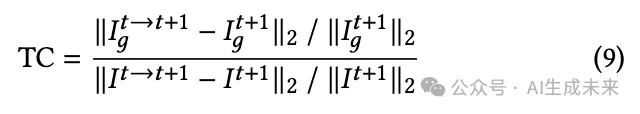

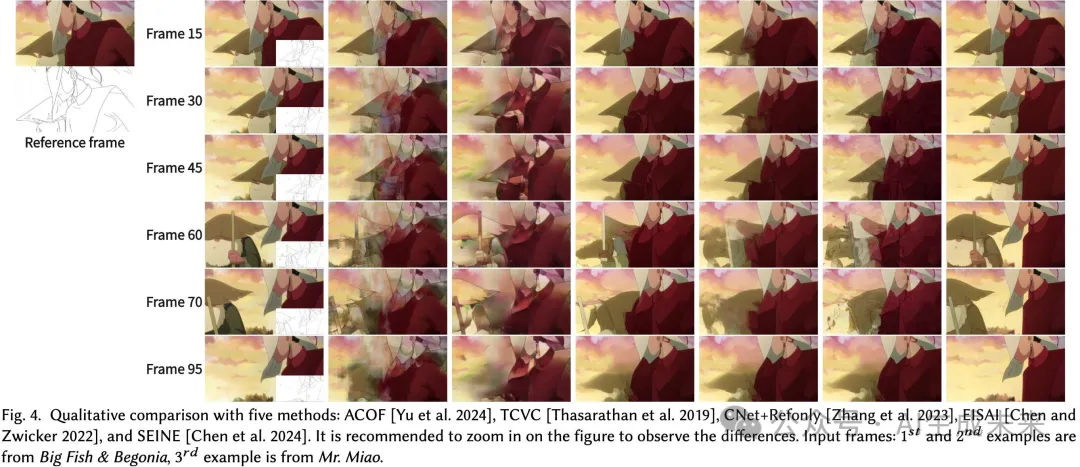

定性比较。

在图4中,展示了三段动画片段的上色帧。在第一个示例中,ACOF和TCVC在使用原始版本Prev Sample时表现出严重的累积伪影。在第二个和第三个示例中,即使使用First Sample,这两种方法在生成与参考帧相比有显著运动的帧时仍然面临困难,导致移动位置出现重影效应。因此,无论是Prev还是First Sample,这两种方法都容易产生某些伪影。这表明,先前基于CNN的方法在有效地对具有大量运动的长序列线条草图进行上色方面存在困难。关于图像ControlNet加上Reference-only的方法,它们仅在运动范围有限时才能成功生成帧。Reference-only技术在推理期间单独应用,而不是与模型一起训练,当对象位移过大时,可能会错误解释参考帧的对应关系,如第一个示例中女孩的红发和第三个示例中帧60和70中的扭曲老人所示。实验突显了图像扩散模型在完成我们的任务中的局限性。对于插值方法,EISAI表现出重影效应,而SEINE产生显著噪声,导致帧模糊(建议放大图像以注意伪影)。这表明,即使提供由ControlNet + Refonly方法生成的关键帧,这两种方法也无法适应我们的任务。

本文方案利用具有长范围空间匹配的基于视频的扩散模型,通过参考注意力,能够生成具有大运动的长期时间一致的动画。例如,在所有示例中,当精灵和角色改变位置时,我们的方法能够准确找到正确的对应关系并有效地对其进行上色。此外,通过结合重叠混合和前参考注意力的顺序采样,我们的方法能够保持长期时间一致性。正如第二个示例中精灵的尾部和第一个示例中生成的头部(不在参考帧中)所证明的,相似的颜色在整个动画中得以保留。总体而言,方法成功地实现了对长序列线条的上色,这是以往工作(包括基于CNN和基于扩散的框架)无法实现的。

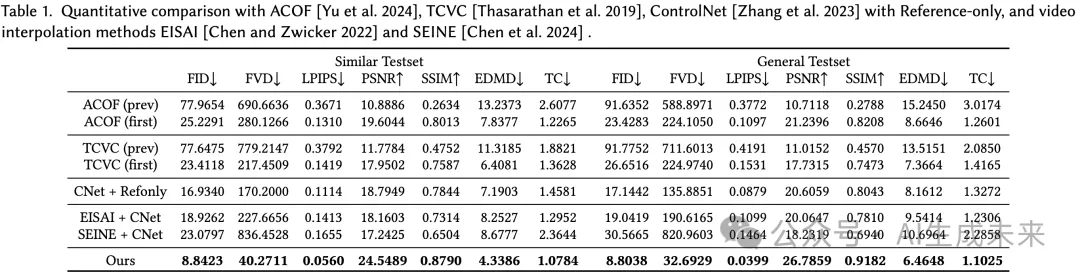

定量比较。在这一部分,在帧和视频质量、帧相似性、草图与真实动画的对齐以及时间一致性等方面对我们的方法与其他方法进行了比较。表1显示,我们的方法在所有方面都显著优于其他方法,尤其在视频质量(FVD)和时间一致性(TC)方面表现突出。这些结果表明,我们的方法能够生成长时间一致的高质量动画,超越以往的工作。此外,我们的方法在训练数据集中能够很好地泛化到不同风格的动画,产生可比的定量结果。总体而言,我们引入了新的度量标准(EDMD和TC),有效评估生成动画的草图对齐和时间一致性,为基于参考的线条视频上色设定了新的标准。

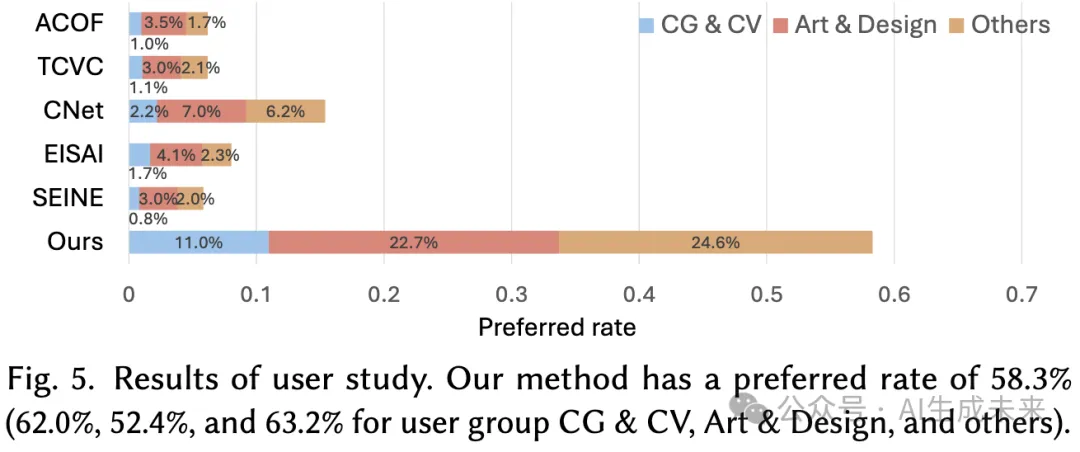

用户研究

进行了一项用户研究,以进一步评估我们方法的性能。在30个动画(15个来自相似测试集,15个来自一般测试集)中,参与者首先看到真实动画和线条草图作为参考,然后是随机顺序生成的动画,包括ACOF、TCVC、CNet+Refonly、EISAI、SEINE和我们的方法。

每位用户需从随机选择的10个问题中选择最佳动画,考虑以下三个方面:

- 与原始动画的相似性

- 与线条的对齐

- 整体质量

在113名参与者中,20名在计算机图形学和计算机视觉(CG & CV)领域工作或学习,49名从事艺术与设计,44名来自其他领域。如图5所示,我们的方法获得了58.3%的最高偏好率,其中CG & CV、艺术与设计和其他领域的用户偏好率分别为62.0%、52.4%和63.2%。

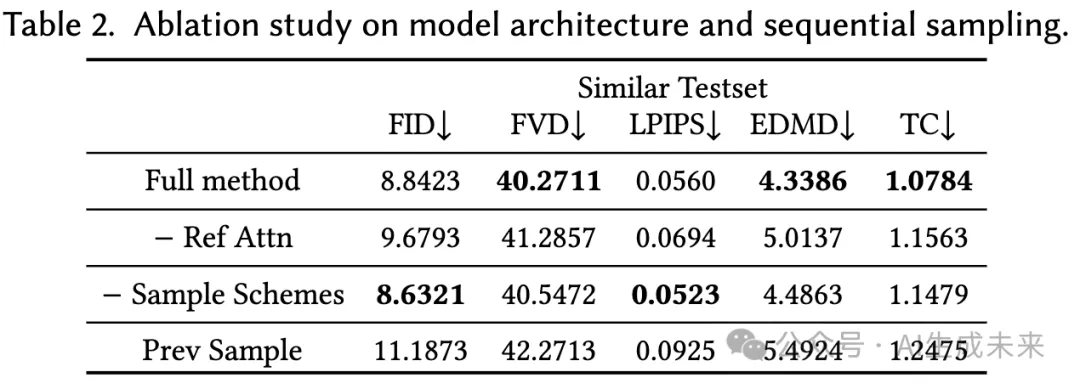

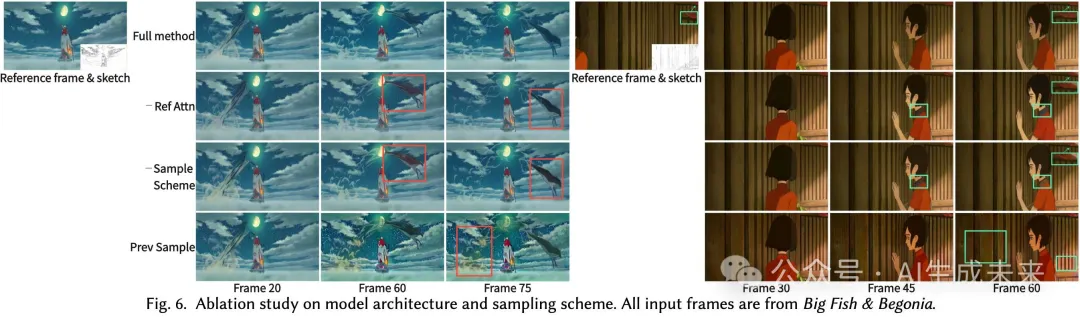

消融研究

模型架构消融。 为了研究方法的效果,我们进行了消融研究,通过去除参考注意力层并使用相同的超参数重新训练网络。表2中的定量结果表明,各项指标均出现下降,显示模型处理大运动动画的能力减弱。从视觉效果来看,如图6所示,缺少参考注意力会导致显著运动区域的不一致和不正确上色,例如右侧示例中的黑色领子,以及左侧示例中鹿的颜色不一致。这些发现突显了参考注意力在增强模型生成高质量大运动动画能力方面的重要作用。

序列采样方案的消融研究。 在表2中,我们将我们的方法与两个变体进行了比较。首先,去除了前面中提到的所有采样方案,仅使用第一个参考帧进行动画采样。对于“Prev Sample”,进一步将参考切换到前一段生成的帧。定量结果显示,去除采样方案会导致时间一致性降低(TC增高),而其他指标保持相似。对于“Prev Sample”,由于使用先前生成的帧作为参考导致的累积误差,所有指标均有所下降。

在图6所示的定性结果中,我们的采样方案表现出优越的时间一致性保持能力。例如,左侧示例中的鹿的颜色和右侧示例中的领子保持了一致,而没有采样方案的结果则出现了不一致。此外,左侧示例中(在绿色框内放大)的“小盘子”逐渐显露出更多区域,我们的方法能够保持与参考图像相似的一致红色。与“Prev Sample”相比,我们的采样方案有效减轻了累积伪影。例如,左侧示例中的蓝天上出现黄色区域,而右侧示例中的墙面在“Prev Sample”下变成了红色。总之,我们的采样方案能够增强长期时间一致性,同时有效解决累积伪影的问题。

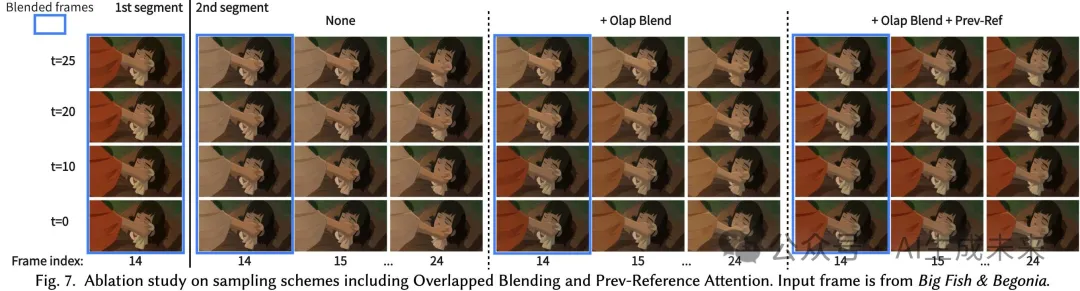

在图7中,分析了两种序列采样方案的效果,即重叠混合(Overlapped Blending)和前参考注意力(Prev-Reference Attention)。我们展示了在𝑡 = 25 → 0时的中间去噪输出,其中第一段的帧14与第二段的帧14重叠。对于没有这两个模块的结果,我们注意到帧14中的内容(即红色袖子)无法从第一段传播到第二段,导致新采样的帧14出现不一致的棕色袖子。在整合重叠混合后,第一段帧14中的红色袖子能够被继承到第二段。最终,结合前参考注意力后,袖子的红色成功传播到帧24,形成了时间一致的动画。

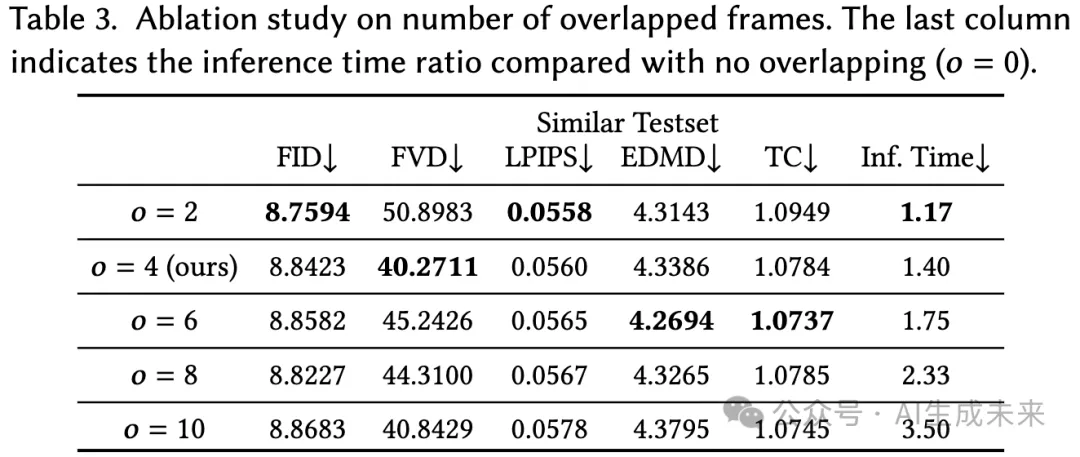

重叠帧数量的消融研究。 将视频序列划分为带有𝑜个重叠帧的段,以进行序列采样。在表3中,分析了不同数量的重叠帧。观察到,将𝑜从2增加到4显著改善了视频质量(FVD)和时间一致性(TC),而其他图像质量指标几乎保持不变。然而,进一步增加重叠帧的数量并未带来显著的改善,甚至在𝑜 = 6和𝑜 = 8时导致FVD下降,同时减慢推理速度。因此,为了平衡推理质量和速度,设置𝑜 = 4个重叠帧是最佳选择。

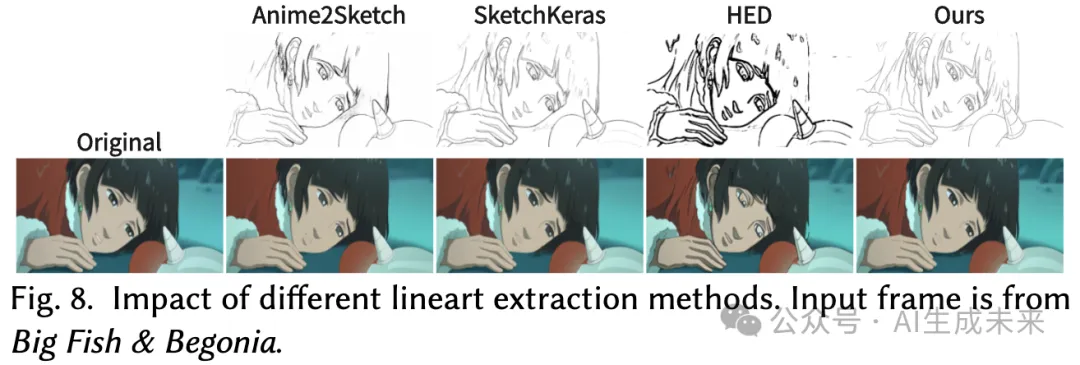

不同线条提取方法的影响

为了评估不同线条提取方法的影响,将训练使用提取的线条的模型应用于使用多种提取方法生成的线条上,包括Anime2Sketch、SketchKeras、HED(使用来自所有层的组合特征)以及我们训练数据集中使用的方法。如图8所示,尽管与我们训练中使用的线条在风格和细节上存在差异,我们的模型仍能为Anime2Sketch和SketchKeras提取的线条生成类似质量的结果,展示了我们方法的通用性。然而,当应用于线条过于粗厚的HED提取线条时,我们的模型倾向于生成粗糙且模糊的动画。这个问题可以通过用不同厚度的线条增强训练数据来解决。

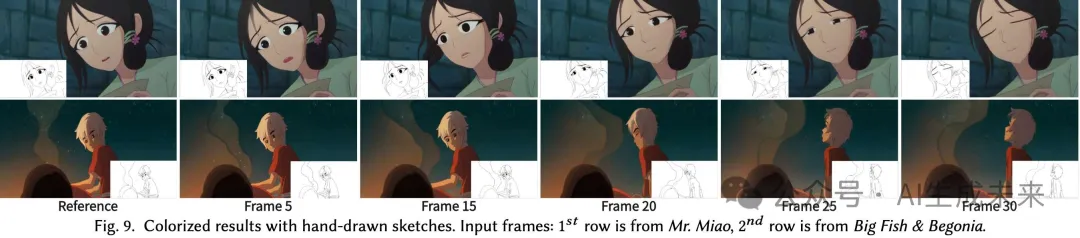

应用于手绘线条

为了验证我们方法的实际适用性,邀请了专注于绘画的学生使用绘图板创作手绘线条草图。然后,利用我们的方法对这些手绘线条进行上色。如图9所示,模型最初是用自动生成的草图训练的,能够无缝地适应手绘线条草图。

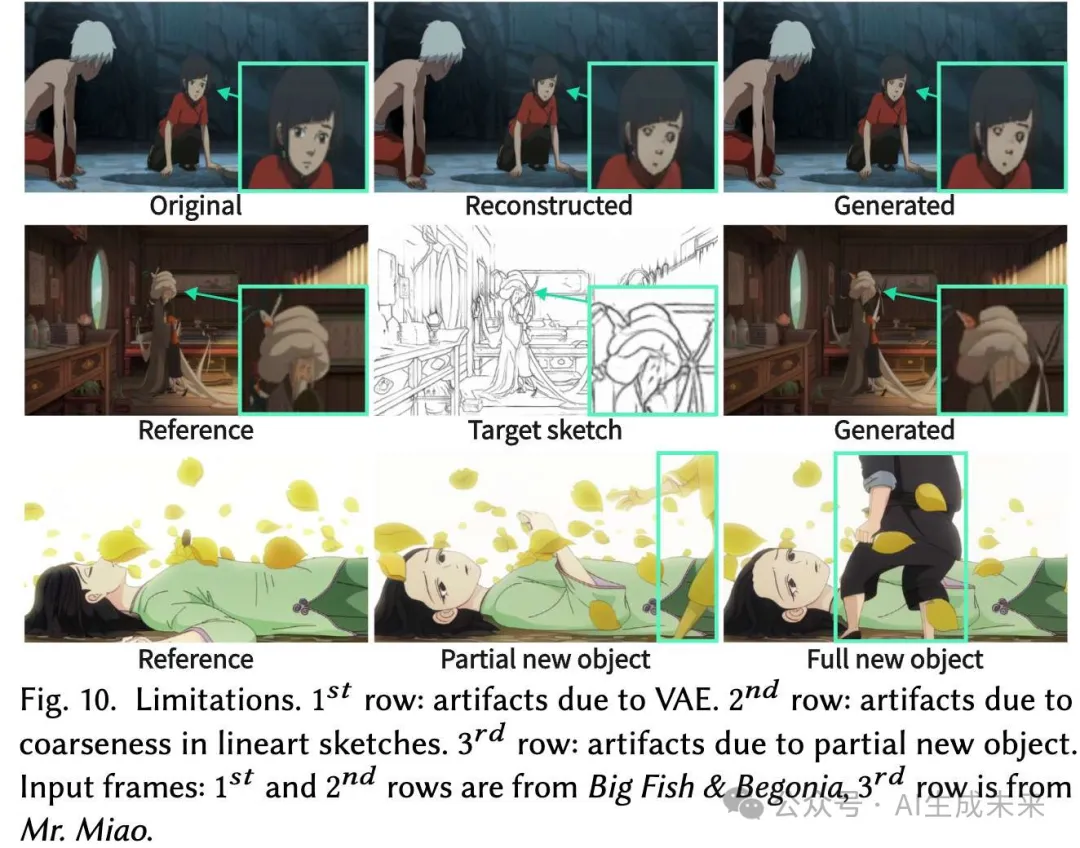

局限性

尽管本文方法有效,但存在两个局限性。首先,由于VAE的重建损失和输入草图的粗糙性,我们的方法在细节上可能会出现伪影。如图10所示,由于重建损失,第一行女孩脸部的细节丢失,而第二行老人的脸由于草图粗糙而模糊。对原始VAE进行微调以适应卡通图像领域以及我们框架中使用的分辨率,并对训练草图进行数据增强,可以缓解这个问题。另一个局限性是对部分可见新对象的上色可能不准确。如第三行所示,当新角色的部分身体进入场景时,其身体被错误地上色为附近花瓣的颜色。只有当角色的全身可见时,上色才会准确。修改我们的视频剪辑算法以包括更多涉及新对象场景变化的案例,可能会帮助我们的模型处理这种情况。

结论

本文提出了第一个基于参考的线条视频上色的扩散框架,解决了先前方法的局限性。方法通过利用预训练的视频扩散模型,能够生成长时间一致且高质量的动画。为了将预训练的SVD适应我们的任务,引入了草图引导的ControlNet进行可控视频生成,并通过Reference Attention使模型能够处理大范围的运动。此外,新型序列采样,包括重叠混合和前参考注意力,扩展了模型生成长动画的能力,同时保持了时间一致性。我们的实验验证了我们方法的有效性,展示了其在处理大运动时生成高质量动画的能力,这是以往工作所无法实现的。由于本框架是通用的,可以应用于其他模态,例如边缘、深度和法线图。在未来的工作中,可能会将方法扩展到由其他模态或甚至多模态指导生成现实视频。通过使用大规模现实视频数据集并利用SVD在类似视频上进行预训练的事实,现实视频生成的性能可以进一步提高。

本文转自 AI生成未来 ,作者:ZHITONG HUANG等