COLM 2024:一种新的深度学习架构——Monotone Deep Boltzmann Machines 原创

在深度学习的世界里,Boltzmann机器是一种很有趣的模型,通过概率来理解数据。想象一下,我们有很多变量,它们之间的关系就像一张复杂的网。Boltzmann机器就是试图描述这些变量之间的概率关系。它有不同的版本,比如深Boltzmann机器(DBM)和受限Boltzmann机器(RBM)。

RBM是一种比较常用的形式,它避免了模型同一层内的连接,这样可以使用更高效的基于块的近似推理方法。但是,我们不禁要问,除了这种限制,还有没有其他的限制方式也能让推理变得高效呢?这就引出了我们今天要介绍的新模型——单调深度Boltzmann机器(Monotone Deep Boltzmann Machines,mDBM)。

一、背景知识

1.平衡模型及其收敛性

首先要提到的是深度平衡模型(DEQ)。它是由Bai等人提出的,就像一个神奇的公式,可以模拟一个无限深度的网络。后来,Winston和Kolter又提出了一种参数化的DEQ(monDEQ),它可以保证收敛到一个独特的固定点。这就像给模型找到了一个稳定的“家”,让它不会乱跑。

2.马尔可夫随机场(MRF)及其变体

MRF是一种基于能量的模型,Boltzmann机器就是它的一种形式。其中,RBM是比较成功的变体,它通过特定的能量函数定义来避免层内连接。但是我们的mDBM不一样,它允许层内连接,更加灵活和强大。

3.并行和收敛的平均场

平均场更新通常使用坐标上升算法在局部收敛。但是有很多研究都在尝试并行化更新。比如Krähenbühl和Koltun提出的方法,还有Baqué等人的方法。我们的mDBM在这方面也有自己的创新,它可以保证在并行更新时收敛到一个全局最优的平均场固定点。

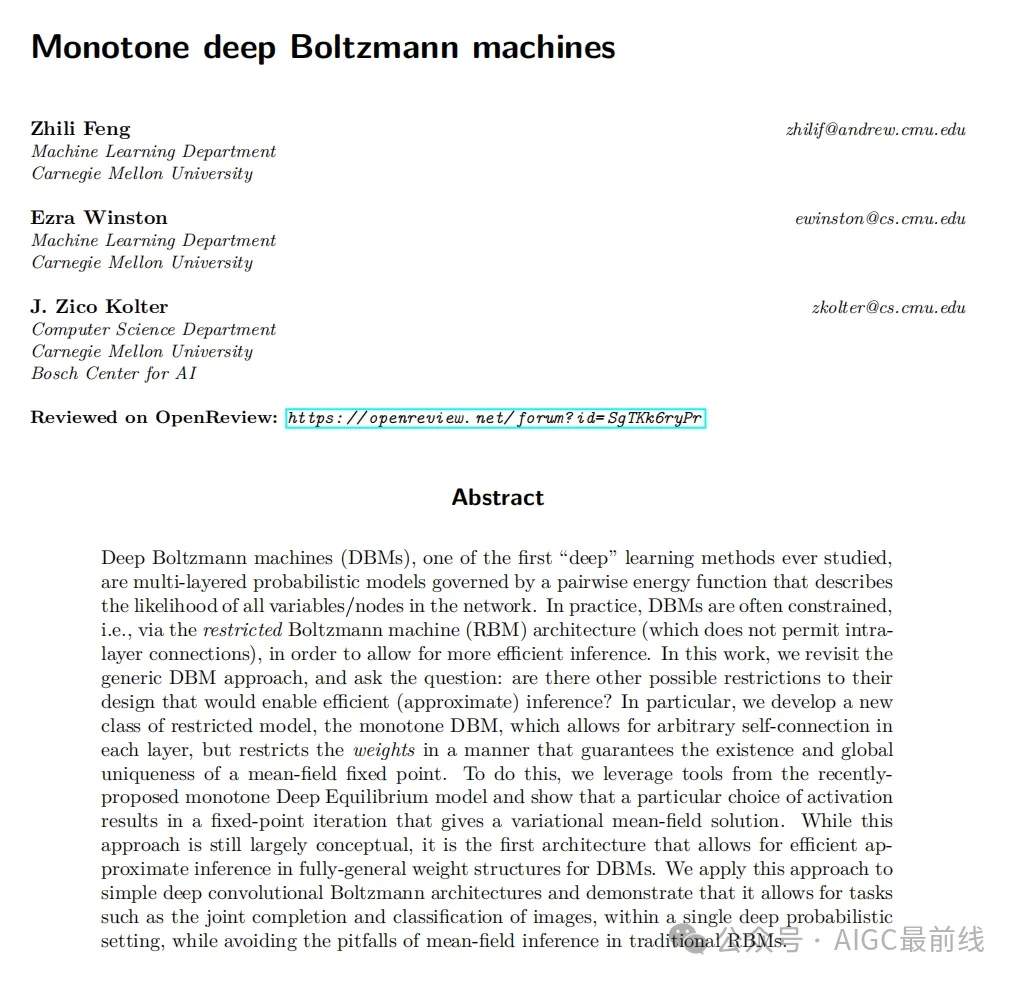

图1:不同玻尔兹曼机的神经网络拓扑结构。一般情况是一个完全图(红色虚线是玻尔兹曼机中有但受限玻尔兹曼机中没有的边的子集)。

二、单调深Boltzmann机器(mDBM)的奥秘

1.单调参数化

- 我们是如何让mDBM变得独特的呢?首先是参数化。我们通过一种特殊的方式来定义模型中的成对势,使得它们满足一定的单调性条件。就像给模型的各个部分设定了规则,让它们按照我们想要的方式“行动”。

- 具体来说,我们定义了一些矩阵和运算,比如通过对矩阵A的处理来得到成对势Φ。这样的参数化既保证了Φ矩阵的空心性,又保证了单调性。

2.平均场推理作为单调DEQ

- 接下来,我们把平均场推理和单调DEQ联系起来。平均场推理是为了近似条件分布,我们发现,在一定条件下,这个平均场固定点可以看作是一个类似DEQ的固定点。这就像找到了两个不同领域之间的桥梁,让我们可以更好地理解和处理模型。

- 而且,我们还证明了在特定条件下,对于任何输入,都存在一个独特的、全局最优的平均场分布的固定点。

3.实际建模考虑

- 在实际中,当我们用mDBM来建模时,需要考虑很多细节。比如变量可能代表深度学习架构中的隐藏单元,我们不能直接表示矩阵A,而是要找到一种方法来计算与A相关的乘法。

- 我们通常会把隐藏单元分成不同的集合,通过卷积层等方式来参数化A。这样可以处理各种复杂的网络结构,比如卷积、全连接层和跳跃连接等。

4.高效并行求解平均场固定点

- 虽然我们保证了单调性,但是简单的迭代不一定能收敛到我们想要的解。所以我们需要使用阻尼迭代。

- 这个阻尼迭代可以在网络的所有变量上并行进行,不需要像传统的平均场推理那样使用坐标下降方法。但是计算这个阻尼迭代中的近邻算子并不容易,我们通过一系列的定理和方法来解决这个问题,包括找到一种数值稳定的计算方法。

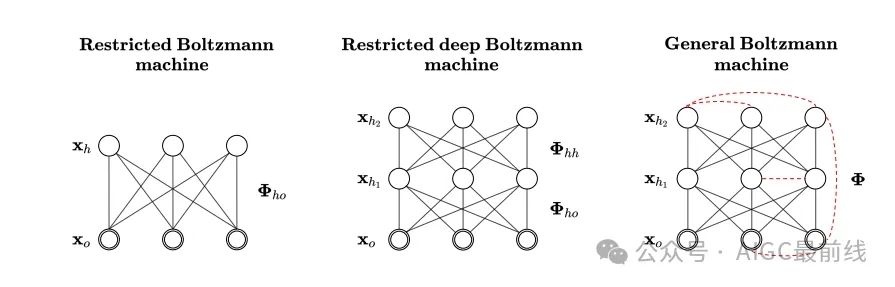

图2:一种可能的深度卷积玻尔兹曼机的示意图,其中单调性结构仍然可以被强制实施

三、训练mDBM的技巧

1.损失函数的选择

- 在训练mDBM时,我们要选择合适的方法。概率模型通常通过近似似然最大化来训练,但是对于我们的mDBM,直接使用平均场近似来训练参数可能不是最好的方法。

- 我们发现,基于边际的损失函数是一个更好的选择。就像给模型一个明确的目标,让它朝着正确的方向学习。

2.具体训练过程

- 给定一个样本,我们首先要解决平均场推理问题,找到隐藏状态的估计值。然后我们可以计算预测值和真实值之间的损失函数,通过这个损失函数来更新模型的参数。

- 在计算梯度时,我们要注意一些细节,比如通过隐函数定理来处理一些复杂的导数关系。而且,由于单调性约束,我们可能还需要对输出边际进行一些处理,比如使用一个可学习的温度参数来调整。

四、实验评估:mDBM的实力展示

1.在MNIST数据集上的表现

- 我们在MNIST数据集上测试了mDBM。我们进行了联合像素插补和分类任务,随机掩盖一部分像素,然后让模型预测缺失的像素和图像的类别。

- 结果显示,mDBM的测试分类准确率达到了92.95%,而传统的深RBM只有64.23%。而且从像素插补的效果来看,mDBM也远远优于RBM。我们还比较了不同比例像素被掩盖时的情况,mDBM在各种情况下都表现出了优势。

- 我们还测试了mDBM在一些特殊任务上的表现,比如随机掩盖14X14的补丁,mDBM也能很好地收敛和预测。

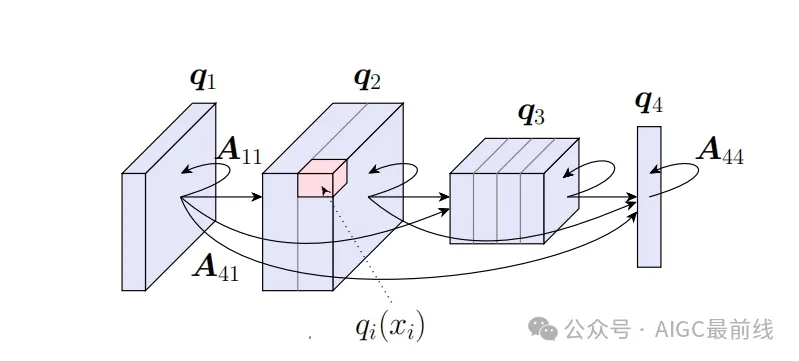

2.在CIFAR - 10数据集上的表现

- 在CIFAR - 10数据集上,我们同样进行了图像像素插补和标签预测任务。当50%的像素被观察时,mDBM模型获得了58%的测试准确率,并且能够有效地插补缺失的像素。

- 与深RBM相比,mDBM在插补误差等方面也表现出了优势。

3.与其他推理方法的比较

- 我们还比较了mDBM的平均场推理方法与其他一些方法,比如Krähenbühl和Koltun以及Baqué等人提出的方法。

- 实验结果显示,我们的方法在收敛速度上更快,而且能够保证收敛到真正的平均场固定点,而其他方法可能存在不收敛或者收敛到错误的固定点的问题。

图3:使用mDBM和深度RBM对CIFAR - 10进行像素填充

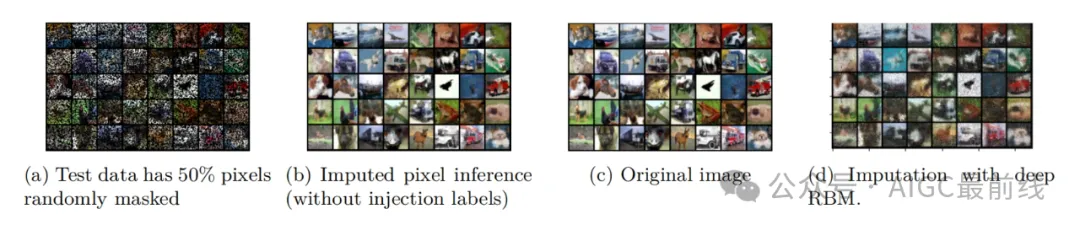

图4:仅将上半部分展示给模型时,使用mDBM对MNIST和CIFAR10进行像素填充。左:观测图像;中:填充结果;右:原始图像。

五、未来方向:探索更多可能

1.单调性条件的改进

目前定理3.1中的单调性条件只是充分条件,不是必要条件。如果我们能改进这个条件,可能会让我们的模型更加灵活和强大。

2.模型的单调性调整

我们可以思考是否可以使用一个负的参数m来让模型“有界非单调”,同时还能保持良好的收敛性质。

3.联合概率建模

我们的模型目前只学习条件概率,是否可以让它更高效地学习联合概率呢?这是一个值得探索的方向。

4.模型的扩展和优化

虽然我们已经有了一个比较高效的实现,但是与一些常见的非线性函数相比,还是比较慢。我们需要找到一种方法来更高效地扩展mDBM。

5.其他概率模型与DEQ框架的联系

我们可以探索更多的概率模型是否也可以在DEQ框架内表达,就像发现更多的宝藏等待我们去挖掘。

六、结论

在这篇文章中,我们介绍了单调深Boltzmann机器(mDBM)。它是一种很有潜力的深度学习模型,通过独特的参数化和推理方法,在处理图像数据等任务上表现出了很好的性能。我们还讨论了它的训练方法和未来的发展方向。希望这个新的模型能在深度学习的领域中开辟出一片新的天地,让我们更好地理解和处理数据。

本文转载自公众号AIGC最前线 作者:实习小毕

原文链接:https://mp.weixin.qq.com/s/RF6TeDxJIA0YXRCqz2QX-g