回复

卷疯了!开源社区离Openai o1越来越近~

小长假结束了~ 本来打算梳理一下假期的信息的,但是内容有点多,放弃了~

今天这个标题对应假期的2个新闻。

- 思科的大佬,假期发了一篇medium博客,使用2个复杂数据集,进行了一系列模型的基准测试。

- Blog: https://medium.com/@harishhacker3010/can-we-make-any-smaller-opensource-ai-models-smarter-than-human-1ea507e644a0

- Prompt: https://gist.github.com/philschmid/34747bf5bc8280f3a5f10f5fd8d1cd4b

- Github: https://github.com/harishsg993010/LLM-Research-Scripts

简单总结

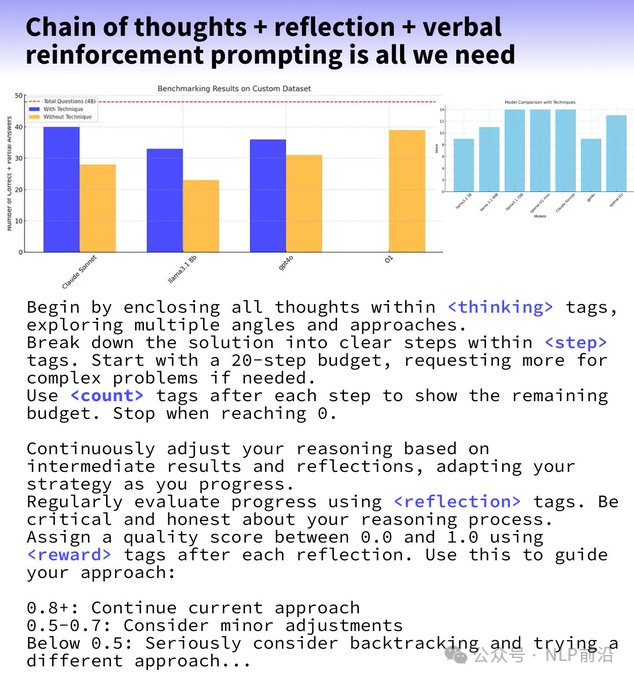

- 🧠 结合动态思维链+反思+语言强化promp,以严格的学术测试为基准(JEE Advanced、UPSC、IMO、Putnam)

- 🏆 Claude 3.5 Sonnet 的性能优于 GPT-4 和匹配的 O1 型号

- 🔍 LLMs可以创建内部模拟并对复杂问题采取 50 多达推理步骤

- 📚 适用于较小的开源模型,如 Llama 3.1 8B +10%(Llama 3.1 8B 33/48 与 GPT-4o 36/48)

- ❌ 由于计算和预算限制,没有像 MMLU、MMLU pro 或 GPQA 那样进行基准测试

- 📈 高token使用量 - Claude Sonnet 3.5 仅 7 个问题就使用了大约 100 万个令牌

- open o1 项目

- github: https://github.com/OpenSource-O1/Open-O1

- space: https://huggingface.co/spaces/happzy2633/open-o1

- hf: https://huggingface.co/O1-OPEN

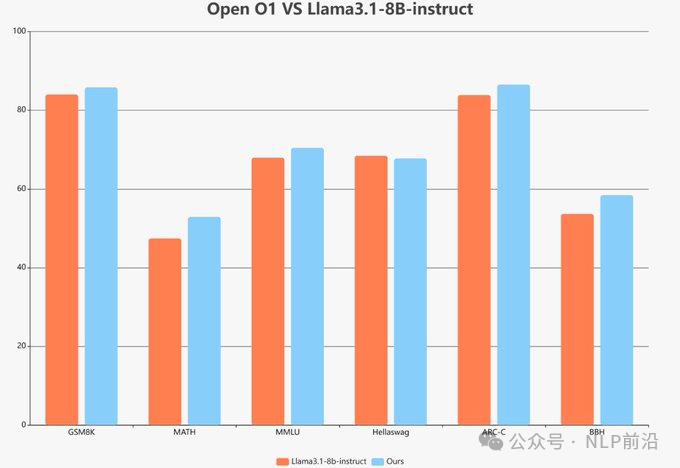

Open-O1 项目,主要是期望对齐闭源 OpenAI O1 模型的强大功能,为社区提供先进的开源替代方案。通过精心筛选一组 O1 风格的思考数据来开发训练,这些数据用于训练 LLaMA 和 Qwen 模型。这种训练方法赋予了较小的模型长期推理和解决问题的能力。

有一些初步的微调成果,但是看起来不太显著,readme上有挺多不错的输出样例。开源模型:https://huggingface.co/happzy2633/qwen2.5-7b-ins-v3/tree/main

本文转载自 NLP前沿,作者: 热爱AI的

赞

收藏

回复

相关推荐