IP创作即将爆发!Midjourney最新功能来袭 原创

使用Stability AI、Midjourney、OpenAI等公司的图像生成工具时,用户经常发现要在生成的图像中维持角色的一致性是一项挑战。尽管重复使用相同的提示词,但AI每次都会根据新输入的提示生成新内容。这个功能对于需要保持叙事连续性的场景中显得尤为不足。特别是对于那些需要设计角色,并希望在不同场景中保持同一角色的面部表情和道具一致性的电影、小说或漫画书创作者来说,这一直是个难题。

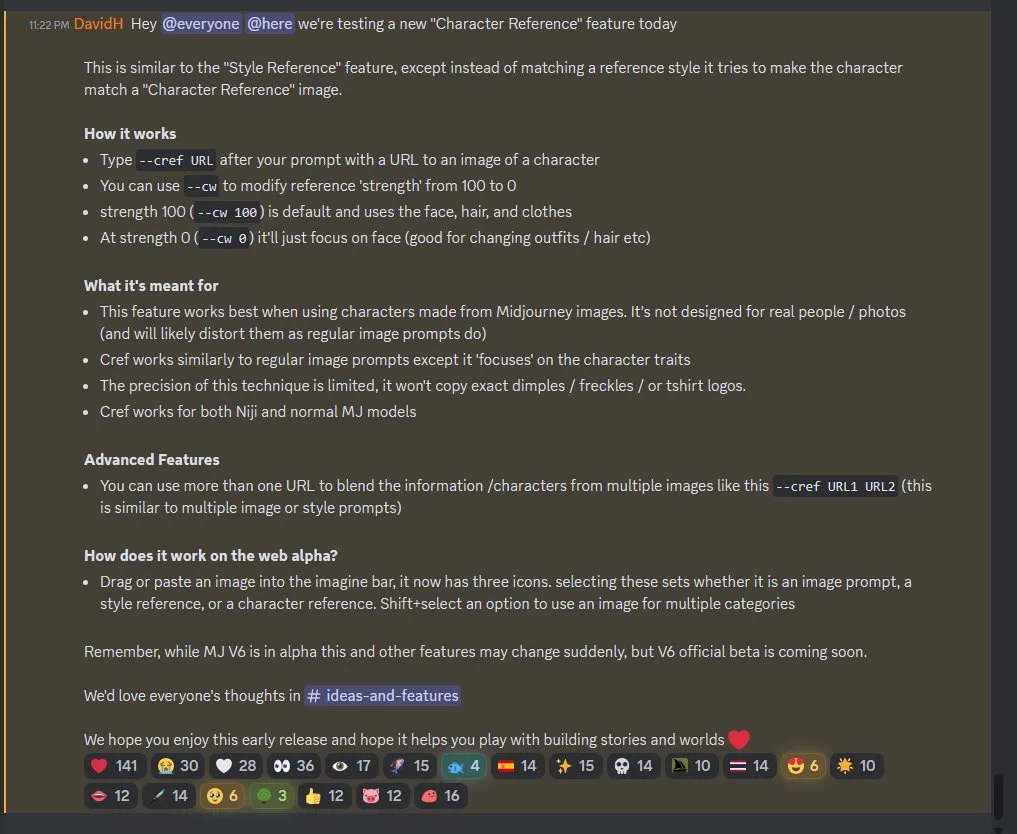

为了解决这个问题,Midjourney最近引入了一项名为「-cref」的革命性功能,即Character Reference的缩写。用户只需在Midjourney Discord的文本提示末尾添加此标签,并指定一个URL链接作为角色的参考图像,即可实现。这一功能使模型能够匹配角色的面部特征、体型和服装,从而显著提高角色的一致性。

这一功能的推出无疑大大方便了追求叙事连续性和一致性的创作者。无论是设计电影角色、创作小说插画还是制作漫画,使用「-cref」标签后,Midjourney能够确保角色在不同的场景下保持一致,无论是面部表情还是环境和道具的变化。

使用这一功能非常简单,只需在指令后加上「--cref URL」,其中URL为角色图像链接。此外,Midjourney还提供了调节参考强度的选项「--cw」,其范围为0至100。默认设置为100(即「--cw 100」),此时模型会尽可能参考角色的面部、发型和服装。若将强度调为0(即「--cw 0」),模型则仅关注角色的面部特征,适合需要变更服饰或发型的场景。

Midjourney的这项功能尤其适合创作IP角色图像。然而,对于真人照片,效果可能不理想,并且会产生扭曲。Cref主要关注角色的特征,但这项技术的精度是有限的,无法复制极其微小的细节,如特定的酒窝或T恤上的图案。

Cref还可以应用于Niji和普通MJ模型,并且可以与「--sref」结合使用,为用户提供更大的创作灵活性。高级用户还可以通过「--cref URL1 URL2」的方式,结合多个图像中的角色信息,类似于使用多重图像或风格提示。

在web alpha版本中,操作简便,只需将图片拖动或粘贴到工具栏,即可看到三个图标。选择其中一个图标,可以将图片设置为图像提示、风格参考或角色参考。若希望一张图像同时用于多个类别,只需按住Shift键再选择。

由于MJ V6目前还处于alpha测试阶段,这些功能可能会有所调整。我们可以期待Midjourney这项功能未来的进展。

本文转载自公众号AIGC开发者,作者:阿橙AIGC