微软提出LLM-dCache:GTP驱动本地数据缓存优化的大模型

大型语言模型(LLM)在系统级优化中的新进展

近年来,大型语言模型(LLM)在解决复杂问题的推理能力方面取得了显著进展,使其能够有效管理数千种工具和API调用。这些改进释放了它们在大规模系统中的潜力,包括UI/网络界面、移动应用程序、SQL后端和远程感应平台。这些用途通过需要集成各种API来加载、过滤、处理和跨多个时间和空间维度可视化数据,体现了系统级的复杂性。

随着Copilots规模的扩大,底层堆栈的开销从云端点到本地执行设备都在增加,这促使我们从根本上改变设计基于LLM的大规模系统和软件的方式。然而,早期的系统优化主要针对简化的查询或定义良好的基准,可能无法捕捉系统级任务模式和数据依赖性的细微差别。在现实的LLM工作负载中,数据显示出显著的可重用性。例如,一个地理空间分析师可能会问:“显示加州纽波特海滩周围的卫星图像。”随后的提示是“现在,在这个区域检测飞机”,这展示了一个数据元素被反复访问的场景。

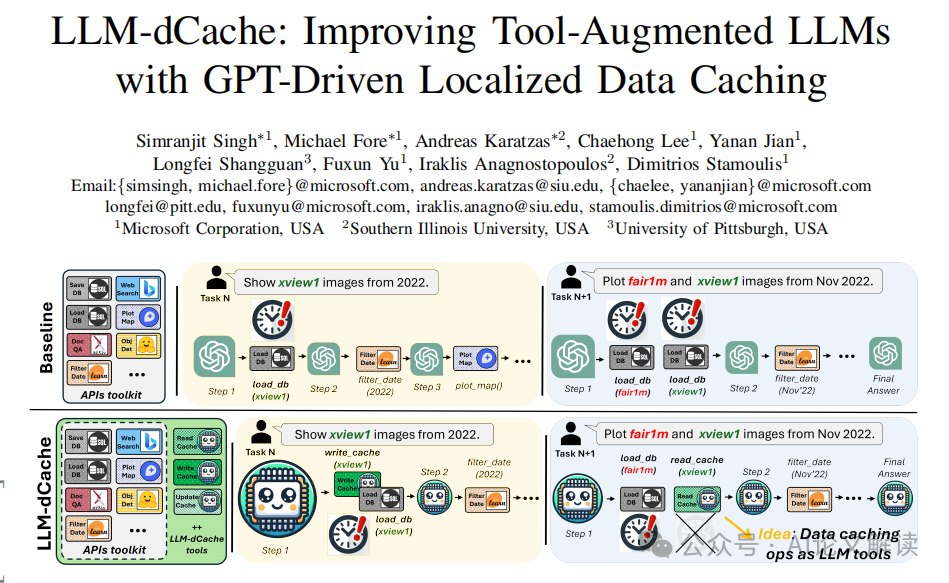

在这项工作中,我们从类似于CPU缓存系统中观察到的时间和空间可重用性模式中汲取灵感,我们引入了LLM-dCache,一种GPT驱动的缓存策略,用于优化LLM数据访问模式。我们的关键直觉在于一种新颖的设计选择,其中缓存管理无缝集成为LLM可用的工具之一,实现了与现有的函数调用机制和基线代理兼容的完全GPT驱动的即插即用方法,同时施加最小的开销。通过在大规模地理空间平台上的评估,我们证明了我们的方法在不同的GPT和提示技术中实现了LLM延迟的减少。我们希望这些发现能激励进一步探索赋予LLM其他系统级优化的可能性。

论文标题:LLM-dCache: Improving Tool-Augmented LLMs with GPT-Driven Localized Data Caching

机构:Microsoft Corporation, USA; Southern Illinois University, USA; University of Pittsburgh, USA

论文链接:https://arxiv.org/pdf/2406.06799.pdf

LLM-dCache的概念与设计动机

1. 从CPU缓存系统中获取灵感

LLM-dCache的设计灵感来源于CPU缓存系统,特别是其对时间和空间可重用性模式的利用。在CPU缓存中,频繁访问的数据被存储在快速访问的硬件中,以减少数据检索时间和提高处理效率。类似地,LLM-dCache旨在通过缓存经常被重新访问的数据来优化大型语言模型(LLM)的数据访问模式,从而减少延迟并提高系统效率。

2. 针对大规模系统的缓存策略

在大规模系统中,如地理空间平台,数据的重用性显著,例如在连续的查询中多次访问相同的卫星图像数据。LLM-dCache通过将缓存操作集成为LLM可调用的API工具,使得缓存管理能够无缝地融入到LLM的操作中。这种设计不仅适应了大规模数据处理的需求,还通过减少对主存储的访问需求,显著提高了任务处理速度。

缓存操作的集成与实现

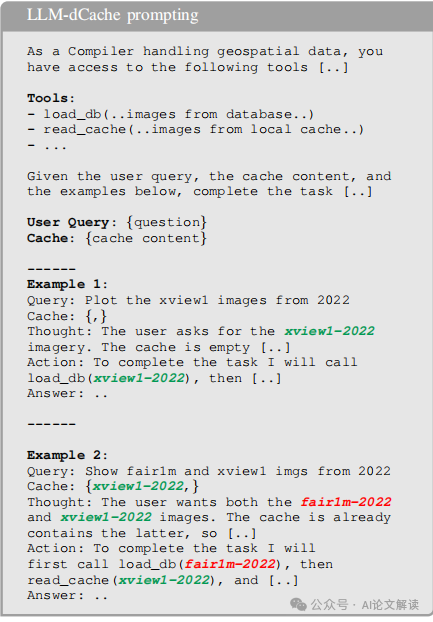

1. 缓存读取操作

在LLM-dCache中,缓存读取操作被设计为GPT的一部分决策过程。当LLM接收到用户查询时,它会检查当前的缓存内容,并决定是否执行缓存加载工具。例如,如果用户请求的数据已经存在于缓存中,则LLM会直接从缓存中读取数据,而不是重新从数据库或其他存储系统加载。

2. 缓存更新策略

LLM-dCache采用最近最少使用(LRU)策略作为主要的缓存更新策略,并通过GPT来动态管理缓存更新。在每轮操作中,GPT根据当前的缓存状态和新的数据加载操作,决定如何更新缓存。这种策略不仅优化了缓存的使用效率,还减少了因缓存不命中而重新加载数据的需要。

3. GPT工具作为缓存操作的实现

将缓存功能作为GPT工具的一部分,简化了缓存操作的实现,并使其与平台无关。这种方法不仅减少了需要进行的更改,还允许LLM自主管理缓存操作,从而在出现缓存未命中时,LLM可以重新评估其工具序列,以实时纠正工具选择中的不准确性。这种动态适应性是系统优化中的关键。

实验设置与数据集

1. GeoLLM-Engine平台介绍

GeoLLM-Engine是一个大规模的、可参数化的LLM引擎,专门用于处理地理空间任务。该平台设计用于捕捉代理性能,配备了长期多工具LLM操作,这些操作需要频繁地检索和过滤数据。平台还集成了一整套开源API、交互式地图用户界面、RAG和数据检索工具,拥有超过110万张卫星图像。

2. 数据集的构建与特点

为了测试GeoLLM-Engine的性能,我们扩展了GeoLLM-Engine采样器以获取GeoLLM-Engine-1k数据集的变体。通过调整采样率参数,并加入控制数据重用可能性的参数,我们选择性地采样了80%概率需要已在缓存中的数据的提示,构建了一个包含1000个多步骤提示的测试数据集(总共约50000个工具调用)。此外,我们还准备了一个包含500个查询的小型数据集用于分析。最后,我们使用模型检查器模块来验证生成任务的功能正确性。

实验结果与分析

1. 不同配置下的任务完成时间比较

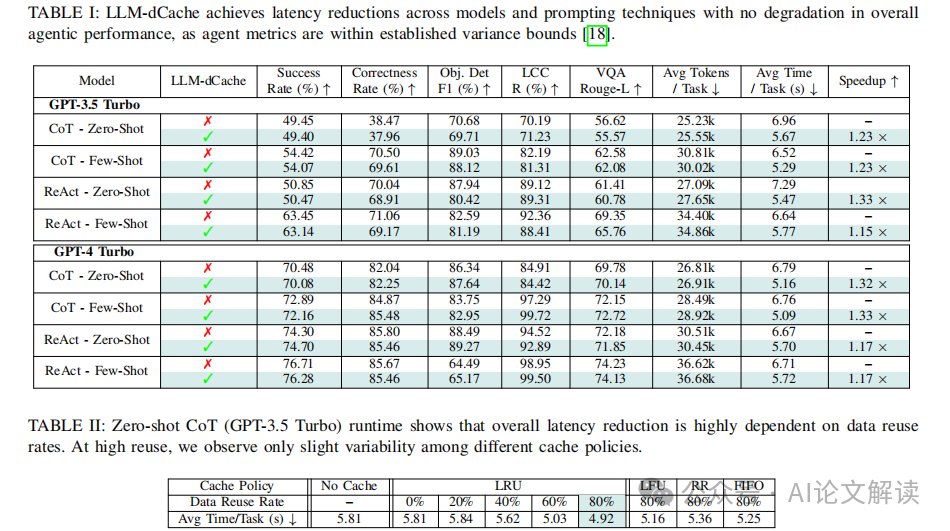

根据实验结果,LLM-dCache在不同配置下(包括GPT-4和GPT-3.5,以及Chain-of-Thought和ReAct技术,无论是少数样本还是零样本场景)平均能够将任务完成时间提高1.24倍(表I)。这表明缓存策略不会降低输出质量和代理的功能性,代理指标仍在既定的方差范围内。

2. 缓存策略的有效性分析

通过对不同的缓存策略(LRU、LFU、RR和FIFO)进行分析,我们发现在数据重用率高的情况下,不同策略之间的延迟差异不明显(表II顶部)。这表明数据重用模式而非模型选择或提示策略是影响性能的主要因素。此外,我们还进行了多个小型验证子集的分析,每个子集包含500个查询,但具有不同的重用率,结果显示更高的重用率与更大的延迟节省相关。

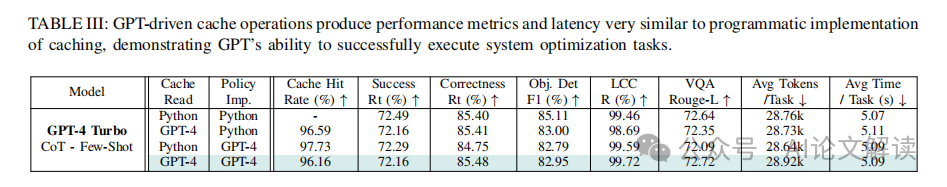

通过将缓存操作作为GPT工具进行提示,我们的实验显示,GPT驱动的缓存操作在性能指标和延迟方面与程序化缓存操作非常接近,这证明了GPT成功执行系统优化任务的能力(表III)。这种方法展示了LLM在传统程序化解决方案之外,指导缓存管理的多功能性和潜力。

讨论:GPT驱动的缓存操作与传统编程实现的比较

1. GPT驱动的缓存操作

GPT驱动的缓存操作,如LLM-dCache所示,通过将缓存操作作为可调用的API工具暴露给GPT,使其能够动态地读取和更新缓存数据以响应用户查询。这种方法允许GPT在上下文提示的帮助下自主管理缓存操作,例如通过提示解释LRU方案。这种集成方式使得缓存读取和更新操作成为GPT的决策过程的一部分,从而只需很少的更改。此外,赋予LLM对缓存决策的自主权还能够处理缓存未命中的情况:在功能调用失败时,LLM会被提示重新评估其工具序列,就像处理任何其他工具选择失误一样。

2. 传统编程实现的缓存操作

传统的编程实现缓存操作通常涉及直接在代码中硬编码缓存逻辑,如使用特定的缓存更新策略(LRU、LFU等)和缓存大小限制。这种方法在效率和可靠性方面可以达到很高的标准,因为它直接控制了所有的底层操作,但它缺乏灵活性,并且通常需要针对每个应用程序或系统进行定制。

3. 性能比较

根据研究,GPT驱动的缓存操作与传统编程实现的缓存操作在性能指标和延迟方面非常相似,表明GPT能够成功执行系统优化任务。例如,GPT驱动的变体在缓存“命中率”和延迟方面与完全编程方法相匹配,后者可以被视为效果和可靠性的上限。

限制与未来工作:扩展到更多系统级优化和其他计算环境

1. 限制

当前的研究主要集中在云优先环境中的代理性能和平均延迟上,这涉及到大量使用云端点。虽然这为系统性能提供了一定的基准,但它限制了在不依赖云基础设施的环境中的应用广泛性。此外,目前的实现主要关注地理空间数据,这可能限制了其在其他类型的数据密集型任务中的应用。

2. 未来工作

为了克服这些限制并进一步提升系统级优化的能力,未来的工作将探索将GPT驱动的缓存操作扩展到其他计算环境,如本地执行设备,这可能包括使用能够在本地运行的GPT替代品,如Llama-3和Phi-3.5。此外,计划将评估扩展到更广泛的任务范围,包括那些在最近的系统级LLM优化论文中考虑的正交任务。

通过这些努力,希望能够进一步利用LLM进行系统级优化,以提高复杂数据密集型环境中的系统效率。

总结:LLM-dCache的贡献与系统级优化的潜力

在大型语言模型(LLM)的发展中,LLM-dCache的引入标志着一个重要的进步,它通过缓存机制优化了数据访问模式,显著提升了系统效率。本章节将总结LLM-dCache的主要贡献,并探讨其在系统级优化中的潜力。

1. LLM-dCache的核心贡献

LLM-dCache通过将缓存操作作为可调用的API工具集成到LLM中,使得大型语言模型能够自主管理缓存操作。这种设计不仅减少了对传统程序逻辑的依赖,还提高了缓存管理的灵活性和效率。例如,在处理地理空间数据时,LLM-dCache能够根据数据的重用模式动态调整缓存内容,从而减少了数据加载时间并提高了任务完成速度。

2. 系统级优化的实现

通过将缓存操作嵌入到LLM的决策过程中,LLM-dCache有效地将系统优化的决策权下放给了语言模型本身。这一策略不仅简化了系统设计,还提高了操作的灵活性。在实际应用中,这意味着LLM可以根据当前的任务需求和数据状态,自主决定何时读取或更新缓存,从而优化整体的系统性能。

3. 提升任务处理速度和准确性

在多个测试场景中,LLM-dCache显示出了显著的性能提升。例如,在地理空间平台上的评估显示,通过使用LLM-dCache,任务完成时间平均缩短了1.24倍。此外,缓存策略的优化还确保了在不同的模型和提示技术中,输出的质量和功能性不受影响。

4. 对未来系统级优化的启示

LLM-dCache的成功实施为未来的系统级优化提供了新的思路。通过进一步探索和扩展这种以LLM为中心的优化策略,我们可以将其应用于更广泛的任务和环境中,如动态电压频率调整(DVFS)、核心分配和热管理等。此外,这种策略的推广还可能促进其他非GPT工具增强型代理在不同计算环境中的无缝集成。

总之,LLM-dCache不仅提升了大型语言模型在处理复杂数据任务时的效率和灵活性,还展示了利用LLM进行系统级优化的巨大潜力。随着技术的进一步发展,我们期待看到更多基于LLM的系统优化解决方案的出现。

本文转载自 AI论文解读,作者:柏企