草莓OpenAI o1的规划能力怎么样?泰斗Subbarao Kambhampati给你答案! 原创

一、引言

OpenAI发布的草莓o1模型为评估大语言模型(LLMs)在规划和调度基准上的进展提供了新的机会,但是它的规划能力到底怎么样呢?近期,规划领域泰斗Subbarao Kambhampati教授领衔的论文对其进行了研究,旨在全面评估o1在既定规划和调度基准上的性能,并展示如何通过将大型推理模型(Large Reasoning Model, LRM)嵌入到带有可靠验证器的循环中,为其输出提供正确性保证并提高性能。

Subbarao Kambhampati一直是经典AI的代表人物,在规划领域造诣很深。熟悉他的读者一定知道,Subbarao Kambhampati对大语言模型一直持保守态度。关于Subbarao Kambhampati教授的工作,我们前两天曾经报道过哦!感兴趣的读者可以参考《啥?!AAAI前主席Subbarao Kambhampati告诉你:大模型不能planning!》

本文评估了两种大型推理模型(LRM)o1-preview和o1-mini在规划和调度基准上的能力。结果表明,o1在某些方面优于基于自回归的大语言模型(LLMs),但推理成本较高,且无法保证生成结果的正确性。通过将o1模型与外部验证器结合,可以保证组合系统输出的正确性,同时进一步提高性能。

二、背景和相关工作

(一)规划领域

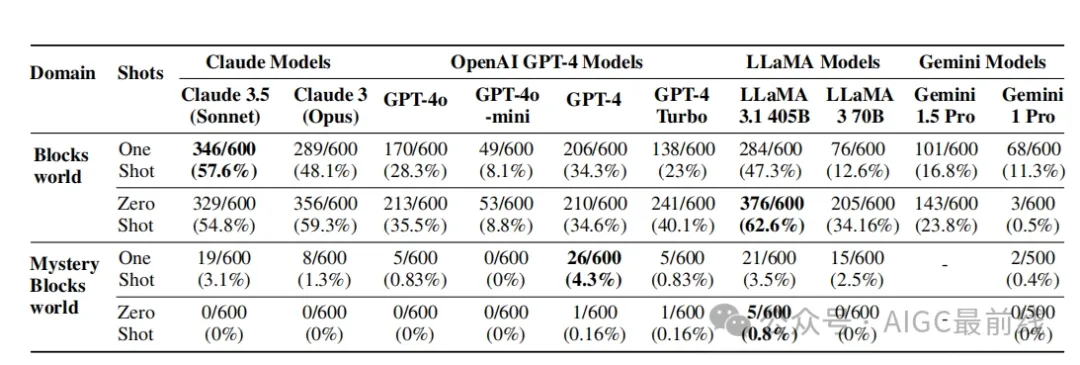

LLM在规划任务上表现出一定的局限性,即使在简单的领域也可能失败。本文关注经典规划问题,使用PlanBench基准测试,并在Blocksworld和Mystery Blocksworld等领域进行测试。

(二)调度领域

调度问题主要围绕资源分配,本文在Natural Plan、TravelPlanner和graph coloring等调度基准上评估o1,这些基准涵盖了旅行规划、日历调度和会议规划等多个方面。

表1:不同系列的大型语言模型在Blocksworld和Mystery Blocksworld领域的600个实例上的性能,使用了零次提示和一次提示。同类最佳准确率用粗体显示。

三、从近似检索到近似推理

(一)o1的架构

o1结合了底层的LLM和类似System 2的能力,可能经过强化学习预训练和自适应推理过程,使其在本质上与之前的LLM有很大不同。

(二)规划能力评估

- PlanBench测试

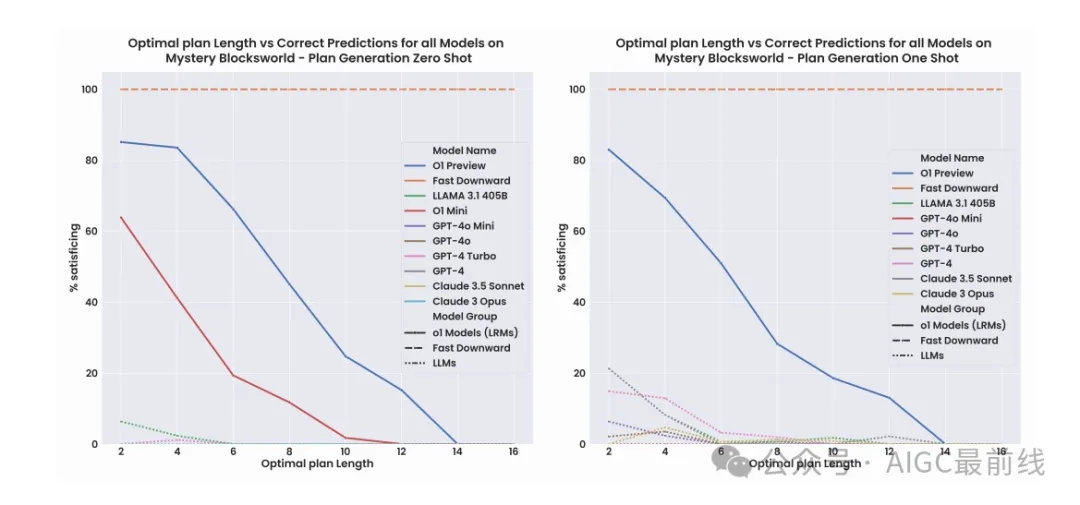

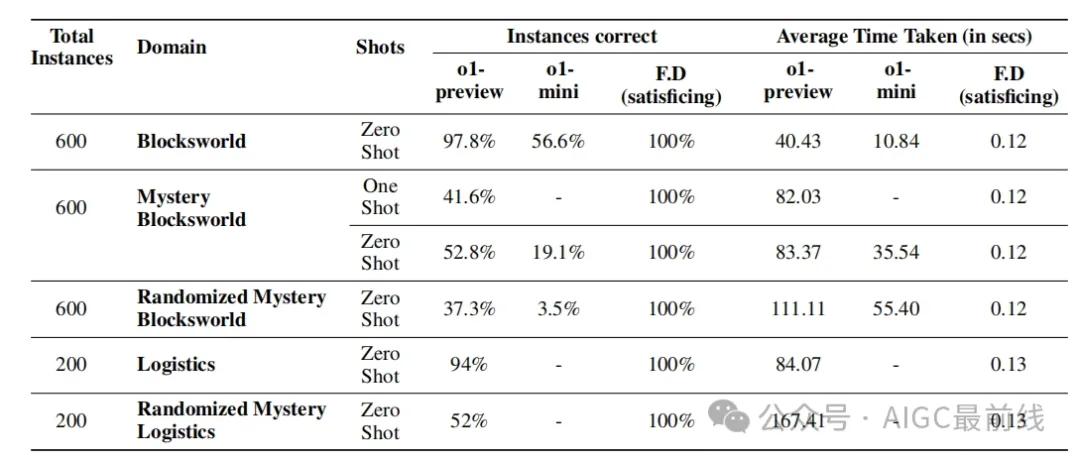

- 在原始600实例PlanBench测试集上,o1-preview在Blocksworld实例中正确回答率高达97.8%,远超LLM,但在Mystery Blocksworld上性能有所下降。

- 随着问题规模增加,性能会快速下降,在110个更难的Blocksworld问题上,o1-preview仅能达到23.63%的准确率。

- 在识别不可解问题方面,o1虽然有一定能力,但仍存在误判情况,有时会错误地声称可解问题不可解,或者为不可解问题提供错误的计划。

- 扩展到更难的领域

- 在Sokoban领域,o1-preview和o1-mini分别能正确回答12.7%和10.9%的实例,而Llama3.1 - 405B在这些实例上全部答错。

图1:这些示例是关于Mystery Blocksworld的。Fast Downward是一种与领域无关的规划器,它能近乎即时地解决所有给定实例,并保证完美的准确性。大语言模型(LLMs)即使在最小的实例上也很困难。测试的两种大型推理模型(LRMs),o1 - preview和o1 - mini,效果惊人,但这种性能仍然不够稳健,并且会随着长度的增加而迅速下降。

(三)调度能力评估

- Graph Coloring

- o1-mini在原始220个图着色问题上解决了96%,超过了GPT - 4的16%。在扩展的更难的图着色测试集上,o1-mini解决了50%,o1-preview解决了64%。

- Travel Planning

- 在TravelPlanner的180个实例验证集中,o1-preview解决了10%的实例,略高于GPT - 4 - turbo的4.4%,o1-mini解决了1.67%的实例。

- Natural Plan

- 在Natural Plan的三个领域中,o1-mini在日历调度领域解决了94%的实例,但在旅行规划和会议规划领域表现不佳。

表2:OpenAI的o1系列大型推理模型和Fast Downward(F.D.)在Blocksworld、Mystery Blocksworld和Randomized Mystery Blocksworld领域的600个实例以及Logistics和Randomized Logistics领域的200个实例上的性能和平均耗时

四、准确性/成本权衡和保证

(一)成本比较

LRM的成本显著高于LLM,o1-preview和o1-mini每100个实例的成本分别为和3.69,而一些LLM每100个实例的成本在到1.80之间。

(二)权衡分析

虽然o1-preview在准确性上可能高于LLM,但它无法提供正确性保证,且成本效益不明确。相比之下,古典规划器如Fast Downward在成本、时间和保证正确性方面具有优势,而LLM - Modulo系统可以在较低成本下提供保证的解决方案。

五、LRM - Modulo提升o1并提供保证

(一)方法介绍

本文提出通过外部验证器增强o1,将其集成到LRM - Modulo系统中,以提高整体性能并提供输出保证。

(二)实验结果

在五个最难的测试集上进行测试,结果表明即使迭代次数有限,性能也有显著提升。例如,在更难的Blocksworld问题上,o1-preview结合系统的准确率达到98.2%,在Sokoban领域从12.7%提升到43.6%。

六、结论

本文评估了o1-preview和o1-mini在规划和调度基准上的性能。o1在一些方面取得了进展,但在处理长问题和确定问题可解性方面存在不足。同时讨论了准确性和效率的权衡,并展示了LRM - Modulo方法可应用于LRM以提高性能和提供保证。未来的评估需要关注这些因素,以保持其意义和相关性。

本文转载自公众号AIGC最前线 作者:实习小毕

原文链接:https://mp.weixin.qq.com/s/HjAkw-0SUUH0WccBDgbr_g