回复

【机器学习】图解线性回归 原创

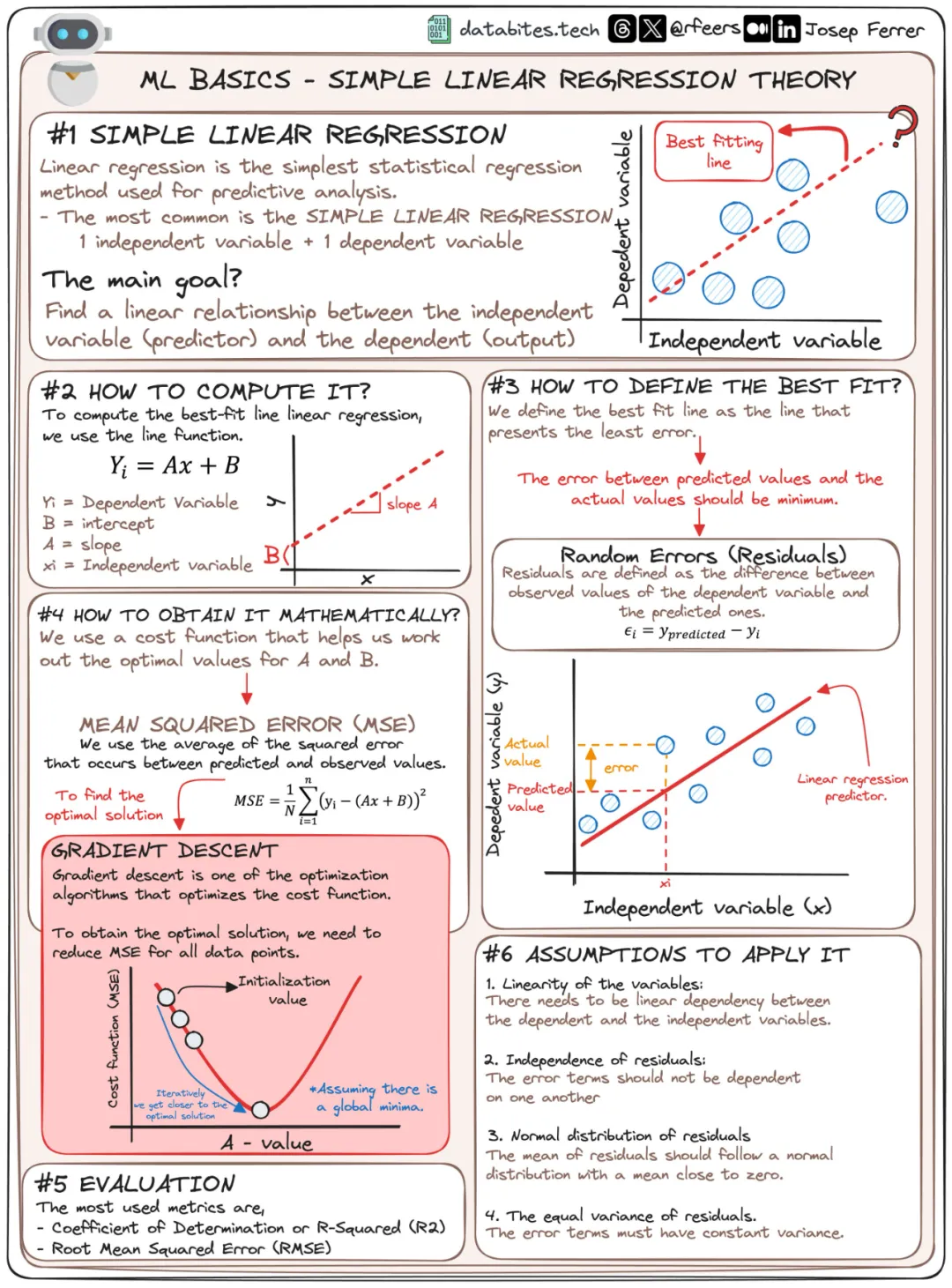

线性回归可谓是机器学习界的hello world,在现实中也有广泛应用,今天我们以图表为主,用可视化方法重新审视下这个模型。

先来个整体视角:

再逐步分解开来:

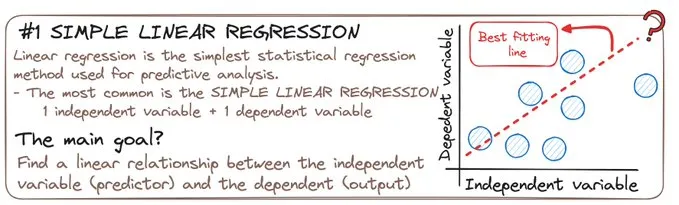

𝗦𝗜𝗠𝗣𝗟𝗘 𝗟𝗜𝗡𝗘𝗔𝗥 𝗥𝗘𝗚𝗥𝗘𝗦𝗦𝗜𝗢𝗡

如果自变量只有一个,我们称为简单线性回归,虽然简单,但很强大,能用来发现数据中潜在的变化趋势。

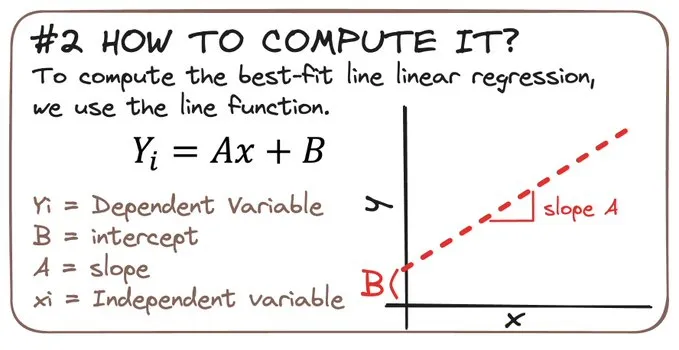

𝗛𝗢𝗪 𝗗𝗢𝗘𝗦 𝗜𝗧 𝗪𝗢𝗥𝗞?

线性回归的目标是拟合一条直线,这条直线最能体现自变量和因变量之间的线性依赖关系。

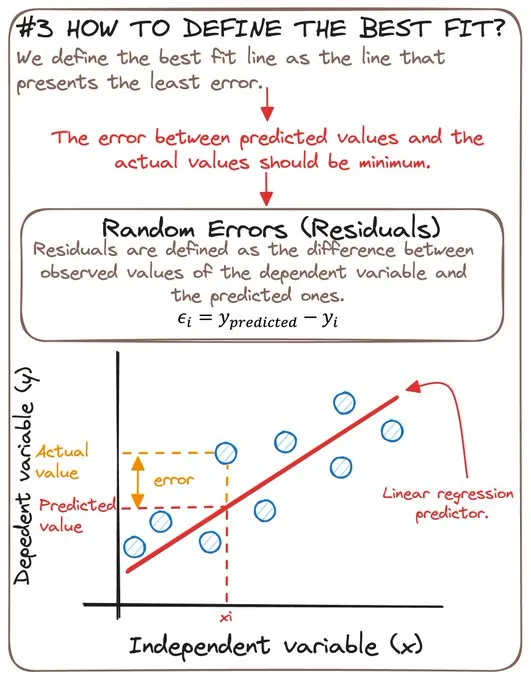

𝗛𝗢𝗪 𝗗𝗢 𝗪𝗘 𝗗𝗘𝗙𝗜𝗡𝗘 𝗧𝗛𝗘 𝗕𝗘𝗦𝗧 𝗙𝗜𝗧?

那如何找到这个最佳的拟合直线呢?让因变量的观测值和模型的预测值之间的误差最小。

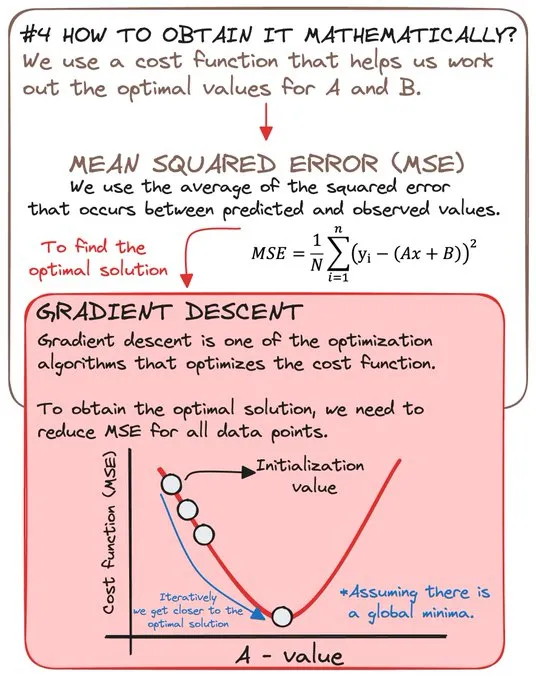

𝗛𝗢𝗪 𝗗𝗢 𝗪𝗘 𝗢𝗕𝗧𝗔𝗜𝗡 𝗜𝗧 𝗠𝗔𝗧𝗛𝗘𝗠𝗔𝗧𝗜𝗖𝗔𝗟𝗟𝗬?

在机器学习中,我们通常使用损失函数来找到最优的参数。

在线性回归中,损失函数就是均方误差,参数就是斜率A和截距B。

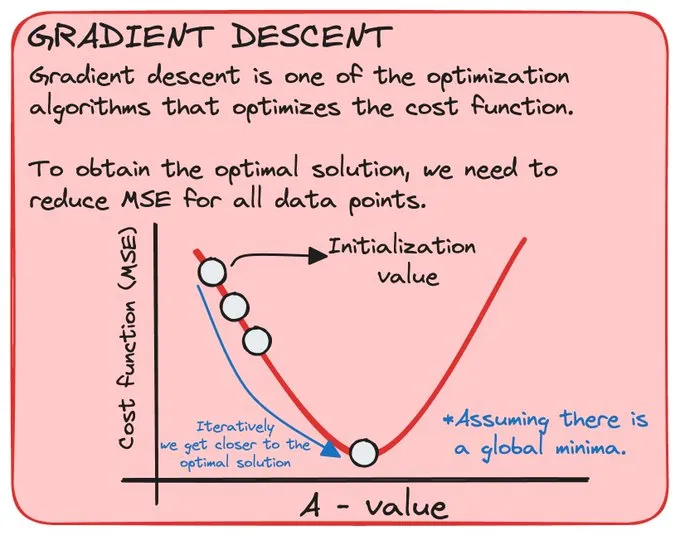

为了找到我们的最优解,我们使用了梯度下降法。

这是优化算法之一,用于优化成本函数。

为了获得最优解,我们需要减少所有数据点的均方误差(MSE)。

通过迭代,我们逐渐接近最优解。

𝗘𝗩𝗔𝗟𝗨𝗔𝗧𝗜𝗢𝗡

“训练完成后,如何才能衡量模型的性能呢?在训练集上表现的好,不见得在未见过的数据上表现也好,我们希望模型具有较强的泛化能力,所以我们需要在测试集上评估模型的性能,来避免模型过拟合。”这句话描述准确吗?

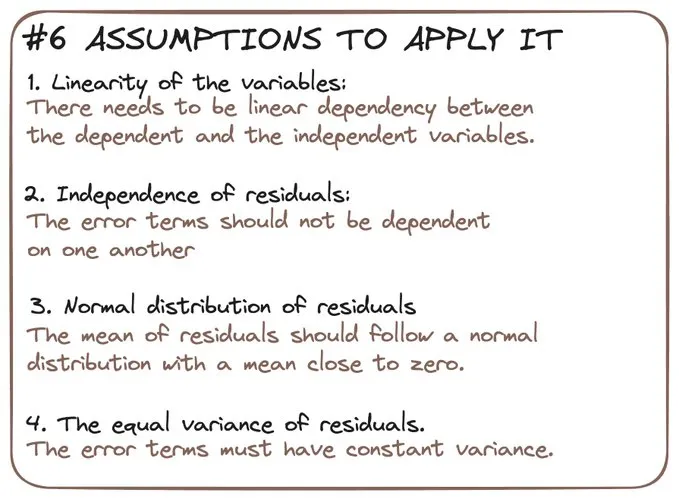

𝗔𝗦𝗦𝗨𝗠𝗣𝗧𝗜𝗢𝗡𝗦 𝗧𝗢 𝗔𝗣𝗣𝗟𝗬 𝗜𝗧

线性回归模型也是基于一些假设的,比如线性关系假设(Linearity),正态性假设(Normality of errors),独立性假设(Independence)等等。

如果假设与实际不符就会导致模型不准确,例如,如果自变量和因变量之间是非线性关系,那么线性回归模型可能无法很好地拟合数据。

这就需要使用通用线性模型或者神经网络了。

本文转载自公众号人工智能大讲堂

原文链接:https://mp.weixin.qq.com/s/OySYGcNUnT8oAFwI9xSyyQ

©著作权归作者所有,如需转载,请注明出处,否则将追究法律责任

赞

收藏

回复

相关推荐