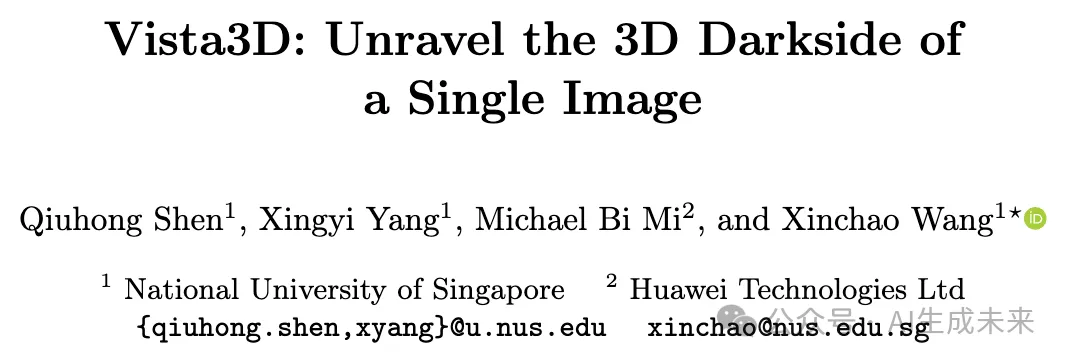

ECCV`24 | 新加坡国立&华为提出Vista3D: 实现快速且多视角一致的3D生成

文章链接:https://arxiv.org/pdf/2409.12193

gitbub链接:https://github.com/florinshen/Vista3D

亮点直击

- 提出了Vista3D,一个用于揭示单张图像3D darkside 的框架,能够高效地利用2D先验生成多样的3D物体。

- 开发了一种从高斯投影到等值面3D表示的转换方法,通过可微等值面方法和解耦纹理来优化粗糙几何,实现纹理化网格的创建。

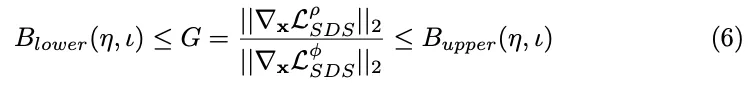

- 提出了一种角度组合方法用于扩散先验,通过约束其梯度幅度,在不牺牲3D一致性的情况下实现3D潜力的多样性。

总结速览

解决的问题

- 解决单张图像生成3D对象时多视图不一致的问题。

- 平衡3D生成中的一致性与多样性。

提出的方案

- Vista3D框架采用两阶段方法:粗略阶段通过高斯投影生成初始几何,精细阶段优化符号距离函数(SDF)。

- 使用角度组合方法进行扩散先验,通过约束梯度幅度实现多样性。

应用的技术

- 高斯投影和可微等值面方法。

- 解耦纹理技术。

- 使用两个独立隐函数捕捉物体的可见和隐藏方面。

达到的效果

- 在短短5分钟内实现快速且一致的3D生成。

- 提升生成质量,维持3D物体一致性和多样性之间的平衡。

方法

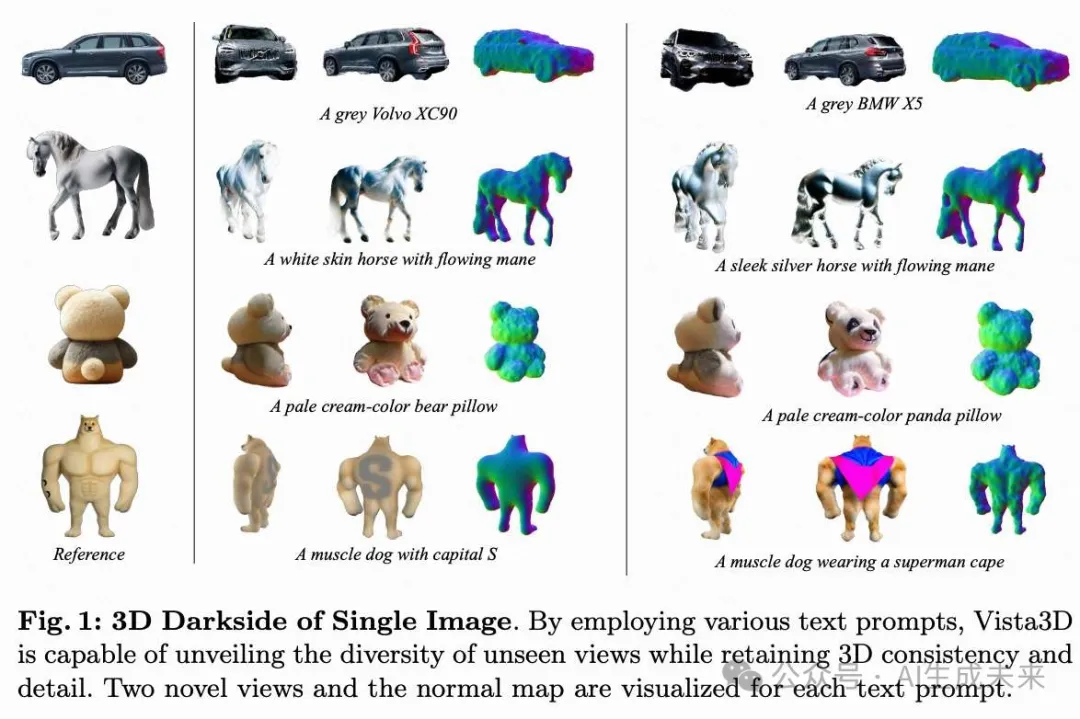

本节概述了利用2D扩散先验从单张图像生成详细3D对象的框架。如下图2所示,本文对单张图像3D darkside的探索始于通过3D高斯投影高效生成基础几何。在精细化阶段,本文设计了一种方法,将初步的3D高斯几何转换为符号距离场,随后引入可微分的等值面表示,以进一步增强几何和纹理。为了实现给定单张图像的多样化3D darkside,本文提出了一种新颖的方法来约束两个扩散先验,通过限制梯度幅度来创造多样而连贯的暗面纹理。通过这些方法,可以高效地从单张图像生成多样化且高保真的网格。

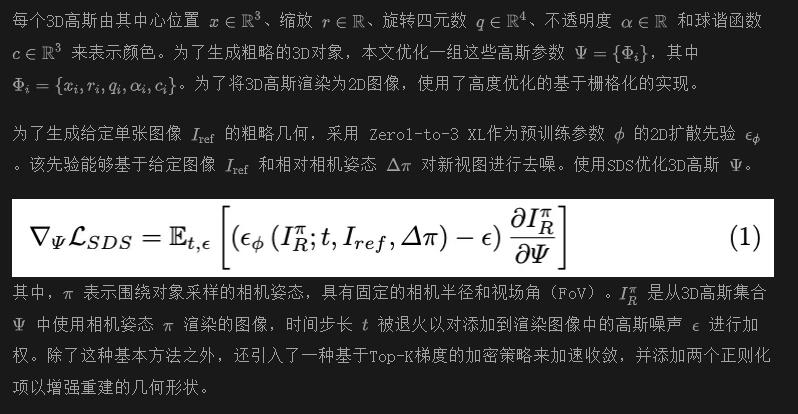

Gaussian Splatting 的粗略几何

在本文框架的粗略阶段,专注于使用Gaussian Splatting构建基础对象几何。该技术将3D场景表示为一组各向异性3D高斯。与其他神经逆渲染方法(如NeRF)相比,Gaussian Splatting在逆渲染任务中表现出显著更快的收敛速度。

一些研究,比如[3, 41, 49] 尝试将 Gaussian Splatting 引入3D生成模型。在这些方法中,发现直接使用 Gaussian Splatting 生成详细的3D对象需要优化大量的3D高斯,这需要大量时间进行优化和密集化,仍然耗时。然而, Gaussian Splatting 可以在一分钟内使用有限数量的3D高斯从单张图像快速创建粗略几何。因此,在本文的方法中,仅利用 Gaussian Splatting 进行初始粗略几何生成。

基于Top-K梯度的加密策略:在优化过程中,发现使用简单梯度阈值的周期性加密由于SDS的随机特性而难以调整。因此,本文采用了一种更稳健的加密策略。在每个间隔期间,仅对具有Top-K梯度的高斯点进行加密,这种简单的策略可以在各种给定图像中稳定训练。

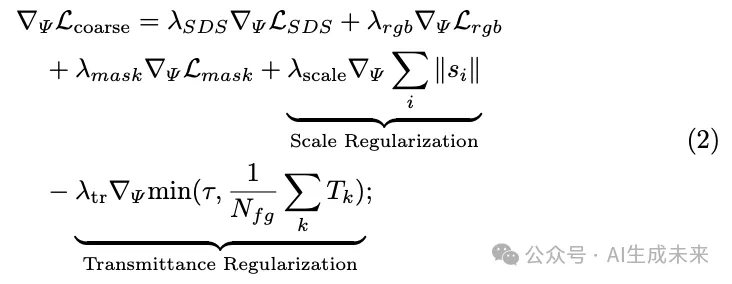

尺度与透射率正则化:本文添加了两个正则化项,以鼓励 Gaussian Splatting在此阶段学习更详细的几何形状。引入了尺度正则化以避免过大的3D高斯,并采用另一种透射率正则化以鼓励几何学习从透明到实心。此阶段的总体损失函数可以写为:

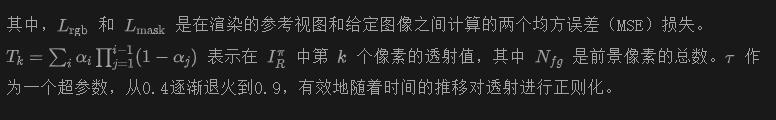

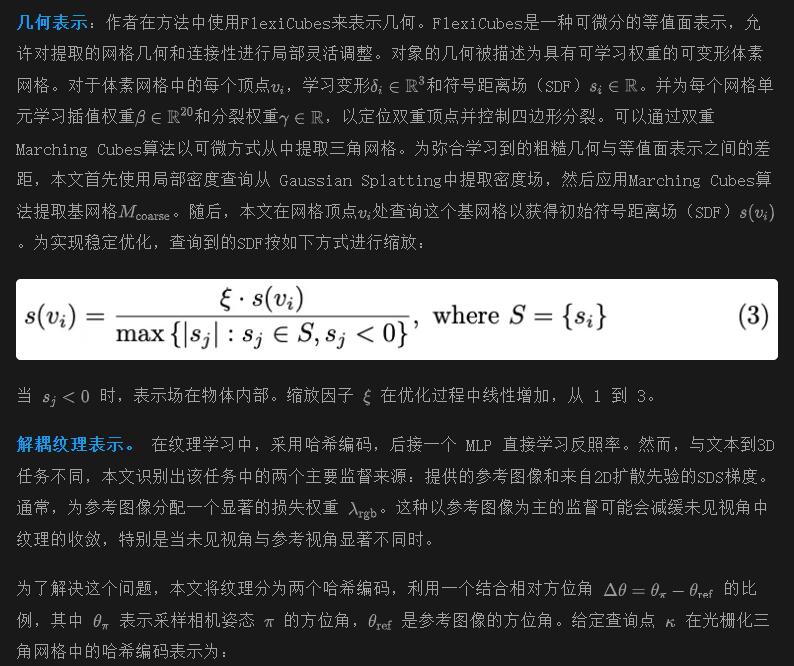

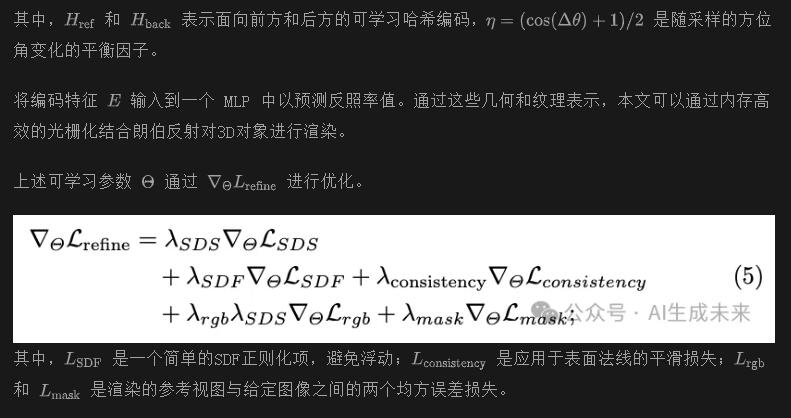

网格细化和纹理解耦

在细化阶段,重点是将通过Gaussian Splatting生成的粗糙几何体转化为符号距离场(SDF),并使用混合表示来优化其参数。这个阶段对于克服粗糙阶段遇到的挑战至关重要,特别是Gaussian Splatting常常引入的表面伪影。由于Gaussian Splatting无法直接提供表面法线的估计,无法采用传统的平滑方法来减轻这些伪影。为了解决这个问题,本文引入了一种混合网格表示,即将3D对象的几何体建模为可微分的等值面,并使用两个不同、解耦的网络来学习纹理。这种双重方法不仅可以平滑表面不规则性,还能显著提高3D模型的逼真度和整体质量。

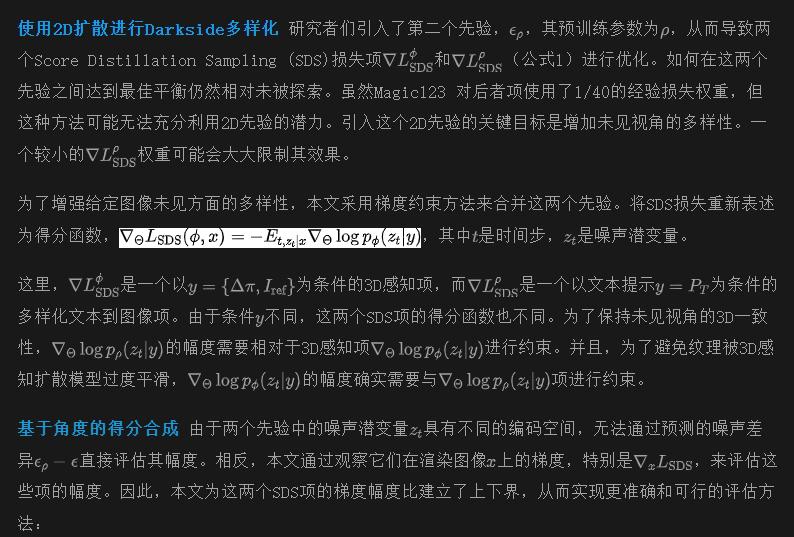

通过预先构图实现黑暗面多样性

在实现pipeline时,遇到了与未见视角缺乏多样性相关的关键挑战。这一问题主要源于依赖Zero-1-to-3 XL先验,该模型是在ObjaverseXL中的合成3D物体上训练的。虽然该先验在基于参考图像和相对相机姿态进行3D感知生成方面表现出色,但在未见视角中往往会产生过于简化或过于平滑的结果。当处理真实世界中捕获的物体时,这一限制尤为明显。

为了解决这个问题,研究者们引入了来自Stable-Diffusion的额外先验,以其合成多样化图像的能力而闻名。

实验

实验细节

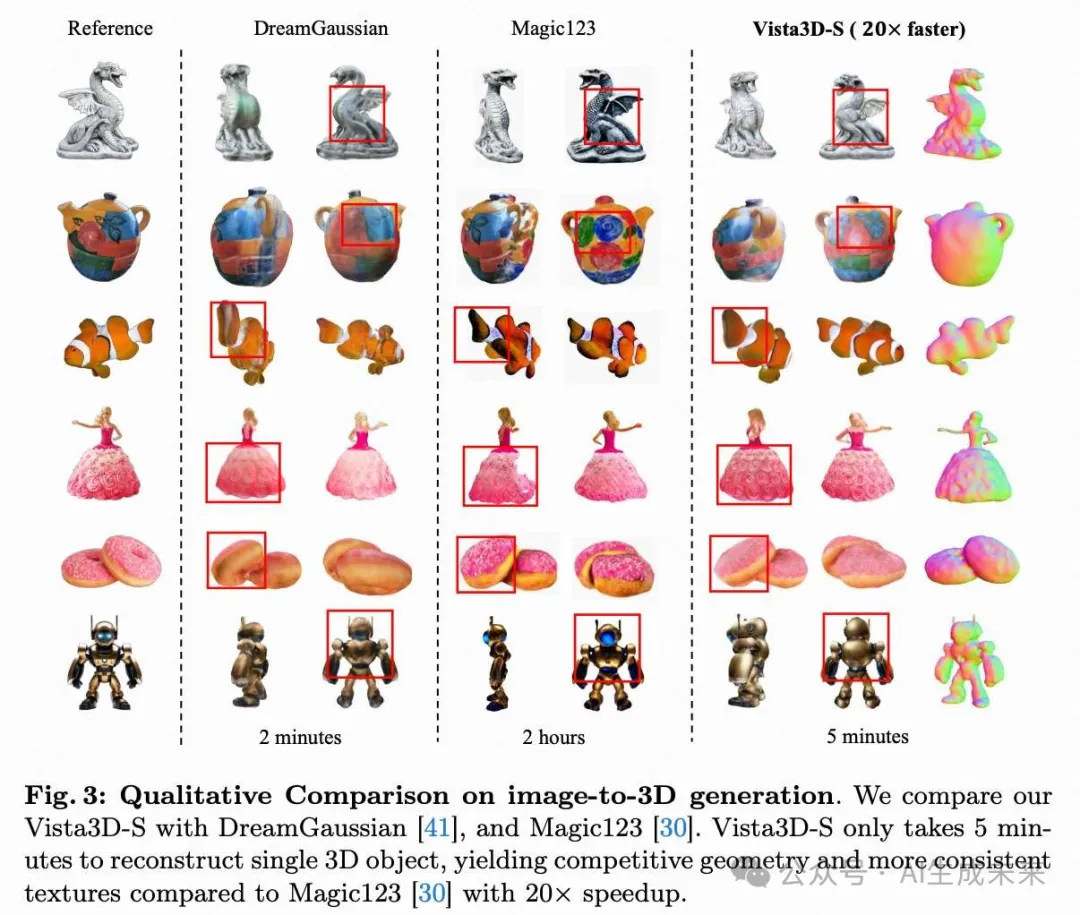

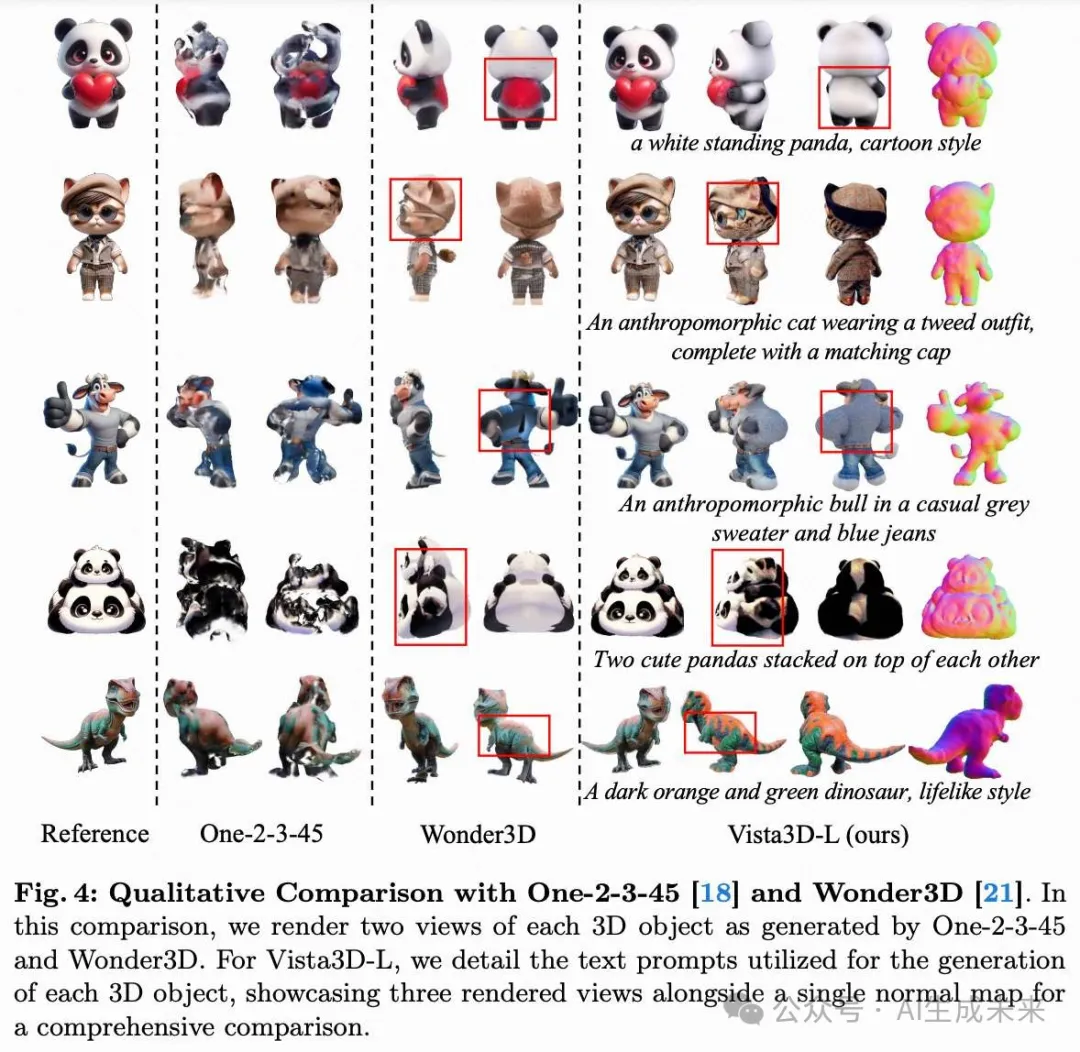

定性比较

在下图3中,本文展示了高效的Vista3D-S能够以比现有粗到细方法快20倍的速度生成具有竞争力的3D对象。对于Vista3D-L,如上图1和下图4所示,本文强调了本文的角度梯度约束,这使得本文的框架区别于以往的图像到3D方法,因为它可以在不牺牲3D一致性的情况下探索单幅图像背面的多样性。在下图3中,本文主要将Vista3D-S与两个基准方法Magic123和DreamGaussian进行比较,用于从单一参考视图生成3D对象。在生成的3D对象质量方面,本文的方法在几何和纹理上都优于这两种方法。关于Vista3D-L,本文将其与两个仅推理的单视图重建模型进行比较,具体来说是One-2-3-45和Wonder3D。如下图4所示,One-2-3-45往往会产生模糊的纹理,并可能导致复杂对象的几何不完整,而本文的Vista3D-L通过用户指定的文本提示实现了更精细的纹理,特别是在3D对象的背面。Wonder3D由于主要在合成数据集上训练,通常采用更简单的纹理,这偶尔会导致某些对象的分布外问题。相比之下,Vista3D-L通过控制两个扩散先验提供零样本3D对象重建,从而实现更详细和一致的纹理。此外,鉴于仅提供对象的单一参考视图,本文认为对象在优化过程中应该可以通过用户指定的提示进行编辑。为了说明这一点,本文在图1中展示了几个强调编辑潜力的结果。

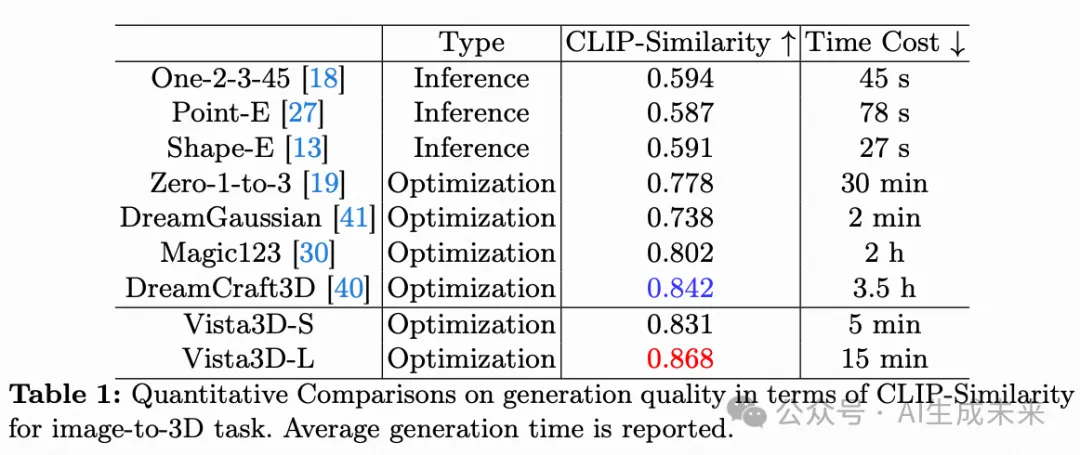

定量比较

在本文的评估中,本文使用CLIP相似度指标来评估本文的方法在使用RealFusion数据集进行3D重建时的性能,该数据集包含15张不同的图像。与以往研究中使用的设置一致,本文在每个对象的方位角范围为[-180, 180]度的零仰角处均匀采样8个视图。然后使用这些渲染视图和参考视图的CLIP特征计算余弦相似度。下表1显示,Vista3D-S获得了0.831的CLIP相似度分数,平均生成时间仅为5分钟,从而超越了Magic123的性能。此外,与另一种基于优化的方法DreamGaussian相比,尽管Vista3D-S可能需要5分钟的时间,但它显著提高了一致性,这从更高的CLIP相似度分数中得到了证明。对于Vista3D-L,本文应用了仅增强设置。通过使用角度扩散先验组合,本文的方法实现了更高的0.868 CLIP相似度。

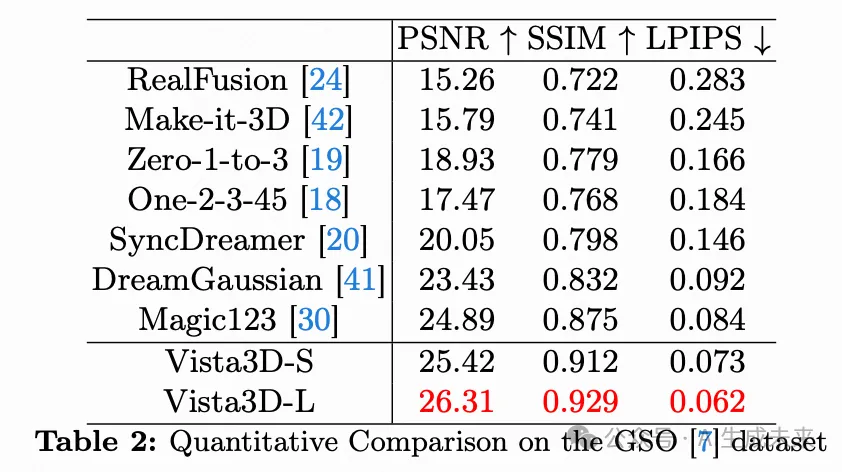

Vista3D-L的能力,特别是在通过先验组合生成具有更详细和逼真纹理的对象方面,在图4中得到了展示。此外,本文在Google Scanned Object (GSO)数据集上进行了定量实验,遵循SyncDreamer的设置。本文使用30个对象评估每种方法,并计算3D对象的渲染视图与16个真值anchor视图之间的PSNR、SSIM和LPIPS。结果如下表2所示,显示本文的Vista3D-L在这些方法中以较大优势实现了SOTA性能。尽管Vista3D-S只有单一扩散先验,但也展示了具有竞争力的性能。

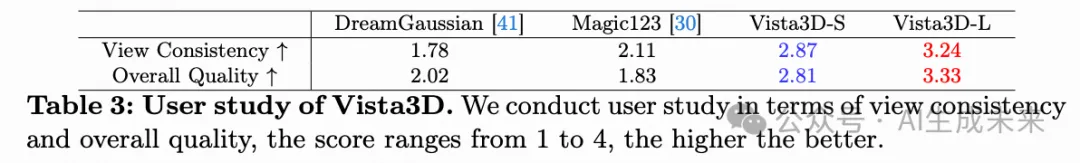

用户研究

在本文的用户研究中,本文评估了参考视图一致性和整体3D模型质量。评估涵盖了四种方法:DreamGaussian 、Magic123,以及本文自己的Vista3D-S和Vista3D-L。本文招募了10名参与者进行这项用户研究。每位参与者被要求根据视图一致性和整体质量分别对不同方法生成的3D对象进行排序。因此,每个指标的得分范围为1到4。下表3中的结果显示,本文的Vista3D-S在视图一致性和整体质量上均优于之前的方法。此外,Vista3D-L中采用的角度先验组合进一步提高了生成3D对象的一致性和质量。

消融研究

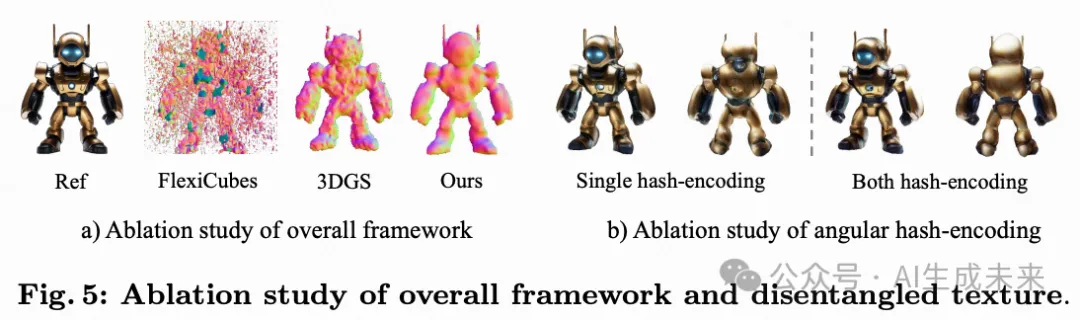

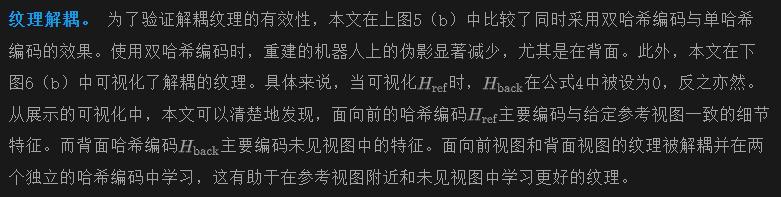

粗到细框架。 本文的框架集成了一个粗略阶段以学习初始几何形状,然后是一个细化阶段以优化几何形状和着色纹理。本文在下图5(a)中验证了这种粗到细流程的必要性。本文首先使用等值面表示直接学习几何形状,发现如果没有初步的几何初始化,几何优化容易崩溃。因此,粗略初始化变得至关重要。此外,本文展示了从粗略阶段的3DGS中提取的粗糙网格的法线贴图。可以观察到,粗略阶段往往会生成粗糙甚至不闭合的几何形状,且难以缓解。这些发现表明,结合这两个阶段对于Vista3D的最佳性能是至关重要的。

结论

本文提出了一种从粗到细的框架 Vista3D,以探索单张输入图像的3D暗面。该框架通过文本提示实现用户驱动的编辑,或通过图像字幕提高生成质量。生成过程从通过高斯喷射获得的粗略几何开始,随后使用等值面表示进行细化,并辅以解耦的纹理。这些3D表示的设计能够在短短5分钟内生成纹理网格。此外,扩散先验的角度组合使本文的框架能够揭示未见视角的多样性,同时保持3D一致性。本文的方法在现实感和细节方面超越了以往的方法,在生成时间和纹理网格质量之间达到了最佳平衡。本文希望本文的贡献能够激励未来的进步,并促进对单张图像3D暗面的进一步探索。

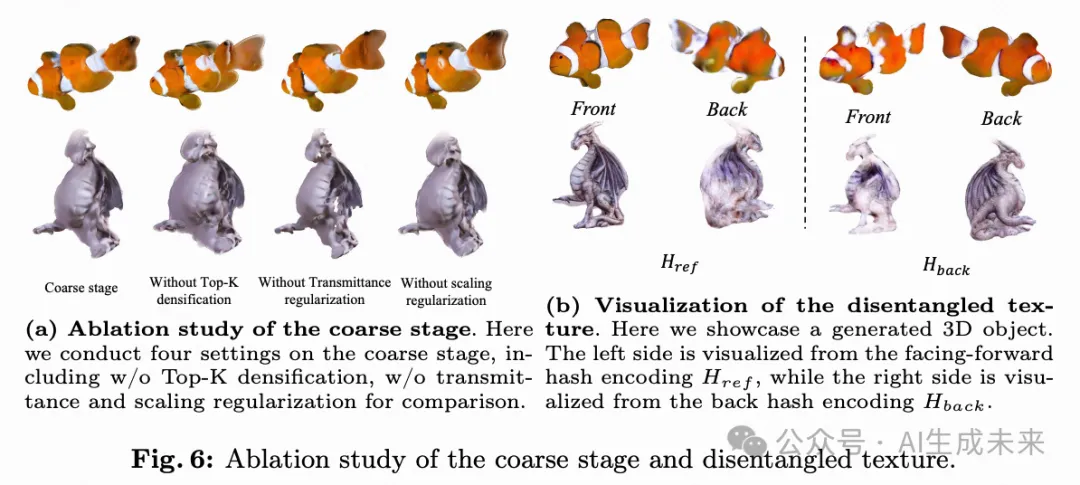

本文转自AI生成未来 ,作者:Qiuhong Shen等