Llama 3.2 强势震撼登场:从 1B 纯文本跃至 90B 多模态,成就端侧 AI 巅峰杰作 原创

在当今科技飞速发展的时代,人工智能技术正以惊人的速度不断演进,为我们的生活和工作带来了翻天覆地的变化。Meta 公司作为科技领域的巨头之一,一直致力于推动人工智能的发展。2024 年 9 月 25 日,Meta 公司重磅推出了 Llama 3.2。 引起了广泛关注,它究竟有哪些令人瞩目的特点和创新呢?让我们一同深入探索。

一、Llama 3.2简介

Llama 3.2 是 Meta 公司开发的一款强大的人工智能模型。它在之前版本的基础上进行了优化和升级,拥有更加出色的性能和广泛的适用性。Llama 3.2 包括了不同参数规格的视觉模型和轻量级纯文本模型,为各种应用场景提供了灵活的选择。

二、Llama 3.2功能特点

1. 强大的视觉处理能力

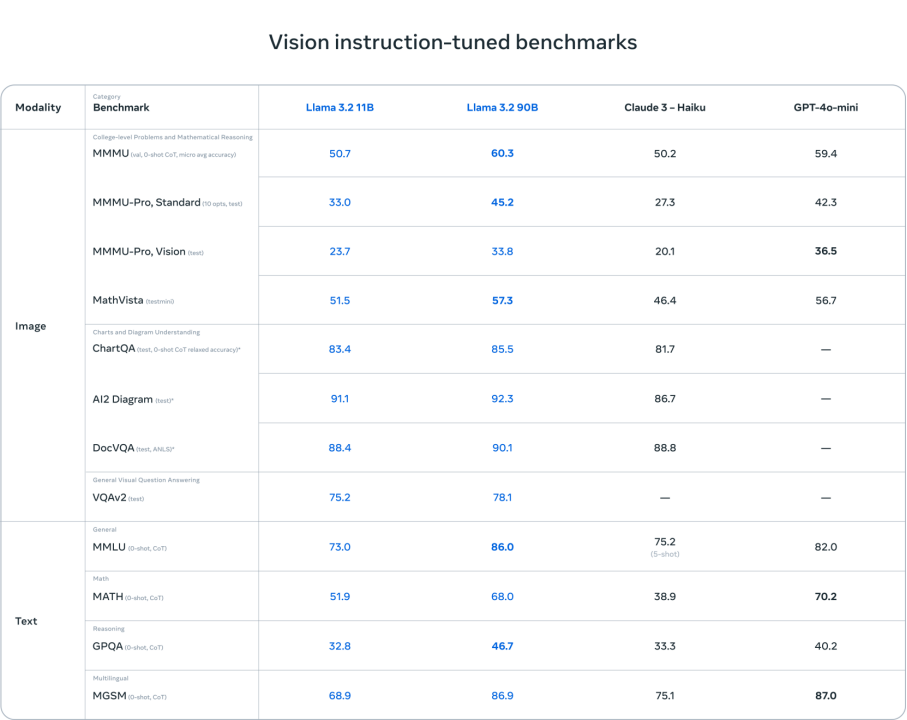

Llama 3.2 拥有 90b 和 11b 两种参数规格的视觉模型,在图像理解任务上表现卓越。它可以完成图像理解、视觉推理、图像标题、图像文本检索、文档视觉问题解答等多种任务。在相关的基准评分中,Llama 3.2 的视觉模型高于包括 Claude 3 Haiku 和 GPT-4 Omini 在内的封闭模型,展现出了强大的竞争力。

例如,在图像理解任务中,Llama 3.2 可以准确地识别图像中的物体、场景和动作,并给出详细的描述。在视觉推理任务中,它能够根据图像中的信息进行逻辑推理,回答各种复杂的问题。这种强大的视觉处理能力为图像相关的应用提供了有力的支持。

2. 轻量级纯文本模型

除了视觉模型,Llama 3.2 还包括能在设备端本地运行的 1b 和 3b 轻量级纯文本模型。这些模型支持 128k tokens 上下文,适配高通和联发科硬件,并针对 ARM 处理器做了优化。这意味着开发者可以在资源受限的设备上运行这些模型,为移动应用等场景提供了强大的人工智能支持。

轻量级纯文本模型具有多语言文本生成和工具调用能力,可用于移动人工智能写作助手和客户服务应用等场景。在保证数据隐私的同时,为用户提供个性化的服务。

三、Llama 3.2模型评估

Meta 公司发布了 Llama 3.2 视觉模型的部分评估数据。具体如下:

1. 文本相关任务方面

对于轻量级的 Llama 3.2 3b 模型,在指令遵从、总结、提示词重写、工具使用等任务上的表现优于 Gemma 22.6b 和 Phi 3.5-mini;而 1b 的表现与 Gemma 相当。这说明 Llama 3.2 的轻量级模型在文本处理的一些常见任务上也具有较好的性能,能够满足一定的应用需求。

2. 图像理解任务方面

在涉及多种语言的 150 多个基准数据集上进行了评估。其视觉模型在图像识别等一系列视觉理解任务上足以比肩业界领先的基础模型 Claude 3 Haiku 和 GPT-4 Omini。这意味着 Llama 3.2 在图像理解的准确性、对不同图像场景和内容的识别能力等方面达到了较高的水平,能够与这些知名模型相媲美。

这些只是 Meta 公司公布的部分性能测试结果,随着更多开发者和研究机构对 Llama 3.2 的使用和测试,可能会有更全面、深入的性能分析和评估结果出现。如果你想了解更详细的性能测试信息,可以关注 Meta 公司的官方发布或相关的技术论坛、研究报告等。

四、本地部署体验

1. 安装依赖

需确保安装的 transformers 版本不低于 4.43.0。

pip install transformers

pip install 'accelerate>=0.26.0'

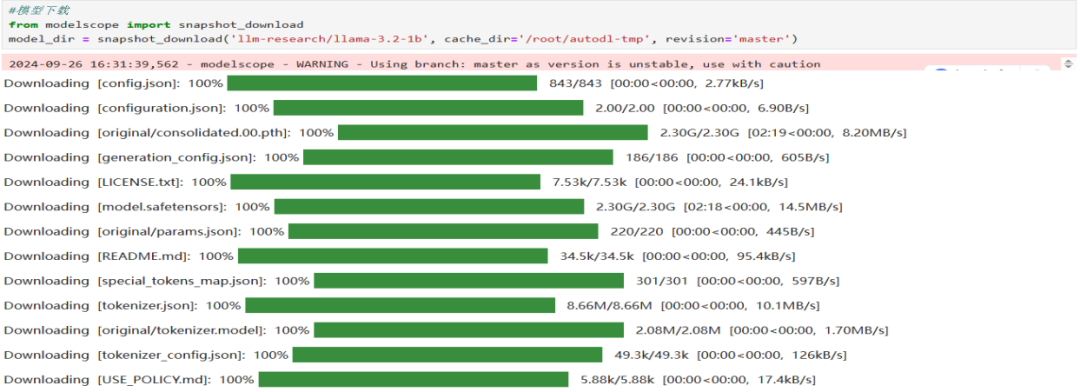

pip install modelscope2. 模型下载

使用 modelscope 中的 snapshot_download 函数下载模型(提前安装modelscope :pip install modelscope)。第一个参数为模型名称,参数 cache_dir 用于指定模型的下载路径。

#模型下载

from modelscope import snapshot_download

model_dir = snapshot_download('llm-research/llama-3.2-1b', cache_dir='/root/autodl-tmp', revisinotallow='master')下载完成如下:

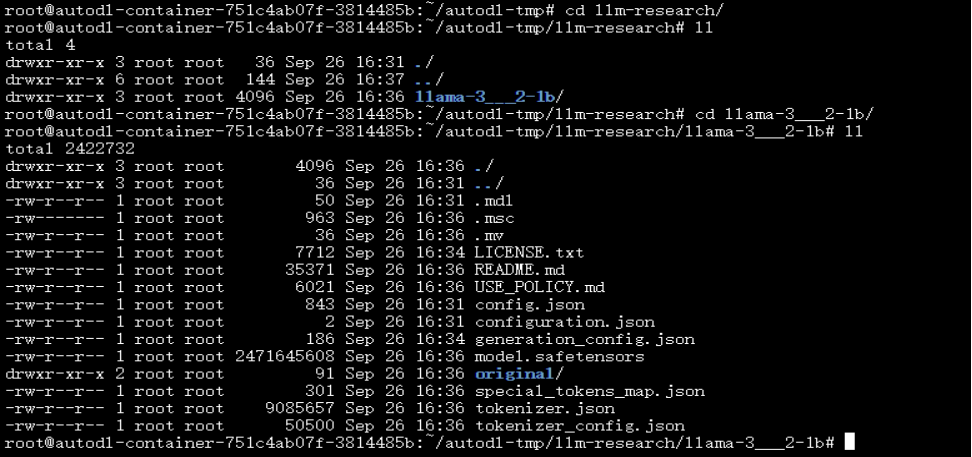

模型下载完成后,可在/root/autodl-tmp/llm-research/llama-3___2-1b目录下查看模型文件

注意检查对比文件数量和大小,确认文件下载是否完整。

3. 模型推理

以下是使用 Python 进行模型推理的代码示例。

import torch

from transformers import pipeline

model_id = "/root/autodl-tmp/llm-research/llama-3___2-1b"

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype=torch.bfloat16,

device_map="auto"

)

pipe("The key to life is")输出:

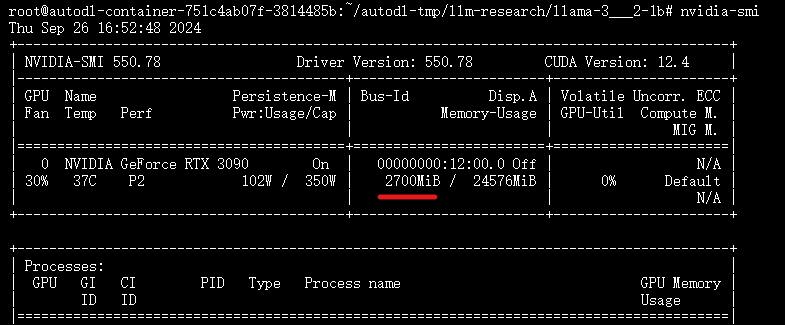

[{'generated_text': 'The key to life is to be happy. The key to happiness is to be kind. The'}]GPU资源消耗如下:

图片

图片

结语

Llama 3.2 的推出标志着 Meta 在人工智能领域又迈出了坚实的一步。它强大的功能特点和广泛的应用场景,为我们展示了人工智能的无限潜力。随着技术的不断进步,我们相信 Llama 3.2 将在未来的日子里为我们的生活和工作带来更多的惊喜和便利。让我们拭目以待,共同见证人工智能的辉煌未来。同时,我们也期待着更多的科技公司能够推出更加先进的人工智能技术,共同推动人工智能行业的发展。

相关资料

- 官网地址:https://www.llama.com/

- 模型地址:https://huggingface.co/meta-llama/Llama-3.2-1B

- Github地址:https://github.com/meta-llama/llama-models/tree/main/models/llama3_2

本文转载自 小兵的AI视界,作者: 小兵