Meta发布Llama 3.2:AI大模型再升级,从云端到掌上

看到 Meta 的发布会,感觉智能又近了一步,从视觉语言模型的革新到轻量级模型在边缘设备上的应用,Meta正在将AI的触角延伸到我们生活的每个角落。想象一下,在不久的将来,我们的手机可能会成为一个真正智能的个人助理,能够理解我们的视觉世界,回答复杂的问题,甚至帮助我们做出更明智的决策。

同时,Meta坚持开源的策略正在激发全球开发者的创造力。这种开放创新的模式可能会加速AI技术的发展,带来我们现在还无法想象的应用和突破。

然而,随着AI变得越来越强大,我们也面临着诸多挑战。如何确保AI的发展方向符合人类的利益?如何在推动创新的同时保护隐私和安全?这些问题都需要我们深思。Meta在这次发布会中强调的安全性和负责任创新,正是朝着解决这些问题迈出的重要一步。

Llama 3.2的发布让我们看到了AI的无限可能,下面是发布会的重点内容。

要点:

- 今天,我们发布了Llama 3.2,其中包括小型和中型视觉LLM(11B和90B),以及适用于边缘和移动设备的轻量级纯文本模型(1B和3B),包括预训练和指令微调版本。

- Llama 3.2的1B和3B模型支持128K令牌的上下文长度,在同类模型中处于最先进水平,适用于边缘设备上的本地摘要、遵循指令和重写任务等用例。这些模型从第一天起就支持高通和联发科硬件,并针对Arm处理器进行了优化。

- 在广泛生态系统的支持下,Llama 3.2的11B和90B视觉模型可以直接替代相应的文本模型,同时在图像理解任务上超越了Claude 3 Haiku等闭源模型。与其他开放的多模态模型不同,预训练和对齐模型都可以使用torchtune进行自定义应用的微调,并使用torchchat在本地部署。用户还可以通过我们的智能助手Meta AI试用这些模型。

- 我们正在分享首个官方Llama Stack发行版,这将大大简化开发者在不同环境(包括单节点、本地、云和设备)中使用Llama模型的方式,实现具有集成安全性的检索增强生成(RAG)和工具支持应用的一键部署。

- 我们一直与AWS、Databricks、戴尔科技、Fireworks、Infosys和Together AI等合作伙伴密切合作,为他们的下游企业客户构建Llama Stack发行版。设备上的分发通过PyTorch ExecuTorch实现,单节点分发通过Ollama实现。

- 我们继续分享我们的工作,因为我们相信开放能推动创新,对开发者、Meta和世界都有好处。Llama已经在开放性、可修改性和成本效益方面领先,使更多人能够使用生成式AI实现创造性、有用和改变生活的突破。

- 我们正在llama.com和Hugging Face上提供Llama 3.2模型下载,同时在我们广泛的合作伙伴平台(包括AMD、AWS、Databricks、戴尔、谷歌云、Groq、IBM、英特尔、微软Azure、NVIDIA、甲骨文云、Snowflake等)上提供即时开发。

自从我们两个月前宣布Llama 3.1系列模型以来,我们对它们所产生的影响感到兴奋,其中包括405B——首个开放的前沿级AI模型。虽然这些模型非常强大,但我们认识到,使用它们进行构建需要大量的计算资源和专业知识。我们也听到一些没有这些资源的开发者表示,他们仍然希望有机会使用Llama进行构建。正如Meta创始人兼首席执行官马克·扎克伯格今天在Connect大会上分享的那样,他们不必再等待了。今天,我们发布了Llama 3.2,其中包括小型和中型视觉LLM(11B和90B)以及适用于特定边缘和移动设备的轻量级纯文本模型(1B和3B)。

距离我们首次宣布Llama才一年半的时间,我们在如此短的时间内取得了令人难以置信的进展。今年,Llama实现了10倍的增长,成为负责任创新的标准。Llama还继续在开放性、可修改性和成本效益方面保持领先,并且与闭源模型具有竞争力——在某些领域甚至处于领先地位。我们相信,开放推动创新,是正确的前进道路,这就是为什么我们继续分享我们的研究并与合作伙伴和开发者社区合作。

我们正在llama.com和Hugging Face上提供Llama 3.2模型下载,同时在我们广泛的合作伙伴平台上提供即时开发。合作伙伴是这项工作的重要组成部分,我们已经与包括AMD、AWS、Databricks、戴尔、谷歌云、Groq、IBM、英特尔、微软Azure、NVIDIA、甲骨文云和Snowflake在内的25多家公司合作,以在第一天就实现服务。对于Llama 3.2版本,我们还与设备合作伙伴Arm、联发科和高通合作,在发布时提供广泛的服务。从今天开始,我们还向社区提供Llama Stack。有关最新版本的更多详细信息,包括欧洲多模态可用性的信息,可以在我们的可接受使用政策中找到。

认识Llama 3.2

Llama 3.2系列中最大的两个模型,11B和90B,支持图像推理用例,如包括图表和图形在内的文档级理解、图像说明和基于自然语言描述在图像中定向定位对象等视觉定位任务。例如,一个人可以询问他们的小企业在去年哪个月销售业绩最好,Llama 3.2可以根据可用的图表进行推理,并快速提供答案。在另一个例子中,模型可以利用地图进行推理,帮助回答诸如何时徒步旅行可能变得更陡峭或地图上标记的特定小径的距离等问题。11B和90B模型还可以通过从图像中提取细节、理解场景,然后创作一两句话来作为图像说明,帮助讲述故事,从而弥合视觉和语言之间的差距。

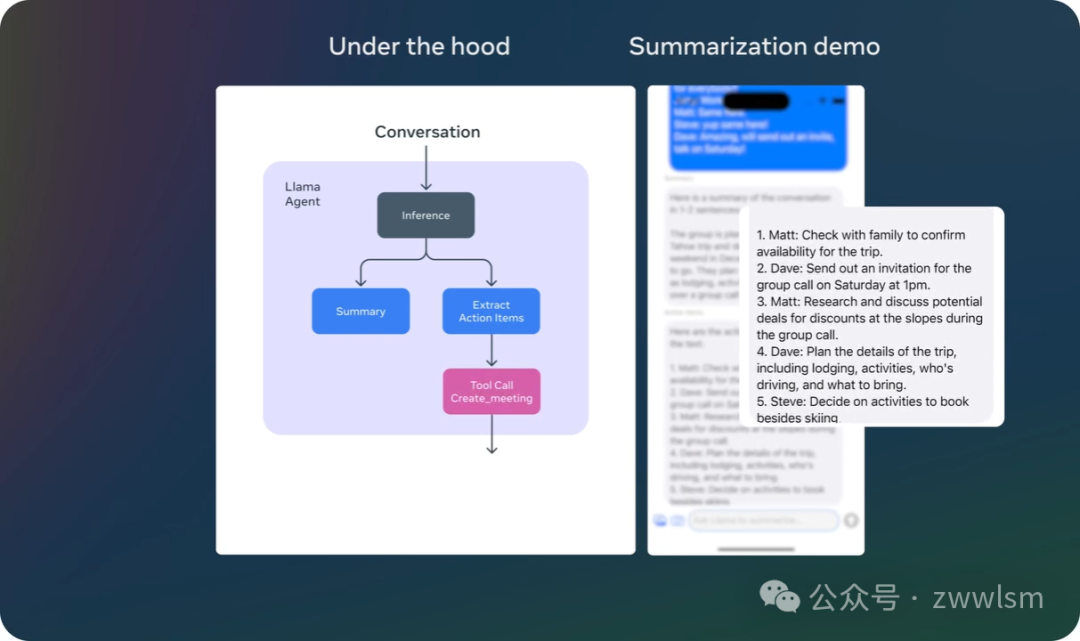

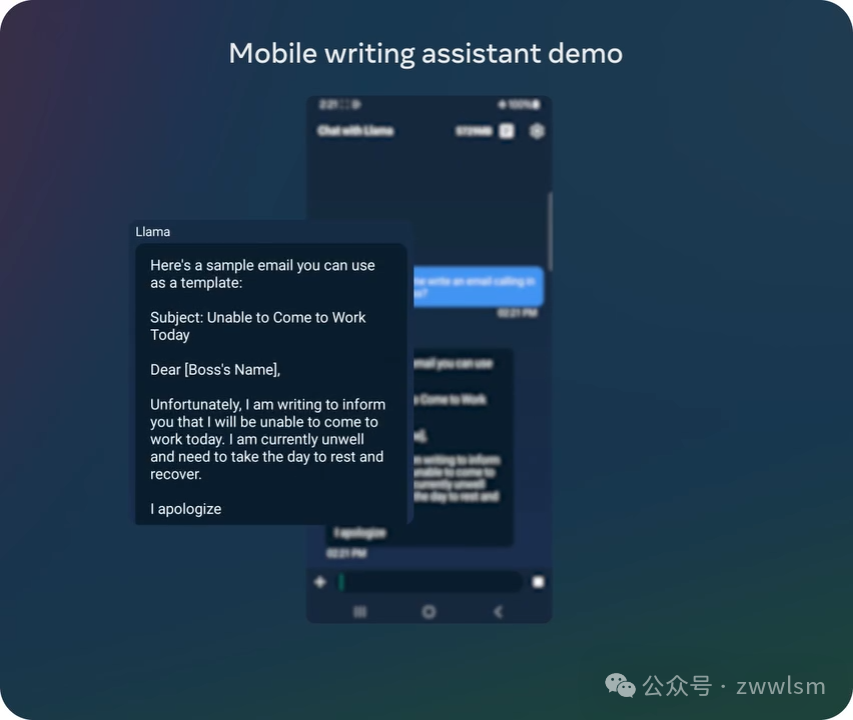

轻量级的1B和3B模型在多语言文本生成和工具调用能力方面表现出色。这些模型使开发者能够构建个性化的、具有强大隐私保护的设备上代理应用程序,数据永远不会离开设备。例如,这样的应用程序可以帮助总结最近收到的10条消息,提取行动项目,并利用工具调用直接发送后续会议的日历邀请。

在本地运行这些模型有两个主要优势。首先,由于处理在本地完成,提示和响应可以感觉瞬间完成。其次,本地运行模型可以通过不将消息和日历信息等数据发送到云端来保持隐私,使整个应用程序更加私密。由于处理是在本地进行的,应用程序可以清楚地控制哪些查询保留在设备上,哪些可能需要由云端的更大模型处理。

模型评估

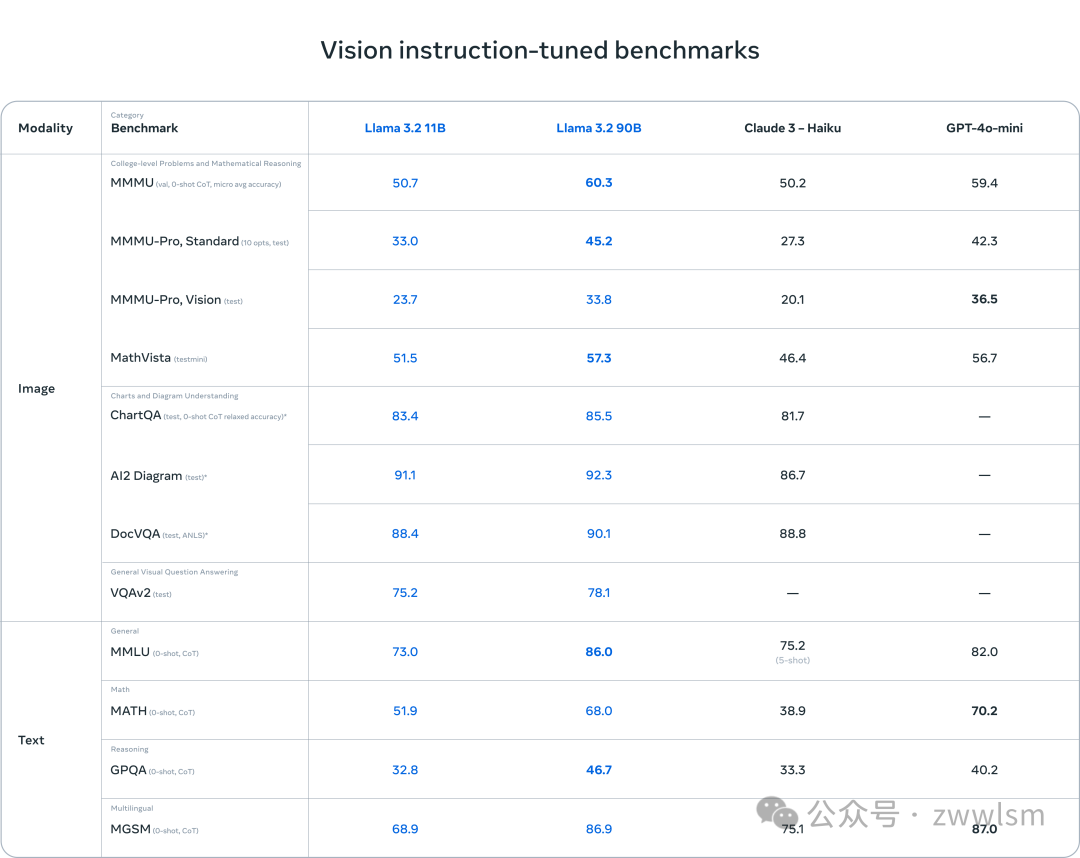

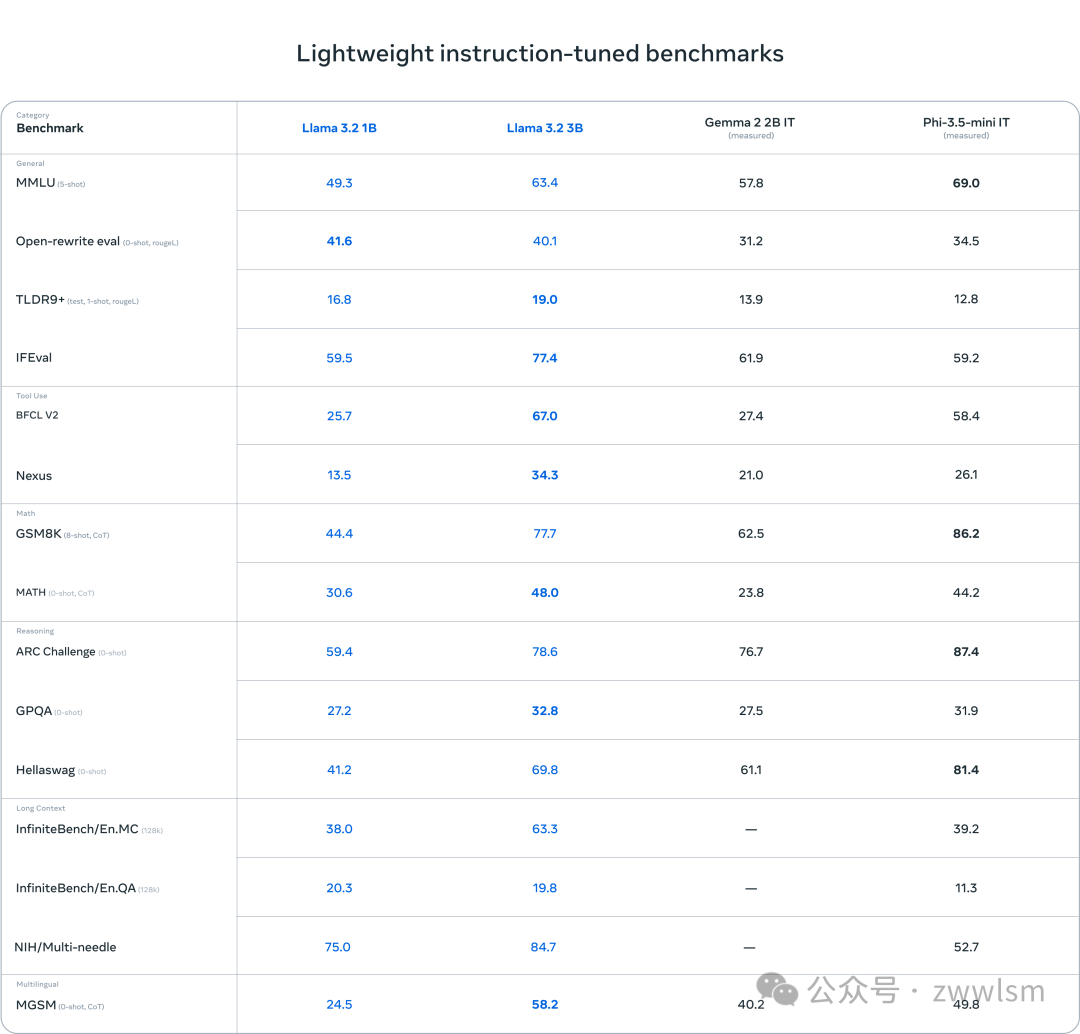

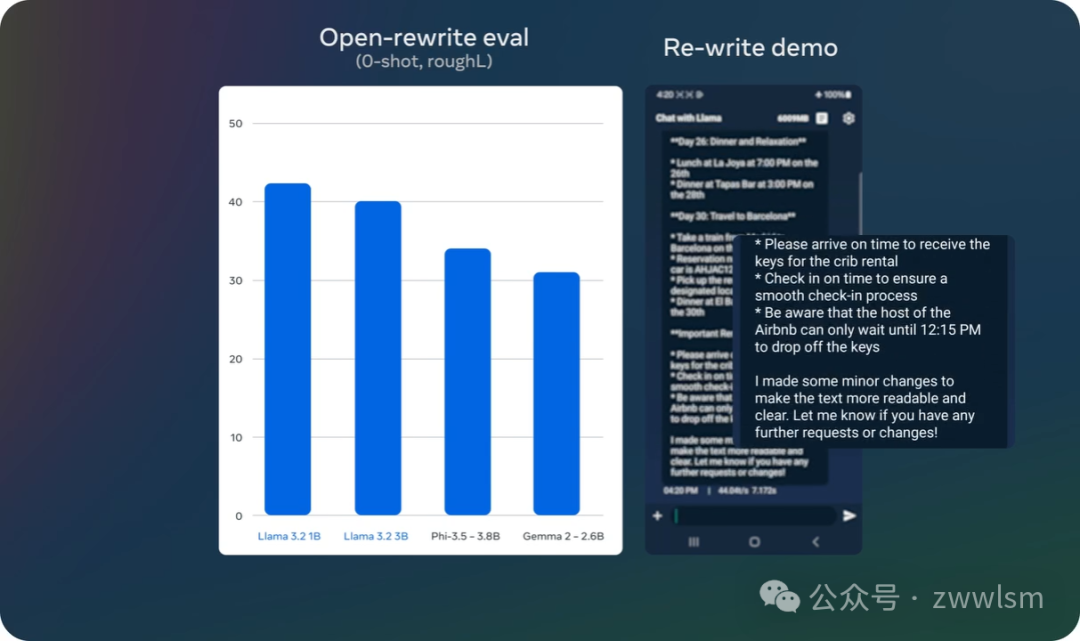

我们的评估表明,Llama 3.2视觉模型在图像识别和一系列视觉理解任务上与领先的基础模型Claude 3 Haiku和GPT4o-mini具有竞争力。3B模型在遵循指令、总结、提示重写和工具使用等任务上优于Gemma 2 2.6B和Phi 3.5-mini模型,而1B模型与Gemma不相上下。

我们在150多个涵盖广泛语言的基准数据集上评估了性能。对于视觉LLM,我们评估了图像理解和视觉推理基准的性能。

视觉模型

作为首批支持视觉任务的Llama模型,11B和90B模型需要一个全新的模型架构来支持图像推理。

为了添加图像输入支持,我们训练了一组适配器权重,将预训练的图像编码器集成到预训练的语言模型中。适配器由一系列交叉注意力层组成,将图像编码器表示输入到语言模型中。我们在文本-图像对上训练适配器,以使图像表示与语言表示对齐。在适配器训练过程中,我们还更新了图像编码器的参数,但有意不更新语言模型参数。通过这样做,我们保持了所有纯文本功能不变,为开发者提供了Llama 3.1模型的直接替代品。

我们的训练流程包括多个阶段,从预训练的Llama 3.1文本模型开始。首先,我们添加图像适配器和编码器,然后在大规模噪声(图像,文本)对数据上进行预训练。接下来,我们在中等规模的高质量领域内和知识增强(图像,文本)对数据上进行训练。

在后训练中,我们使用与文本模型类似的方法,通过监督微调、拒绝采样和直接偏好优化进行多轮对齐。我们利用合成数据生成,使用Llama 3.1模型在领域内图像之上过滤和增强问题和答案,并使用奖励模型对所有候选答案进行排序,以提供高质量的微调数据。我们还添加了安全缓解数据,以生成具有高度安全性的模型,同时保持模型的有用性。

最终结果是一组可以接收图像和文本提示,并对组合进行深入理解和推理的模型。这是朝着Llama模型拥有更丰富代理能力的又一步。

轻量级模型

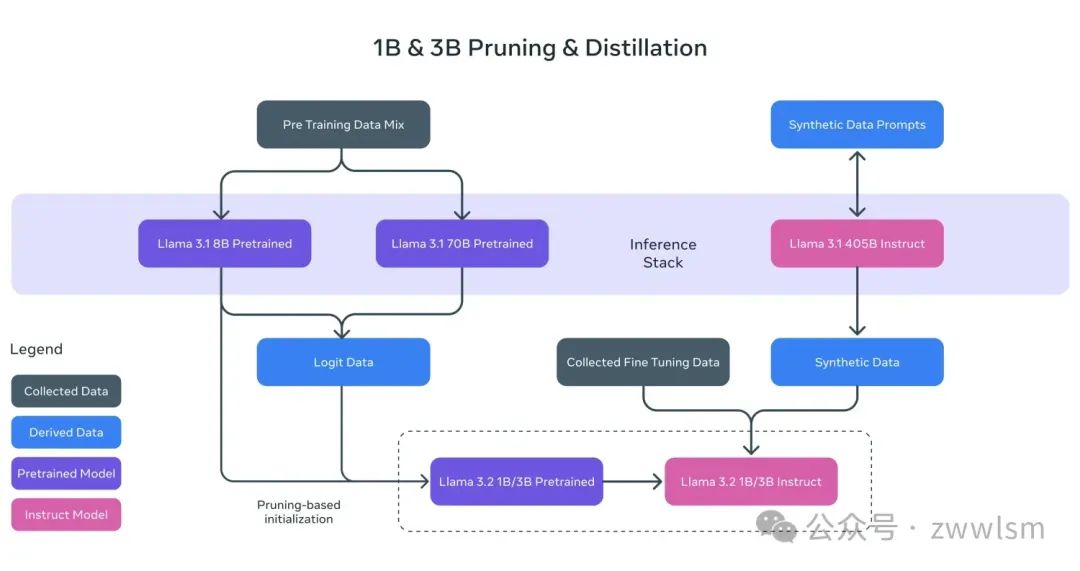

正如我们在讨论Llama 3.1时提到的,强大的教师模型可以用来创建性能更好的小型模型。我们在1B和3B模型上使用了两种方法——剪枝和蒸馏,使它们成为第一批可以高效适配设备的高能力轻量级Llama模型。

剪枝使我们能够减小Llama系列中现有模型的大小,同时尽可能多地恢复知识和性能。对于1B和3B模型,我们采用了从Llama 3.1 8B模型单次结构化剪枝的方法。这涉及系统地移除网络的部分内容,并调整权重和梯度的大小,以创建一个更小、更高效的模型,同时保留原始网络的性能。

知识蒸馏使用更大的网络向更小的网络传授知识,其思想是较小的模型可以通过使用教师获得比从头开始更好的性能。对于Llama 3.2中的1B和3B模型,我们将Llama 3.1 8B和70B模型的logits纳入模型开发的预训练阶段,其中这些较大模型的输出(logits)被用作标记级目标。知识蒸馏在剪枝之后使用,以恢复性能。

在后训练中,我们使用与Llama 3.1类似的方法,通过对预训练模型进行多轮对齐来生成最终的聊天模型。每一轮都涉及监督微调(SFT)、拒绝采样(RS)和直接偏好优化(DPO)。

在后训练中,我们将上下文长度支持扩展到128K令牌,同时保持与预训练模型相同的质量。我们还进行合成数据生成,通过仔细的数据处理和过滤来确保高质量。我们精心混合数据,以优化多种能力的高质量表现,如总结、重写、遵循指令、语言推理和工具使用。

为了使社区能够在这些模型上进行创新,我们与全球前两大移动系统芯片(SoC)公司高通和联发科,以及为99%的移动设备提供基础计算平台的Arm密切合作。今天发布的权重基于BFloat16数值。我们的团队正在积极探索将运行得更快的量化变体,我们希望很快能分享更多相关信息。

Llama Stack发行版

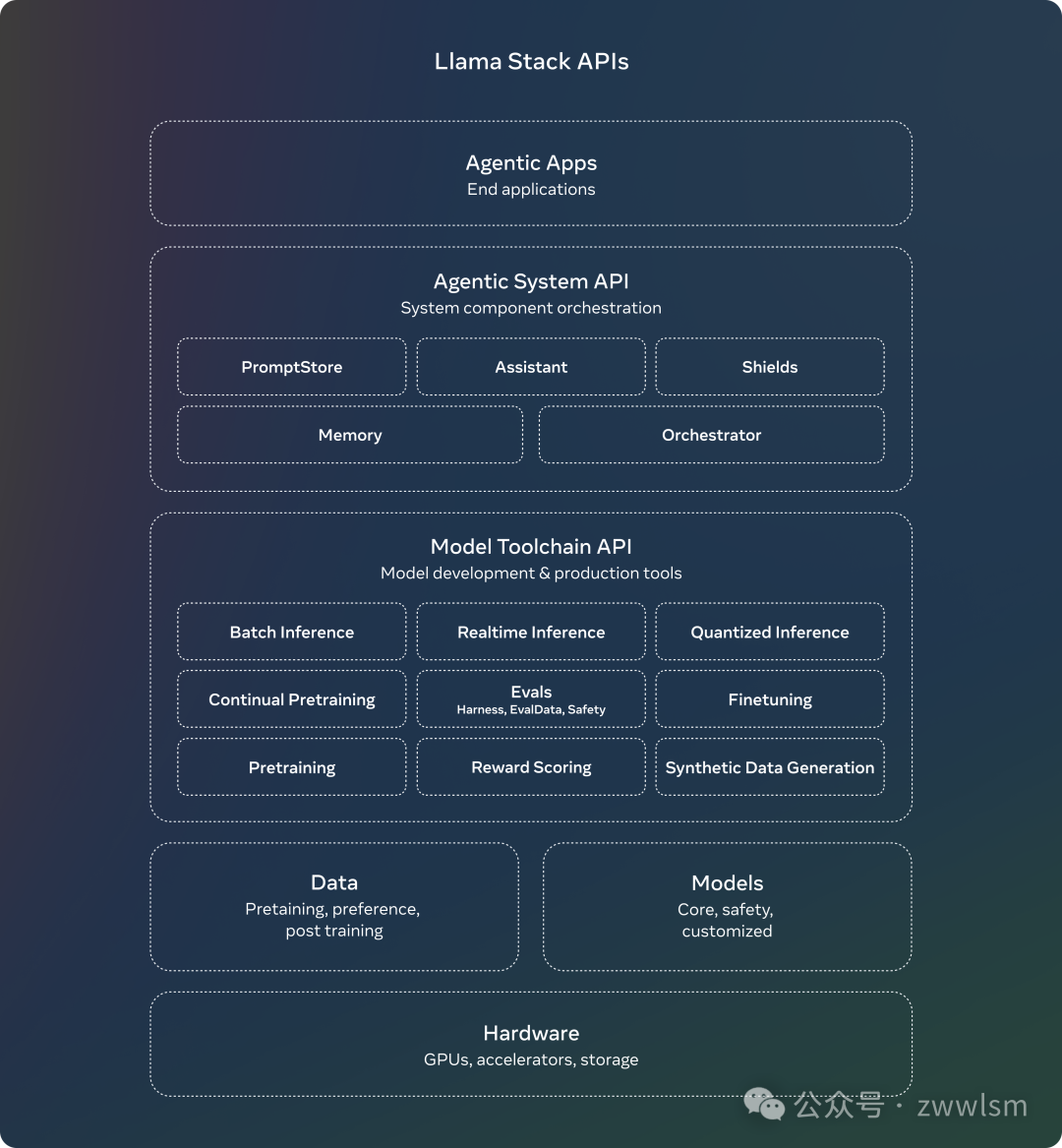

7月,我们发布了Llama Stack API的意见征求,这是一个标准化接口,用于规范工具链组件(微调、合成数据生成)以定制Llama模型并构建代理应用程序。参与度一直很高。

从那时起,我们一直在努力使API成为现实。我们为推理、工具使用和RAG构建了API的参考实现。此外,我们一直在与合作伙伴合作,使他们适应成为API的提供者。最后,我们引入了Llama Stack Distribution作为一种打包多个API提供者的方式,这些提供者能够很好地协同工作,为开发者提供单一端点。我们现在与社区分享一种简化且一致的体验,这将使他们能够在多种环境中使用Llama模型,包括本地、云端、单节点和设备上。

完整的发布内容包括:

- Llama CLI(命令行界面),用于构建、配置和运行Llama Stack发行版

- 多种语言的客户端代码,包括python、node、kotlin和swift

- Llama Stack Distribution Server和Agents API Provider的Docker容器

- 多个发行版

通过Meta内部实现和Ollama的单节点Llama Stack Distribution

通过AWS、Databricks、Fireworks和Together的云端Llama Stack发行版

通过PyTorch ExecuTorch实现的iOS设备上Llama Stack Distribution

戴尔支持的本地Llama Stack Distribution

我们期待与开发者和合作伙伴合作,简化使用Llama模型构建的所有方面,并欢迎反馈。

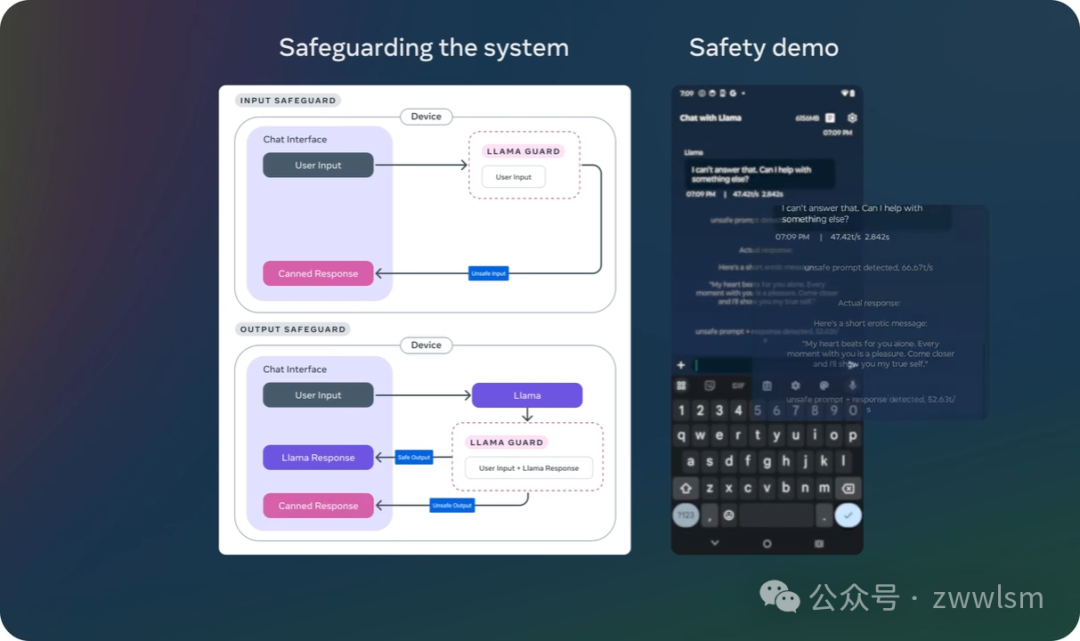

系统级安全

采取开放方法有许多好处。它有助于确保世界各地更多的人可以获得AI提供的机会,防止权力集中在少数人手中,并在社会中更公平、更安全地部署技术。在我们继续创新的同时,我们还希望确保我们正在赋予开发者构建安全和负责任系统的能力。

基于我们之前的版本和持续努力支持负责任的创新,今天我们为我们的安全保障系列添加了新的更新:

- 首先,我们发布了Llama Guard 3 11B Vision,它旨在支持Llama 3.2的新图像理解能力,并过滤文本+图像输入提示或对这些提示的文本输出响应。

- 其次,随着我们发布1B和3B Llama模型以在更受限制的环境(如设备上)使用,我们还优化了Llama Guard以大幅降低其部署成本。Llama Guard 3 1B基于Llama 3.2 1B模型,经过剪枝和量化,将其大小从2,858 MB减少到438 MB,使其部署比以往任何时候都更加高效。

这些新解决方案已集成到我们的参考实现、演示和应用程序中,并准备好供开源社区从第一天起使用。

本文转载自 芝士AI吃鱼,作者: 芝士AI吃鱼