Ollama,本地运行大模型最强工具,轻松上手

1 Ollama

Ollama是一个开源平台,帮助开发者便捷地在本地计算机上设置和运行大型语言模型(LLM)。这个平台简化了下载、安装和使用LLM的流程。

想要开始使用Ollama,首先需要下载它。你可以点击这里进行下载Ollama

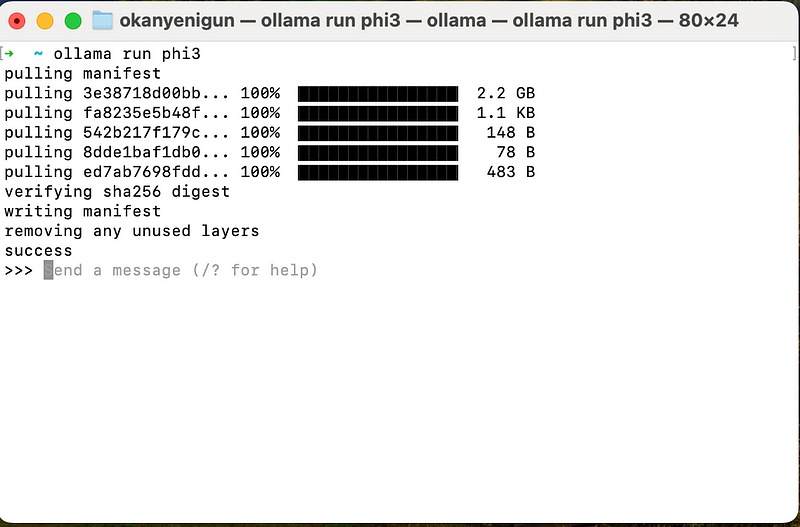

下载完成后,打开终端,输入以下命令来运行模型phi3:

或者,这样,模型phi3的各个层就会被下载到你的电脑上。如果你想先下载模型再运行,可以使用:

这样,模型phi3的各个层就会被下载到你的电脑上。

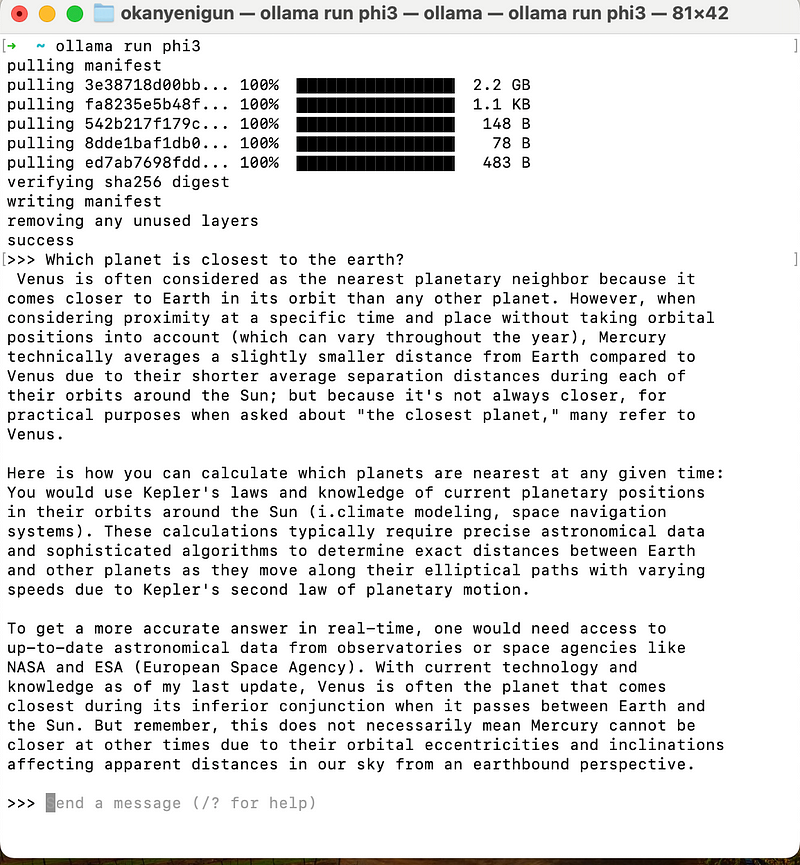

Ollama还提供了REPL(读取-求值-打印循环)环境,这是一个交互式的编程界面,可以在这里输入代码,立即看到执行结果,并继续输入新的代码。

下载模型后,Ollama的REPL就会等待你的指令。

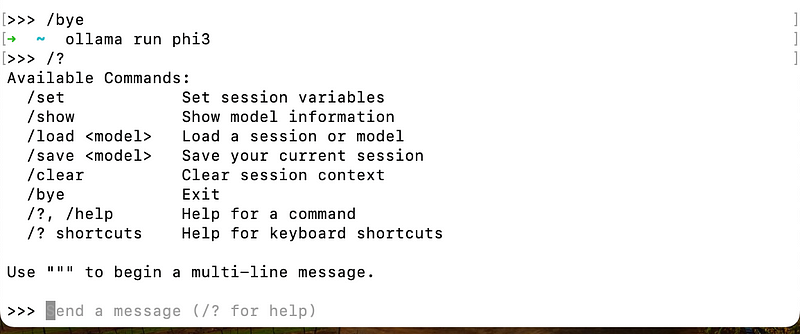

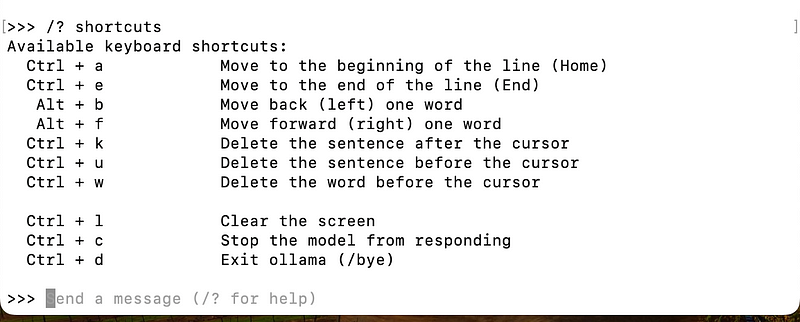

如果想查看所有可用的命令,可以在REPL中输入/?。

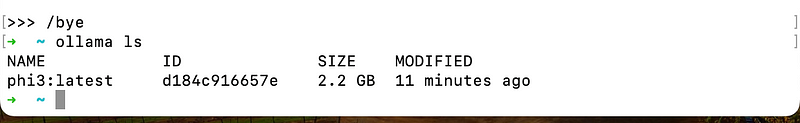

要退出REPL,只需输入/bye。

/? shortcuts获取快捷方式列表。

此外,ollama ls命令可以列出你已经下载的所有模型。

如果想要删除某个模型,可以使用ollama rm <modelname>命令。

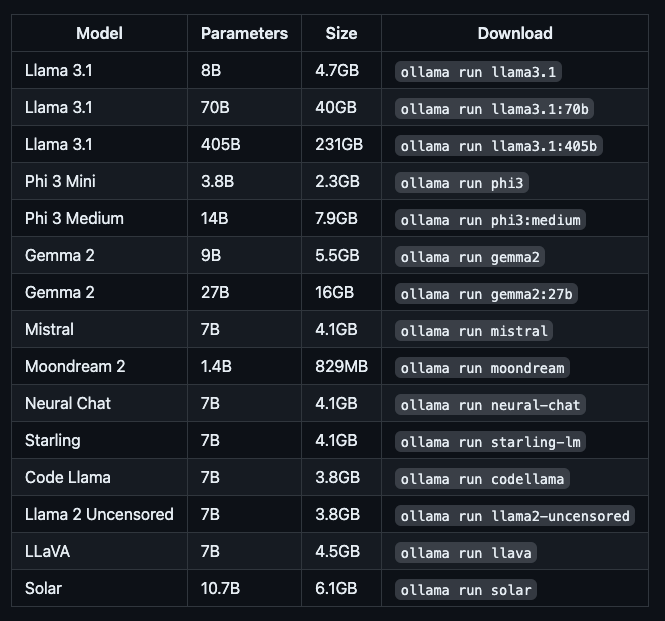

可以通过这个链接(https://ollama.com/library)查看Ollama提供的所有模型,并了解其详细信息,比如模型的大小和参数。

运行不同大小的模型需要不同量的内存:7B模型至少需要8 GB RAM,13B模型需要16 GB,而33B模型则需要32 GB。Ollama支持GPU加速,如果你没有GPU,Ollama也可以在CPU上运行,只是速度会慢一些。

模型列表

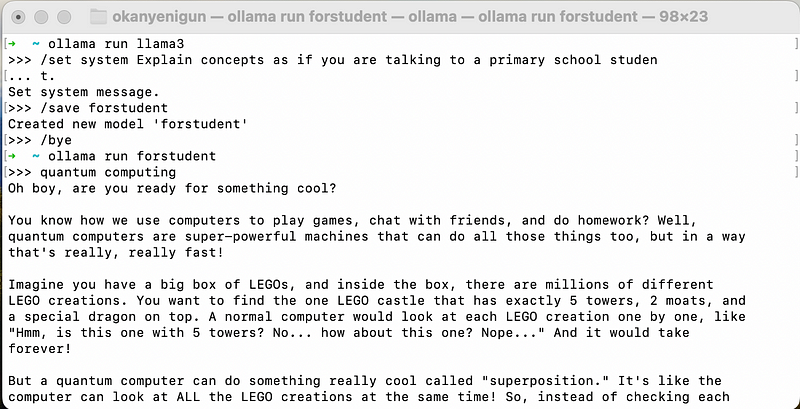

你还可以在Ollama中设置新的系统提示。例如,运行ollama run llama3后,使用/set system命令可以向系统发出指令,比如让系统像对小学生解释概念一样来解释术语。设置完成后,使用/save forstudent保存设置,然后输入/bye退出REPL。之后,你可以通过/ollama run forstudent来运行刚才保存的设置。

以上就是使用Ollama的基本步骤和一些实用命令。如果你想了解更多,可以访问Ollama的官方文档。

2 LangChain

我们可以使用LangChain与Ollama交互。

让我们构建一个简单的对话:

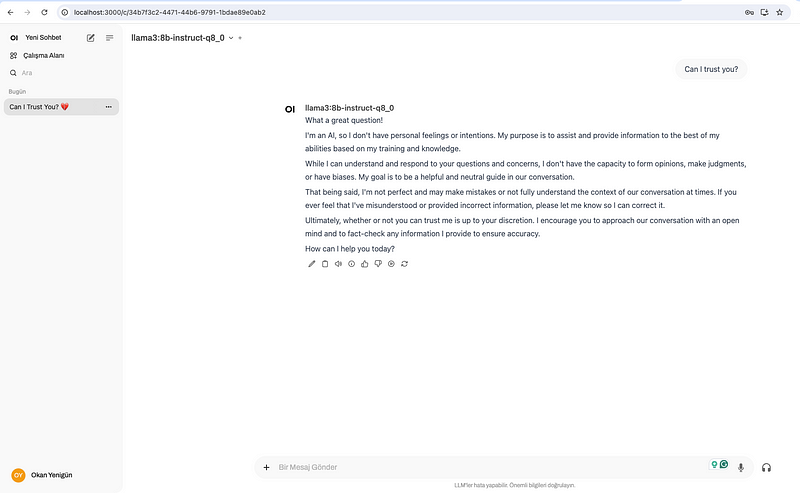

3 AnythingLLM

AnythingLLM是一个全能的AI智能体和RAG工具,运行在本地计算机上。

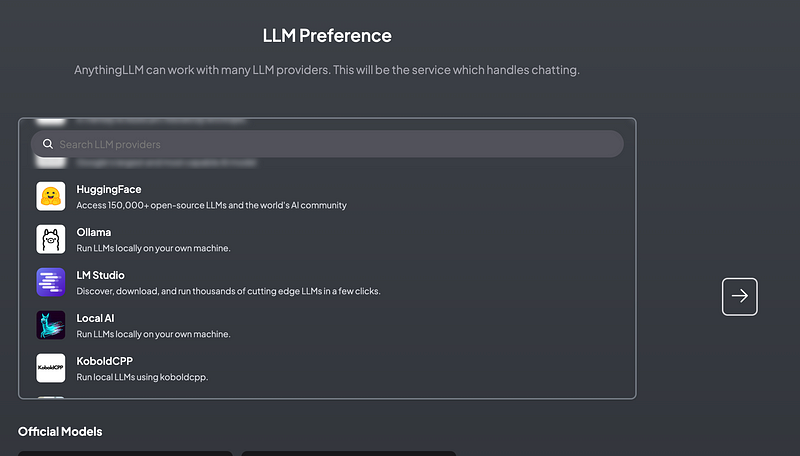

在 AnythingLLM 偏好设置屏幕中选择 Ollama。

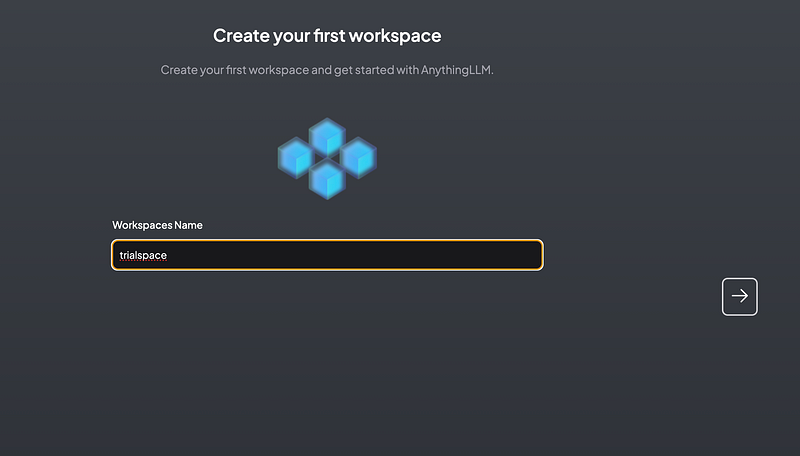

为工作区命名

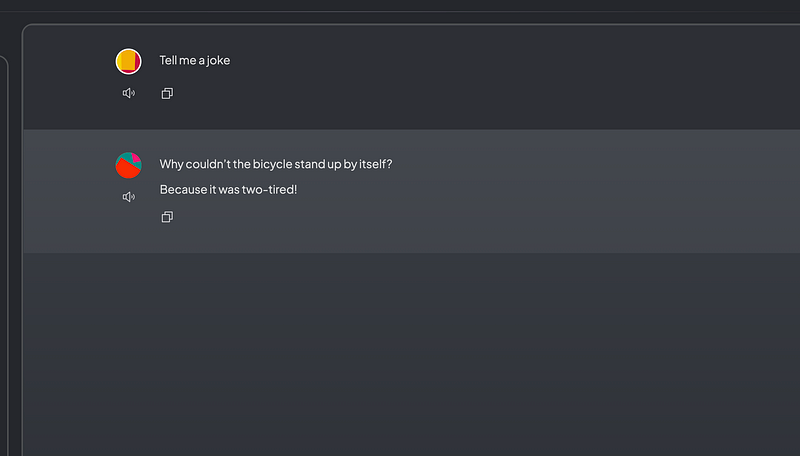

让我们试试这个模型:

4 打开WebUI

可以通过按照这里安装说明进行安装。