被神化的o1模型,规划能力到底如何?

最近OpenAI推出了新的o1模型,与之前类似检索器的大语言模型(LLM)不同,o1被称为推理器模型。o1模型可能是类似于 AlphaGo 的强化学习训练系统,只不过所生成和评估的“动作”是思维链。

依据 OpenAI 发布该模型的博客:o1模型与过去的大语言模型有所区别,是一个新系列的大型推理模型,代表了人工智能能力的新水平。所以,OpenAI将模型的计数器重置为1,命名为OpenAI o1模型。

在o1-preview 和 o1-mini 发布了一周后,作者在 PlanBench 测试数据集上进行了性能测试。

PlanBench 是一套专门用于评估LLM规划能力的工具套件。

那么,o1系列模型在规划能力上到底表现如何?

1. 传统 LLM 在PlanBench上表现如何?

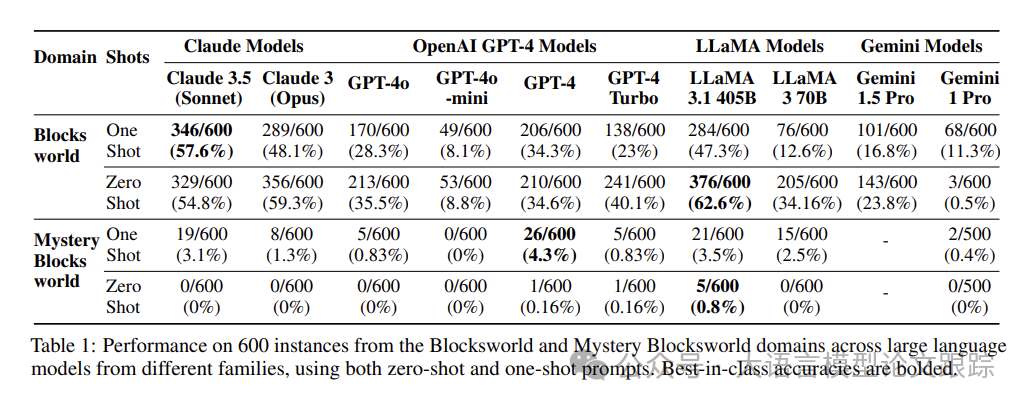

对于传统大型语言模型(通过 RLHF 进行微调的大规模 Transformer 模型),他们在 PlanBench 上的表现都差强人意,这表明依靠近似检索通常无法稳妥地解决规划问题。

图片

图片

上表展示了前一代的LLM在Blocksworld和Mystery Blocksworld数据集上的表现。

在 Blocksworld 静态数据集上,表现最好的模型是 LLaMA 3.1 405B,准确率达到了62.6%。

但是在Mystery Blocksworld数据集上(该数据集为600个语义相同但句法混淆的测试数据),没有任何一个模型能达到5%的准确率。

2. o1系列模型表现如何?

传统LLM是通过类似【检索】的方式生成结果的,尽管在【System 1】类任务重表现出色,但是在更加偏向于【System 2】的任务上,比如:规划任务,表现一般。

据论文作者所知,o1模型是一个底层 LLM(很可能是经过修改的 GPT-4o)整合进了一个经过强化学习训练的系统,该系统引导着私有思维链推理轨迹的创建、管理与最终选择。目前大家能了解到的细节仍然不多,所以只能对其确切机制进行推测。

本篇论文作者猜测 o1 与 LLM 主要有两点不同:

• 1、增加了一个强化学习的预训练阶段(可能是为了从海量合成数据中学习不同思维链的q值)

• 2、引入了一种新的自适应推理过程(或许在选择特定的思维链之前,它会通过类似于展开的方式进一步提炼已学习的q值)。

2.1 在静态测试数据集上评估o1

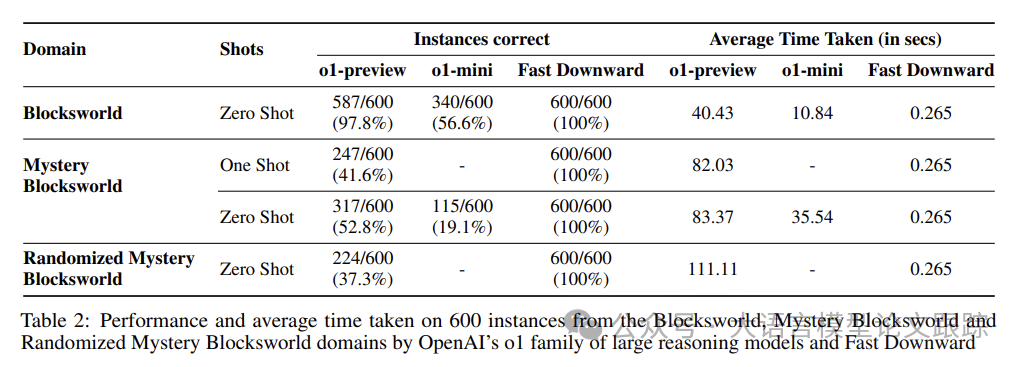

在静态的 PlanBench 测试集上对 o1-preview 和 o1-mini 进行了测试 。

图片

图片

• 在 Blocksworld 测试数据集中,o1-preview 的表现远超任何 LLM,正确回答了这些实例中的 97.8%。

• 在 Mystery Blocksworld 中,o1-preview 未能保持这样的高性能,但仍远超以往所有模型,正确回答了 52.8%。

• 在随机 Mystery Blocksworld 中,尽管准确率有所下降,仍有37.3%的问题得到了正确解答,这与之前模型测试时的零通过率形成了鲜明对比。

随机 Mystery Blocksworld是为验证数据污染是否破坏了效果,采用彻底随机的字符串创建了新的混淆,并以语义对等且明确无误的PDDL格式重新定义了问题域和具体问题的描述。

2.2 随着问题规模增加,o1表现如何?

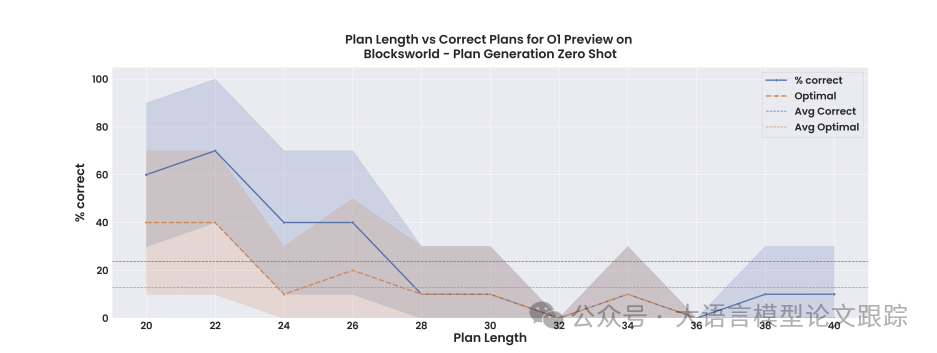

标准的 LLM 思维链提示方法较为脆弱,无法随着问题规模稳定扩展,也难以诱导通用的算法程序遵循 。

图片

图片

在一组 110 个更大的 Blocksworld 问题上对模型进行了测试。这组问题的长度范围在 6 到 20 个块之间,并且需要 20 到 40 步的最优计划。

没有任何混淆的情况下,性能从之前报告的 97.8%迅速滑落。实际上,在这 110 个实例中,o1-preview 仅能处理 23.63%,并且大部分的准确性来自于正确解决需要少于 28 步的问题。虽然这些模型总体令人赞叹,但这表明它们的性能远非稳健。

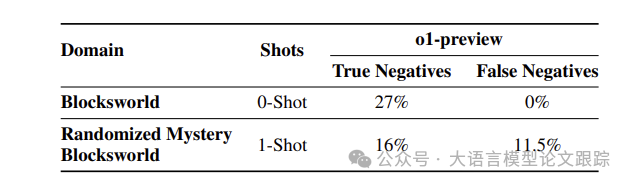

2.3 在无解问题上的性能

在真实场景中的一个例子是网络漏洞分析,希望证明对于特定系统不存在攻击计划 。LLM 一直难以认识到某些问题无法解决,而是自信地编造无意义的答案。

o1 宣称已经开始克服这个问题,并且现在能够准确地识别不可解的问题 。

为了系统地测试这一点,通过向原始的 3 到 5 个块测试集中的每个实例的目标状态添加一个“on(x,y)”类型的合取,使目标无法达成,从而修改了 100 个实例 。

图片

图片

• 在 Blocksworld 上:

只有 27%的所有实例被 o1 正确且明确地识别为不可解。

在所有情况的 19%中,模型返回一个点或某种“[空计划]”标记,没有任何关于不可解性的解释或指示。

这些应该被认为是不正确的,因为“空计划”只有在目标已经达成时才是正确的答案。

在其余 54%的情况下,模型生成了完整的(因此不可能且不正确!

)计划。

• 在随机 Mystery Blocksworld 上,这些数字更糟:

• 16%的情况被正确识别为不可解,5%返回空计划,其余 79%用完整的(不可能或不满足目标的)计划作答。

因此,不可解的实例仍然是 LRM 的难题。此外,有时能够正确注意到不可能的计划是有代价的:现在模型有时会错误地声称可解的问题实际上是不可解的。

2.4 成本收益的权衡

尽管o1-preview可能比LLMs提供更高的精准度,但它任然不能100%确保规划的正确性,其成本效益也尚不明确。

不同于以往模型仅基于输入和输出令牌数量计费,o1的每次调用费用还包括基于其使用的“推理令牌”数量的附加费——这些作为推理过程一部分生成的令牌并不向用户展示,并且以更高的输出令牌费率计费。

目前,用户无法控制生成的推理令牌数量。自这些模型推出不到一周,论文作者在这项基准测试的o1模型实验上已经累积了1897.55美元的费用!

像Fast Downward这样的经典规划器在数据集上实现了100%的准确率,仅用了一小部分的时间、计算和成本。

在个人计算机上运行Fast Downward基本上是免费的,平均每次实例0.265秒,比平均o1时钟时间快了几个数量级。结果也是可预测的,并且可以直接扩展到更难的实例。

普通的LLMs通常非常擅长在格式之间转换问题,并且可以与经典规划器一起使用,成本仅为LRMs的一小部分。

对于没有简单的PDDL领域和实例规范的问题,LLM-Modulo系统可能是一个更安全、更便宜的方法:在循环中运行一个更小、更快的LLM与一个可靠的验证器一起,以便组合系统只输出保证正确的解决方案。

这种LLM-Modulo方法已经可以在原始Blocksworld测试集的一个子集上实现82%的准确率,以及在物流领域实现70%的准确率。

这些后两种方法提供的准确性保证在像o1这样的LRMs中严重缺乏。如果一个通用推理系统继续自信地制定错误的计划,那么它就不能被部署在安全关键和非遍历领域。

o1是一个完全的黑匣子系统,甚至比以前的模型更是如此,OpenAI决定不仅要保密架构和隐藏推理痕迹,而且要警告甚至禁止任何试图理解它们内部情况的人,这使得可解释性几乎是不可能的,并且降低了对系统整体的信任。

• 论文原文: https://arxiv.org/abs/2409.13373

本文转载自大语言模型论文跟踪,作者:HuggingAGI