小扎深夜炸场!Meta首个开源多模态模型Llama 3.2横空出世,能力不输GPT4o-mini;小扎:开源的拐点来了! 原创

起猛了!小扎又又又带着他的开源大模型走来了!

Meta Connect 上,拥有视觉能力的 Llama 3.2推出!这是该大模型家族首个开源的多模态模型。

图片

图片

Llama 3.2 包括小型和中型模型(参数为 11B 亿和 90B 亿),以及更轻量化的仅文本模型(参数为 1B和 3B),扎克伯格称其为“能运行在设备上的最佳模型”,并透露未来将在眼镜设备上使用。

与其前身一样,Llama 3.2 的 1B 和 3B 模型支持 128K 的上下文长度,在端侧模型中可谓遥遥领先。根据Meta透露,这些模型在发布当天就已支持高通(Qualcomm)和联发科(MediaTek)硬件,并针对 Arm 处理器进行了优化。

Meta 还首次分享了官方的 Llama stack 发行版本,以便开发者可以在各种环境中使用这些模型,包括本地、设备端、云端和单节点。

Llama 3.2 模型可以在 llama.com 和 Hugging Face 上以及 Meta 的合作平台上下载。还能通过智能助手Meta AI,试用模型的多模态能力。

Hugging Face 地址:

https://huggingface.co/meta-llama

最后扎克伯格再次秀了一把开源情怀,他提到,闭源模型们试图降低价格以保持与Llama的竞争优势。然而,“开源已经是、并将继续是最具成本效益、可定制、可信且高性能的选择。我们已经到达了行业的一个拐点,它开始成为行业标准,可以称其为 AI 领域的 Linux。”

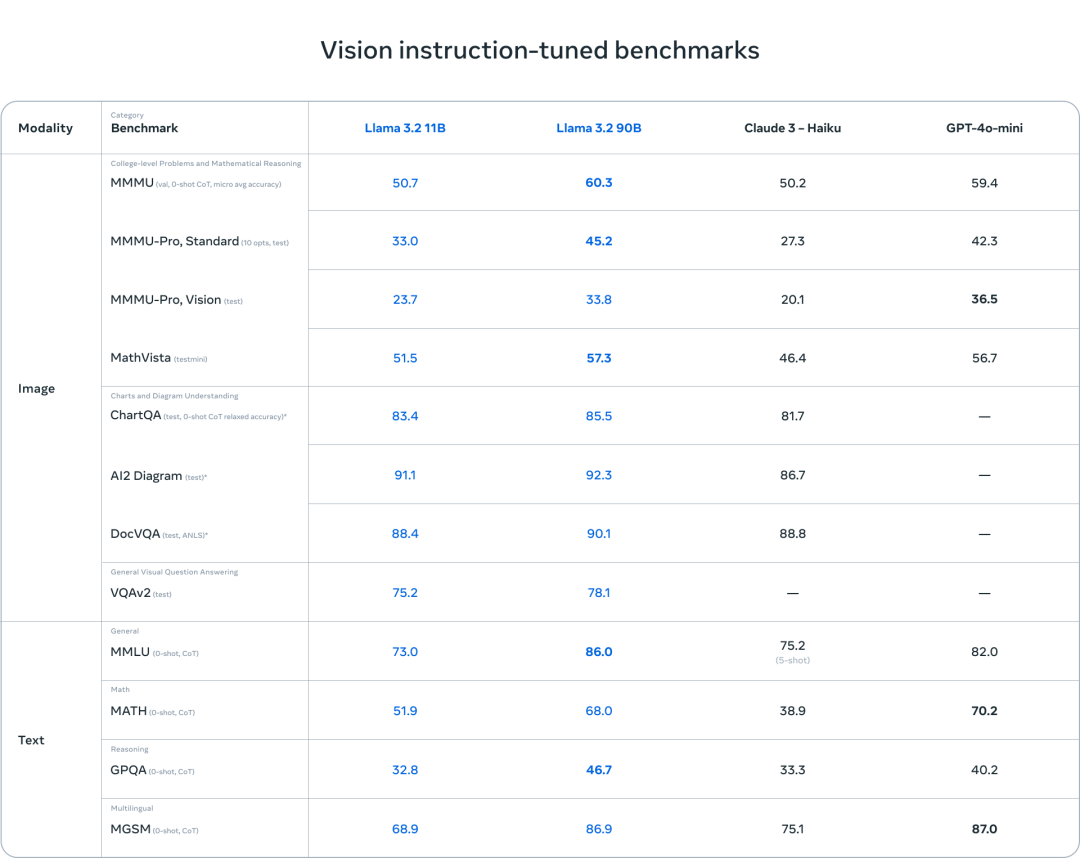

1.媲美GPT4o-mini,开源视觉模型火力十足

Meta 在两个月前发布了 Llama 3.1,至今该模型已实现 10 倍的增长。

扎克伯格表示:“Llama 继续快速进步,它正在实现越来越多的功能。”

现在,最大的两个 Llama 3.2 模型(110 亿和 900 亿参数)有了视觉能力,能够理解图表和图形、为图像生成标题以及识别周围的环境。例如,用户可以询问他们的公司在哪个月取得了最佳销售成绩,模型将基于现有的图表推理出答案。

根据Meta的评估,Llama 3.2 视觉模型在图像识别和一系列视觉理解任务上与领先的基础模型 Claude 3 Haiku 和 GPT4o-mini 相媲美。

图片

图片

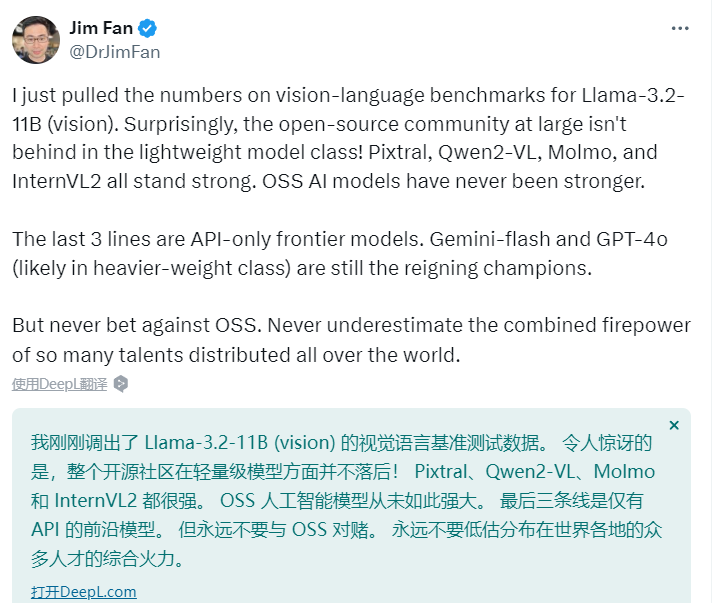

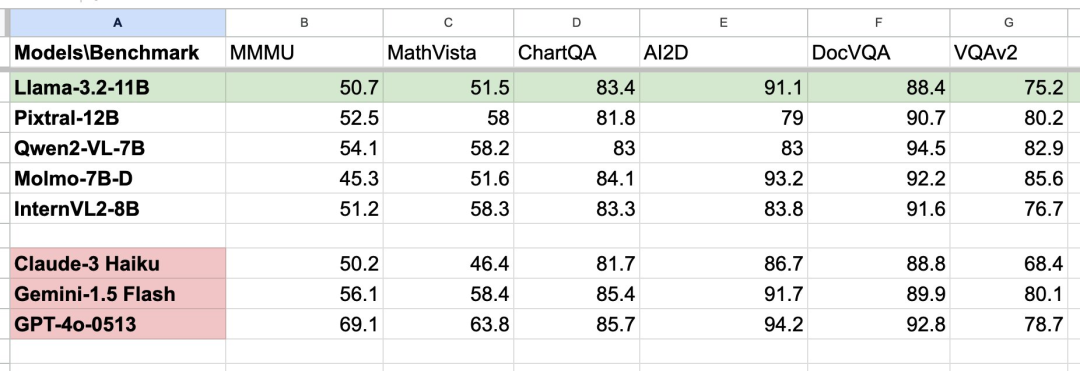

AI大神 Jim Fan 带来了一手的新鲜实测,“我刚刚调出了 Llama-3.2-11B (vision) 的视觉语言基准测试数据。令人惊讶的是,整个开源社区在轻量级模型方面并不落后!”

图片

图片

图片

图片

Llama 3.2的超强能力也让许多大神自觉“手痒”。已经有人连夜搓了基于其视觉能力的开源工具出来,效果惊艳,草图也能秒变APP。

图片

图片

2.Llama 3.2:视觉模型背后的技术细节

作为首批支持视觉任务的 Llama 模型,11B 和 90B 模型采用了全新的模型架构,以支持图像推理任务。

Meta技术报告中提到,为了支持图像输入,他们训练了一组适配器权重,将预训练的图像编码器与预训练的语言模型集成。

该适配器由一系列交叉注意力层组成,将图像编码器的表示传递给语言模型。在适配器训练过程中,我们在图文配对数据上训练,以对齐图像表示和语言表示。适配器训练期间,我们更新了图像编码器的参数,但故意不更新语言模型的参数,这样可以保留语言模型的文本处理能力,方便开发者将其作为 Llama 3.1 模型的替代品。

Llama 3.2的训练流程包括多个阶段,从预训练的 Llama 3.1 文本模型开始。首先,Llama添加了图像适配器和编码器,然后在大规模噪声图文配对数据上进行预训练。接着在中等规模、高质量的领域内及知识增强的图文配对数据上进行训练。

在后续训练中,Llama团队采用了与文本模型类似的方式,进行多轮对齐,包括监督微调、拒绝采样和直接偏好优化。

使用 Llama 3.1 模型对领域内的图像生成和扩展问答,并利用奖励模型对所有候选答案进行排序,以提供高质量的微调数据。此外,Llama 3.2还加入了安全防护数据,确保模型在安全性高的同时保持有用性。

3.小扎:Meta AI 将成为全球第一的智能助手

Llama 3.2 的横空出世,使得 Meta AI 拥有了“声音”。

该模型将在 WhatsApp、Messenger、Facebook 和 Instagram 上以明星语音响应语音或文本命令。Meta AI 还可以对聊天中分享的照片做出回复,并添加、删除或更改图像以及添加新的背景。Meta 表示,它还在尝试为 Meta AI 开发新的翻译、视频配音和唇同步工具。

图片

图片

扎克伯格在演讲中表示:“我认为语音将比文本更自然地与 AI 进行交互,它确实要好得多。”

扎克伯格开源的底气,就在于他们的商业模式并不依靠获得模型访问权而营利,但是他已经将应用视为 Meta 的护城河。

现在,Meta AI 月活跃用户接近5亿,日活用户也以突破4000万大关。

扎克伯格吹嘘说,Meta AI 正在成为全球使用最广泛的助手——“可能已经做到了。”

参考链接:https://venturebeat.com/ai/meta-llama-3-2-vision-models-to-rival-anthropic-openai/

本文转载自51CTO技术栈