Transformer结构优势 ,How Much Attention Do You Need?

前言

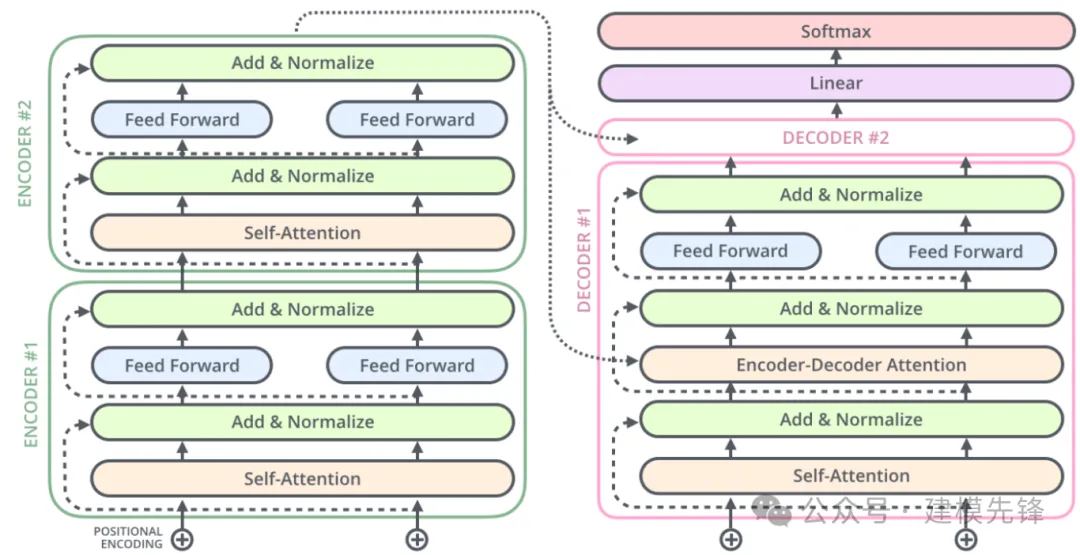

本期基于凯斯西储大学(CWRU)轴承数据,进行 Transformer 的结构优势进行讲解,结合论文《How Much Attention Do You Need? 》,探索不同模块对故障分类任务的影响力。

1 《How Much Attention Do You Need? 》

1.1 论文解析

论文提到三个观点:

(1)Source attention on lower encoder layers brings no additional benefit (x4.2).

解释:

- Source Attention:通常指的是在编码器(encoder)中,模型关注输入序列的不同部分的机制。在Transformer中,编码器的每一层都通过自注意力(self-attention)机制来处理输入序列。

- Lower Encoder Layers:指的是编码器中的靠前或较浅的层。

- 结论意义:在模型的较浅层次,对源输入进行复杂的注意力机制处理并没有显著的性能提升。也就是说,较低层次的编码器主要在做基础特征提取,而复杂的注意力模式在这些层次上未能发挥其潜力。因此,将注意力机制的复杂性集中在编码器的更深层次可能更为有效。

(2)Multiple source attention layers and residual feed-forward layers are key (x4.3).

解释:

- Multiple Source Attention Layers:在模型中使用多个层次的注意力机制来处理源输入序列。

- Residual Feed-Forward Layers:在每个注意力层之后,通常会有一个残差结构的前馈神经网络(Feed-Forward Neural Network),这对于学习复杂的特征变换是重要的。

- 结论意义:这表明,对源输入进行多层次的注意力处理,以及在每个注意力层之后使用残差前馈层,是模型性能的关键因素。这可能是因为多层次的关注机制允许模型在不同的抽象层次上理解输入序列,并通过残差连接有效地训练深层模型。

(3)Self-attention is more important for the source than for the target side (x4.4).

解释:

- Self-Attention:一种注意力机制,输入的每个元素(如序列中的一个词)对自身序列中的其他元素进行关注,以捕捉序列内部的相关性。

- Source Side vs. Target Side:在序列到序列模型中,源指的是输入序列(例如,翻译任务中的源语言),而目标指的是输出序列(例如,翻译任务中的目标语言)。

- 结论意义:这个结论表明,自注意力机制在源输入序列的处理过程中比在目标输出序列生成过程中更为重要。这可能是因为在源输入的编码阶段,理解和建模句子内部的长程依赖性和上下文关系至关重要,而在目标侧,可能更多依赖上下文和已生成的部分来预测下一个元素。

2.1 具体结构探究

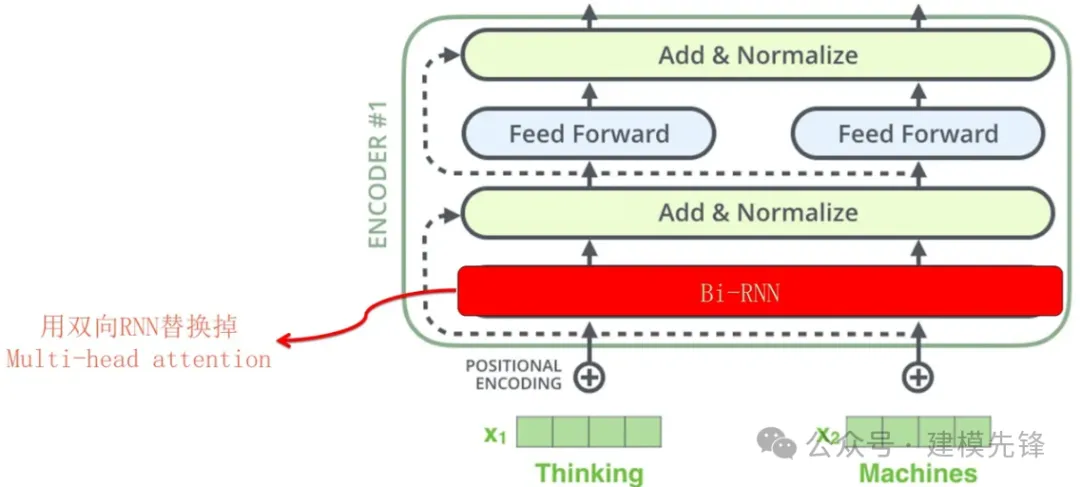

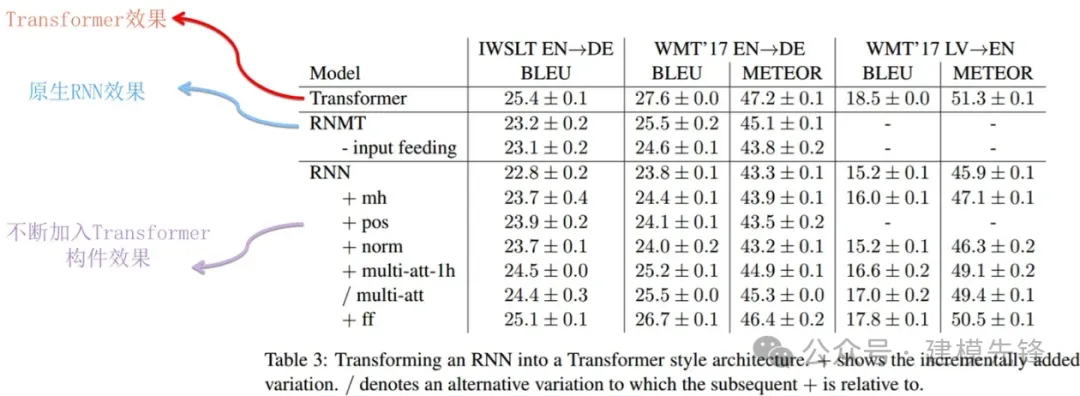

(1)双向 RNN 替换多头注意力

RNN嵌入Transformer后,上图展示了对原生RNN逐步加入Transformer的各个构件后的效果。从上面的逐步对比过程可以看到,原生RNN的效果在不断稳定提升。但是原本的Transformer相比,性能仍然有差距。

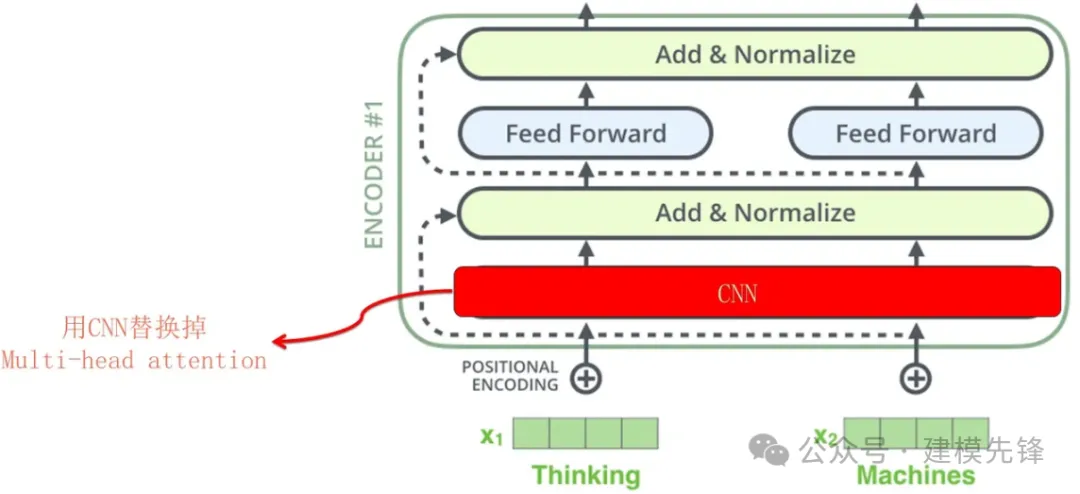

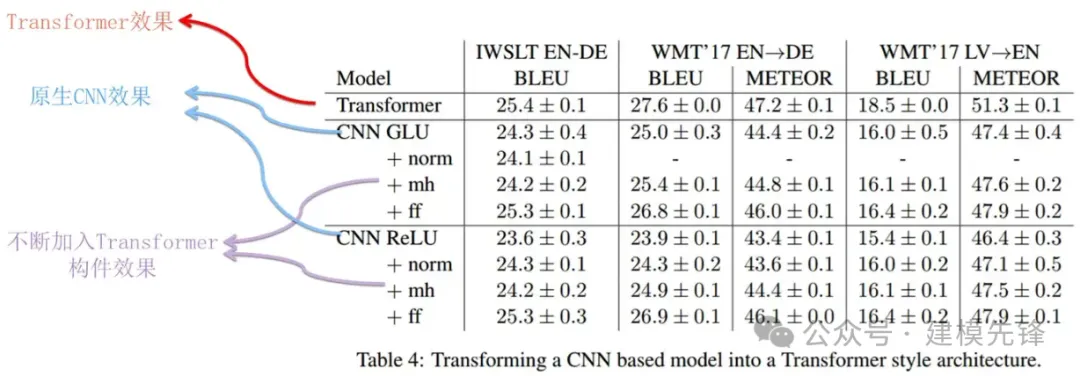

(2)CNN 替换多头注意力

上图展示了对CNN进行不断加入Transformer的各个构件后的过程以及其对应效果。同样的,性能也有不同幅度的提升。但是也与原本的Transformer性能存在一些差距。

(3)论文结论:

我们发现基于RNN的模型受益于多源注意机制和剩余前馈块。另一方面,基于CNN的模型可以通过层归一化和前馈块来改进。这些变化使基于RNN和CNN的模型更接近Transformer。此外,我们还展示了可以成功地组合体系结构。

我们发现自我注意在编码器方面比在解码器方面重要得多,即使没有自我注意的模型也表现得非常好。对于我们评估的数据集,在大多数情况下,编码器侧具有自关注的模型以及解码器侧具有RNN或CNN的模型与Transformer模型相比具有竞争力。

2 结合故障诊断进行探索

2.1 探索目标分析

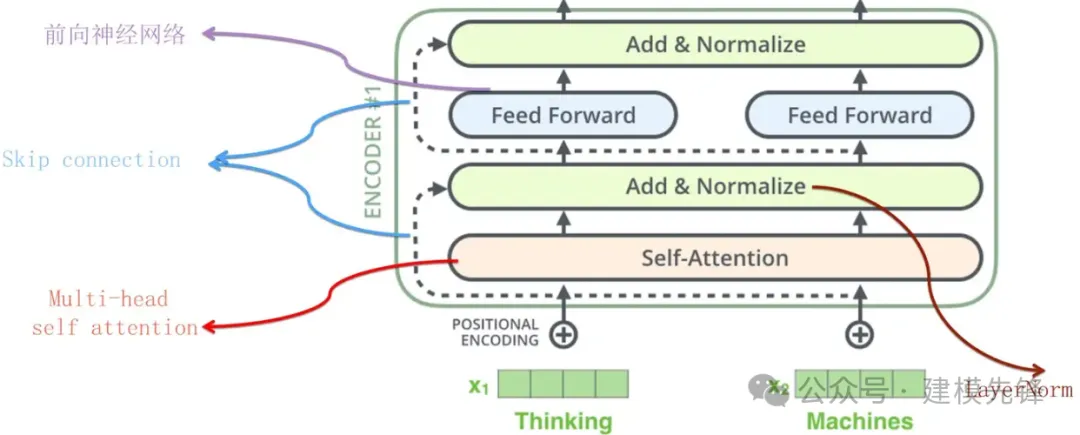

根据上述结论,编码器结构在特征提取过程中扮演着重要角色,而编码器结构又由多头注意力、前馈神经网络、残差连接等部分组成。结合故障诊断任务,我们可以锁定2个研究对象:

- 编码器整体结构

- 多头注意力机制

2.2 多头注意力机制的优势

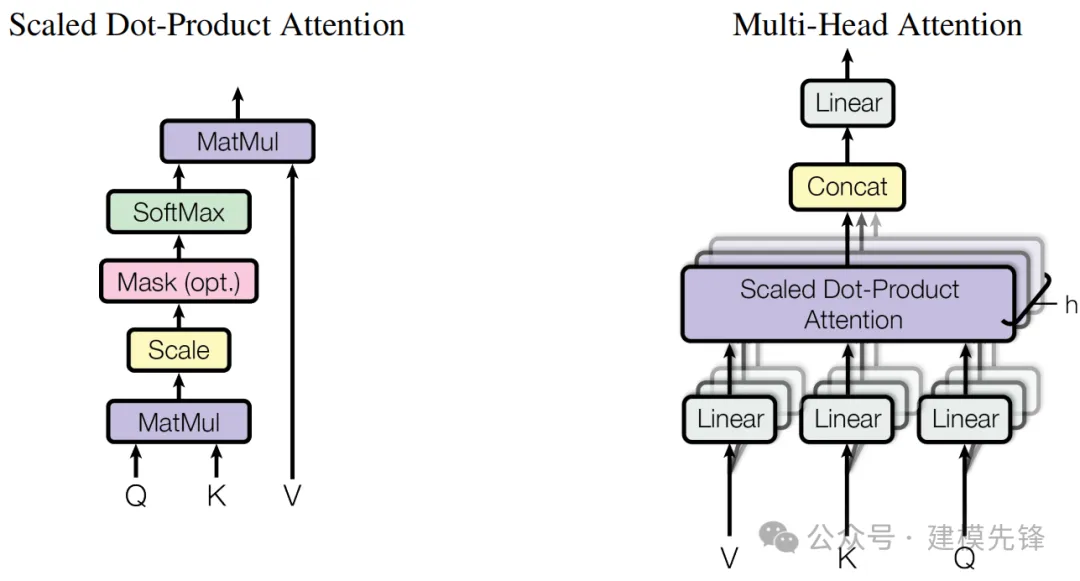

(1)多角度关注:

不同的头可以从不同的角度和细粒度的层次来关注输入序列的不同部分,从而捕捉更丰富的特征和关系。

(2)提高模型的表达能力:

多头机制使得模型可以在不同的子空间中并行学习,这增强了其表达复杂关系和模式的能力。

(3)稳定训练:

通过缩放点积和多头的并行计算,模型能更好地处理长序列并稳定梯度。

3 轴承故障数据的预处理

3.1 导入数据

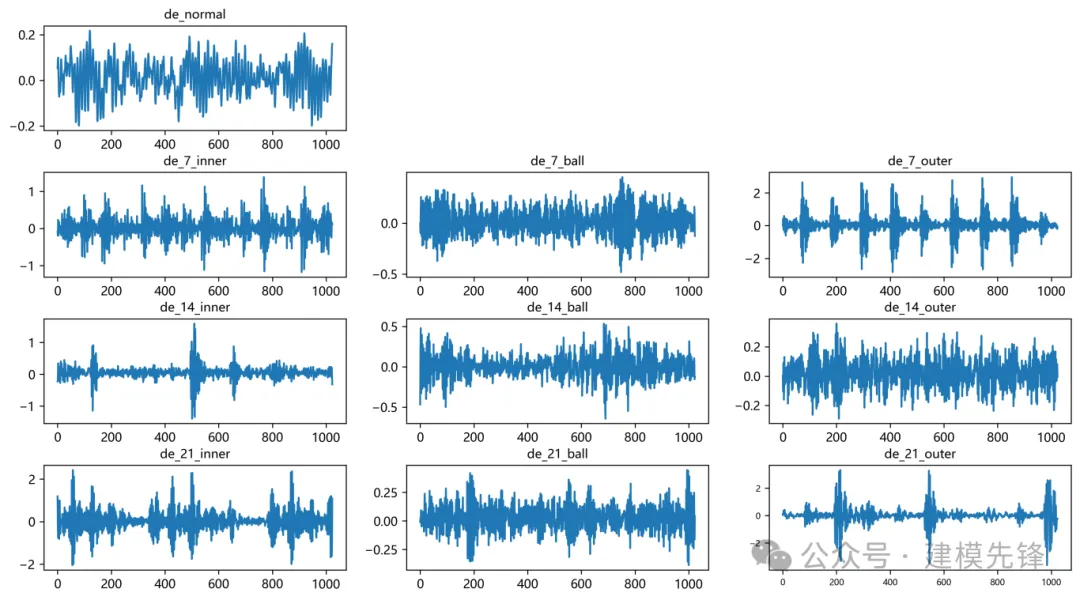

参考之前的文章,进行故障10分类的预处理,凯斯西储大学轴承数据10分类数据集:

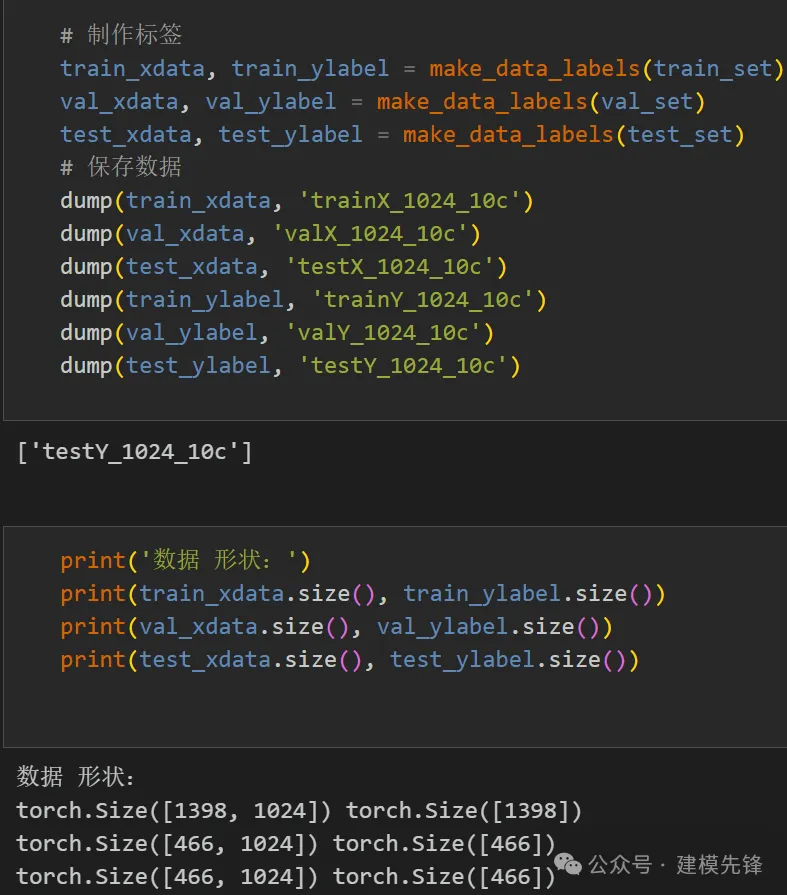

train_set、val_set、test_set 均为按照7:2:1划分训练集、验证集、测试集,最后保存数据

3.2 故障数据预处理与数据集制作

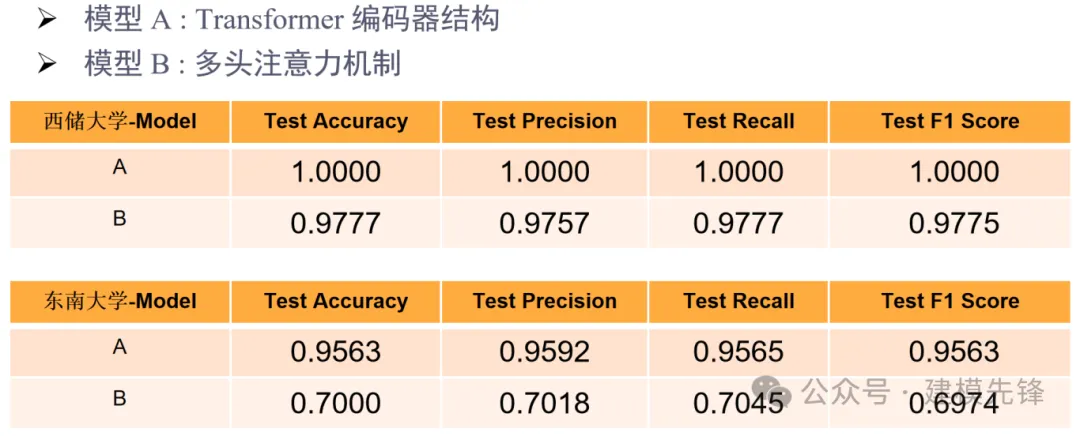

4 编码器整体结构的实验对比

4.1 对比模型为:

- 模型 A :Transformer 编码器结构

- 模型 B :多头注意力机制

4.2 西储大学十分类数据集实验对比

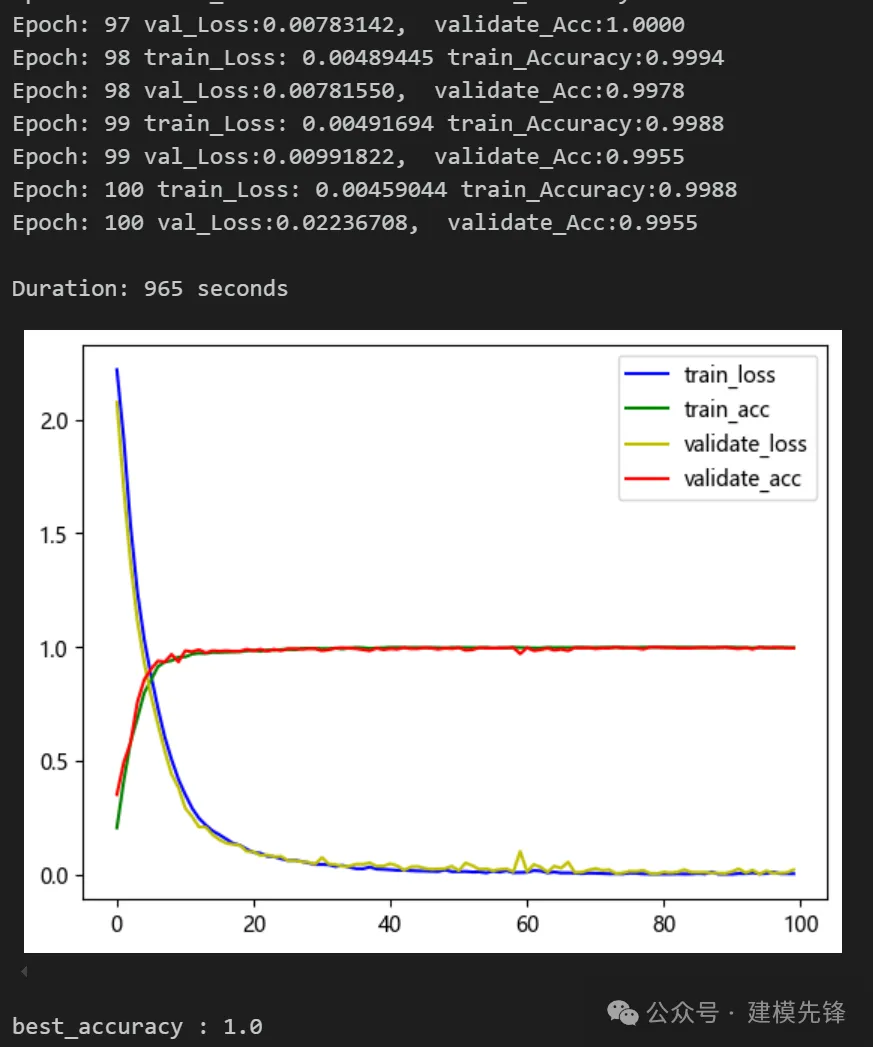

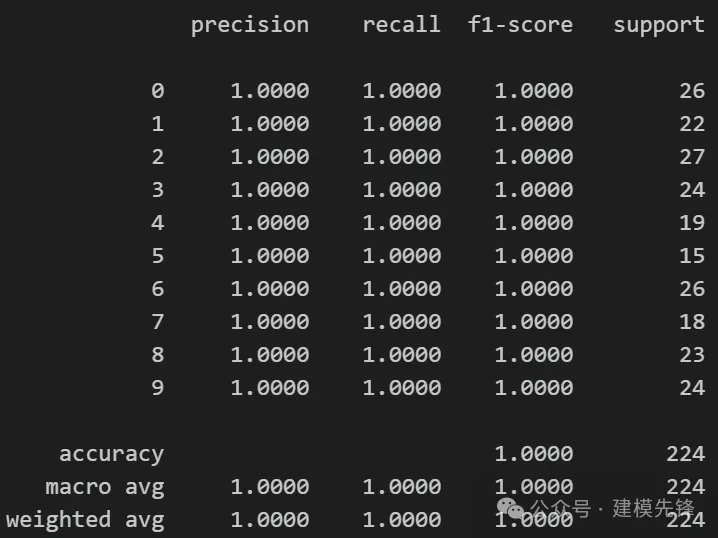

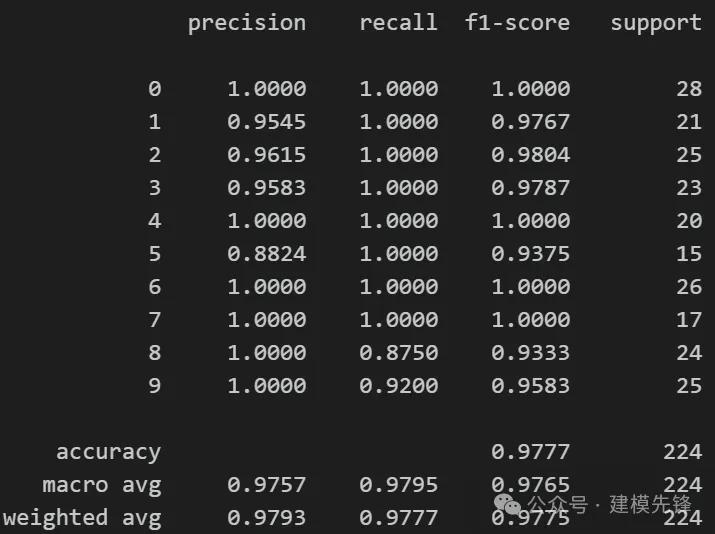

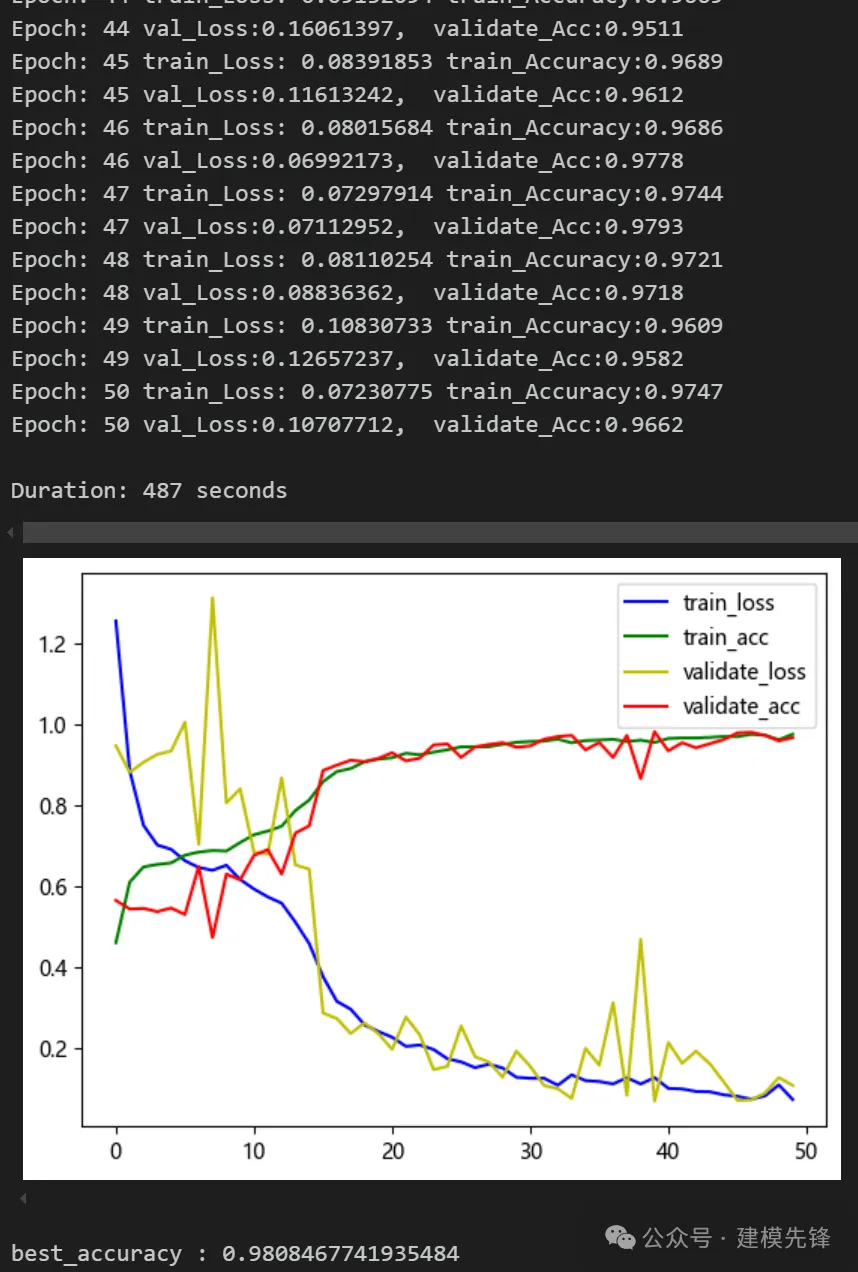

(1)模型 A:

模型评估:

准确率、精确率、召回率、F1 Score

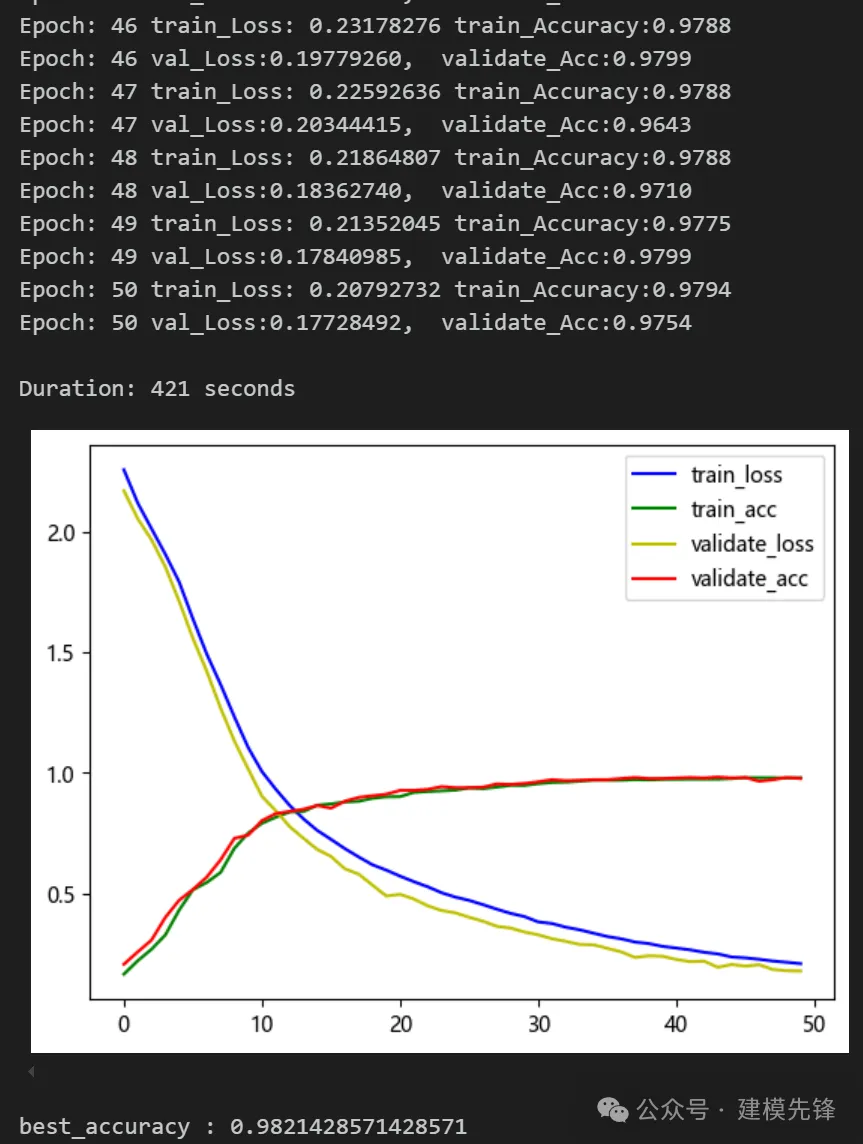

(2)模型 B:

模型评估:

准确率、精确率、召回率、F1 Score

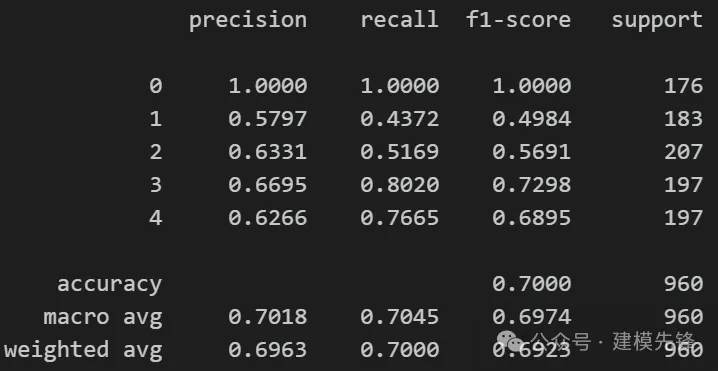

4.3 东南大学齿轮箱轴承故障-五分类数据集实验对比

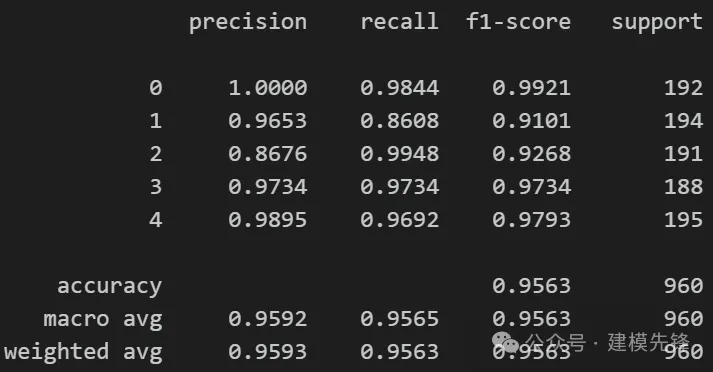

(1)模型 A:

模型评估:

准确率、精确率、召回率、F1 Score

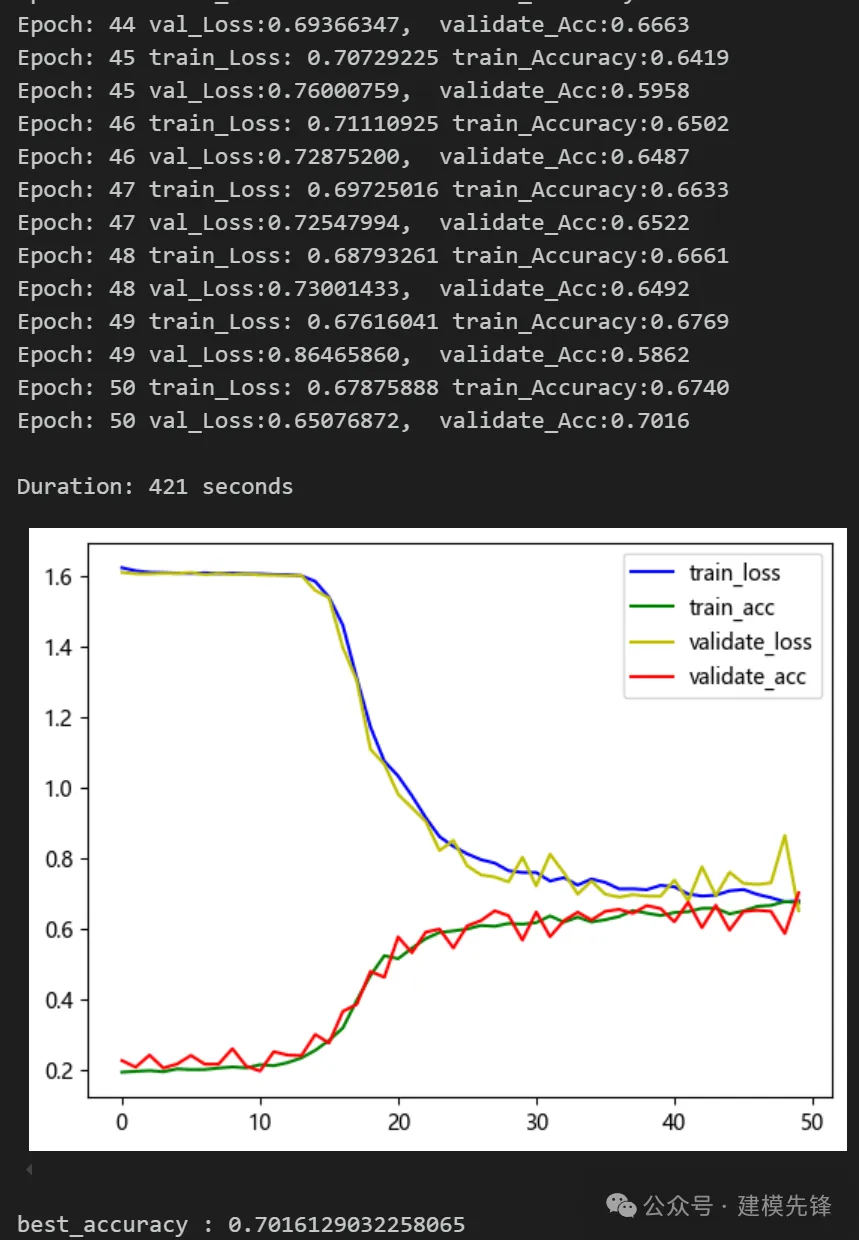

(2)模型 B:

模型评估:

准确率、精确率、召回率、F1 Score

5 实验对比结果分析

通过两个数据集的对比实验,我们可以发现,Transformer 编码器层在故障信号分类任务上取得了不错的效果,但是仅用多头注意力机制分类效果有一定程度的下降,证明Transformer 编码器整体结构在故障信号分类任务上的优越性!大家还可以进一步细致的探索结构中的其他部分。