多模态AI搜索引擎最强设计,赶超商业!GPT-4o、Qwen荣登榜首!研究者阵容豪华:香港中文大学、字节、北大、 原创

编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

有了多模态大模型(LMM)之后,之前那种OCR“以图搜图”的方式已经不再Fashion了。

然而,遗憾的是,虽然今年AI搜索很火、多模态很火,但是多模态的AI搜索进展却进展缓慢。

香港中文大学、字节跳动、上海人工智能实验室、北京大学、斯坦福大学、商汤科技的一众研发人员开始着手研究多模态搜索引擎的可行性了。

他们精心设计了一种零样本的方法,可以让LMM化身“多模态搜索引擎”。

重点来了,他们还进一步提出并解答了一个大家可能都难以回答的命题:如何评价一款多模态大模型作为搜索引擎的潜力?

图片

图片

一、多模态AI搜索引擎

提到多模态AI搜索引擎,大家会不会想到之前的“以图搜图”?看图识花、淘宝中的看图搜商品等等,但这些还不是多模态AI搜索。

想象这样换一个场景,假设现在有多枚奖牌,想知道它们的具体名称。一个多模态AI搜索引擎能够将这些奖牌的照片与从互联网上检索到的图像和文本交织表进行匹配,从而识别出每一枚奖牌。相比之下,纯文本搜索引擎既无法接收照片进行搜索,也无法理解这种交织的表格。

而面对这种复杂的图、表、文交织呈现的Web内容,即便是LLM也只能望洋兴叹:

虽然语言大模型可以更好地掌握用户意图、从原始Web信息中总结符合上下文语境的答案的能力,但这种仅限于文本查询和解释文本Web内容的形式,极大地限制了用户的查询场景和产品的想象空间。

这时候,就需要多模态大模型(LMM)上场解决了。

二、三个步骤让LMM成为多模态搜索引擎

近一年以来,多模态成为了大模型发展的主旋律之一,GPT-4o、Sora、Qwen-VL等模型争相发布,基于大型多模态模型LMM的产品应用如可灵、Character.AI等产品也给业界带来了经验的视觉效果,但是,它们怎样才能用作多模态的 AI 搜索引擎呢?

香港中文大学联合一众知名大学、企业精心设计了一套流水线,让市面上不管是闭源的GPT-4o、开源的Qwen,还是商用的Perplexity Pro,都统统经过三个步骤,化身成为可以理解视觉Web内容的多模态AI搜索引擎。

MMSearch-Engine

MMSearch-Engine

AI搜索过程是一个复杂的过程,这期间涉及到LMMs与传统搜索引擎之间的多轮交互。

三、开发团队究竟是如何设计的呢?

首先,研究团队利用LMMs的图像理解能力,整合了两种类型的视觉数据——第一类,使用Google Lens(一种OCR工具)从图像中搜索信息;第二类视觉数据,则是检索到的网站截图,目的是保留网站内容的原始格式。

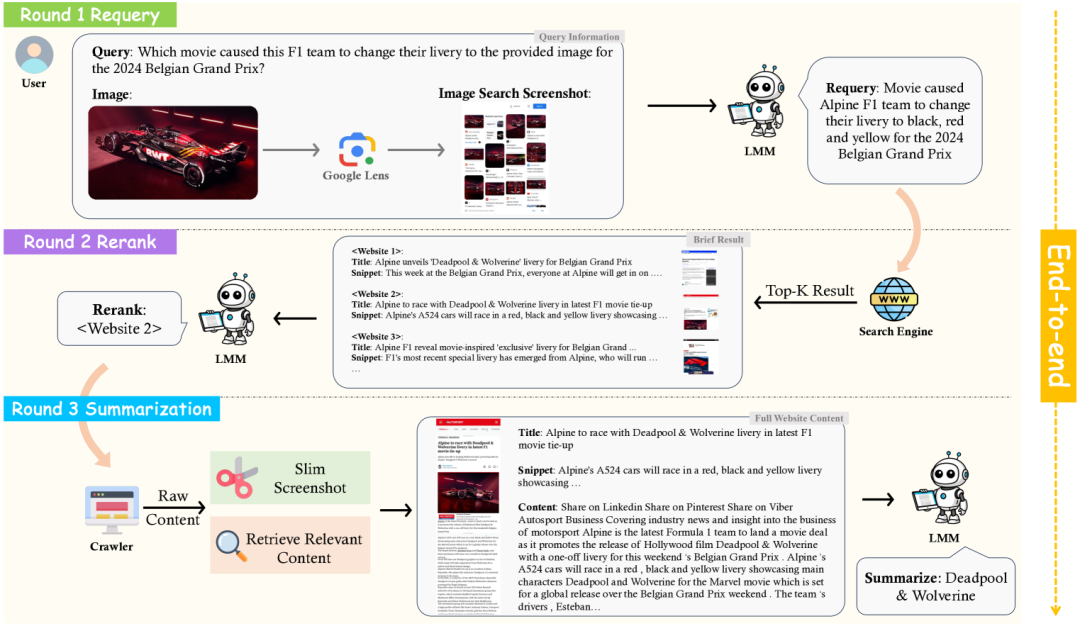

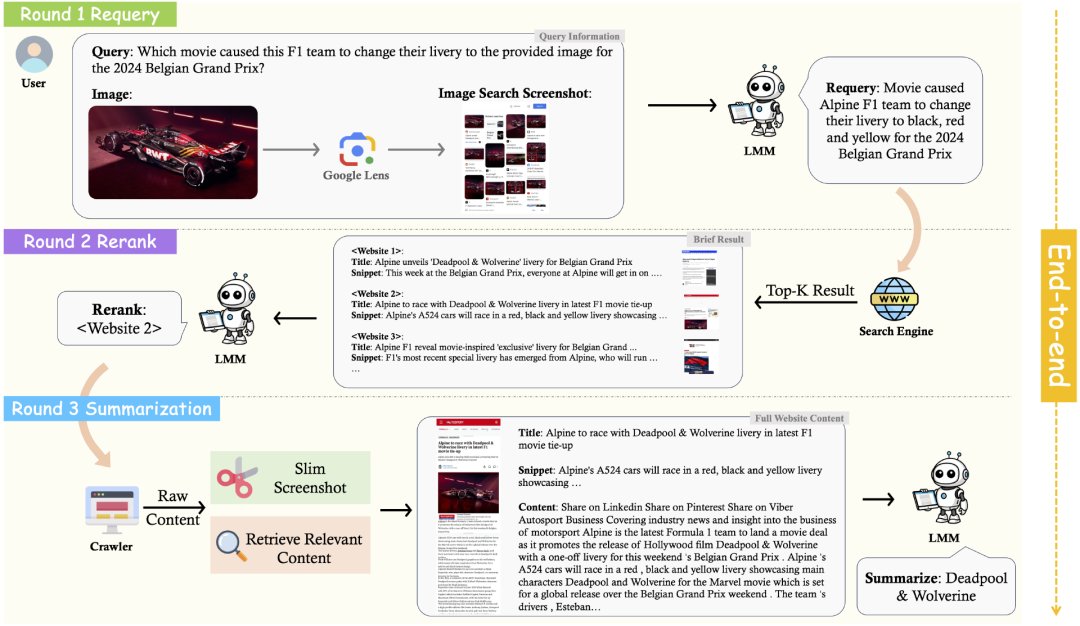

那么,LMM到底如何与搜索引擎协同工作?该流程包括三个连续阶段:

图片

图片

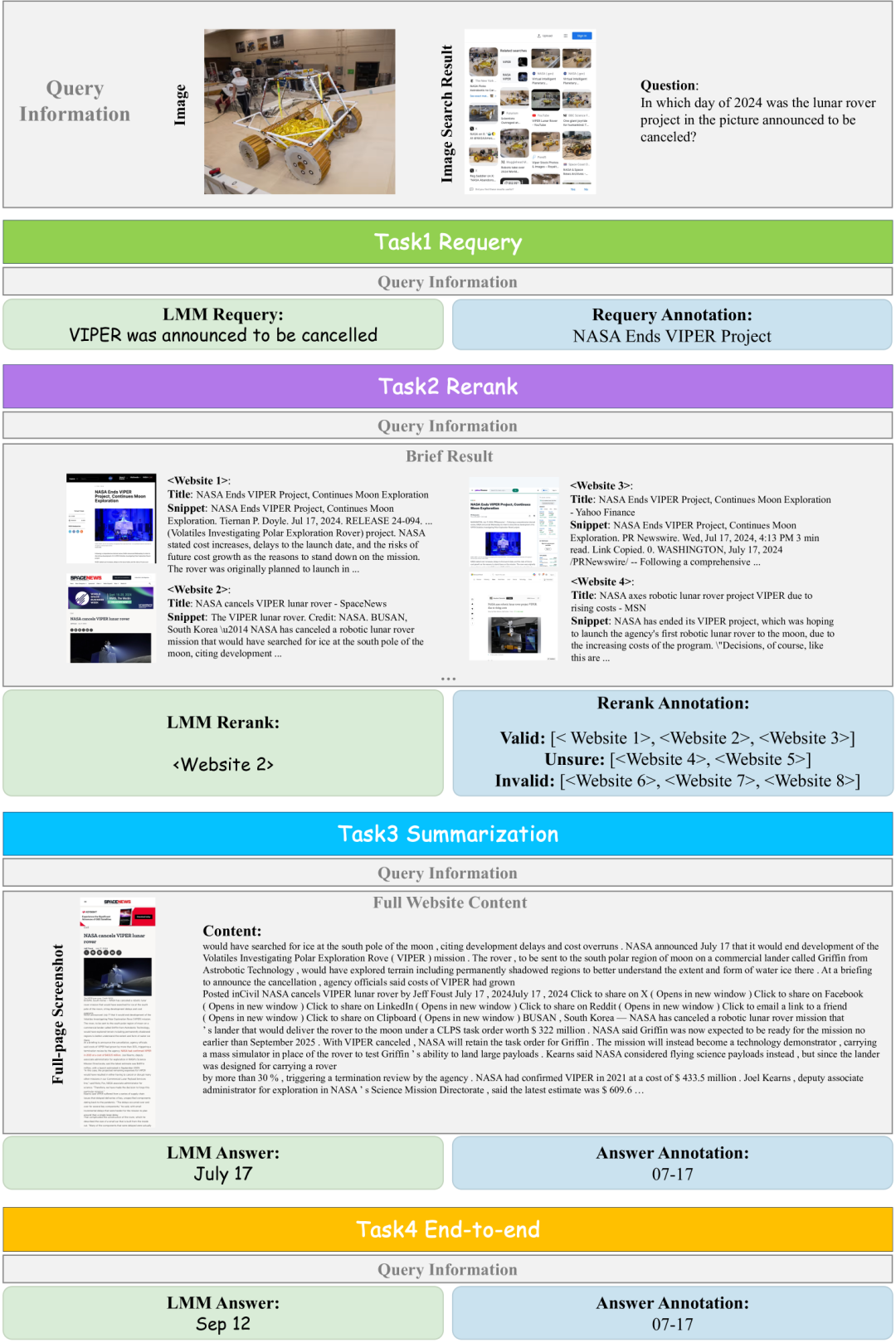

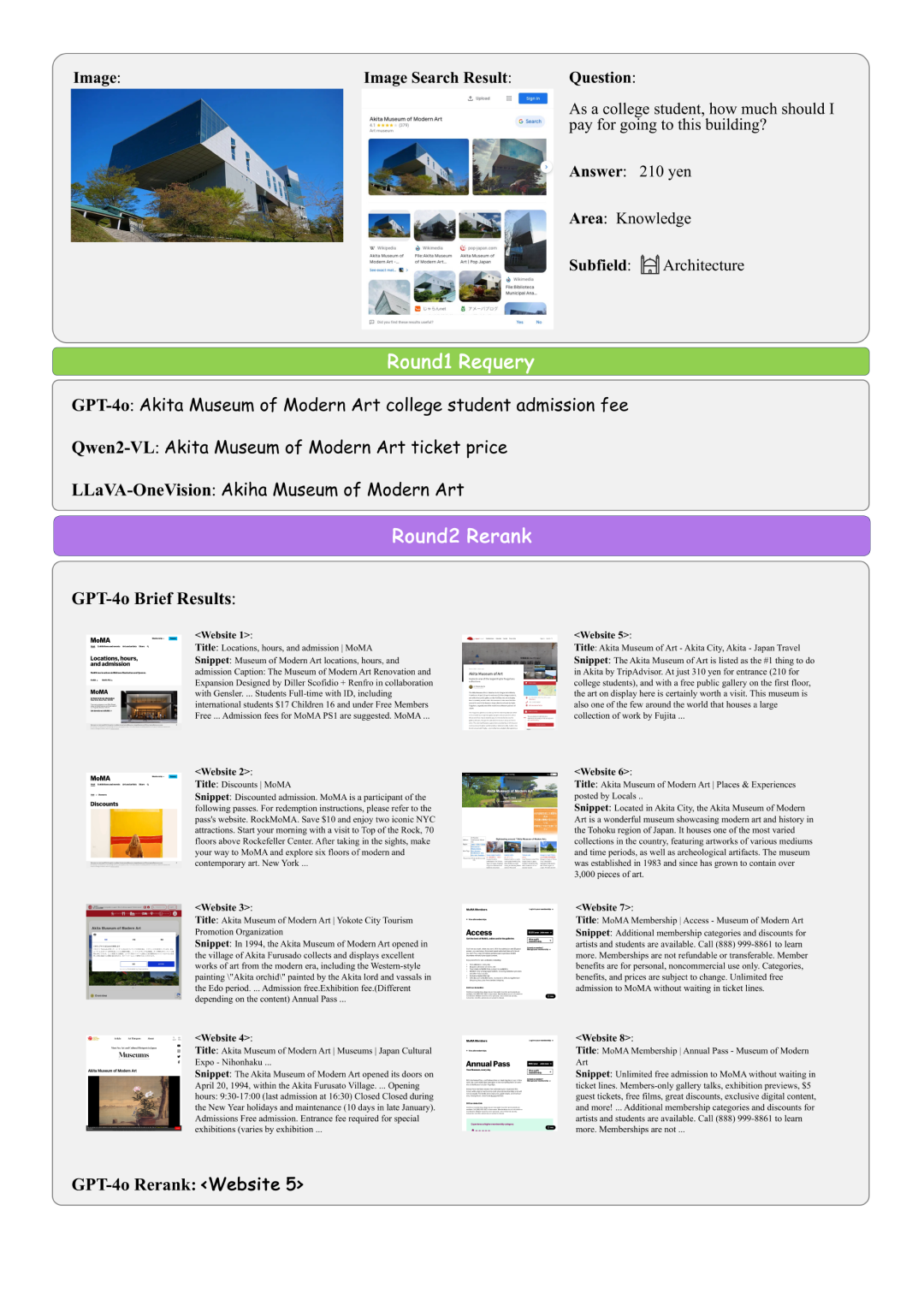

1. 重新查询(Requery)。用户直接输入的查询可能包含对图像中某些信息的引用,如图1所示的新闻财经示例。由于传统搜索引擎仅接受文本输入,因此LMM需要将图像内容转换为文本,并将其与查询结合,以向搜索引擎提出有效的问题。

此外,原始用户查询有时可能含糊不清或效率低下,因此LMM还必须重新构造查询以使其更清晰。如果用户查询包含图像,则将Google Lens的图像搜索结果截图纳入其中。

研究人员将用户查询、用户图像和图像搜索截图视为查询的基本信息。这些信息将在流程中的每一轮都输入给LMM。在重新查询阶段,研究人员需要提示LMM向传统搜索引擎输出一个重新构建的查询。

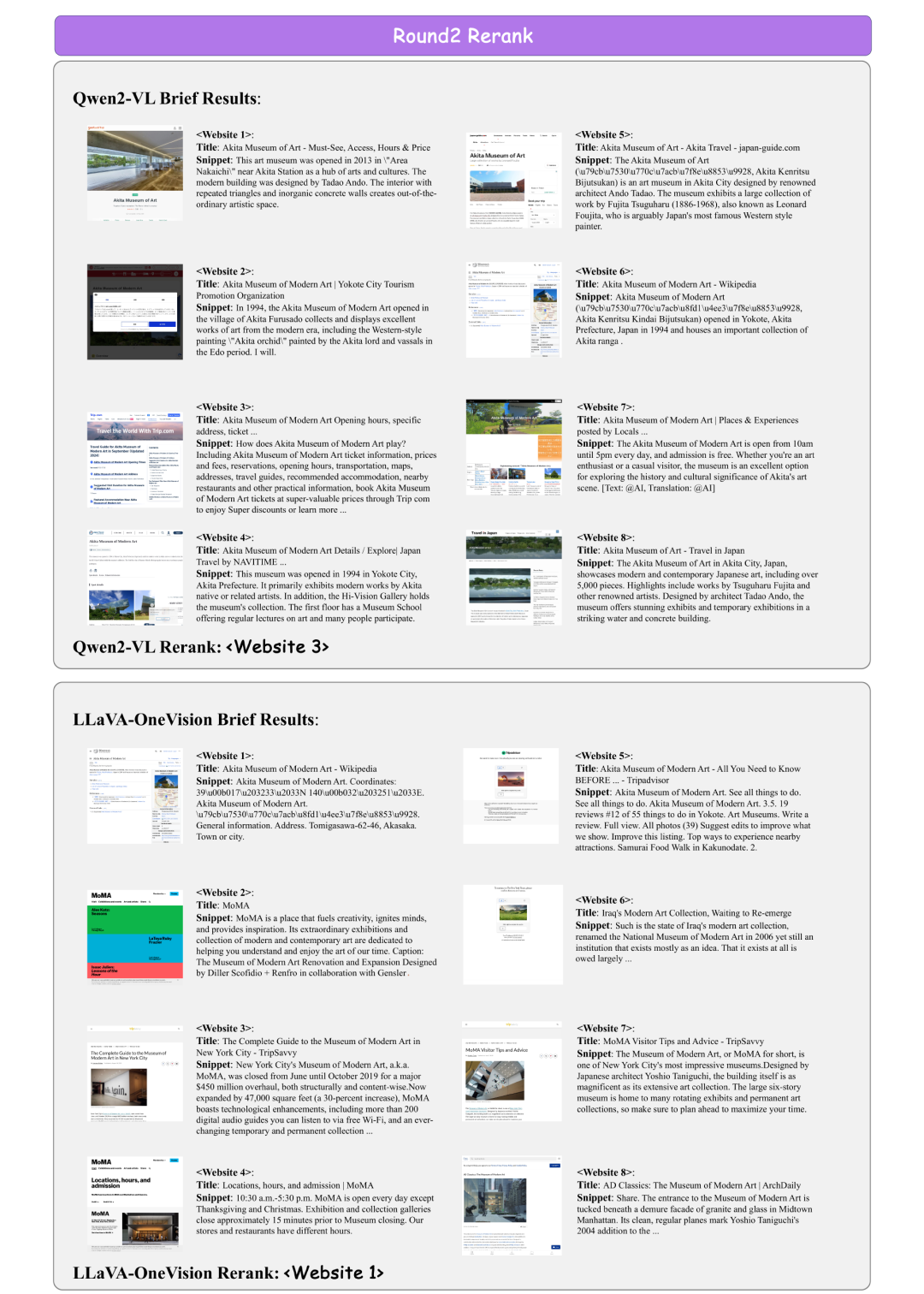

2.重新排序(Rerank)。将重新构建的查询发送给搜索引擎API(如DuckDuckGo),以检索前K个相关网站。根据重新构建查询的质量,并非所有检索到的网站都必然与查询回答相关。因此,研究人员会提示LMM选择一个信息量最大的网站进行答案摘要。

由于LMM的上下文长度限制和网站内容的广泛性,仅提供每个网站的必要信息(包括标题、摘要和网页顶部部分的截图),这里称之为简要结果,这些将作为LMM重新排序的输入。

需要注意的实,这里包含截图有两个目的。首先,截图提供了一个视觉线索来评估网页的可信度,因为组织良好的网站往往比充斥着广告的网站更值得信赖。此外,截图可能包含重要的视觉信息。例如,它可能包含与查询图像相似或相同的图像。

3. 摘要(Summarization)。首先抓取选定的网站以收集所有可用信息。解析HTML以获取原始文本内容,并捕获网站的整页截图。

然而,存在两个问题:原始内容往往冗长且杂乱无章,而整页截图中由于网站上的广告块,大量区域是空白的。这两个问题导致输入令牌中填充了大量不相关信息。

为了提高数据效率,研究人员在将截图和内容输入给LMM之前,先对截图进行瘦身并检索相关内容。对于整页截图,则识别空白区域并迭代地将其移除。

对于文本内容,我们应用一个文本嵌入模型从原始内容中检索最多2K个与重新构建查询相关的令牌。所以,这里将瘦身后的截图和检索到的内容定义为完整的网站内容。

最后,研究人员将完整的网站内容、网站标题、网站摘要以及查询信息输入给LMM,以总结答案。

图片

图片

四、评估多模态搜索能力,靠这两招

这还没完,让LMM具备了多模态搜索的能力后,如何评估这种能力的强弱呢?

这里涉及到两个主要难题:评估数据集和如何打分。

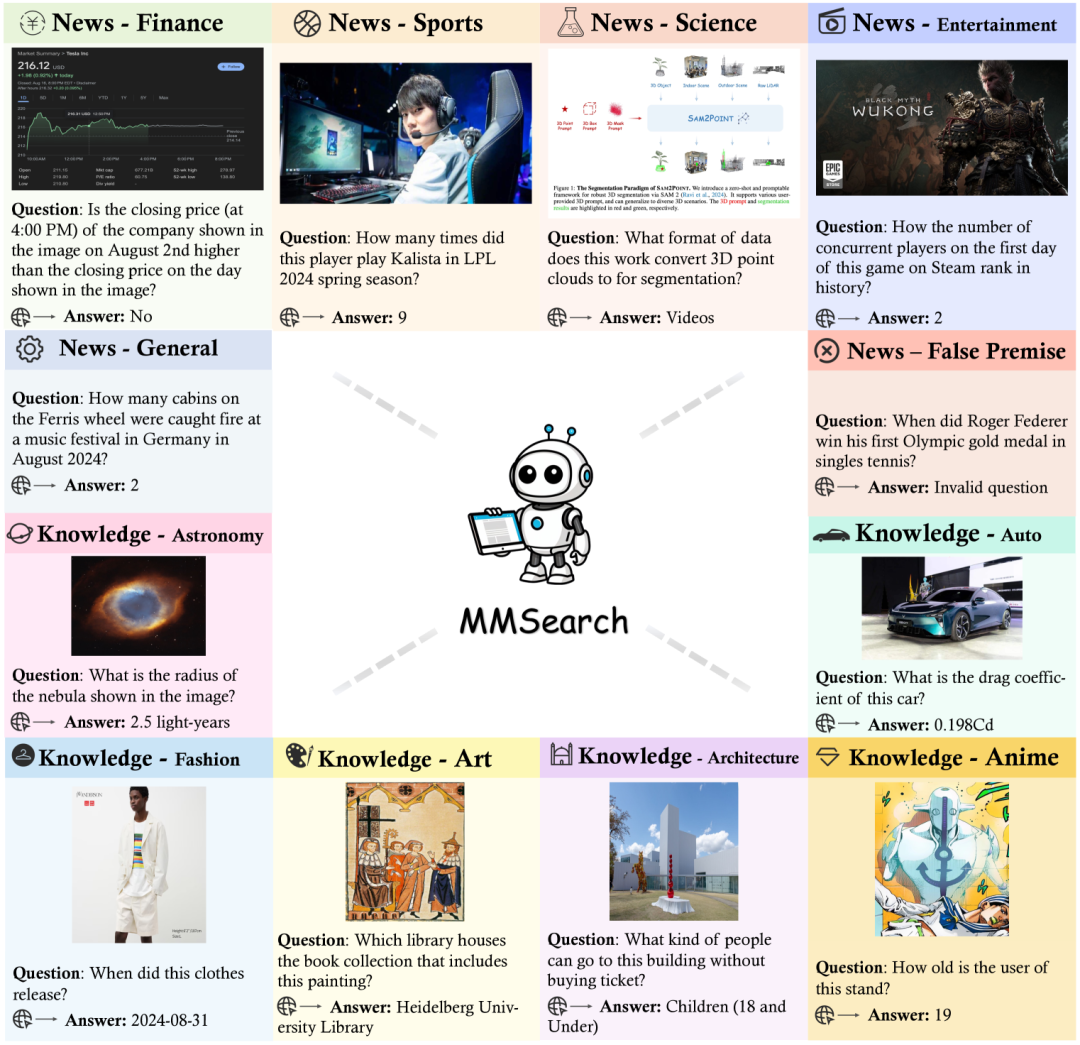

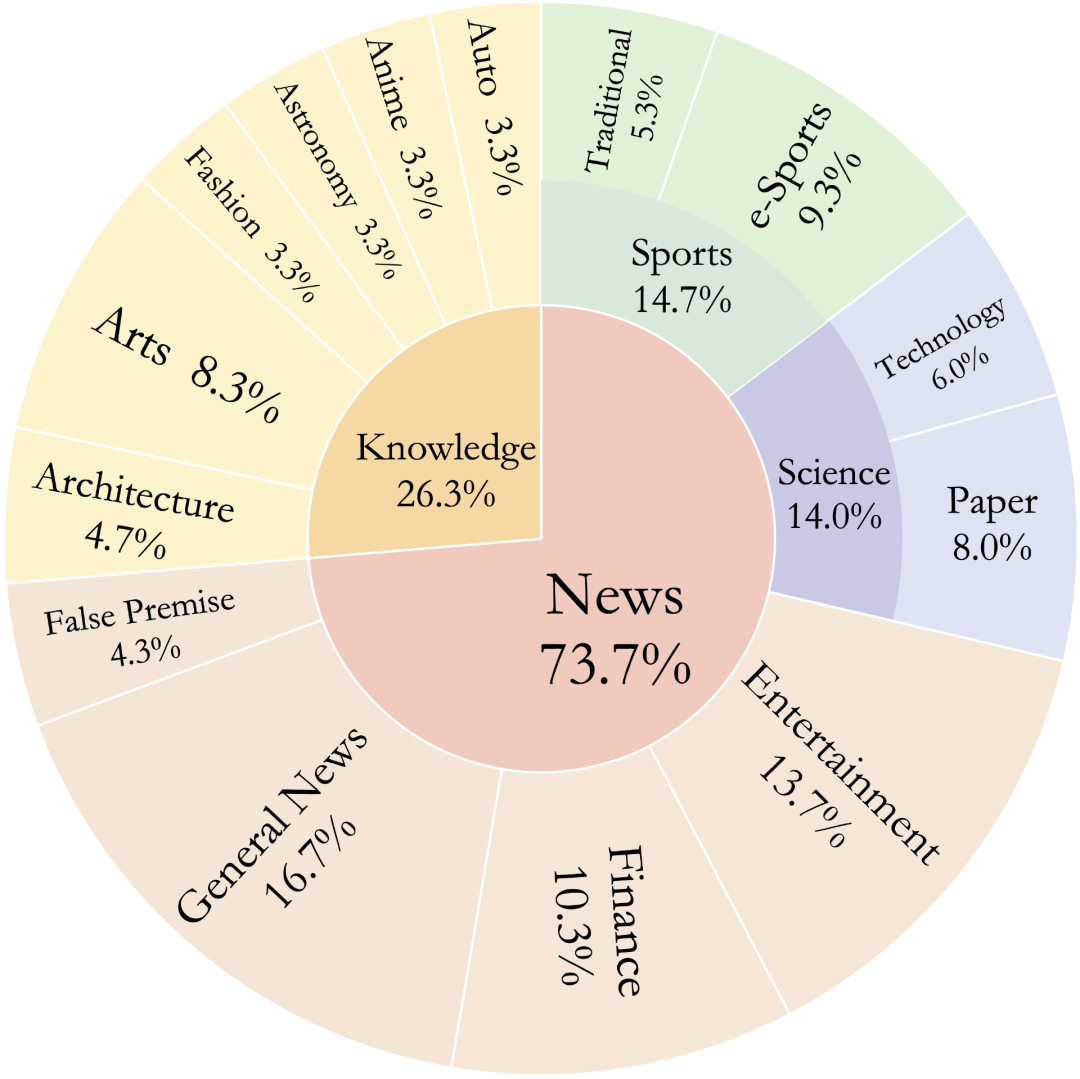

数据集方面,研究人员在此基础上引入了一个评测数据集 \dataset,这是一个全面的评估基准,用于评估 LMM 的多模态搜索性能。

该数据集包含 300 个手动收集的实例,跨越 14 个子字段,与当前 LMM 的训练数据不重叠,确保只能在搜索中获得正确答案。通过使用 MMSearch-Engine,通过执行三个单独的任务(requery、rerank 和 summarization)和一个具有挑战性的端到端任务来评估 LMM,该任务具有完整的搜索过程。

图片

图片

图片

图片

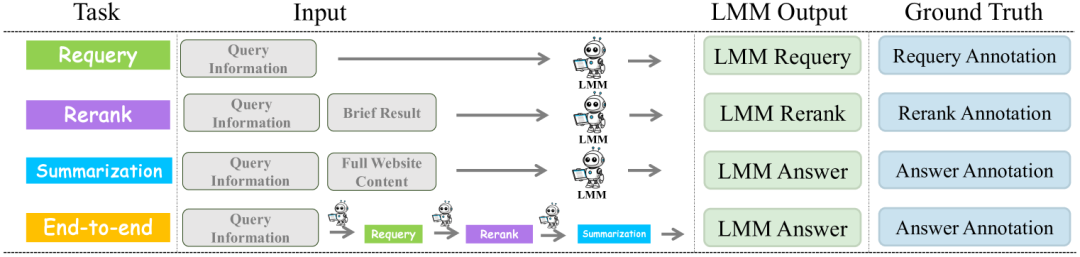

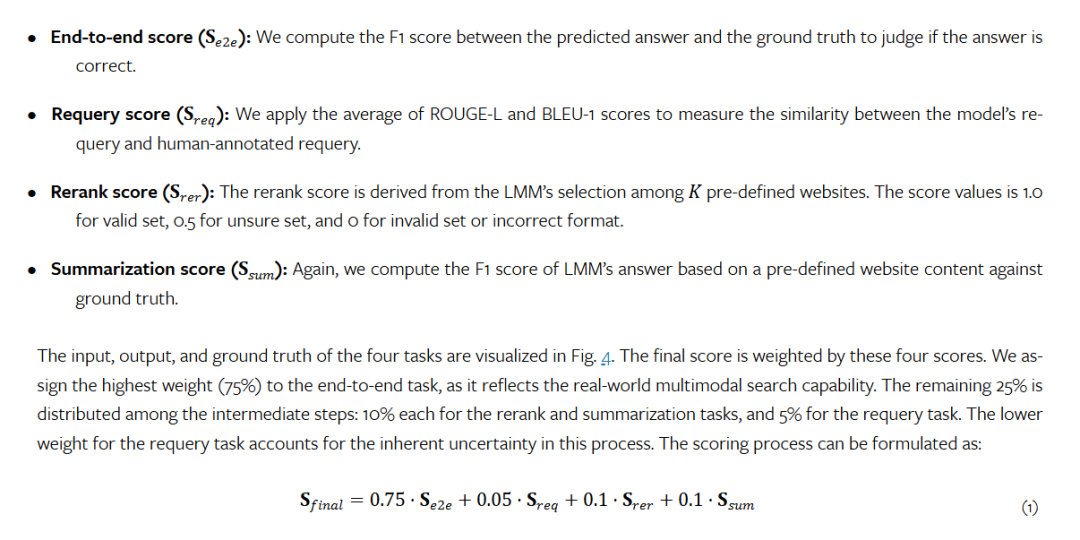

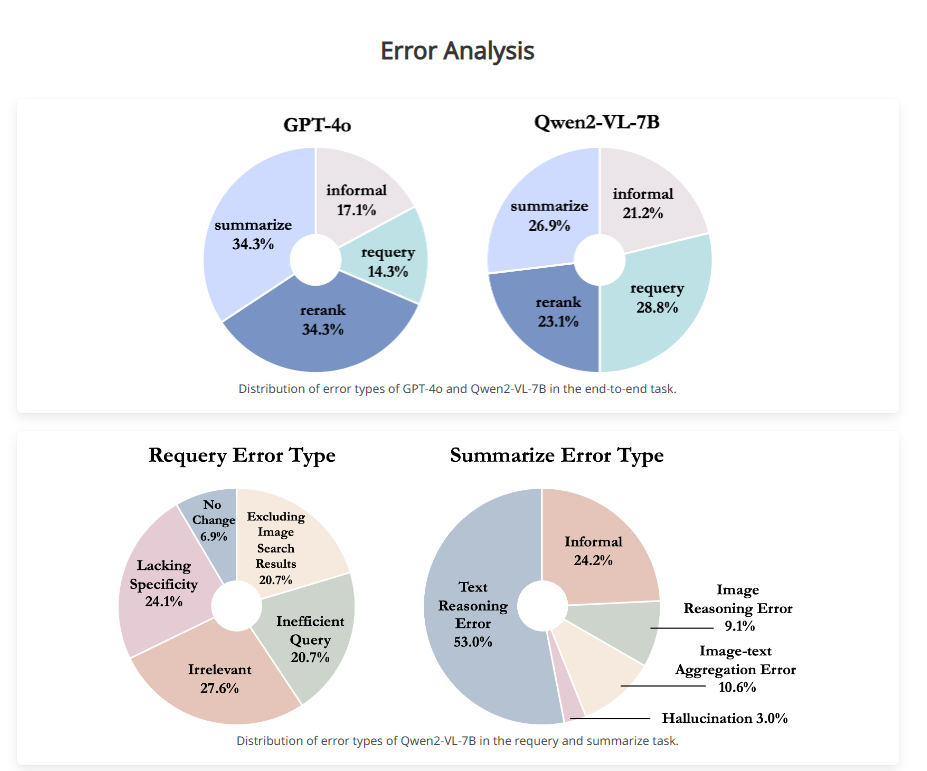

而在打分方面,研究团队没有简单粗暴地来进行一场端到端的黑盒打分策略,而是采取了对三个核心搜索步骤上进行多轮逐步的策略,因为仅对最终答案的端到端评估不足以揭示模型在每个核心搜索步骤中的不足。例如,模型所犯的错误可能发生在摘要过程中,但也可能是由于在重新排名阶段选择了不正确的网站。

根据这四个打分,研究人员为最终结果设计了一个整体的得分。

图片

图片

图片

图片

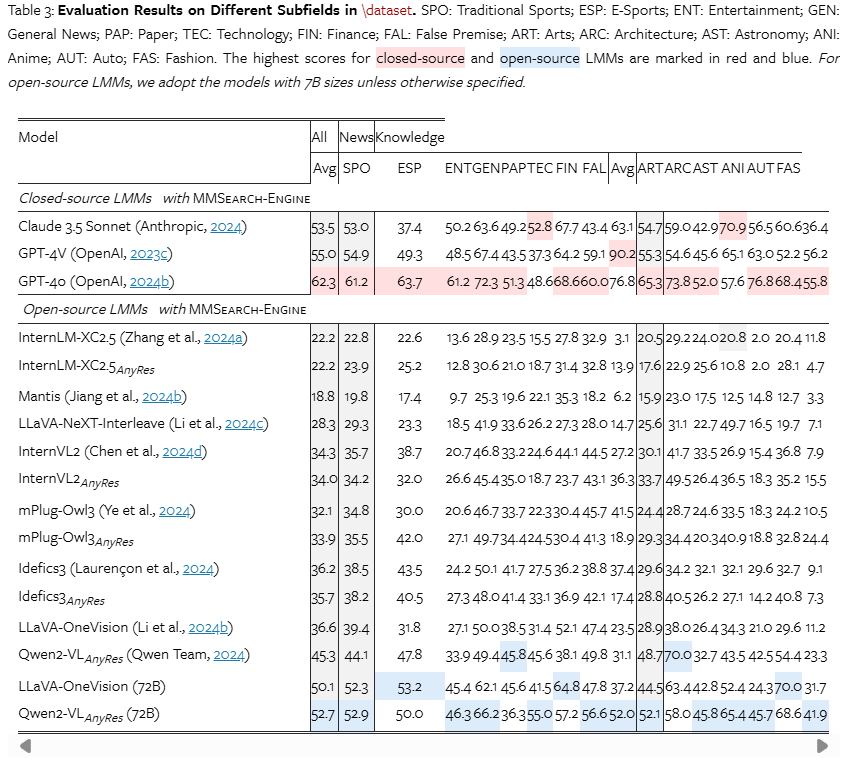

研究人员对闭源和开源 LMM 进行了广泛全面的实验。在所有测试模型中,带有 MMSearch-Engine 的 GPT-4o 取得了最好的结果,在端到端任务中超过了商业产品 Perplexity Pro,证明了这种“三步骤流水线”方法的有效性。

与此同时,为了彻底研究多模态搜索能力,通过上文提到的评估策略在数据集 \dataset 上得到了了不同模型的评估结果。

图片

图片

五、结论:闭源依旧强大,开源Qwen居首

1.任意分辨率的输入仅提供轻微的改进或没有改进

在测试的 LMM 中,有四种型号,即 InternLM-XC2.5、InternVL2、mPlug-Owl3 和 Idefic3,均支持低分辨率 (LowRes) 和任意分辨率输入 (AnyRes)。正如人们所料,AnyRes 输入可以更好地实现图像的 OCR 和感知。然而,与 LowRes 性能与 AnyRes 性能之间的差异相比,我们只观察到轻微甚至没有增强。

以 mPlug-Owl3 为例,AnyRes input 在总分上比 LowRes input 高出 1.8%,端到端高出 2.7%,rerank 高出 0.2%。虽然它在重新查询和摘要方面分别落后于 LowRes 0.8% 和 1.7%。这表明 OCR 和感知质量不会成为搜索性能的瓶颈。相反,次优性能似乎源于 LMM 本身缺乏强大的搜索功能。

2.当前的 LMM 在 requery 和 rerank 方面仍然存在重大缺陷

将端到端任务的平均分数与摘要任务的平均分数进行比较,就会发现,无论是在闭源模型还是开源模型中,摘要分数都始终以很大的优势超过端到端任务。

论文认为,虽然摘要任务 input 始终包含答案,但端到端任务的第三轮 input 质量取决于模型在前几轮中的 requery 和 rerank 质量。这种性能差距的大小反映了模型的摘要能力与其重新查询和重新排名任务的能力之间的差异。差异越大,能力差距越大。观察结果中发现:大多数开源模型的差距超过 14%,而闭源模型都在 10% 以下。

这表明所有当前的 LMM 都需要改进其 requery 和 rerank 能力,尤其是对于开源模型。

值得注意的是,Qwen2-VL-72B 的差距为 10.5%,也低于 14%,凸显了它在其他开源 LMM 中的优越性。

图片

图片

3.闭源 LMM 在整体性能上优于开源 LMM

在最终得分方面,闭源 LMM 的性能始终优于开源 LMM。GPT-4o 获得了 62.3% 的最高总分,展示了卓越的零样本多模态搜索能力。虽然 Qwen2-VL-72B 在开源模型中处于领先地位,但它仍然落后于 GPT-4o 9.6%。在最具挑战性的端到端任务中,性能差距扩大到 11.3%,对于 7B 开源 LMM 进一步扩大到 20.1%。这些显著的差异凸显了开源模型的巨大改进空间。

4.使用MMSearch-Engine,SoTA LMM 在端到端任务中超越了商业 AI 搜索引擎

我们还评估了 Perplexity 的专业版,一个著名的商业 AI 搜索引擎,接受图像和文本查询。Perplexity pro 可以接受用户查询中的图像和文本。令人惊讶的是,尽管 Perplexity 还利用了 GPT-4o 和 Claude 3.5 Sonnet 等 SoTA LMM,但它在端到端任务中的性能在很大程度上低于配备相同模型的 MMSearch-Engine。

更值得注意的是,MMSearch-Engine 甚至可以通过开源 LMM Qwen2-VL-72B 超越 Perplexity。

这表明MMSearch-Engine 为多模态 AI 搜索引擎提供了更好的开源方案。性能差距验证了 MMSearch-Engine 的设计有效性,并突出了在我们的管道中测试各种 LMM 的价值,因为在使用强大的 LMM 时,管道确实可以实现卓越的性能。

此外,论文还指出使用强大的图像搜索步骤的重要性。

图片

图片

图片

图片

结果实例

结果实例

六、多模态AI搜索引擎,何时才会到来

进入2024以来,“寻找PMF”、“如何利用大模型的能力打造产品”成为了业界的主流角逐点。而搜索作为与AI天生最容易结合的、最值得关注的赛道之一,我们欣喜地看到了香港中文大学、字节跳动、北京大学、商汤科技、斯坦福大学等众多国内外学术界、产业界的研究人员走到了一起,并为多模态搜索引擎的赛道提出了一种可行的设计框架。

虽然目前看,即便是GPT-4o,也难以达到人类实用的效果,但“三个步骤”设计流水线和评估LMM的多模态搜索潜力的方法,值得各位借鉴。毕竟,我们可以看到使用MMSearch,SOTA模型的性能已经超过了商业的Perplexity Pro,这是一个可喜的成绩。

参考链接:

https://arxiv.org/pdf/2409.12959v1

https://mmsearch.github.io/

本文转载自51CTO技术栈,作者:言征