P-RAG: 渐进式检索增强生成方法在具身日常任务规划中的应用 精华

在人工智能领域,具身AI(Embodied AI)一直是一个备受关注的研究方向。它旨在赋予AI代理与物理世界交互的能力,让AI不仅仅停留在虚拟的数字世界中,而是能够在真实环境中感知、规划和行动。近年来,随着大语言模型(LLM)的蓬勃发展,如何将LLM的强大语言理解和生成能力与具身AI任务结合起来,成为了一个热门的研究课题。

在这个背景下,来自中国科学技术大学等机构的研究人员提出了一种新颖的方法——渐进式检索增强生成(Progressive Retrieval Augmented Generation, P-RAG),用于解决具身日常任务中的规划问题。这项研究发表在ACM多媒体会议(MM '24)上,论文题为《P-RAG: Progressive Retrieval Augmented Generation For Planning on Embodied Everyday Task》。

背景与现状

具身日常任务(Embodied Everyday Task)是具身AI领域的一个重要任务。在这类任务中,AI代理需要根据自然语言指令和视觉观察来执行一系列动作。例如,我们可能会给机器人下达这样的指令:"请把厨房打扫干净"或"请给盆栽浇水"。这看似简单的任务对AI来说却充满了挑战:

- 自然语言指令往往缺乏明确的任务规划。比如"打扫厨房",它包含了很多隐含的子任务,如清洁台面、收拾餐具、擦拭电器等。

- AI需要对任务环境有充分的了解。不同的家庭环境可能有不同的布局和物品,AI需要适应这种差异。

- 动作空间可能是可变的,某些动作在特定情况下可能是无效或非法的。例如,我们可以用烹饪或加热来处理某些食物,但对于盆栽或鞋子,这些动作就是非法的。

- 现实世界的一些限制条件容易被忽视。比如在某些模拟环境中,桌子可能比较小,无法放置过多物品。

传统的基于学习的方法,如强化学习(RL),虽然可以通过迭代过程来增强模型在特定任务和环境中的能力,但往往缺乏理解语言指令的能力。而近期兴起的基于大语言模型(LLM)的方法,虽然在理解语言指令方面表现出色,但又缺乏对特定任务和环境的知识。

问题与挑战

现有的基于LLM的方法主要面临以下挑战:

- 缺乏任务特定知识: LLM拥有广泛的通用知识,但对于特定任务环境的细节认知不足。

- 依赖标注数据: 一些方法需要使用少量样本(few-shot)来增强LLM的性能,这些样本通常需要人工标注,成本较高。

- 单次检索的局限性: 传统的检索增强生成(RAG)方法通常只进行一次检索来辅助生成,难以适应复杂的具身任务。

- 缺乏渐进式学习能力: 现有方法难以像人类一样,通过不断尝试和积累经验来逐步提升性能。

P-RAG: 渐进式检索增强生成

为了解决上述问题,研究人员提出了P-RAG方法。P-RAG的核心思想是:通过渐进式的方式,不断积累任务特定知识,并利用这些知识来辅助LLM进行更好的规划。

方法概述

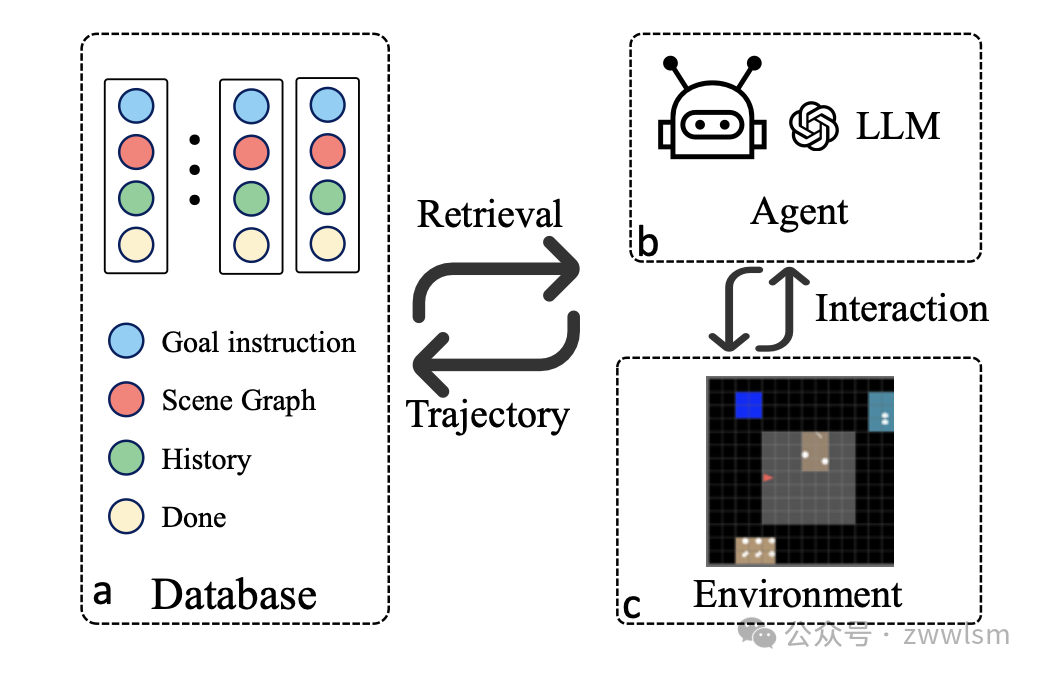

P-RAG的整体框架如图1所示:

P-RAG框架图

P-RAG主要包含以下几个关键组件:

- 数据库: 存储历史轨迹信息,包括目标指令、场景图、轨迹历史和任务完成状态。

- 检索模块: 根据当前任务的目标指令和场景观察,从数据库中检索相关的历史信息。

- LLM代理: 接收检索结果和当前环境信息,生成行动计划。

- 交互环境: 模拟具身任务的环境,如MINI-BEHAVIOR或ALFRED。

- 渐进式更新机制: 在每轮交互后,更新数据库,积累新的经验。

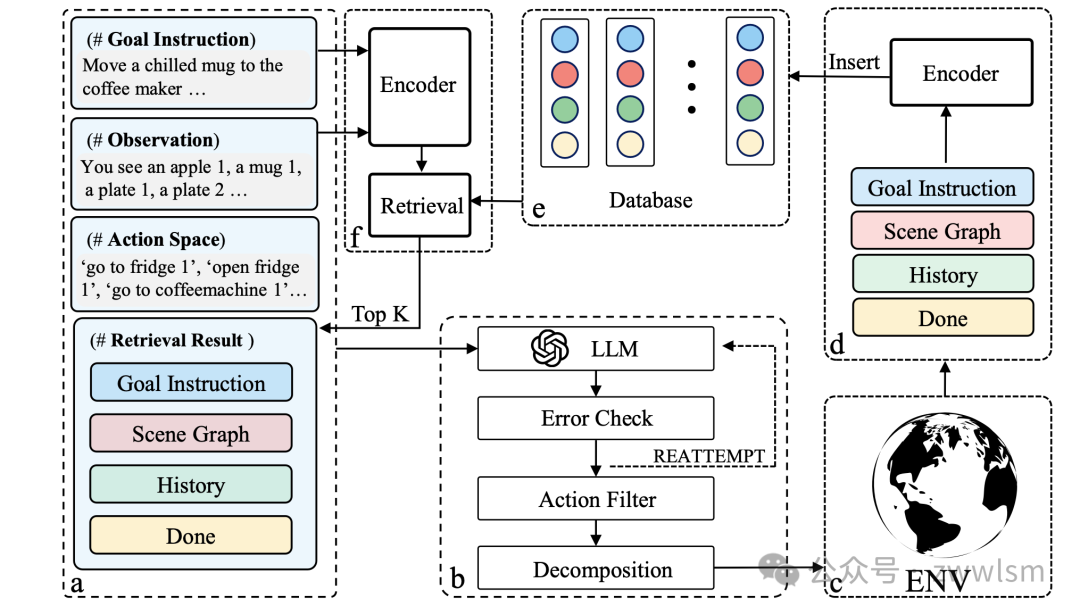

工作流程

P-RAG的工作流程可以概括为以下步骤:

- 信息收集: 代理接收目标指令、环境观察、动作空间和数据库检索结果。

- LLM规划: 将收集到的信息输入LLM,生成一系列高级动作。

- 动作执行: 将高级动作分解为低级动作,在环境中执行。

- 结果反馈: 环境返回新的观察和奖励信息。

- 数据库更新: 将新的轨迹信息更新到数据库中。

- 迭代优化: 重复上述步骤,不断积累经验,提升性能。

核心创新点

- 渐进式知识积累: P-RAG不依赖预先标注的数据,而是通过与环境的交互,逐步积累任务特定知识。这种方式更接近人类学习的过程,也更适合实际应用场景。

- 联合检索策略: P-RAG不仅检索相似的任务,还考虑相似的场景。这种细粒度的检索策略能提供更有价值的参考经验。具体来说,P-RAG使用以下公式计算相似度:

s_n = sim(Q_goal, K_goal) + max(sim(Q_obs,n, K_obs,t))其中,Q_goal和K_goal是目标指令的嵌入向量,Q_obs,n和K_obs,t是场景图的嵌入向量。

- 迭代式更新: P-RAG引入了一种迭代方法,在每轮交互后更新数据库。这使得模型能够从失败的尝试中学习,不断改进其性能。

- 灵活的LLM集成: P-RAG可以与不同的LLM(如GPT-3.5、GPT-4)集成,充分利用LLM的语言理解和生成能力。

实验与结果

研究人员在两个具有代表性的数据集上进行了大量实验,以验证P-RAG的有效性:

- ALFRED数据集: 一个基于视觉和语言的室内任务数据集。

- MINI-BEHAVIOR数据集: 一个抽象的网格环境,包含20个日常活动。

ALFRED数据集上的结果

表1展示了P-RAG与其他先进方法在ALFRED数据集上的性能比较:

模型 | 数据集 | 标注数据 | Valid Unseen | Valid Seen |

HiTUT | 全量 | ✓ | 10.23 | 18.41 |

HLSM | 全量 | ✓ | 18.28 | 29.63 |

LLM-Planer | 部分 | ✓ | 12.92 | 13.53 |

GPT-4 | - | × | 7.05 | 17.46 |

P-RAG (我们的方法) | 部分 | × | 14.11 | 18.2 |

P-RAG (自迭代) | - | × | 27.4 | 19.05 |

表1: ALFRED数据集上的性能比较 (成功率 %)

从表1中我们可以看出:

- P-RAG在不使用任何标注数据的情况下,就能达到或超过使用部分训练数据的方法(如LLM-Planer)的性能。

- 通过自迭代(在测试集上进行渐进式更新),P-RAG的性能甚至超过了使用全量训练数据的方法,特别是在Valid Unseen数据集上。

- P-RAG显著优于单纯使用GPT-4的基线方法,证明了检索增强和渐进式学习的有效性。

MINI-BEHAVIOR数据集上的结果

表2展示了P-RAG在MINI-BEHAVIOR数据集上的表现:

模型 | 总成功率 | 任务成功率 | SPL |

GPT-4 | 15% | 20% | 13.8% |

P-RAG-4 | 16.7% | 25% | 15% |

GPT-3.5 | 7.5% | 20% | 7.5% |

P-RAG-3.5 | 10% | 20% | 9.5% |

表2: MINI-BEHAVIOR数据集上的性能比较

从表2中我们可以观察到:

- 无论是基于GPT-4还是GPT-3.5,P-RAG都能显著提升性能。

- P-RAG不仅提高了总成功率,还提升了任务成功率和SPL(成功加权路径长度)指标。

- 即使在这种简单的环境中,P-RAG也展现出了明显的优势,特别是考虑到MINI-BEHAVIOR对强化学习算法来说是一个具有挑战性的环境。

案例分析

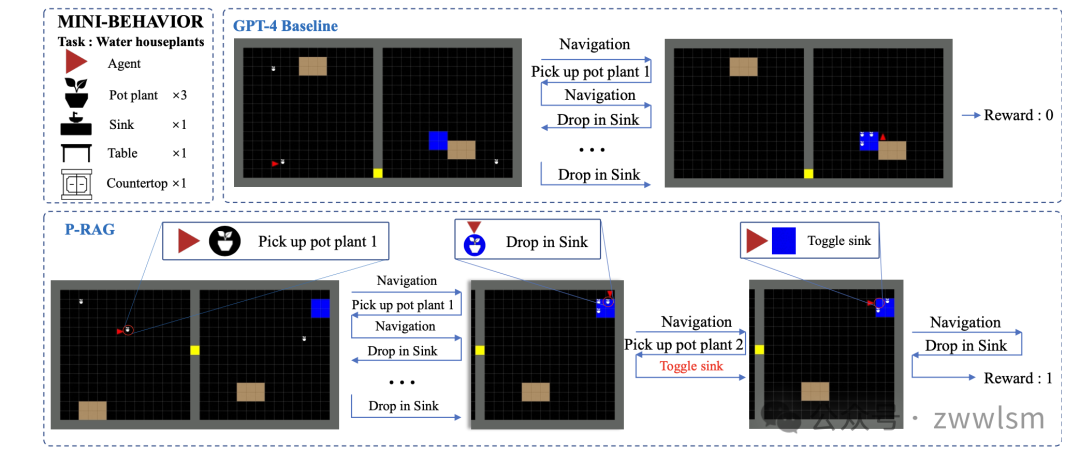

为了更直观地理解P-RAG的工作原理,让我们来看一个具体的案例。图2展示了P-RAG和GPT-4基线在"给盆栽浇水"任务上的规划轨迹对比:

规划轨迹对比

图2: P-RAG与GPT-4基线在"给盆栽浇水"任务上的规划轨迹对比

在这个案例中:

- GPT-4基线方法简单地按顺序拿起三个盆栽并放入水槽,然后认为任务完成。但实际上,它并没有成功完成任务。

- 相比之下,P-RAG利用全面的历史轨迹信息来做决策。它不仅正确地将盆栽放入水槽,还记得要打开水龙头,最终成功完成了任务。

这个案例很好地展示了P-RAG如何利用历史经验来做出更合理的决策,从而更好地完成复杂的具身任务。

方法分析与改进方向

P-RAG虽然取得了令人瞩目的成果,但仍有一些值得进一步探索和改进的方向:

- 检索效率优化: 随着交互轮次的增加,数据库中的历史轨迹会不断累积。如何在大规模数据中快速、准确地检索相关信息,是一个值得研究的问题。可以考虑引入更高效的索引结构或近似最近邻搜索算法。

- 知识蒸馏与压缩: 目前P-RAG直接存储原始的轨迹信息。未来可以探索如何从这些原始数据中提取关键知识,并以更紧凑的形式存储,从而减少存储开销并提高检索效率。

- 多模态信息融合: 当前的方法主要依赖文本形式的场景图。未来可以考虑如何更好地利用视觉信息,perhaps通过引入视觉-语言预训练模型来获取更丰富的环境表征。

- 任务迁移与泛化: 虽然P-RAG在未见过的环境中表现良好,但如何将在一个任务域中学到的知识迁移到新的任务域,仍是一个开放的问题。研究跨任务、跨域的知识迁移将是很有价值的方向。

- 与强化学习的结合: P-RAG目前主要依赖LLM进行决策。探索如何将P-RAG与强化学习方法相结合,可能会带来更好的性能和更强的适应性。

- 人机协作方面的应用: P-RAG的渐进式学习特性使其非常适合人机协作场景。研究如何让人类用户更自然地参与到知识积累和决策优化的过程中,将是一个很有前景的方向。

- 可解释性增强: 虽然P-RAG通过检索历史轨迹提供了一定的可解释性,但如何让模型的决策过程更加透明和可理解,仍有改进空间。perhaps可以通过可视化检索到的关键信息,或生成决策依据的自然语言解释。

总结与展望

P-RAG为解决具身日常任务中的规划问题提供了一种新颖而有效的方法。它巧妙地结合了大语言模型的强大语言能力和渐进式学习的灵活性,在不依赖大量标注数据的情况

本文转载自 芝士AI吃鱼,作者: 爱滑冰的咸鱼